近期,开源大大大模型的「卷王」争霸赛正式打响,在Meta 发布新一代的开源大模型 Llama 3.1 405B 后,Mistral AI 也不甘示弱,发布了 Mistral Large 2,当众人为其性能感到震惊的同时,超大规模的参数也提高了本地部署的门槛,让不少想上手体验的小伙伴们望而却步。

别着急,OpenBayes 现已上线 Llama-3.1-405B-Instruct-AWQ-lNT4 和 Mistral-Large-Instruct-2407-AWQ 模型,支持一键 input,让你跳过漫长的下载、上传时间,直接开启快乐部署。

模型地址:

Mistral-Large:https://go.openbayes.com/VTuMR

Llama-3.1-405B:https://go.openbayes.com/Z7flq

为了给大家带来更好的体验,平台的公共教程板块也上线了「使用 Open WebUI 一键部署 Mistral Large 2407 123B」和「使用 Open WebUI 一键部署 Llama 3.1 405B 模型」,无需输入任何命令,只需点击克隆即可立即开始体验。

教程地址:

Mistral-Large:https://go.openbayes.com/IxTx5

Llama-3.1-405B:https://go.openbayes.com/oPEQR

针对高阶玩家,我们也同步上线了「一键部署 Mistral Large 2407 123B 模型 OpenAI 兼容 API」和「一键部署 Llama 3.1 405B 模型 OpenAI 兼容 API 服务」,大家可以按需选择不同的方式。

进阶教程地址:

Mistral-Large:https://go.openbayes.com/1ru8c

Llama-3.1-405B:https://go.openbayes.com/zempr

为了方便大家的理解,我们录制了详细的操作视频,小白也可以快速上手!

【OpenBayes 官方教程】快速部署 Mistral-Large & Llama-3.1-405B 超大模型_哔哩哔哩_bilibili

操作步骤

本次文字教程会以「使用 Open WebUI 一键部署 Mistral Large 2407 123B」和「一键部署 Llama 3.1 405B 模型 OpenAI 兼容 API 服务」为例,为大家拆解操作步骤。

01 使用 Open WebUI 一键部署 Mistral Large 2407 123B

1. 登录 OpenBayes.com,在「公共教程」页面,选择「使用 Open WebUI 一键部署 Mistral Large 2407 123B」。

2. 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

3. 点击右下角「下一步:选择算力」。

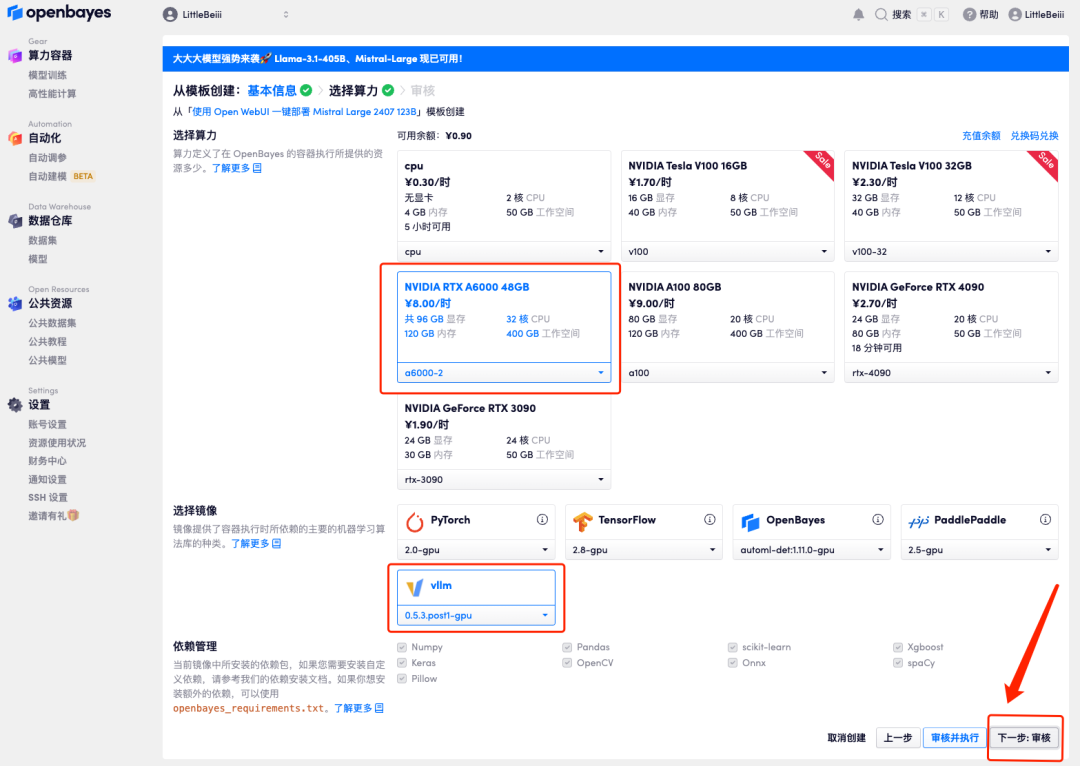

4. 页面跳转后,选择「NVIDIA RTX A6000-2」以及 「vllm」镜像,点击「下一步:审核」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

小贝总专属邀请链接(直接复制到浏览器打开):

https://go.openbayes.com/9S6Dr

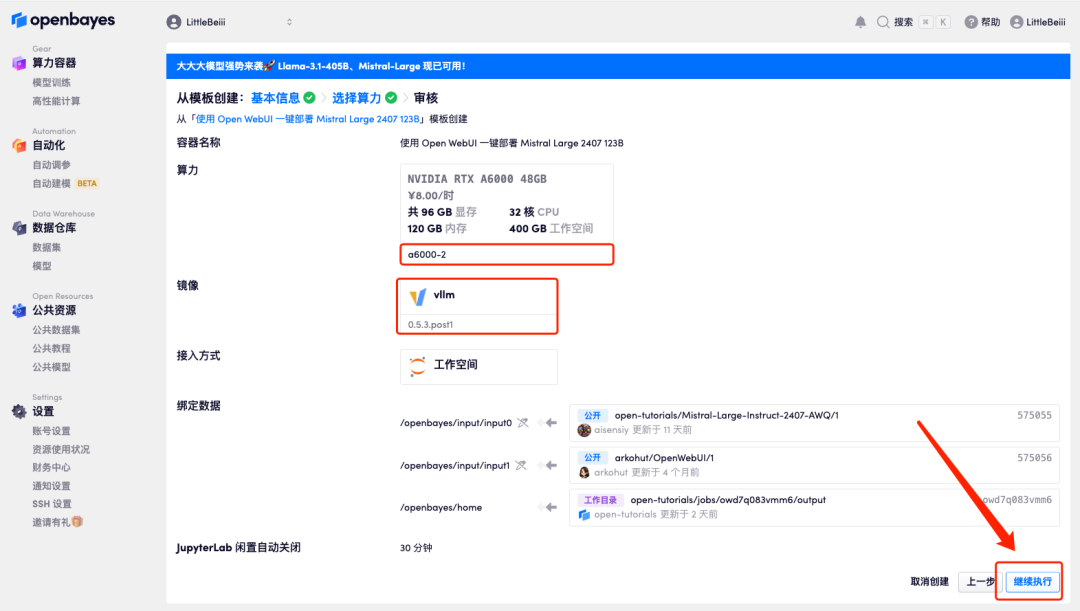

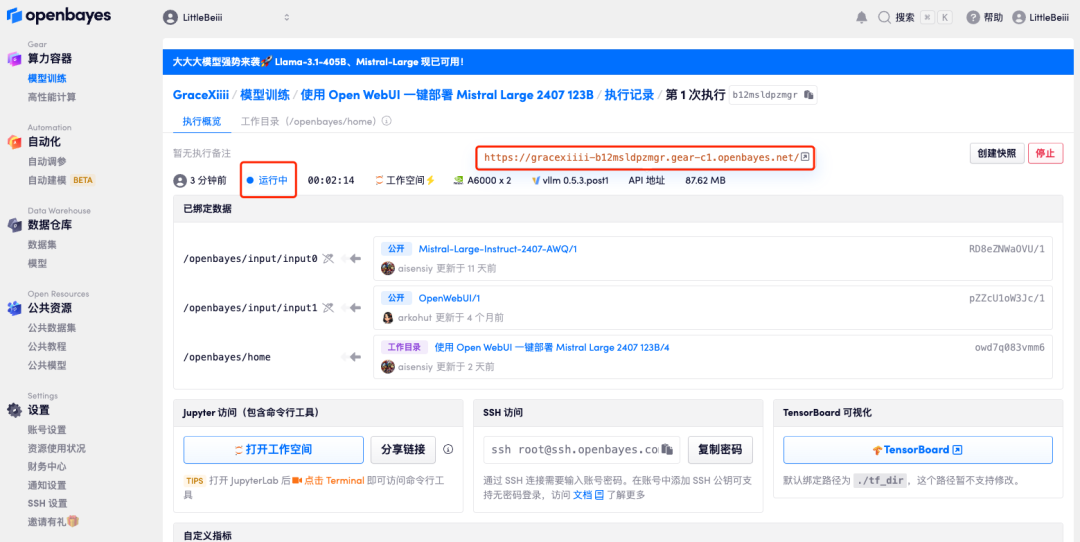

5. 确认无误后,点击「继续执行」,等待分配资源,首次克隆需等待 2 分钟左右的时间。当状态变为「运行中」后,点击「API 地址」边上的跳转箭头,即可跳转至 Demo 页面。请注意,用户需在实名认证后才能使用 API 地址访问功能。

若超过 10 分钟仍处于「正在分配资源」状态,可尝试停止并重启容器;若重启仍无法解决,请在官网联系平台客服。

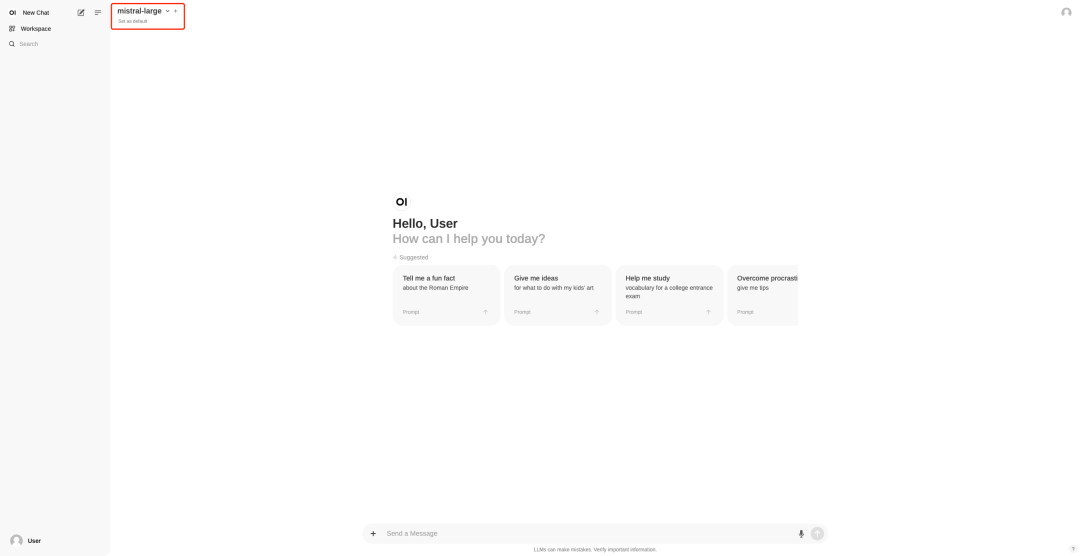

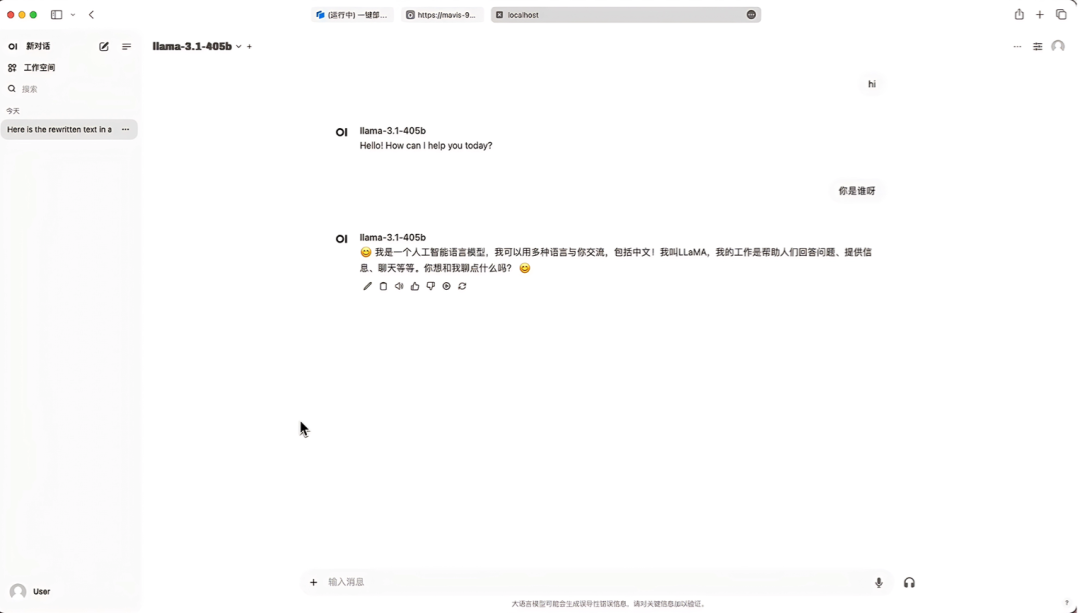

6. 打开 Demo 后,即可立即开启对话。

02 一键部署 Llama 3.1 405B 模型 OpenAI 兼容 API 服务

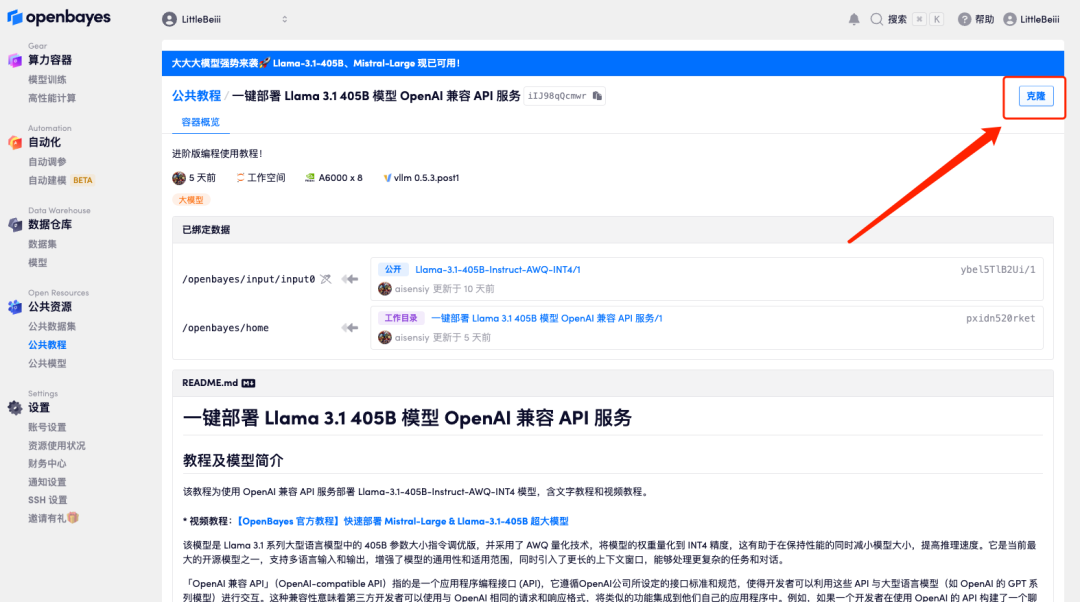

1. 想要部署 OpenAI 兼容 API 服务的小伙伴,在公共教程中选择「一键部署 Llama 3.1 405B 模型 OpenAI 兼容 API 服务」。

2. 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

3. 点击右下角「下一步:选择算力」。

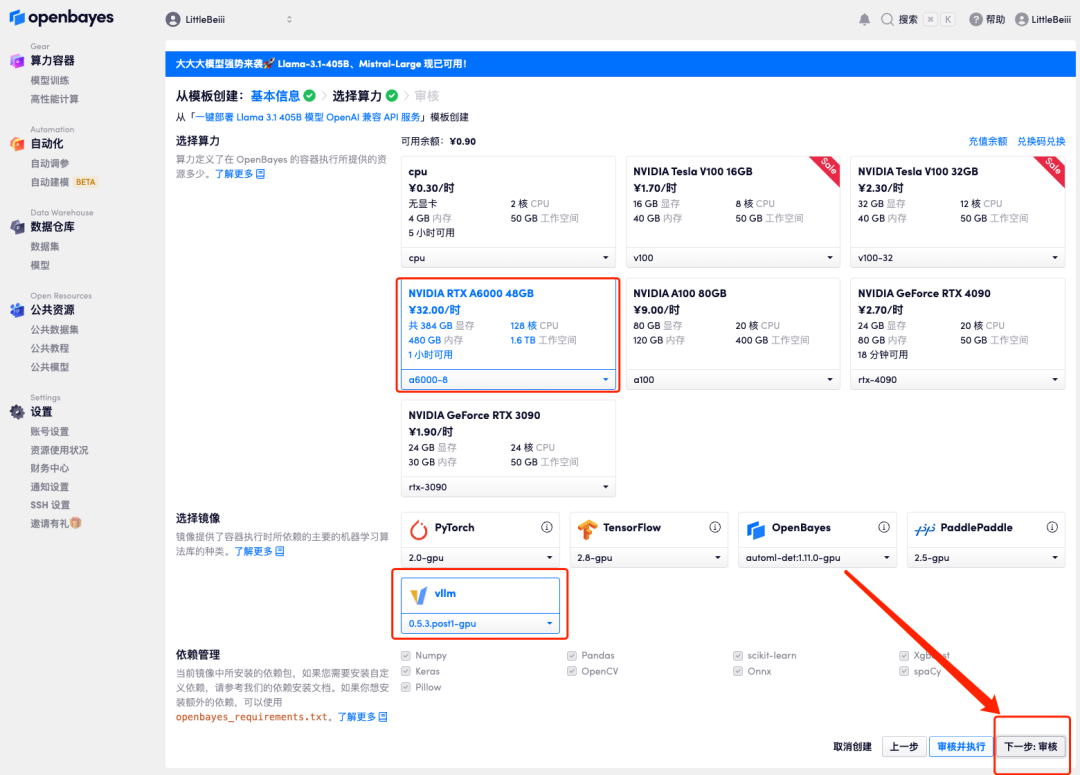

4. 页面跳转后,因模型较大,算力资源需要选择「NVIDIA RTX A6000-8」,镜像依旧选择「vllm」,点击「下一步:审核」。

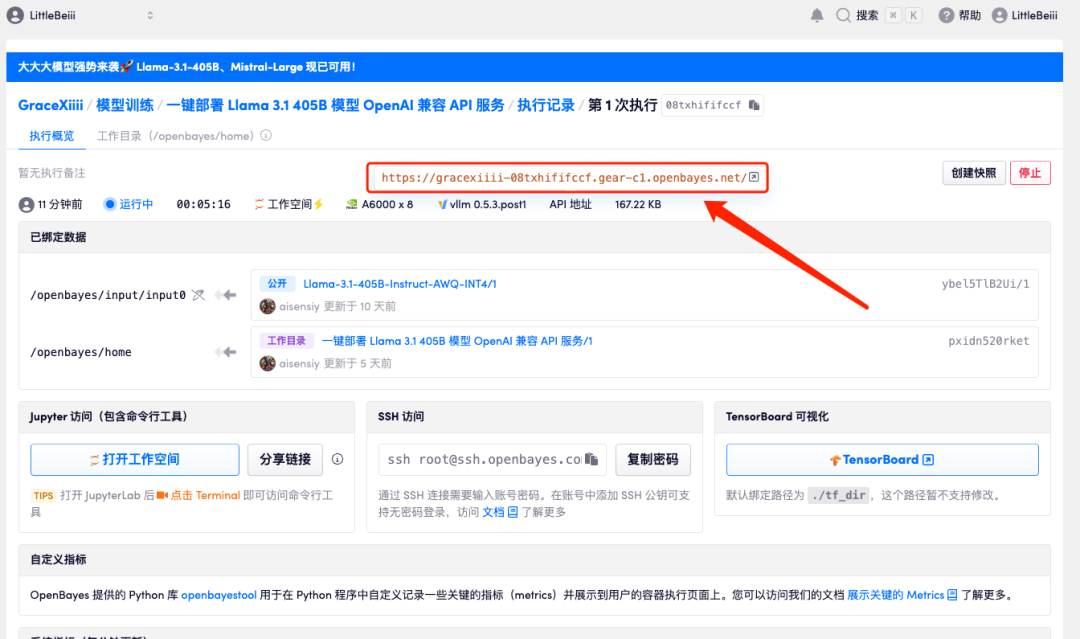

5. 确认无误后,点击「继续执行」,等待分配资源,首次克隆需等待 6 分钟左右的时间,待状态显示为「运行中」后,模型会自动开始加载。

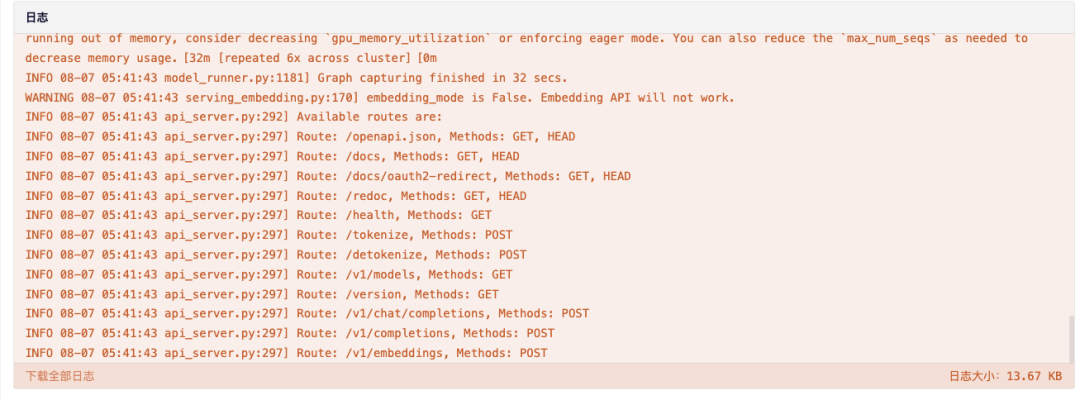

6. 将该界面拉至最底部,当日志显示以下路由信息时,说明服务已经启动成功,打开 API 地址。

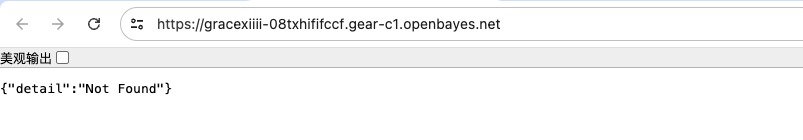

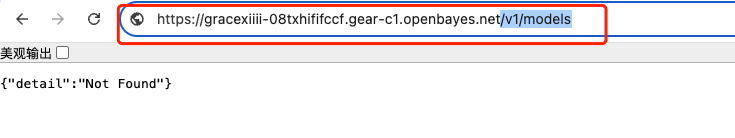

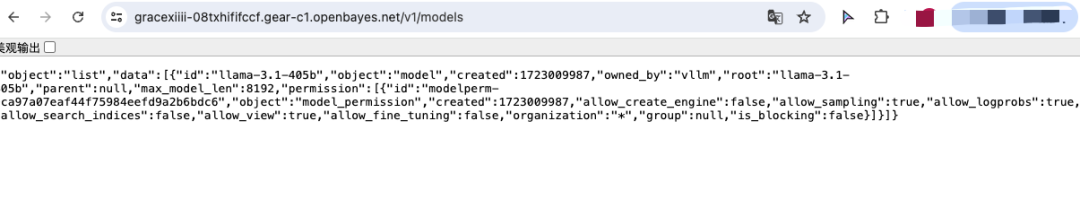

7. 打开后,会默认显示 404 的信息,在红框处添加额外的参数「/V1/models」即可显示当前模型的部署信息。

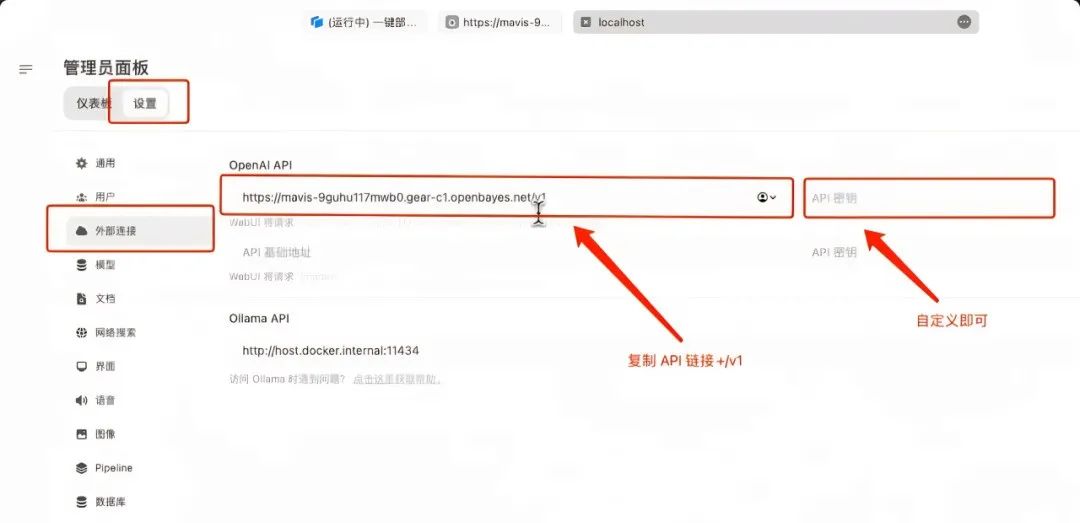

8. 在本地起一个 Open WebUI 的服务,在「外部连接」处起一个额外的连接,在「OpenAPI」处填写之前的 API 地址并 ➕「/v1」,这里没有设置任何「API 密钥」自定义输入即可,输入完毕后点击右下角保存。

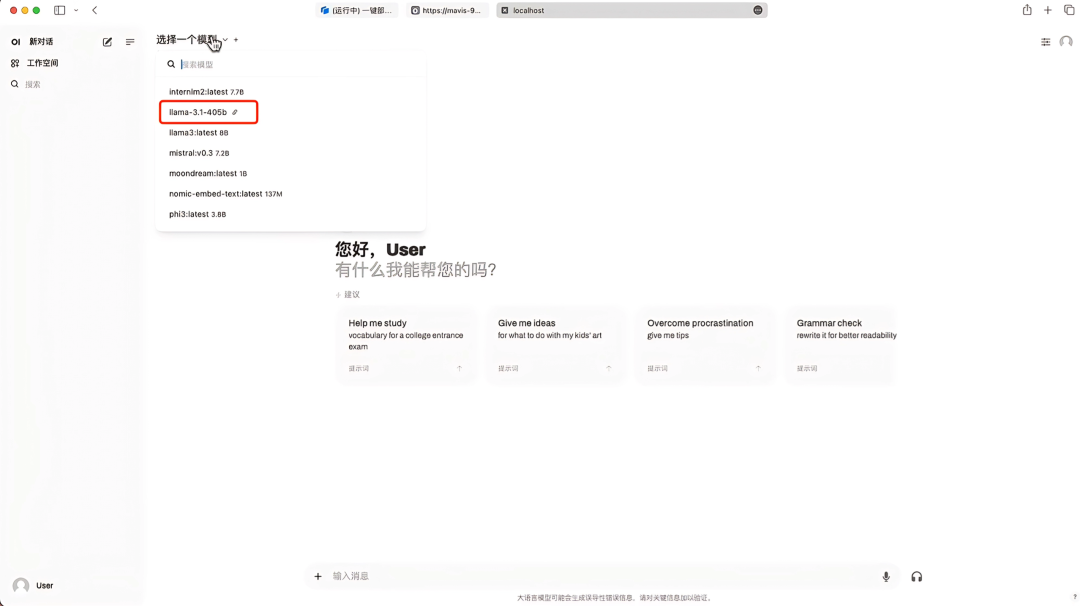

9. 保存后,在「选择模型」这里就可以看到出现了 Llama-3.1-405B,选择该模型后,即可开启对话。

小贝还建立了「Stable Diffusion 教程交流群」,欢迎小伙伴们入群探讨各类技术问题、分享应用效果~添加小贝总微信(微信号:OpenBayes001),备注「SD 教程交流」,即可加入群聊。

650

650

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?