神经网络,作为人工智能领域的“万能工具”,模仿人脑神经元的工作机制,让计算机具备了强大的模式识别和复杂任务处理能力。无论是语音识别、图像处理,还是自然语言理解,神经网络算法都发挥着关键作用。

但你知道吗?神经网络其实有很多“家族成员”和变体,它们各有“拿手绝活”,适合解决不同的问题。理解这些算法,就像拆开AI的“黑匣子”,帮你理清技术脉络,也更容易上手项目实践。

✅ 神经网络算法详解

🔹 感知机(Perceptron)

神经网络的鼻祖。它是一个简单的线性分类器,模拟单个神经元的工作:输入信号加权求和,经过激活函数输出结果。

-

特点:只能解决线性可分问题。

-

意义:奠定了神经网络的基础。

🔹 多层感知机(MLP, Multi-Layer Perceptron)

免费分享一套人工智能+大模型入门学习资料给大家,如果想自学,这套资料很全面!

关注公众号【AI技术星球】发暗号【321C】即可获取!

【人工智能自学路线图(图内推荐资源可点击内附链接直达学习)】

【AI入门必读书籍-花书、西瓜书、动手学深度学习等等...】

【机器学习经典算法视频教程+课件源码、机器学习实战项目】

【深度学习与神经网络入门教程】

【计算机视觉+NLP入门教程及经典项目实战源码】

【大模型入门自学资料包】

【学术论文写作攻略工具】

通过多层隐藏层堆叠,加入非线性激活函数(如ReLU、Sigmoid),实现了对非线性问题的建模。

-

结构:输入层 → 多个隐藏层 → 输出层。

-

算法原理:反向传播算法(Backpropagation)用来调整权重,最小化预测误差。

-

应用:早期广泛用于分类、回归任务。

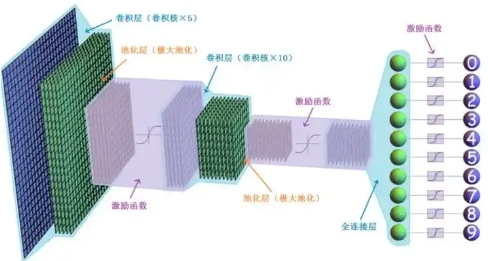

🔹 卷积神经网络(CNN, Convolutional Neural Network)

专门为图像数据设计,能够自动提取局部特征,且对平移具有不变性。

-

核心模块:卷积层、池化层、全连接层。

-

优势:减少参数量、捕捉空间结构。

-

代表网络:LeNet、AlexNet、VGG、ResNet。

-

应用:图像分类、目标检测、医学影像分析。

🔹 循环神经网络(RNN, Recurrent Neural Network)

擅长处理序列数据,内部有“记忆”机制,可以捕捉时间依赖。

-

问题:标准RNN存在梯度消失/爆炸。

-

变种:LSTM(长短时记忆网络)、GRU(门控循环单元),通过门机制解决长依赖问题。

-

应用:语音识别、自然语言处理、时间序列预测。

🔹 自注意力与Transformer

Transformer是近年来NLP革命的核心算法,完全抛弃了RNN结构,基于“注意力机制”并行处理序列。

-

注意力机制:动态权重,关注输入中的关键信息。

-

结构:编码器-解码器架构,多个自注意力层堆叠。

-

代表模型:BERT、GPT系列、T5。

-

优势:训练效率高,捕获长距离依赖能力强。

-

应用:机器翻译、文本生成、图像描述等。

🔹 生成对抗网络(GAN, Generative Adversarial Network)

由两个网络组成:生成器(生成样本)和判别器(判断真假),通过对抗训练不断提升生成效果。

-

创新点:让模型学会“欺骗”对手,逼真合成数据。

-

应用:图像生成、图像修复、风格迁移、数据增强。

🔹 图神经网络(GNN, Graph Neural Network)

处理图结构数据的神经网络,适合社交网络、知识图谱等非欧几里得结构数据。

-

核心思想:节点间信息传播与聚合。

-

代表算法:GCN(图卷积网络)、GraphSAGE、GAT(图注意力网络)。

-

应用:推荐系统、分子结构分析、异常检测。

🔹 自编码器(Autoencoder)

无监督学习方法,通过压缩输入再还原,实现特征提取和降维。

-

结构:编码器 + 解码器。

-

变体:变分自编码器(VAE),结合概率模型生成数据。

-

应用:降噪、异常检测、数据生成。

🧠 总结与应用指导

| 算法类型 | 主要特点 | 典型应用 |

|---|---|---|

| 感知机 | 单层线性分类器 | 基础分类 |

| 多层感知机(MLP) | 多层非线性,反向传播训练 | 经典分类与回归 |

| 卷积神经网络(CNN) | 空间特征提取,参数共享 | 图像处理、目标检测 |

| 循环神经网络(RNN) | 序列数据处理,长短期记忆 | 语音、文本、时间序列预测 |

| Transformer | 自注意力机制,强长依赖捕获 | 机器翻译、文本生成 |

| 生成对抗网络(GAN) | 生成高质量合成样本 | 图像生成、风格迁移 |

| 图神经网络(GNN) | 图结构数据建模 | 社交网络、推荐系统 |

| 自编码器(AE) | 无监督特征学习 | 降维、异常检测 |

🚀 学习建议

想要扎实掌握神经网络算法,建议从基础的感知机和MLP入手,理解反向传播和激活函数;接着学习CNN和RNN,做些图像和序列任务;再进一步探索Transformer和GAN,感受前沿生成与预训练模型;最后结合GNN和自编码器,拓展到图数据和无监督学习。

实践中可结合PyTorch或TensorFlow进行编码实操,配合公开数据集和项目,加深理解。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?