1 大模型的训练数据

数据是大模型的关键要素,其所需的数据的种类也非常广泛,涉及多种模态。以语言大模型为例,其所需要的数据包括多语言数据、代码数据、人工标注数据等多种类别。

1.1 大模型的训练数据处理流程和特点

根据大模型训练的尺度定律(scaling law),数据规模、模型参数与大模型性能存在紧密关系。近期,微软研究工作表明提高数据质量可以极大地改变尺度定律的形状。

通过构建 7B 的小规模“教科书(Textbooks)”高质量的代码训练数据(包括从 web 上筛选的“教科书质量”数据(6B tokens)以及使用 GPT-3.5 生成的教科书和练习(1B tokens)),训练 1.3B 模型 phi-1 在代码评测集 HumanEval 上 Pass@1准确率达到了 50.6%,超越 GPT-3.5(175B,超过 2TB 训练数据)的47%。

该方法表明,通过构建高质量的数据,可以大大降低大模型训练需要的数据规模,具有重要指导意义。

下面是几类用于提升数据质量的预处理方法。

-

**质量过滤:**语言大模型训练中需要过滤低质量数据,主要分为两类方法:基于分类器的方法和基于启发式的方法。基于分类器的方法是训练一个文本质量判断模型,用以识别并过滤低质量数据。例如,GPT3、PaLM和 GLaM模型在训练数据构造时都使用了基于分类器的方法。而基于启发式的方法则是通过一组精心设计的规则来消除低质量文本,主要包括语言过滤、指标过滤、统计特征过滤和关键词过滤,如 BLOOM 和 Gopher都采用了基于启发式的方法。

-

**冗余去除:**语言大模型训练语料库中的重复数据会影响模型性能,降低语言大模型的多样性,并可能导致训练过程不稳定。因此需要对数据进行冗余去除。文本冗余发现(Text Duplicate Detection)也称为文本重复检测,是自然语言处理和信息检索中的基础任务之一。该方法用于数据处理可以发现不同粒度上的文本重复,包括句子、段落以及文档等不同级别,可以有效改善语言模型的训练效果。

-

**隐私消除:**预训练数据中可能包含涉及敏感或个人信息,增加隐私泄露的风险。对于此类问题,最直接的方法是采用基于规则的算法删除隐私数据。例如可以使用基于命名实体识别的算法,检测数据中姓名、地址和电话号码等个人信息内容,并进行删除或者替换。这种方法使用了基于 Transformer 的模型,并结合机器翻译技术,可以处理超过 100 种语言的文本,消除其中的隐私信息。

当前,大模型训练不仅需要大量的无标注数据,而且也需要高质量的人工标注数据,用于模型微调等任务。语言大模型通常需要人类提供明确的指令用于生成有用的输出,标注者通常需要编写提示,典型的提示类型包括如下几种:

-

普通提示(Plain):这种类型的提示是为了确保模型的多样性。标注人员需要设计一系列任务,并确保任务具有足够的多样性,以便模型能够了解不同类型的问题和请求。

-

少量样本提示(Few-shot):这种类型的提示需要标注人员设计一个指令以及该指令的多个查询/响应对。这些示例应该是常见任务或指令,并且应该涵盖各种不同的主题和情境。

-

**基于用户的提示(User-based):**这种类型的提示需要标注人员根据用户使用案例来编写提示。这些使用案例很有可能是源于用户的实际需要,因此标注人员应该尽可能准确地描述任务和需求。

基于上述收集的数据和提示信息,需要准备三类数据集用于不同训练阶段:

-

SFT数据集,标注人员会根据输入的提示给出一些符合需求的示例结果,然后在这些数据上进行有监督学习。

-

RM数据集,对同一个输入,模型会给出多个输出结果,标注员会标注各个结果好坏的排序,然后在这个基础上训练一个奖励模型。

-

PPO数据集,没有任何人类标签,用作强化学习的输入。在数据构建任务中,随着数据量不断增长,需要开发自动化算法来简化流程。例如,数据增强等环节的自动化受到越来越多的关注。这些任务的自动化不仅会提高效率,而且会提高准确性。

此外,自动化可以促进人工标注结果的一致性。多模态大模型需要有大规模的多模态训练数据,这类数据的收集与处理难度相比于单模态数据更大,需构建以低代价挖掘并实现不同模态之间对齐的高质量多模态数据的方法。

未来还需要重点考虑的问题包括:如何构建大模型数据质量评价体系、如何科学地配比训练数据、以及如何在训练不同阶段引入数据等。

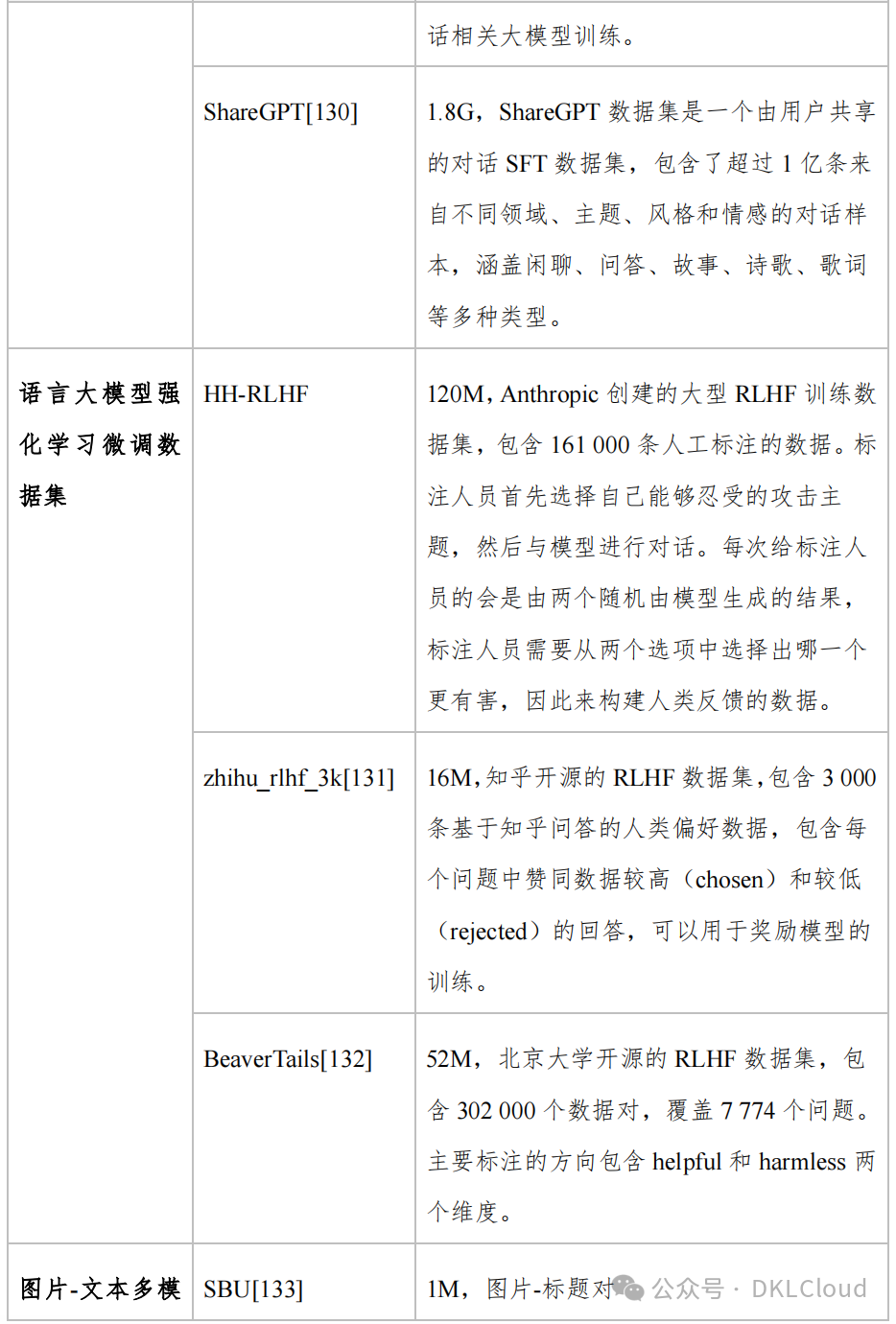

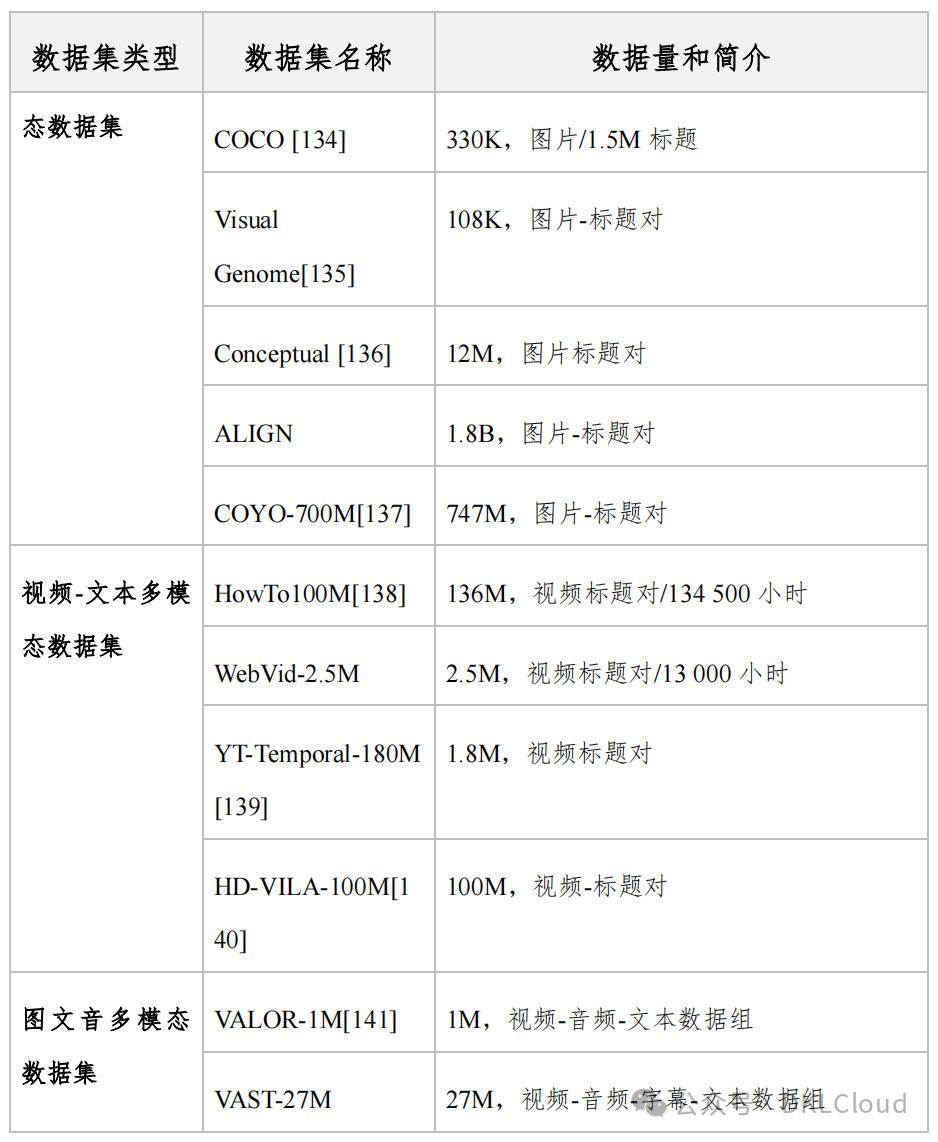

1.3 大模型常用的公开数据集

当前已经出现一批大模型数据集,涵盖多种模态。代表性的数据集既包括 ALIGN、VAST-27M、WebVid-2.5M等多模态数据集,还包括 BookCorpus、Common Crawl、HH-RLHF等语言大模型数据集。

表 1 大模型常用的公开数据集

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

728

728

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?