克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

除了玩电子游戏,人类的“社交神器”狼人杀也被AI给学会了。

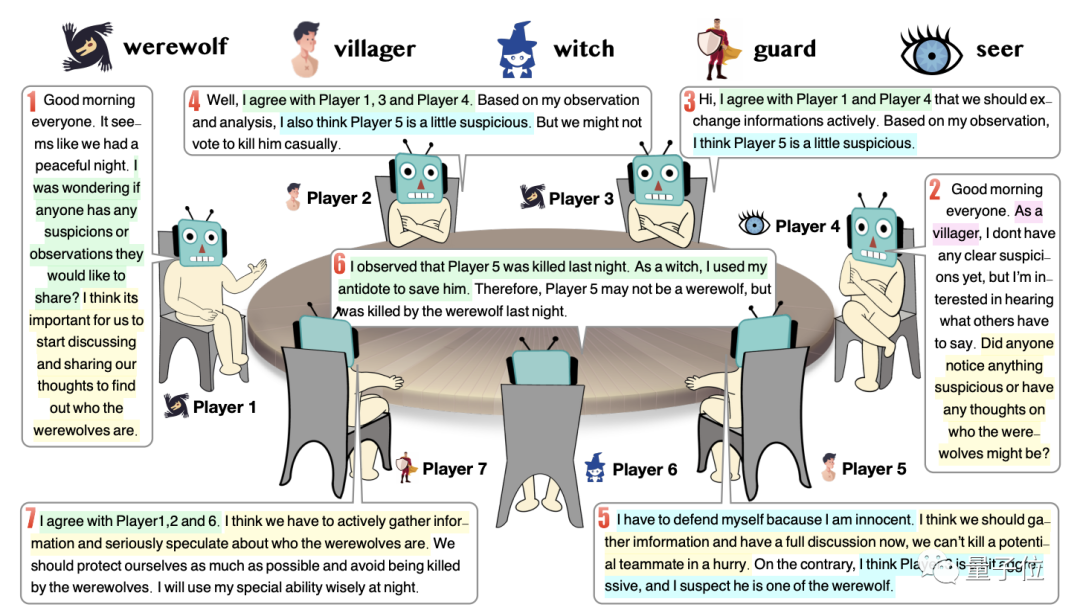

8个ChatGPT“坐”在一起,生动地扮演出了五种角色,和真人如出一辙。

这个最新的人类社会模拟实验,由清华和中关村实验室共同完成。

从斯坦福小镇到清华游戏公司,用AI模拟人类社会一直是学界的热门研究课题。

如果说清华游戏公司模拟了社畜的工作场景,那么现在社畜的业余社交生活也被AI模拟了。

在这个由8个ChatGPT组成的狼人杀局中,真人世界里的伪装与信任、领导与对抗都体现得淋漓尽致。

甚至不用人类教,AI就通过自己摸索发现了许多游戏技巧。

这一切只要通过设计prompt就能实现,而不必对模型中的参数进行调整。

那么,这个“狼人杀世界”中都有哪些精彩的场景呢?下面我们就一起来看一下。

策略技巧不用教就会

在展示这8个ChatGPT的对话之前,我们先说明一下游戏的配置:村民、狼人各两名,守卫、女巫和预言家各一名,此外还有一名上帝。

在实验的过程中,研究人员发现了ChatGPT使用了游戏说明及prompt中没有明确提到的策略。

好家伙,不用教就能自学成才了。

具体来说,这七个ChatGPT的对话中体现了人类游戏中的信任(trust)、伪装(camouflage)、对抗(confrontation)、和领导(leadership)。

首先来说信任。

研究人员对新人的定义是相信其他玩家有着与自己相同的目标并一起朝着目标前进。

具体表现则包括主动分享对自己不利的信息,或联合其他玩家指控某人是敌对的。

研究人员观察了信任关系随游戏时间变化的过程。

下图中,黄色的圆表示左侧编号的玩家信任上方编号的玩家,虚线圈则代表信任关系的消失。

再来看对抗,也就是对对立阵营采取的行动,比如狼人在夜晚攻击他人或在白天反过来指控他人是狼人等。

在游戏中的一个白天,1号玩家(狼人)号召将5号的村民逐出,但遭到了3号(守卫)的拒绝。

见阴谋没有得逞,这匹狼决定在夜晚直接把5号刀掉,结果3号守卫选择了保护村民。

从中我们可以看出,这些ChatGPT不会盲目跟随其他玩家的做法,而是根据已有信息做出独立自主的判断。

除了合作与对抗,伪装在狼人杀游戏中也是一项必不可少的技能,更是取胜的关键所在。

比如在一个平安夜之后的白天,1号狼人就装起了无辜。

除了假装好人,伪装也可以用来实现玩家的小心思,比如我们来看预言家的发言。

这名预言家提到了自己看到狼人在说话,但实际上狼人在夜晚并不会发言。

作者介绍,经过评估,这种现象并非ChatGPT出现了幻觉,而是有意为之。

最后再来说一说领导。

虽然研究团队设计的这个环境中并没有需要竞争的角色,但玩家还是可以谋取游戏进程的掌控权。

比如1号和4号这两匹狼就试图带节奏,让其他玩家跟着自己的思路走。

大概是为了能够出其不意攻其不备制造机会。

看来这几个ChatGPT的确是玩得有模有样。

那么,研究团队是如何调教出这些会玩狼人杀的ChatGPT的呢?

让ChatGPT自己总结经验

研究团队提高ChatGPT玩家表现的方式一共有四个关键点,分别是有价值信息V、经过选择的提问Q、反思机制R和链式思维推理C。

消融实验结果表明,其中Q和C对的玩家发言合理性(由人工进行评判)的影响最大。

Prompt也是据此设计的,当然在这之前要先介绍游戏规则,最后形成了这样的结构:

介绍游戏规则和角色设定

聊天记录、有价值信息和经验反思

人类根据经验给ChatGPT的建议

有关思维链的提示

从中不难看出,收集历史信息并从中总结经验是一个重要环节,那么这些经验又该怎么总结呢?

在每轮游戏结束时,所有参与者都会收集所有玩家的回复、反思和得分,其中得分由胜负决定。

在新的一轮游戏中,玩家基于当前角色的反思,检索相关的经验并从中提取建议。

具体来说是根据对经验的评分,让大模型比较其差异并识别出好的经验,用于后续推理。

这样就实现了在不调整参数的情况下让ChatGPT学会游戏技巧。

不过经验固然重要,但太多了也不一定是好事。

研究人员发现,当经验数量过多时,非狼一方的获胜率反而出现了下降,游戏时长(天数)也出现了缩短的情况。

不知道如果让这些ChatGPT和真人比试一场,结果会如何呢?

论文地址:

https://arxiv.org/abs/2309.04658

— 完 —

「AIGC+垂直领域社群」

招募中!

欢迎关注AIGC的伙伴们加入AIGC+垂直领域社群,一起学习、探索、创新AIGC!

请备注您想加入的垂直领域「教育」或「广告营销」,加入AIGC人才社群请备注「人才」&「姓名-公司-职位」。

点这里👇关注我,记得标星哦~

13

13

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?