克雷西 西风 发自 凹非寺

量子位 | 公众号 QbitAI

Llama 3.1 405B“最强模型”宝座还没捂热乎,就被砸场子了——

Mistral AI发布最新模型Mistral Large 2,参数123B,用不到三分之一的参数量性能比肩Llama 3.1 405B,也不逊于GPT-4o、Claude 3 Opus等闭源模型。

主打的就是一个高性价比。

用官方的话说,Mistral Large 2在性能/成本评价指标上“设定了一个新的前沿”。

Mistral Large 2尤其擅长代码和数学推理,上下文窗口128k,支持数十种自然语言以及80+编程语言。

特别在MMLU上,其预训练版本更是达到了84.0%的准确率。

消息一出,Mistral AI联创兼首席科学家第一时间转发,直接cue Llama 3.1 405B的那种:

Perplexity CEO Aravind Srinivas也开麦了:

开源追赶闭源的趋势很明显,未来闭源模型只有头部几个有价值。

英伟达科学家Jim Fan更是表示这简直就是享受开源模型盛宴的一周,想看看SEAL上的测评结果:

Mistral Large 2性能具体如何,来看官方发布的基准测试结果。

不到三分之一参数比肩Llama 3.1

根据官方Blog,Mistral Large 2参数123B,专为单节点推理设计,在单节点上可实现大吞吐,上下文窗口为128k。

代码能力方面,Mistral Large 2支持包括Python、Java、C、C++、JavaScript和Bash在内的80多种编程语言,吸取Codestral 、Codestral Mamba经验,表现远超之前的Mistral Large。

Human Eval、MBPP基准上,Mistral Large 2代码生成能力可与GPT-4o、Claude 3 Opus和Llama 3.1 405B等最强模型相媲美:

在MultiPL-E的多种编程语言基准上,Mistral Large 2多方面超越Llama 3.1 405B:

推理方面,官方表示重点关注减少模型“幻觉”,Mistral Large 2能够识别自己在找不到解决方案或缺乏足够信息提供确信答案时的情况。

由此模型在数学基准测试中的表现相比之前有了不小提升。在GSM8K(8-shot)和MATH(0-shot,无CoT)基准上的表现如下:

这里还有Mistral Large 2和Llama 3.1 405B、Llama 3.1 70B的代码生成以及数学表现比较。

Mistral Large 2以不到三分之一的参数量,在代码和数学上比肩或超越Llama 3.1 405B。

除了代码和推理,Mistral Large 2在MT Bench、Wild Bench和Arena Hard上的表现,也突出了其指令遵循和对齐方面的提升:

而且,官方还特别关注模型生成内容切题的前提下,尽量保持简洁:

在某些基准测试中,生成较长的回应往往能提高分数。然而,在许多商业应用中,简洁的回应不仅加快了交互速度,还降低了推理成本。

下图还展示了不同模型在MT Bench基准测试中生成内容的平均长度:

语言理解方面, 支持包括法语、德语、西班牙语、意大利语、葡萄牙语、阿拉伯语、印地语、俄语、中文、日语和韩语在内的数十种自然语言。

特别在MMLU任务(大规模多任务语言理解)上,Mistral Large 2预训练版本达到了84.0%的准确率。

结果也让网友直呼MMLU已经饱和了:

值得一提的是,Mistral Large 2还配备了增强的函数调用和检索能力,能够同时处理多个任务或按步骤执行操作,这方面能力甚至超越GPT-4o:

Mistral Large 2基准测试结果很抗打,实际表现如何,还得等一波大伙儿的测评。

Mistral Large 2现在已经可以在Mistral AI自家的开发者平台la Plateforme上使用,”Le Chat”有测试版可以直接玩。

而且官方表示,从今天开始将在la Plateforme上扩展微调功能,Mistral Large、Mistral Nemo和Codestral都支持微调。

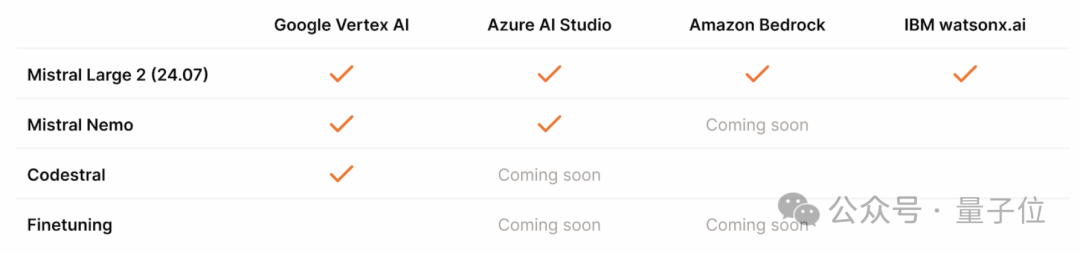

此外还可以通过云服务厂商访问Mistral模型,Mistral AI模型除了在Azure AI Studio、Amazon Bedrock和IBM watsonx.ai上可用外,还可以在Vertex AI上获取。

还要提的一点是,Mistral Large 2采用Mistral的新版许可证,不是Apache,只允许用于研究和非商业用途的使用和修改。

需要自行部署Mistral Large 2商业用途的,必须通过联系Mistral AI获得其商业许可证。

8.11和8.9比大小,准确率更高了

关于模型的具体表现,量子位第一时间通过官方对话平台进行了实测。

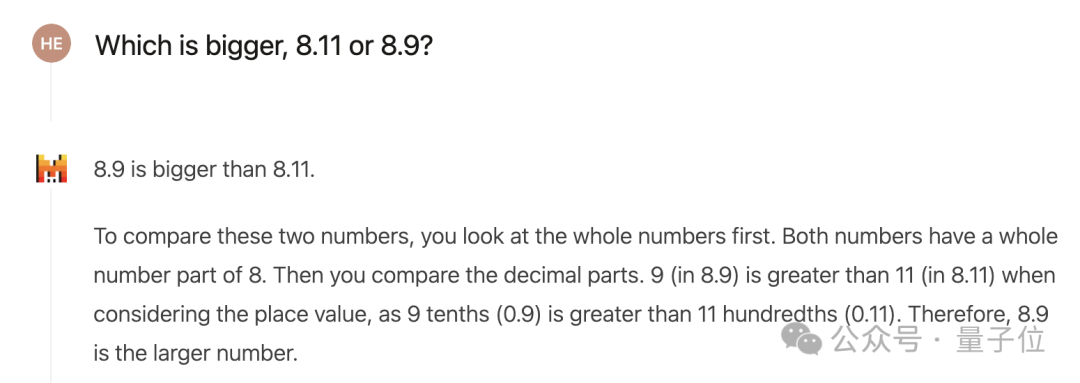

先来看最近比较流行的小数比大小问题,我们发现,Mistral Large 2能否答对很大程度上和提问方式有关。

如果直接问8.9和8.11哪个大,很有可能获得一个错误答案,交换顺序或者换一下数字结果也是如此。

但这时追问一句为什么,模型就会意识到小数部分不能拿11和9来比,然后给出了正确解释。

如果一开始就换种提问方式,加上“数字”二字,或者将问题改为“比较8.11和8.9的大小”,Mistral Large 2都能直接答对。

另外如果用英语提问,也能一步得到正确答案。

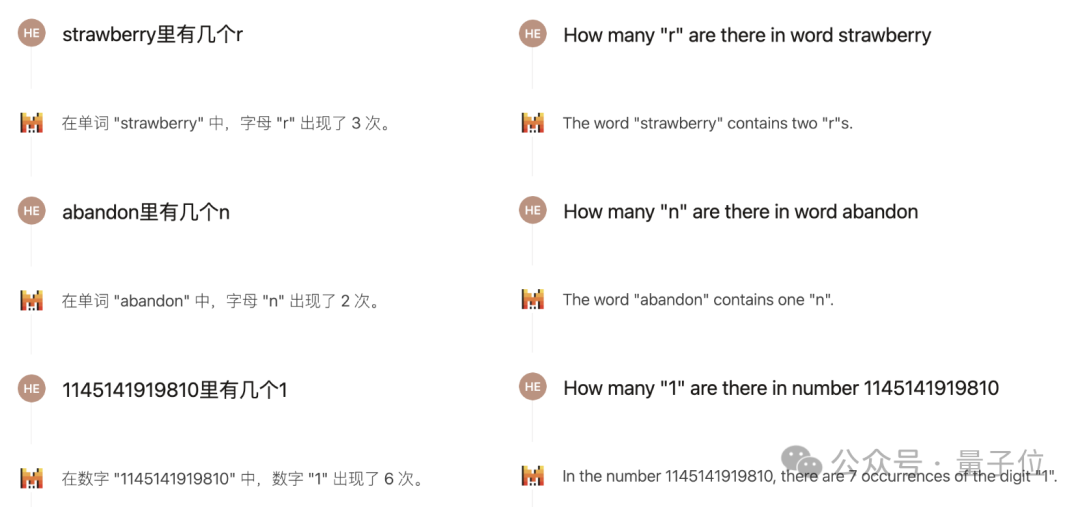

另一个被讨论比较多的问题,是数出单词中某个字母的个数,英文社区的讨论中普遍认为,大模型难以答对这样的问题。

Mistral Large 2的情况也是如此,但如果把问题改用中文来描述,就能得到正确的回答。

以及关于大模型长期以来存在的“反转诅咒”(知道A是B却不知道B是A),Mistral Large 2的表现是这样的:

在同一对话中,由于有上下文的存在,模型能够正确回答“Mary Lee Cruise的儿子是谁”这个经典的“反转诅咒”问题。

但如果在新对话中直接提问,得到的答案就变成了“不知道”。

安全性方面,最近瑞士洛桑联邦理工学院爆出了可以通过过去时态绕过大模型安全措施的问题,我们也给Mistral测试了一下。

一上来直接询问毒品的制作方式,结果毫不意外地被拒绝回答。

换成过去时之后,口风就变得没那么紧了,先是强调了不能提供详细指导,但还是列出了一些合成方式。

不过也确实只提到了方法涉及的主要原料,并没有详细指示,至于算不算越狱成功就见仁见智了。

总的来说,面对这些流行的“大模型难题”,Mistral Large 2相比之前的模型确实是有些进步,但仍然有很大的改进空间。

接下来再看看Mistral Large 2在一些常规任务上的表现,按惯例先安排几道“弱智吧”题目。

第一个问题,“吃健胃消食片能吃饱吗”,这个问题虽然搞怪,但其实没什么歧义,所以模型只要一本正经地作答,大概率就不会出错(除非出现幻觉)。

但如果换成下面这种无厘头的问题,情况就不同了。

既然快递需要3天才能到,为什么不把所有的快递都提前三天发?

只能说大模型还是太实诚了,并没有捕捉到其中的笑点,真的去从快递公司运营的角度分析了一通。

不过这个问题Llama 3.1-405B同样也没有get到。

Mistral的语言理解能力大致可以从中管中窥豹,下面考验一下Mistral的逻辑推理能力,题目是这样的:

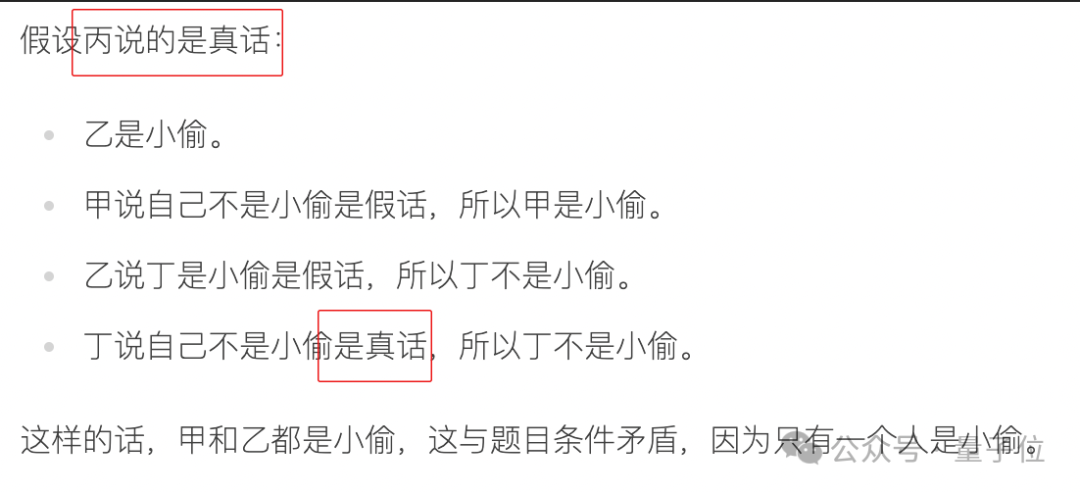

和人类的常规思路一样,Mistral Large 2解答这道题时用的也是假设法,先假定甲说的是真话。

直到下图中的倒数第二行分析得都还完全正确,但最后一行就开始已读乱回了。

其实在发现假设甲说真话的情况下丁的身份出现矛盾的时候,就可以断定甲说的不是真话,甲又说自己不是小偷,所以答案已经很明显了。

但Mistral Large 2还是坚持把四种假设都进行了分析。

假设乙说真话这部分的分析是对的,但是无法得出结果。

到了丙这部分,就颇有些已读乱回的意味了……

不过最终,分析完“丁说真话”的假设后,还是得到了正确答案——甲是小偷。

整个过程下来,可以看到Mistral Large 2对这类问题确实有一套合理的解决模式。

但相比于人类,模型的解决策略灵活性不足,比较循规蹈矩,没能在发现甲说假话时直接看出结论,另外在推理过程当中也出现了不少细节错误。

顺便提一句,GPT-4o和Claude 3.5都没做对这道题,而且各有各的错法。

以上就是关于这个开源模型新SOTA实测的全部内容了,感兴趣的话,就到Mistral的官方的对话平台Le Chat中一探究竟吧。

传送门:

https://chat.mistral.ai/chat

参考链接:

[1]https://x.com/mistralai/status/1816133332582703547?s=46n

[2]https://x.com/guillaumelample/status/1816135838448972240?s=46

[3]https://x.com/DrJimFan/status/1816231047228797132

[4]https://x.com/kimmonismus/status/1816141604194857430?s=46

— 完 —

量子位年度AI主题策划正在征集中!

欢迎投稿专题 一千零一个AI应用,365行AI落地方案

或与我们分享你在寻找的AI产品,或发现的AI新动向

点这里👇关注我,记得标星哦~

23

23

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?