快速体验

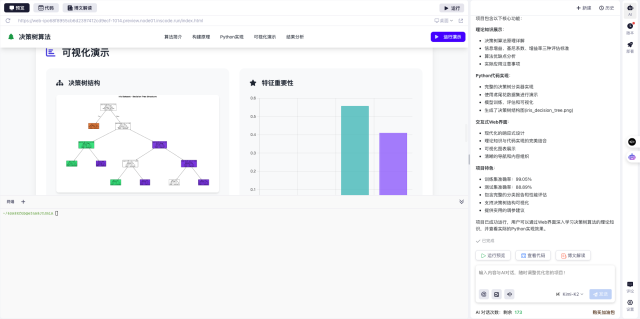

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框输入如下内容

帮我开发一个深度学习优化系统,用于简化分布式模型训练和推理流程。系统需要支持:1.基于ZeRO技术的显存优化 2.3D并行训练功能 3.混合专家(MoE)模型处理 4.PyTorch框架集成。注意事项:需预装CUDA和PyTorch环境 - 点击'项目生成'按钮,等待项目生成完整后预览效果

-

核心价值理解 DeepSpeed作为微软开源的深度学习加速库,其突破性在于通过ZeRO内存优化技术,能将模型参数、梯度和优化器状态分布在多个GPU上,显著降低单个设备的显存占用。实验数据显示,这使得百亿参数模型的训练成为可能,相比传统方法可节省多达5倍显存。

-

环境准备要点 实际安装前需特别注意CUDA版本与PyTorch的兼容性。例如CUDA 11.x需对应PyTorch 1.8+版本,若使用A100显卡则必须选择CUDA 11.0及以上。虚拟环境创建虽为可选步骤,但强烈推荐使用conda管理环境,能更好解决依赖冲突问题。

-

配置深度优化 配置文件中的fp16混合精度设置需要结合硬件特性调整,新一代NVIDIA显卡建议开启bf16支持。训练批次大小的设置需考虑显存容量与通信开销的平衡,通常建议从较小值开始逐步调优。分布式训练时还需注意节点间网络带宽对并行效率的影响。

-

实战调试技巧 遇到初始化失败时,可先运行

ds_report命令检查环境完整性。常见的OOM错误可通过梯度累积(gradient_accumulation_steps)或激活检查点技术缓解。监控工具如DeepSpeed的日志系统和NVIDIA-smi配合使用,能有效定位性能瓶颈。

在InsCode(快马)平台实际体验时,发现其预置的PyTorch环境能自动匹配CUDA版本,省去了手动配置依赖的麻烦。通过网页终端直接验证DeepSpeed安装的状态非常直观,对于需要快速验证技术方案的场景特别友好。平台提供的Jupyter环境还能直接运行分布式训练示例代码,比本地搭建环境效率高出不少。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

274

274

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?