第1周-深度学习简介

【总结】

-

Scale drives deep learnig progress:Data,Computation,Algorithms

-

非结构化数据:图片,音频,文本

-

R e L U ReLU ReLU (Rectified Linear Unit) 修正线性单元

相比于其它激活函数来说, R e L U ReLU ReLU有以下优势:

- 计算梯度简单,梯度下降更快;

- R e L U ReLU ReLU由于非负区间的梯度为常数,因此能够解决 s i g m o i d sigmoid sigmoid 存在的梯度消失问题,使得模型的收敛速度维持在一个稳定状态;

- R e L U ReLU ReLU会使一部分神经元的输出为0,这样就造成了网络的稀疏性,并且减少了参数的相互依存关系,缓解了过拟合问题的发生。

第2周 神经网络基础

【总结】

-

神经元节点先计算线性函数( z = W x + b z = Wx + b z=Wx+b),再计算激活。

-

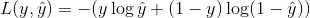

l o g i s t i c logistic logistic 回归的loss function:

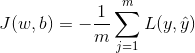

l o g i s t i c logistic logistic 回归的cost function:

-

将一个(32,32,3)的数组转换为列向量?

x = img.reshape((32 * 32 * 3, 1))

- python中的广播机制(

broadcasting)

- 简单来说,broadcasting可以这样理解:如果你有一个 m ∗ n m * n m∗n的矩阵,让它加减乘除一个 1 ∗ n 1 * n 1∗n(或 m ∗ 1 m * 1 m∗1)的矩阵,它会被复制 m m m (或

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?