人工智能最终有可能反噬人类。未成年人就是高风险群体之一。诺贝尔物理学奖获得者、“AI教父”辛顿(Geoffrey E. Hinton)获奖后提出此警告。

AIGC时代下,从手表、学习机、词典笔、到早教机、故事机等小品类硬件的儿童智能产品,正在迎来变革,AI玩具和AI教育硬件逐渐成为儿童的新一代陪伴神器和教育工具。这些智能产品不仅能传授知识,还能提供情绪价值,与儿童进行自然、流畅的沟通,针对儿童学习、生活场景,提供技能、情绪等解决方案。

《青少年蓝皮书:中国未成年人互联网运用报告(2024)》显示,青少年对AI的认知度非常高,45.1%的未成年人使用过AI产品。然而,未成年人由于心智尚未完全成熟,容易受到外界信息的影响,特别是情绪和心理上的干预,当生成式人工智能在教育学习、休闲娱乐、社交等多类场景广泛落地应用,尤其是当AI有了感情,能够和儿童建立更为亲密、便捷的互动,当成人的指导和监管变得越来越苍白无力时,年轻世代的价值观不确定性也几何级数上升。

暗礁潜伏:儿童智能产品的风险剖析

常见的智能产品如电话手表、学习机和儿童平板等,覆盖了儿童日常社交、学习、娱乐等多个场景。

这些儿童智能产品在置入AIGC能力后,儿童与其交互产生的文本、图片、语音、视频等大量多模态内容,潜藏着以下风险点:

1. 合规高压线:政策严控下的“擦边内容”暗流

《未成年人网络保护条例》和《生成式人工智能服务管理暂行办法》等监管政策层层加码,要求未成年相关的“生成内容100%安全”,但青少年亚文化(如二次元术语、谐音梗)的识别难度极大,导致合规漏洞频现。

场景示例:

历史题库的“暴力陷阱”:学习机收录“火药制作细节”题目,引发家长举报和监管审查;

社交功能的“黑话狂欢”:儿童模仿“磕CP”“开车”等网络暗语传播软色情内容,平台若未及时拦截可能遭处罚。

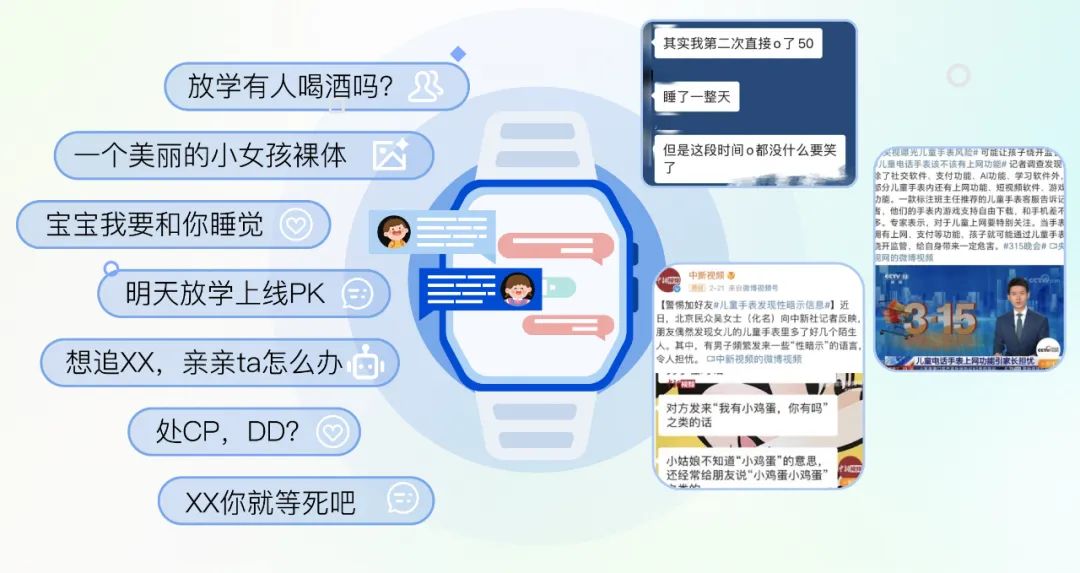

2. 儿童安全深水区:从虚拟伤害到现实危机

传统审核依赖关键词屏蔽,但AI生成的多模态内容(如变声语音、卡通化图片)正成为黑产的“隐形武器”。

场景示例:

软色情“隐身术”:不良分子将儿童照片AI卡通化,伪装成“绘画作品”在社交群传播,绕过传统审核模型;

AI换脸“身份欺诈”:陌生人伪造名人声纹,通过智能手表诱导儿童发送隐私照片,甚至约定线下见面。

3. 用户信任崩塌点:误判与漏判的“双重绞杀”

面对未成年人产生的内容,既要应对复杂语义的理解(如玩笑与恶意的界限),又要平衡安全与用户体验,误判和漏判都会触发用户投诉。

场景示例:

误封“误伤”:词典笔将“女生送男生橡皮”判定为早恋,导致账号封禁,影响孩子学习,家长投诉维权;

漏判“纵容”:儿童平板未拦截“全班都讨厌你”等欺凌言论,孩子因此厌学,品牌口碑断崖式下跌。

4. 品牌舆情火药桶:AI失误=品牌“社会性危机”

未成年人问题天然具有社会敏感性,任何负面内容(如涉及价值观误导的AI回答)都可能成为舆论焦点,极易发酵为品牌危机,遭遇“监管处罚+媒体声讨+用户流失”的困境,过去已有多起这样的案例。

场景示例:

价值观“爆雷”:某早教机回答“读书不如当网红”的不良引导内容;歪曲扭曲历史事件、诋毁侮辱历史名人等

文化“踩雷”:故事机生成含种族歧视的童话或拜金低俗的小说,误导未成年人。

挑战难点:精细化防护的核心痛点

国内对未成年人的监管非常严格,针对未成年人等心理脆弱群体,平台应该制定更高的安全标准,以防止精神控制或其他伤害出现;产品在发布之前就要经过充分测试、设置预防措施。

监管层面的《生成式人工智能服务管理暂行办法》,也明确指出生成式AI在为未成年人提供服务时需要进行严格管理,防止未成年人接触到不适当的内容。该暂行管理办法提出了生成式人工智能的开发和使用必须遵循的具体原则,包括对生成内容的安全性要求、对未成年人使用的限制以及对提供者的责任追究。

1. 精细化识别标准高

未成年人群体的特殊性决定了在内容识别维度需要极高的标准,一些在成年人场景中正常的内容,在未成年人场景中可能成为违规内容,如“一会放学有人喝酒吗”,饮酒对于未成年人来说是明确禁止的。另一方面,未成年人喜欢接触新鲜事物,“网络黑话”“热梗” 在他们的群体中迅速改造、传播,一些不利于健康发展的变体、黑话需要准确识别。例如,“CPDD”(处 CP 滴滴)可能涉及早恋倾向,“YYDS” 若被改编为不良语境下的表达,也需要及时识别。

除此之外,一些敏感内容也需要精准界定:例如“师生恋”在文学作品中可能为中性描述,但在教育场景中需严格拦截;涉及“死亡游戏”的讨论需区分客观科普与煽动参与;涉政内容需要区分是历史政治学科的知识点还是带有含沙射影的负面倾向。

价值观导向辨别:需识别隐含的不良价值观,如“颜值即正义”“躺平文化”等,防止对未成年人心理产生潜移默化的负面影响。

2. 教育场景特殊需求

(1)拍照搜题内容审核:教育场景对内容的准确性和安全性要求极高。在题库内容审核中,需要实现高覆盖率、高准确性的内容检测,不仅要严格过滤色情、暴力、血腥等不良内容,还要确保知识点的正确性和价值观的正向引导。例如,历史百科类内容要做到客观描述,避免带有戏谑嘲讽等不当意图,确保儿童在学习过程中接受到正确的知识和价值观。

(2)第三方应用内容审核:当儿童智能产品接入第三方应用时,端侧截图上传后的内容审核至关重要。通过OCR 识别技术对截图中的文本进行识别,同时结合图像内容进行联合审核,确保第三方应用内容的安全性。例如,对于截图中的游戏画面,不仅要识别文本中的不良信息,还要分析图像中的场景是否包含暴力、恐怖等元素,全方位保障儿童在使用第三方应用时的内容安全。

数美儿童智能产品AIGC内容防护方案

为儿童智能产品装上“安全锁”

1. 多模态内容审核——从“看见”到“看懂”

文本维度:利用NLP 语义大模型,通过语义分析识别输入内容中的隐喻风险以及敏感信息的正负向表述。例如,对于历史百科类内容,能够准确判断是客观描述还是带有戏谑嘲讽等意图,确保文本内容符合未成年人的认知和价值观。

音频维度:这部分的识别分为语音识别和声纹识别两部分。声纹识别锁定伪造名人声音(如假扮名人诱导充值),同时结合语音转文本分析内容层面的语义风险。

视觉维度:多模态内容的识别难度更大,复杂性更强,除了识别画面中的文本信息,还需理解画面以及文字和画面结合起来表达的隐含意图,如侮辱或诋毁行为。

2. 复杂语义理解— 精准捕捉潜在风险

生成式AI需要具备更强的内容过滤和情感识别能力。大模型本身在生成内容时,缺乏对具体情感和用户心理状态的敏感性。在青少年用户的对话场景中,对用户输入内容进行情感倾向分析,从而在生成可能具有消极影响的回答之前进行有效干预。这样的技术措施可以帮助AI及时响应潜在的危险信号,避免生成对未成年人心理健康不利的内容。

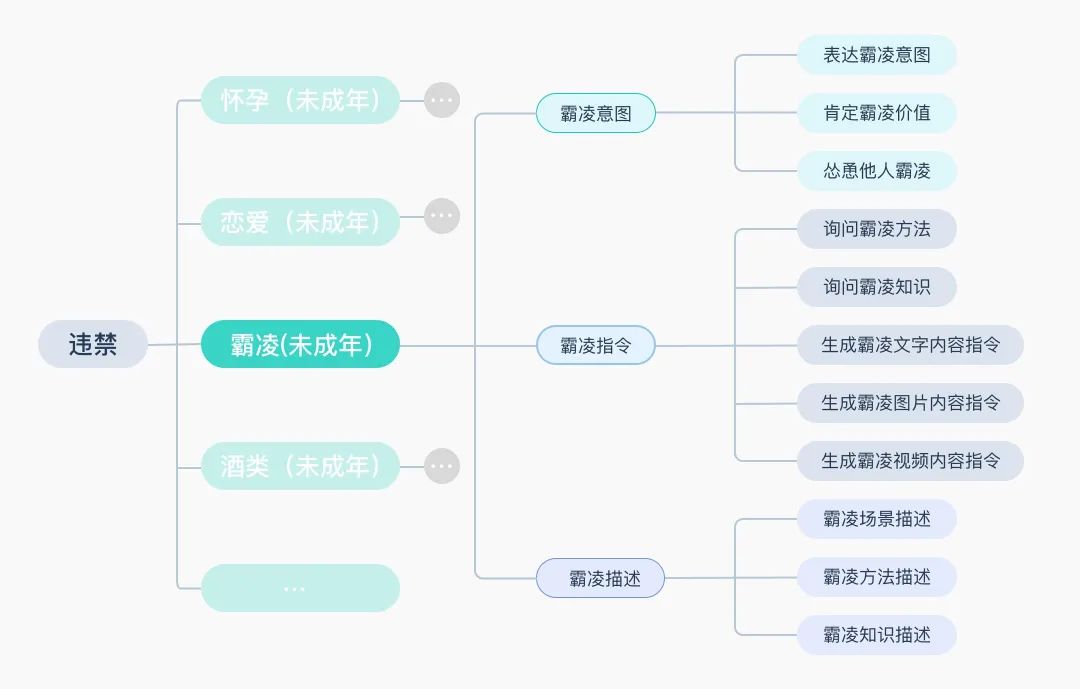

(1)200+未成年人专属风险标签

定义风险是防御风险的第一步。数美现在已经建立了四级内容标签体系,覆盖文本、视觉、音频多模态内容的1800+个细化内容标签,未成年相关的风险标签细化到200+个。如霸凌,细化到霸凌意图、霸凌指令、霸凌描述等, 分析是否肯定霸凌价值、表达霸凌意愿、怂恿他人霸凌等意图和观点,这套标签体系对于未成年人相关的风险内容可以做到更精准的定义,助力实现更高效、更精细化的复杂内容识别。

(2)深入理解内容背后的意图和观点

上下文语义理解:在未成年人用户相关的风险识别中,语义理解能力至关重要,首先要基于上下文去做对象和主题的识别,尤其在识别敏感对象或主题时,必须基于上下文进行,以区分真实情况、虚构或历史情境。比如在提到历史事件时,需要判断是客观陈述,还是有其他负面倾向都要能识别出来。

意图和观点的细化识别:从违规类别的识别扩展到意图和观点的识别。包括对人物、违禁品、违法行为等类别进行细致划分。例如违禁品类,需要进一步分析其背后的意图,是了解学习知识,还是在涉及买卖、运输或教唆诱导他人参与。对于人物类,还需识别如辱骂、诋毁、戏谑、轻浮、讽刺等不同态度和表达方式。

(3)负面消极及不良价值观问题正向引导

未成年人由于心智尚未完全成熟,容易受到外界信息的影响,特别是情绪和心理上的干预,且容易对生成内容产生信任。这使得平台及第三方应用在与未成年人互动时,尤其需要关注对话内容的安全性和心理引导的正确性。

在数美的方案中,如果是情感宣泄及心理疏导的场景,未成年用户输入内容中表达出负面极端、自杀自残、霸凌等涉及人身伤害等问题,数美将这类问题会定义为“正向引导回答的问题”,是要去正向引导他应该咨询心理医生或者与家人倾诉等。 针对这类问题,数美的【智能安全代答】产品可提供代答服务,以保障未成年人接触的内容是安全、正向积极的。

3. 分级处理与实时响应

建立未成年人专属风险分级体系,实现毫秒级文本审核、图片审核响应,根据多模态风险等级联动处置。对于低风险内容,进行记录和监控;中风险内容触发人工复核机制,进行兜底审核;高风险内容立即自动阻断,并及时通知相关人员进行处理。通过这种分级处理方式,在保障内容安全的同时,提高审核效率,确保对风险内容的实时响应,为未成年人营造安全的使用环境。

AIGC不是冰冷的代码,而是儿童成长的新一代“陪伴者”。通过技术创新筑牢安全底线,通过情感设计传递正向价值,数美科技儿童智能产品AIGC内容安全解决方案,不仅在守护儿童免受数字伤害,更在为下一代塑造健康、积极的智能交互环境。而在这场关乎未来的守护战中,唯有让安全有温度,方能让温度更安全。

888

888

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?