1.从过去到未来

以往较多使用单一特定任务的专用模型,但目前向单一模型多模态多任务方向发展。eg.gpt4 单一语言模型-->图片表格等多模态

2.

internLM-7B开源商用,多语言,全链条开源工具。

internlm-chat-7B使用lagent框架使模型不只支持语言模型单一功能

7b目前是轻量化社区应用 20B目前也是开源

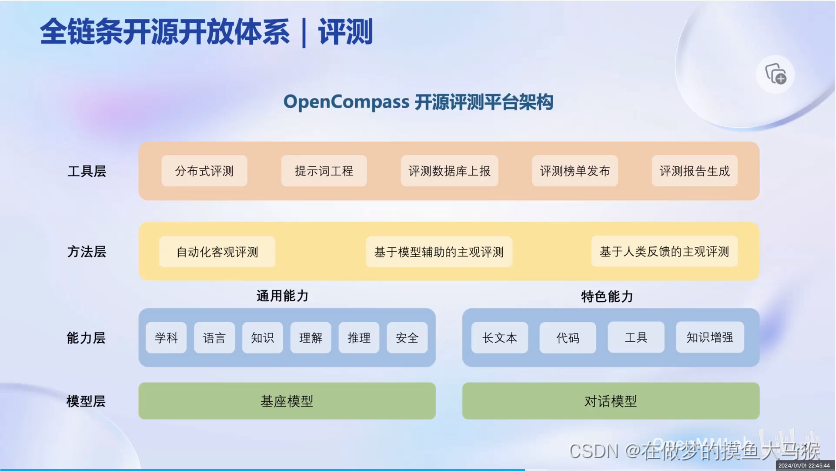

opencompas用以评价

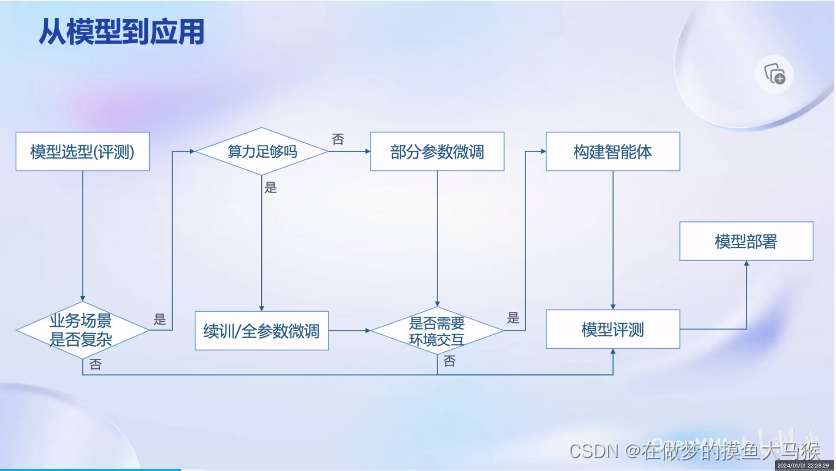

3.选模型

模型部署:更少资源更高吞吐量,多并发

全体系:

agentlego:大模型工具箱,视觉多模态接口都放入

1)书生万卷

图文视频都有,多领域多模态。

2)datalab的数据内容更多,带智能标注工具

3)预训练工具

4)增量续训和有监督微调

增量续训针对垂直领域知识,大长段书籍文章与代码

有监督微调通常是让模型完成、遵循各种指令或者注入少量内容,使用高质量对话及问答:

全量参数微调

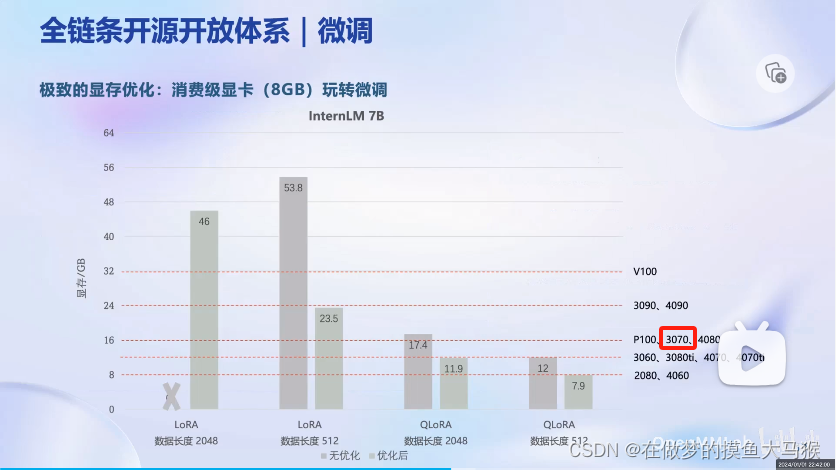

部分参数微调(Lora:固定原有的参数,引入新的参数进行微调)

这里可以使用到高效微调框架Xtuner:多种不同微调方式-->最低只需要8GB即可微调Lora(?)

最低的8GB在QLoRA算法,数据长度512的时候为7.9GB勉强能调

一定要注意显卡是否支持不然真的吃大亏

5)opencompass

6)部署及部署优化

都在图里-->lmdeploy全流程解决方案:之后要关注部署的消耗。给出的例子都是用的A100,如果是多张消费级显卡会是什么效果。

5.大语言模型的局限性:

1)难以获取最新信息和知识

2)回复的可靠性-->这里要关注用途:if我要pin point一点指出一个具体的事情例如某种医疗疾病我需要怎么操作;

3)数学能力较差-->群里有人出现1+3=6的运算结果,助教给出的介绍是7B数学性能较弱,建议使用20B

4)外部工具使用交互有难度

解决方案-->智能体:以大语言模型为核心,完成不同调用链

目前可使用的是Lagent,偏向作为框架使用:

eg:代码解决数学题以及零样本泛化:多模态AI工具使用(医学上是不是可以使用来进行分割、分类、定位识别、报告生成)

多模态智能体工具箱agentlego:更多作为工具箱使用

本文探讨了从单一任务专用模型向多模态多任务发展的趋势,介绍了InternLM-7B开源模型和AgentLego工具箱。文章还涉及模型部署策略,如资源优化和微调方法,同时指出了大语言模型在获取新知识、可靠性及数学能力上的局限,并提出利用智能体来增强其功能。

本文探讨了从单一任务专用模型向多模态多任务发展的趋势,介绍了InternLM-7B开源模型和AgentLego工具箱。文章还涉及模型部署策略,如资源优化和微调方法,同时指出了大语言模型在获取新知识、可靠性及数学能力上的局限,并提出利用智能体来增强其功能。

109

109

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?