概述

随着人工智能技术的快速发展,本地化部署大模型的需求日益增长。DeepSeek 作为一款开源且性能卓越的大语言模型,提供了灵活的本地部署方案,使用户能够在本地环境中高效运行模型,同时充分保障数据隐私。本文将详细介绍 DeepSeek 的本地化部署流程。

环境准备

(一)硬件需求

-

最低配置:

-

处理器:支持AVX2指令集的CPU

-

内存:16GB

-

存储空间:30GB

-

-

推荐配置:

-

显卡:NVIDIA GPU(RTX 3090或更高)

-

内存:32GB

-

存储空间:50GB

-

(二)软件依赖

-

操作系统:

支持Windows、macOS或Linux系统。 -

Docker:

如需使用Open Web UI,需提前安装Docker。(通过其他方式也可安装)

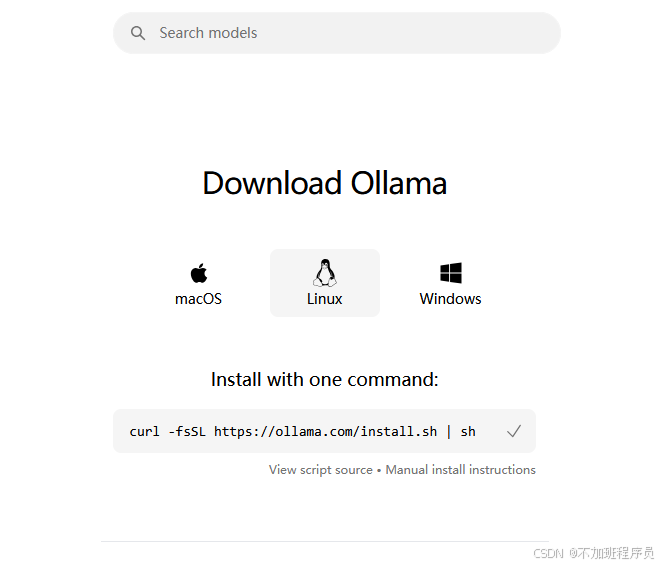

ollama安装

Ollama是一个开源工具,用于在本地轻松运行和部署大型语言模型。以下是安装Ollama的步骤:

访问官网下载指定版本的安装包:

官网地址:

我本地为乌班图系统,所以下载命令如下:

curl -fsSL https://ollama.com/install.sh | sh

安装完成通过命令检测是否安装成功

ollama --version

如果输出版本号(例如ollama version is 0.5.6),则说明安装成功。

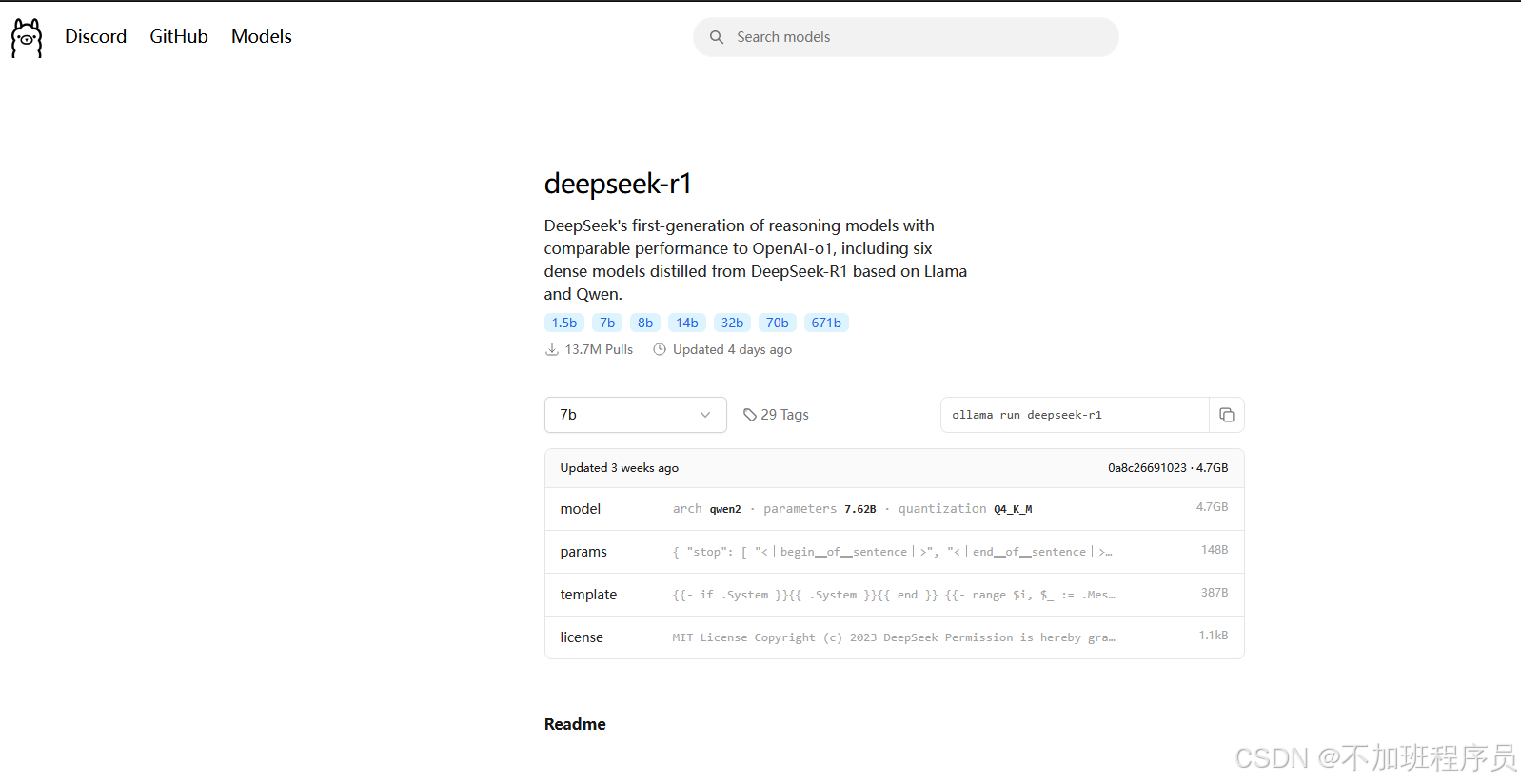

deepseek下载

选择模型版本

- 入门级:1.5B版本,适合初步测试。

- 中端:7B或8B版本,适合大多数消费级GPU。

- 高性能:14B、32B或70B版本,适合高端GPU。

打开终端,输入以下命令下载并运行DeepSeek模型。例如,下载7B版本的命令为:

ollama run deepseek-r1:7b

该命令为运行模型的命令,第一次运行时模型不存在会自动下载,后续可通过该命令直接运行。

启动Ollama服务

在终端运行以下命令启动Ollama服务:

ollama serve

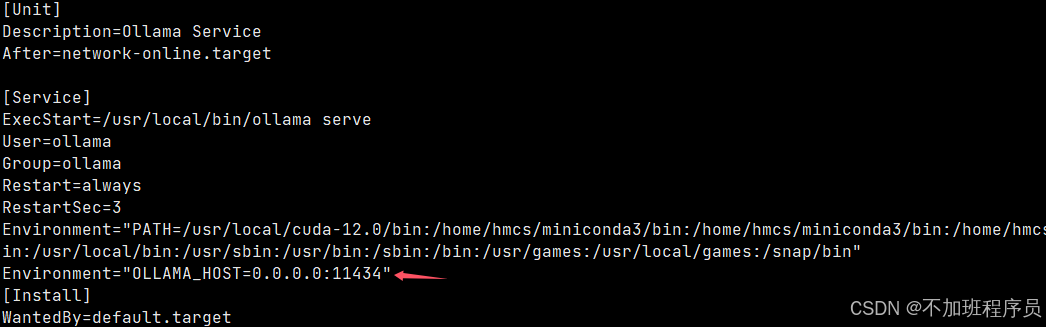

如果要通过ip端口访问该服务,需要修改配置文件(root)/etc/systemd/system/ollama.service

增加一行配置

Environment="OLLAMA_HOST=0.0.0.0:11434"

然后重新加载配置并启动

systemctl daemon-reload

systemctl restart ollama

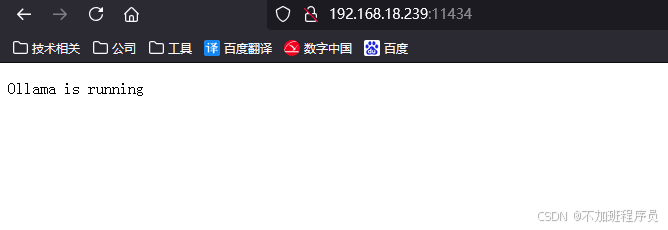

重启ollama后出现如下界面则成功

到目前为止,deepseek已经安装完成,能够完成基本的问答交互。

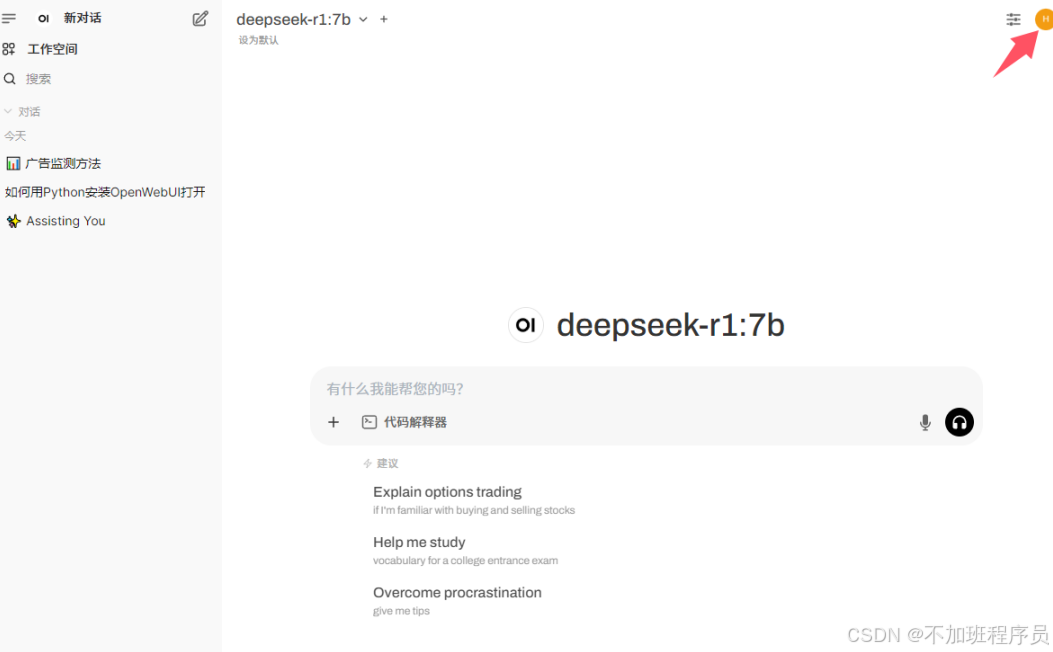

Open-webui安装(可视化)

为了更直观地与DeepSeek模型进行交互,可以使用Open Web UI。以下是安装和使用步骤:

创建pyhton环境

conda create -n open-webui python=3.11

conda activate open-webui

安装Open-WebUI项目

pip install open-webui -i https://pypi.tuna.tsinghua.edu.cn/simple

开启服务

open-webui serve

然后通过浏览器打开 ip:8080进行账号注册,注册完成后可直接登录。

问题

登录时显示成功但是长时间没反应,页面白板,一段时间后能正常访问,目前定位为登录时会先通过openai验证用户有效性,由于网络不通,超时后会通过本地验证用户。目前已处理。

这个其实是因为默认对接了open-ai的Api,但是没有科学上网的话,会一直等待响应,只需要关闭即可。

访问入口:点击头像 -->管理员面板 -->设置 -->外部连接-> openAi API

19万+

19万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?