目录

一、自定义数据集

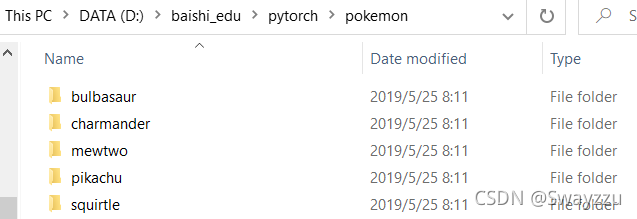

现有数据如下:

5个文件夹,每个文件夹是神奇宝贝的一种。

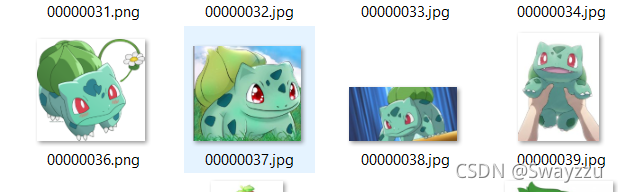

每个图片形状、大小、格式不一。

我们训练CNN的时候需要的是tensor类型的数据,因此需要将所有的图片进行下列转换:

1.对文件夹编号,进行映射,比如妙蛙种子文件夹编号0,皮卡丘编号1等。

2.对文件夹中所有图片,进行编号的对应,这个就是标签。并保存为一个csv文件。

3.图片信息获取:分为train,val,test

4.处理图片,使其成为torch可以处理的类型

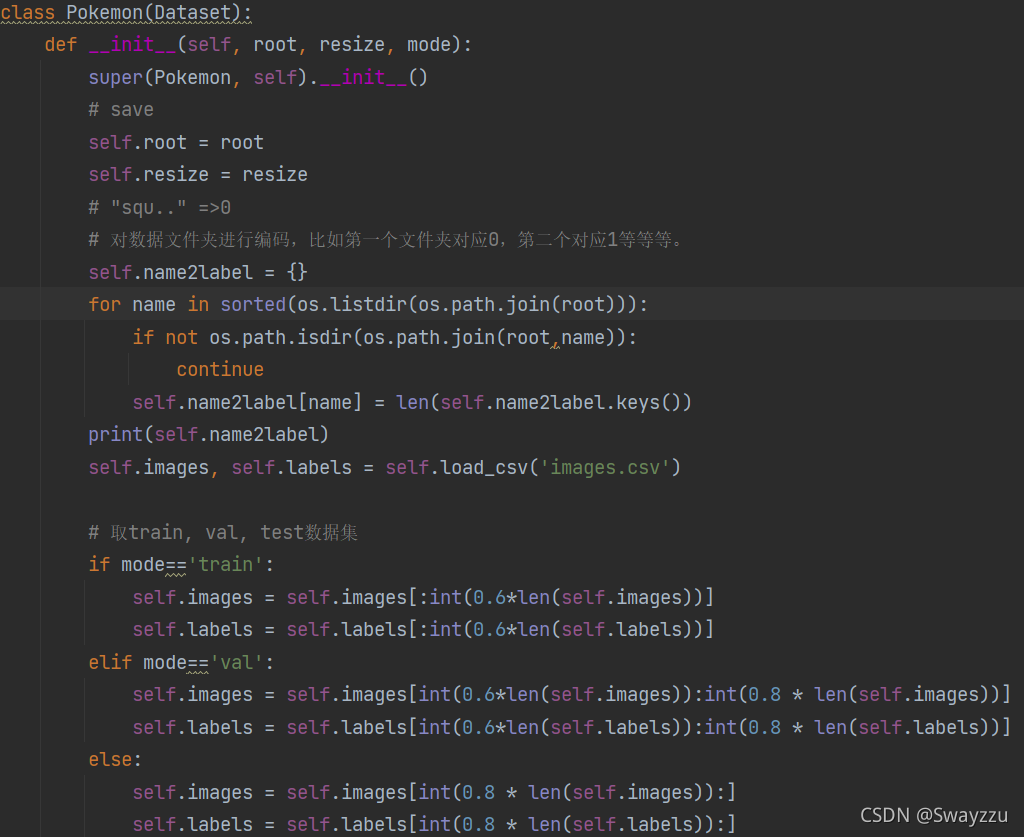

1.文件夹映射

前半部分为文件夹的映射。我们希望传入数据的时候直接传入文件夹的名字,而文件夹所在的路径就是py文件所在的路径,因此这样可以直接读取。对于路径的操作使用os.path.join进行。

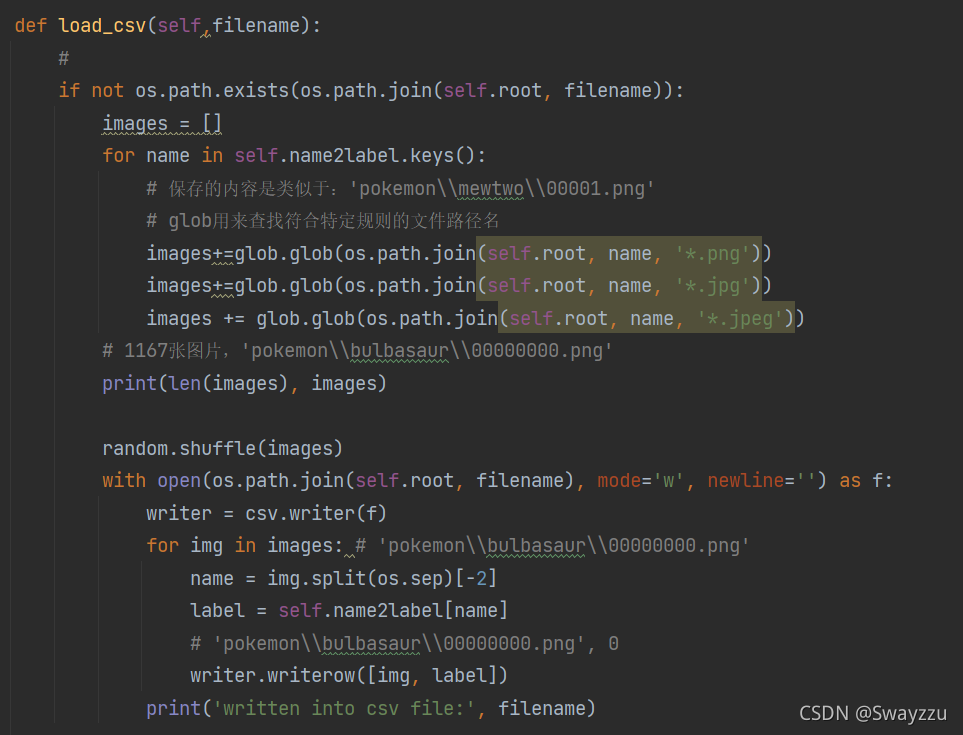

2.图片对应标签

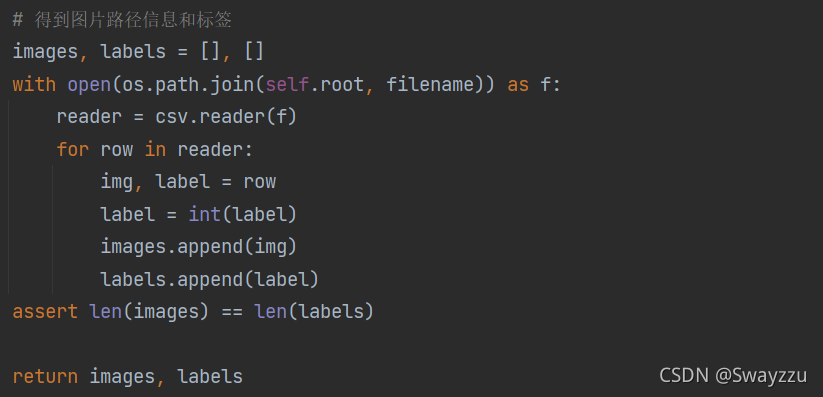

输入的filename,就是我们将图片和标签信息存储的文件。

使用glob.glob方法,可以轻松调取路径下的所有指定类型的文件。

将名字和标签对应好后,通过csv.writer,可以将信息以csv格式写入新文件。

以上是保存的部分,在这个函数中,我们还要重新读取一下这个文件,因为要在这个类中获得最终的图片,以及标签,并且返回。

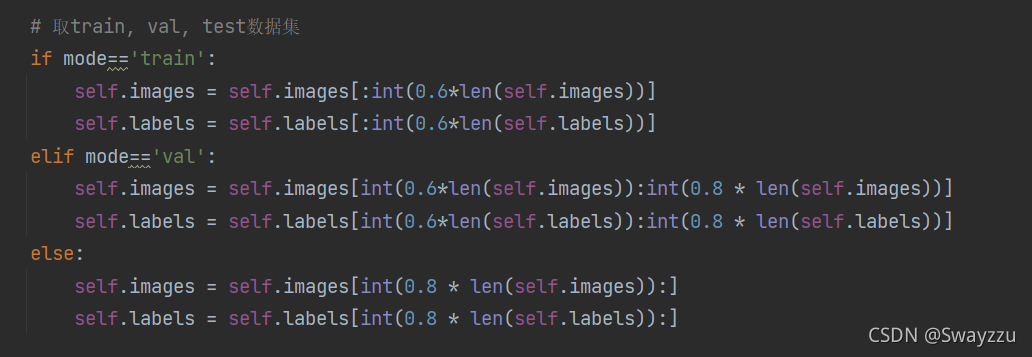

3.训练及测试数据分割

这里是第一步的图片的后半部分,导入了图片之后,对其进行分割,这里是按照训练、交叉验证、测试,分别是0.6,0.2,0.2进行分割的。

分割完毕后的self.images, self.labels,就可以拿来进行tensor相关的处理了。

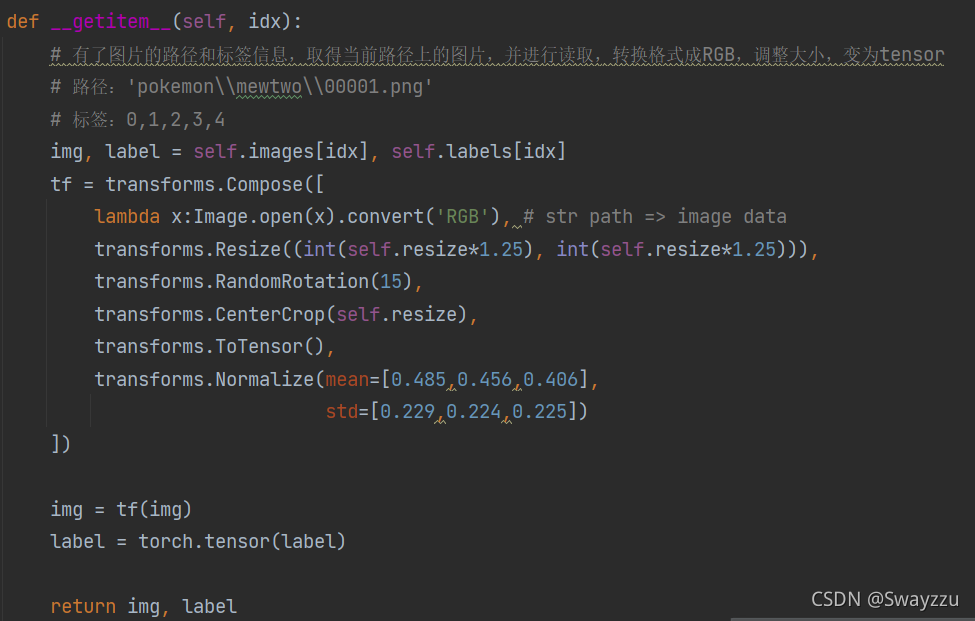

4.数据处理

上面几步是准备工作,接下来定义的__getitem__是为了能够使train_loader = DataLoader()这一语句实现。在这里面直接将数据进行我们希望进行的转换。比如大小、旋转、裁剪等。

最后返回处理好的图片,以及tensor化的标签。

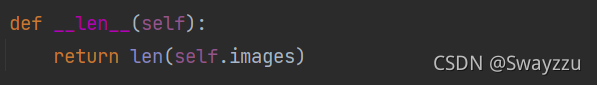

另外,还需要定义一个__len__,使得我们可以获得数据集长度。

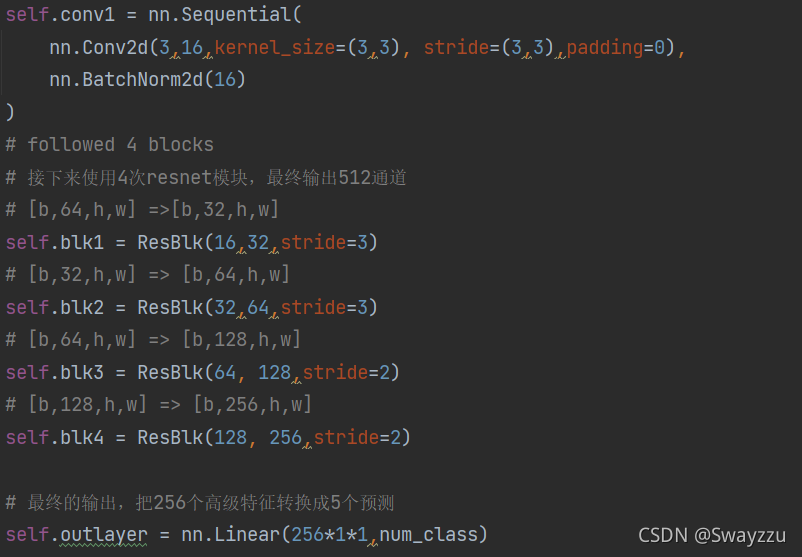

二、ResNet处理

我们要用ResNet对图片进行处理,因此其中的参数需要进行一定的修改。

主要的修改部分是ResNet18之中的resblock模块。因为我们希望输入的是3通道,224*224的图片,因此在这里对通道,步长进行一定的修改,并进行测试,成功之后便可以进行训练了。

三、训练及可视化

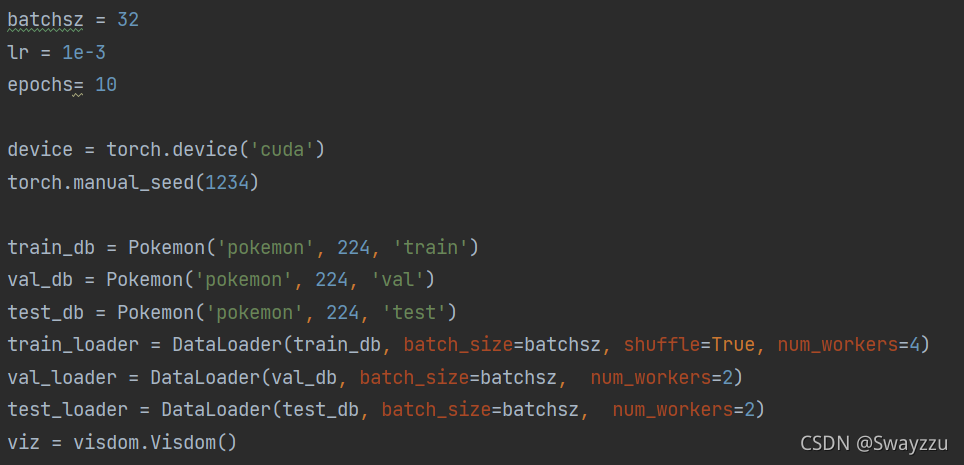

1.数据集导入

同时把GPU设备相关代码准备好,并且由于需要可视化,因此先实例化visdom,并且在终端上输入python -m visdom.server,打开visdom监视终端。

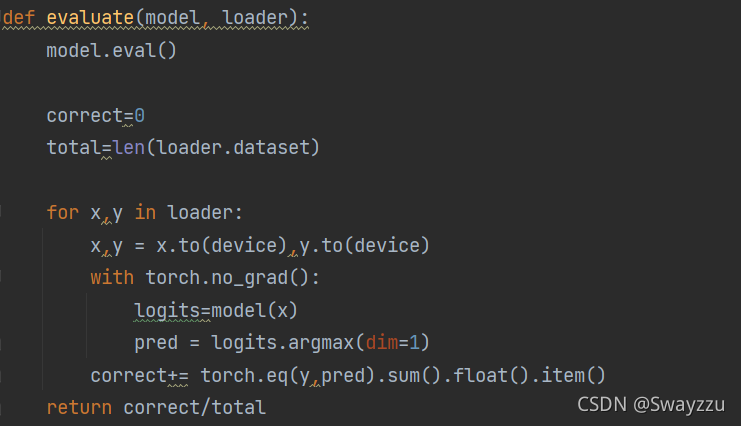

2.测试函数

先把模式改为eval(),接下来就是通过model,去训练测试集,得到标签,并统计正确率。

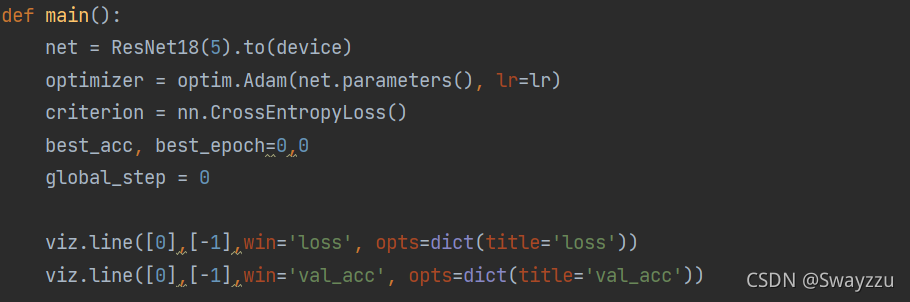

3.训练过程及可视化

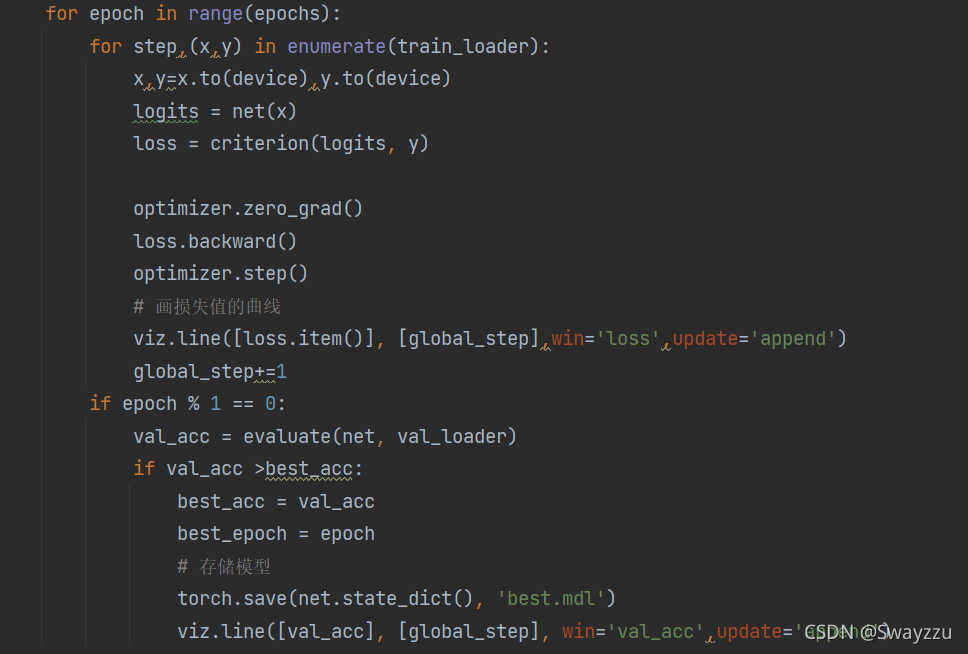

和之前的一样,还是先实例化一个优化器,选择损失函数模式,实例化ResNet18,然后进行训练。

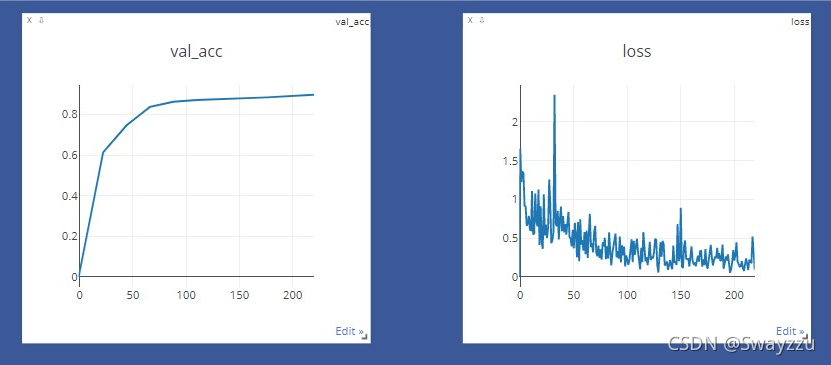

在这里由于要展示,因此先对损失值,交叉验证分数分别设置一个初始的线,通过append的方法,画出我们的损失曲线,以及交叉验证分数曲线。

通过torch.save方法存储我们的最优解。

通过torch.save方法存储我们的最优解。

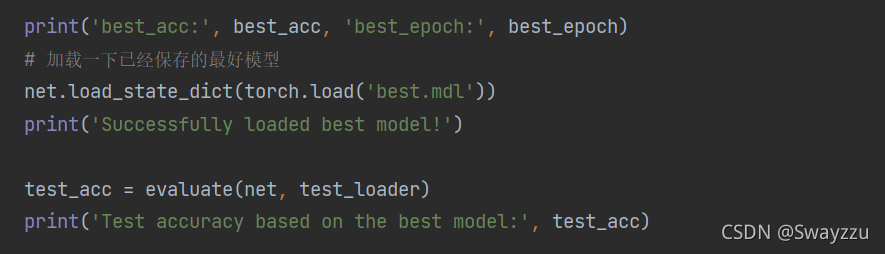

最后通过把存储好的最优解调用起来,使用测试集,来测试最终的效果。

最终获得的交叉验证准确率89%,测试集准确率88%,损失值及交叉验证结果的图像如下:

该博客介绍了如何构建和训练一个使用ResNet的卷积神经网络,针对自定义的神奇宝贝数据集进行图像分类。首先,详细阐述了数据集的准备,包括文件夹映射、图片标签对应、数据分割和处理。接着,针对ResNet模型进行了调整以适应输入的图像尺寸。在训练与可视化阶段,通过DataLoader加载数据,利用visdom进行训练过程的可视化,并实现了模型的训练、测试及性能评估。最终,模型在交叉验证集上的准确率达到89%,测试集上达到88%。

该博客介绍了如何构建和训练一个使用ResNet的卷积神经网络,针对自定义的神奇宝贝数据集进行图像分类。首先,详细阐述了数据集的准备,包括文件夹映射、图片标签对应、数据分割和处理。接着,针对ResNet模型进行了调整以适应输入的图像尺寸。在训练与可视化阶段,通过DataLoader加载数据,利用visdom进行训练过程的可视化,并实现了模型的训练、测试及性能评估。最终,模型在交叉验证集上的准确率达到89%,测试集上达到88%。

8635

8635

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?