点击上方“深度学习大讲堂”可订阅哦!

编者按:在工业界大量资源的投入下,大数据、大规模GPU集群带来了深度学习在计算机视觉领域的全面产业落地,在很多竞赛中甚至取得远超学术界的成绩。在AI领域的各个顶级会议上,越来越多的优秀工作也来自于Google、Facebook、BAT等巨头或者一些新锐创业公司。

值得注意的是,工业界目前的主要进展和应用落地,很大程度上依赖于高成本的有监督深度学习。而在很多实际场景中,存在数据获取成本过高、甚至无法获取的问题。因此,在数据不足的情况下,如何使用弱监督、乃至无监督的方式进行学习,这既是学术界中大家广泛关注的问题,其实也是工业界面临的新挑战。

商汤科技研发总监、中山大学教授林倞,将从产业落地以及学术创新两种视角出发,带领大家一起探索“后深度学习时代”的新挑战。文末,大讲堂特别提供文中提到所有文章的下载链接。

关于本次报告中提到的所有算法及部分源码,详见中山大学人机物智能融合实验室网站: http://www.sysu-hcp.net

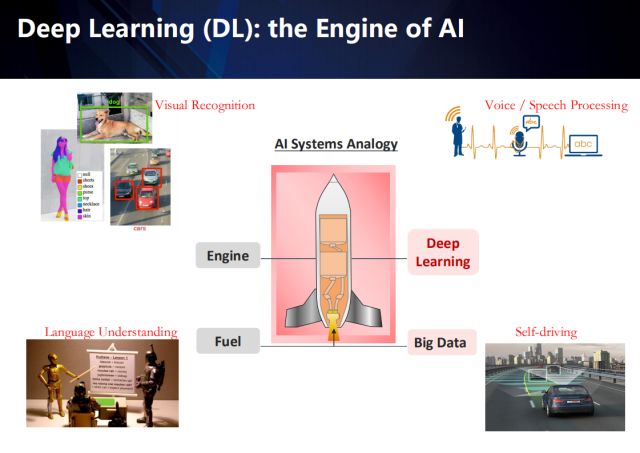

如果把AI系统比作为一架火箭,那么大数据就是它的燃料,深度学习则是它的引擎。随着大数据以及GPU算力的加持,深度学习在很多领域都取得了突破性的进展,例如视觉图像理解、属性识别、物体检测、自然语言处理、乃至自动驾驶。当然了,垂直化应用场景才是AI技术落地不可或缺的因素,这其实也是在工业界做研究的最大优势——从真实的需求引导技术的发展,而学术界的科研往往基于一些不太实际的假设。

基于视觉的图像理解,是从有标注的数据学习出AI算法,以实现相应的视觉识别任务,左上角展示了视觉图像理解中的物体检测以及属性识别应用。

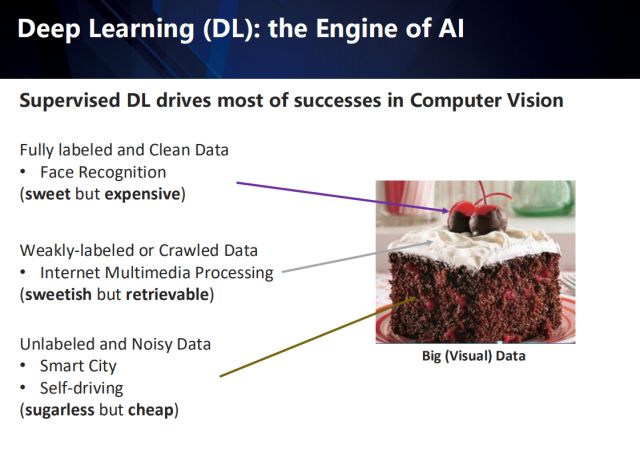

而值得注意的是,深度学习在计算机视觉领域的成功应用,很大程度上依赖于有监督的数据,这意味着大量的完全标注的干净数据(例如人脸识别领域的数据)。然而,这样的数据意味着非常高昂的成本。在真实的场景中,经常存在的是弱监督或者从互联网上获取的数据(例如网络社交媒体的数据),以及无标注或者标注有噪声的数据(例如智慧城市以及自动驾驶等应用中采集到的数据)。

LeCun教授曾用右图的蛋糕,来形容有监督学习、无监督学习、以及强化学习之间的区别,这里借用来说明这三种数据的区别:完全标注的干净数据就像蛋糕上的金箔樱桃,甜美却昂贵;而弱标注或互联网爬取的数据,就像蛋糕上的奶油,还算甜但也可获取;而无标注的或者标注有噪声的数据,不太甜但成本较低。

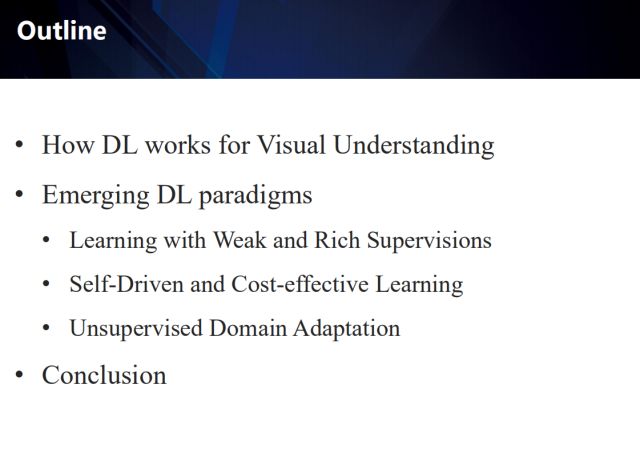

在本次报告中,我将首先介绍深度学习如何应用于视觉理解,接下来会从三个方面介绍最新的深度学习范式:

以丰富多源的弱监督信息来辅助学习

算法自驱动、具有高性价比(性能/监督信息成本)的自主学习

无监督领域自适应学习

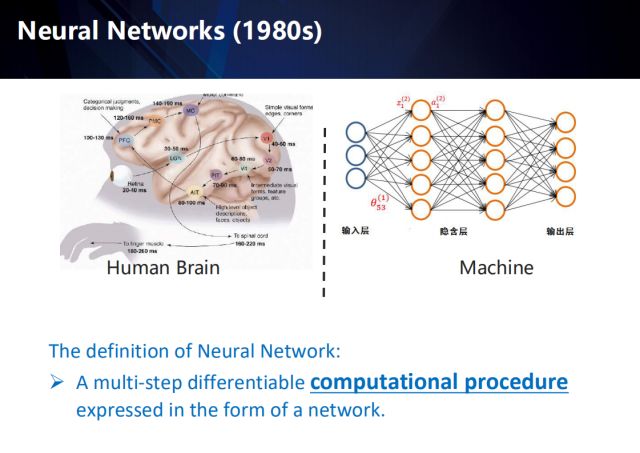

首先介绍一下深度学习的基本概念,深度学习被定义为最终以网络形式呈现的、涵盖了多个步骤的、可微分的计算过程。而说起深度学习,就要从上世纪80年代的神经网络开始讲起。神经网络其命名的初衷,是向人脑中的神经网络致敬。那么人脑中是如何处理视觉信号呢?

首先,视网膜输入视觉信号,经过LGN外膝体,到达视觉皮层V1—V5,其中V1对边缘和角点敏感,V2捕捉运动信息, V4对part物件敏感,例如人的眼睛、胳膊等,最后到达AIT,来处理高层信息:脸、物体等。送到PFC决策层,最后由MC发出指令。所以人脑处理视觉信号是一个从浅层到深层的过程,而在此过程中,并不是一个单一的处理,它还具备时序性,也就是说它在处理每个信号时,都是利用了之前的时序信息的。

深度神经网络的形式和计算过程与人脑有很大的不同,不过它的发明的确是受到了神经信号处理的启发,例如经典的感知机模型其实是对神经元最基本概念的模拟。右上展示了1980年发明的多层感知机。

从1980年代的多层感知机到2010年的卷积神经网络,它经历了一个层数由少至多、层级由浅至深的过程,通过解决网络梯度消失以及泛化不好的问题,以及数据及GPU的加持,它终于实现了一个一站式的端到端的网络。

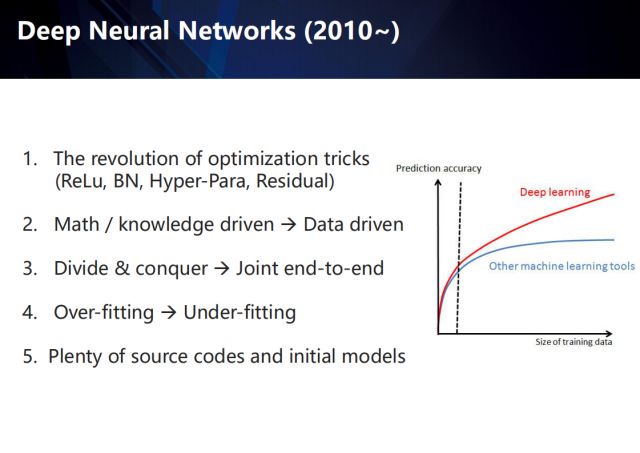

自2010年起,深度学习方法取得了远超传统机器学习方法的成绩,尤其随着训练数据集的不断扩展,传统方法迅速触碰到精度天花板,相比之下,深度方法的预测精度则不断提升。这里总结了这一波深度学习技术革新的几个关键点,包括新的网络优化方法,如ReLu,Batch Normally,Skip Connection等;从数学/知识驱动到数据驱动的研究思路的转变;分治优化逐渐过渡到联合端到端联合优化;从避免过拟合学习到避免欠拟合学习;大量的开源代码和初始化模型的涌现。

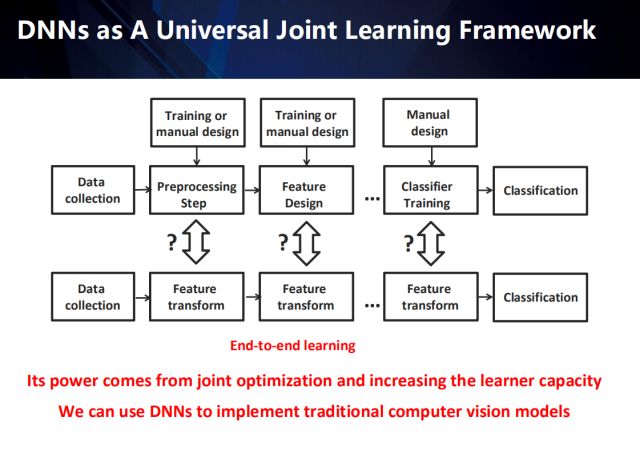

传统的模式识别任务,大致可总结为几个独立的步骤:包括数据采集、数据预处理、特征提取、分类器训练以及最终的分类。其中,数据预处理器和特征提取器的设计都是以经验为驱动的。而深度学习通过将预处理、特征提取以及分类训练任务融合,因此衍生出了一个,具有更强表示能力的端到端的特征转换网络。

在传统模式识别方法到深度方法的演变过程中,我们越来越体会到学习的重要性,而特征学习也已进化成一个端到端的学习系统,传统方法中的预处理已不是必须手段,而被融入端到端的系统中。似乎特征学习影响着一切模式识别任务的性能,然而,我们却忽视了数据收集和评估的重要性。

接下来我们举例说明传统方法是如何演化为深度方法的。

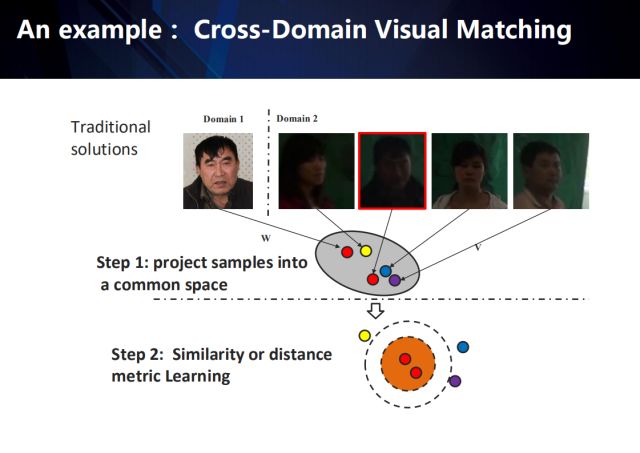

以跨领域视觉匹配任务(从领域2的数据中匹配到给定的领域1中的目标)为例,传统的方法一般会包含以下两个步骤:

首先,将来自于不同领域的样本投影到一个公共的特征空间 (特征学习);

然后,采用相似性或距离度量学习的方式,学习到一种距离度量,来表征这个公共空间上特征之间的相似性 (相似性度量学习)。

那么如何将这种相似性的度量整合到深度神经网络中,并进行端到端的学习呢?

如何把相似性度量融合到特征提取中去?

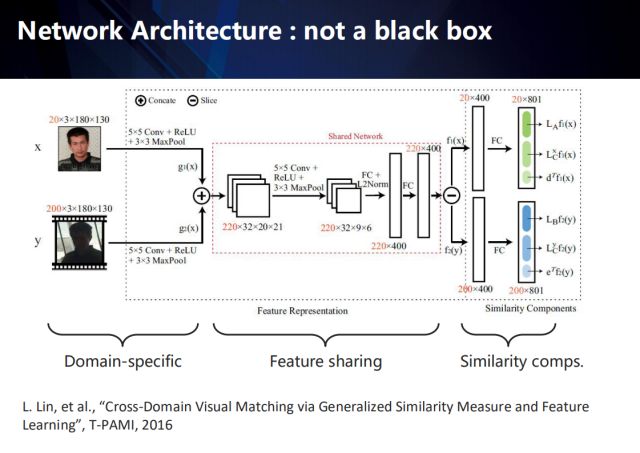

以右上公式表示的相似性度量方法为例 (度量模型的提出和推导请参加相关论文),我们可以将该度量模型分解后融入到神经网络中——将原来的全连接网络表示成成若干个与度量模型相匹配的结构化网络。再通过误差反向传导,可以将度量模型与卷积特征进行联合学习、统一优化。详细过程如下:

右上公式中, A矩阵为x样本所在领域中样本间的自相关矩阵,半正定; B矩阵表示y样本所在领域中样本间的自相关矩阵,半正定;C矩阵则是两个领域样本间的相关矩阵。

展开后我们可以发现,其组成成分除了网络从不同域提取到的特征外,还包含6个不同的表达距离度量模型的变量(每个域包含2个矩阵和1个向量)。图中左上部分显示了我们将分解后的距离度量变量融入到神经网络中的过程——结构化的网络模型。

由此看来,深度网络并不是完全的黑盒子,通过引入领域知识和结构化模型,是可以具备一定的宏观解释性的。

以跨域视觉匹配算法为例,其内部可归纳为三个部分:域独有层、特征共享层、以及相似度量。

整个端到端的网络如图所示,其每个部分都具有可解释性。

在域独有层,该网络为不同域的数据提取该域的独有特征;

在特征共享层,我们首先将不同域的特征融合,再将融合后的特征投影到共有空间下,再反向拆解出各自域在该共有空间下的特征;

本文探讨了在深度学习取得显著成就后,所面临的挑战和未来可能的发展方向,包括模型解释性、泛化能力、计算效率及数据需求等关键问题。

本文探讨了在深度学习取得显著成就后,所面临的挑战和未来可能的发展方向,包括模型解释性、泛化能力、计算效率及数据需求等关键问题。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

928

928

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?