点击上方“深度学习大讲堂”可订阅哦!

编者按:摄像,摄万物之象。经典摄像方法在成像的各个维度——空间分辨率、时间分辨率、视角及深度、颜色(光谱)等均已达到瓶颈,而计算摄像能够突破经典成像模型和相机硬件的局限,更加全面、精确地捕捉真实世界的视觉信息。计算摄像学是一门综合信号处理、光学、视觉、图形学等多学科知识的交叉研究领域。在本文中,国内第一部真人CG电影《爵迹》的幕后英雄,南京大学的曹汛教授,将从计算摄像学的常用原理和思想出发,重点介绍光谱视频计算摄像、光场成像等计算摄像学领域的经典研究。大讲堂特别在文末提供文章以及代码的下载链接。

今天的报告主要从计算摄像的基础原理和思想出发,重点介绍我十几年来主要做的光谱视频相机,并介绍一些著名的计算摄像研究方向和系统。

计算摄像学是一个新兴的交叉学科,其英文名是Computational Photography ,在 视觉(CVPR/ICCV)以及图形学 (SIGGRAPH) 等会议中都有相关的 track。但是在近十几年中,会议中计算摄像track的论文比例较低,例如在 CVPR 中,每年几百篇接受的论文中只有二十几篇这个方向的论文。这其中的原因主要在于它涉及到硬件系统,研究周期比较长。其背景包括光学、电路以及算法,将新的计算理论引入到成像过程。与传统的图像、视频处理技术在获得数据后再进行处理相比,计算摄像研究希望能够通过更早地介入成像的过程,增强图像和视频的采集效率和性能。

目前,国际上诸如M.I.T.、Stanford、CMU等学校都开设了计算摄像相关的课程。在国际上有一些实验室专注于研究这个方向,如 Stanford 的SCI实验室、M.I.T. 的 Media Lab、以及杜克大学、以色列理工等等。国内清华大学、南京大学、北理工、中科大、北航、西电等高校以及中科院等科研院所也均开展了相关的课程教学和研究工作。

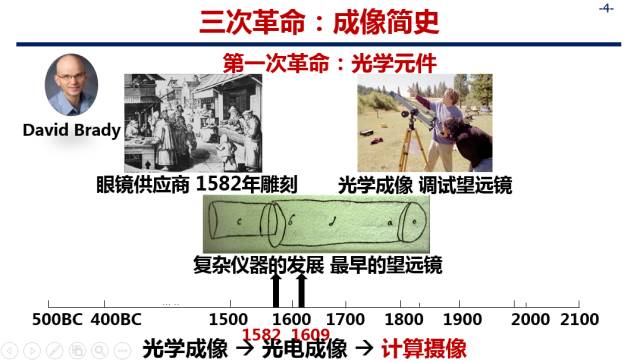

成像简史的三次革命

第一次革命:光学元件

我非常崇敬的计算摄像学领域的大师 David Brady教授,在国际上讲computational photography时常用这样一页Slide,我将它翻译过来放在这里。在这里,早期的光学成像装置起源于意大利佛罗伦萨,他们设计了类似于现在眼镜的装置(Spectacles),以此来进行光学成像,而世界上最早的望远镜镜头设计图纸如上图所示。(致谢David Brady教授)

我个人认为,世界上最早的成像其实在公元前400年,我们中国的墨子就发现了做一个小孔的装置就可以成像(小孔成像原理)。在我的建议下,David Brady教授在国际上做报告时也将墨子这一部分加入他的成像历史简介中。可以说,第一次成像革命中,人们意识到设计各式各样的光学装置可以进行成像,而那个年代,成像得到的图像和视频并不能保存下来,更谈不上图像处理、以及现在如火如荼的视觉研究了。

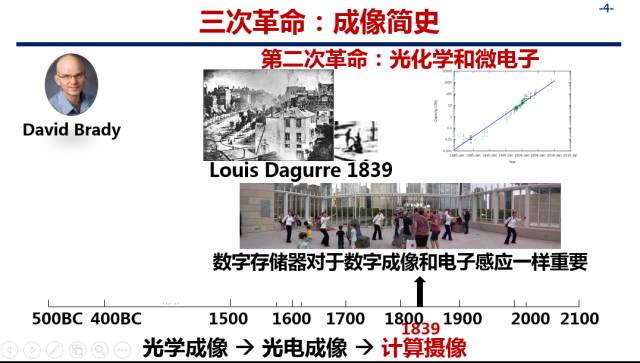

第二次革命:光化学和微电子

第二次革命使得成像有了记忆(memory),人们主要发明了两种方式可以将图像记录下来:其一是光化学的方法(如传统的胶片),其二是随着微电子的发展,集成电路可以做数字成像器件(如CCD、CMOS, CCD得到了2009年的诺贝尔奖)。将图像记录下来,为图像处理和分析提供了可能。

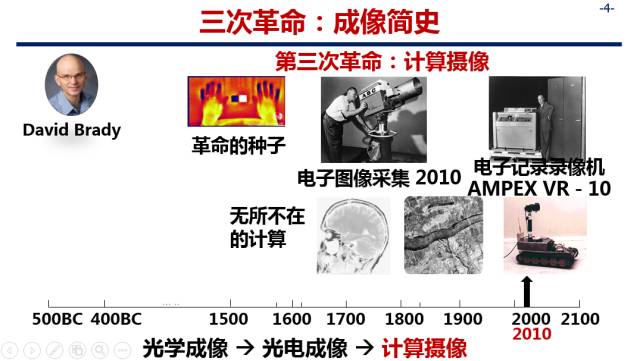

第三次革命:计算摄像

而现在的计算摄像让我们可以更早地介入成像的过程,对于处理图像时无法实现的指标,可以在成像的过程中就加入一些“计算”和“智能”的因素。

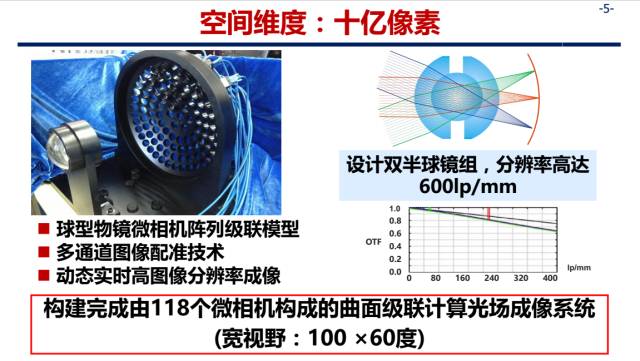

下面举几个例子,比如在空间维度上,现在手机相机的像素一般在1200万左右,而人类眼睛的最高像素集中区域大概在亿像素量级,那么,如果达到十亿像素是什么样的呢?

David Brady教授于2012年在 Nature上发表了一篇关于十亿像素相机的文章[1],之后一直在做这个技术的产业化,他现在就想把美国的橄榄球比赛做成一个十亿像素的直播,这涉及到了很多数据处理和数据传输问题。如果有十亿像素的话,观众就可以在直播中一直追踪喜欢的球星。并且由于分辨率特别高,在直播中切换视角时会有一种身临其境、漫游的感觉。

在时间维度上,高速摄像是人们一直追求的目标。比如在1964年,MIT 就做了一个子弹穿过苹果的 photography;在2000年,电影《黑客帝国》中有每秒一万帧的拍摄镜头。那么如果拍摄速度达到光速,也就是每秒万亿帧,会是什么样的情形呢?我的同事,Di Wu博士做了一个工作(CVPR, 2012 Oral),就捕捉到了一束光穿过可乐瓶的过程,直到此时,光速级别的成像也变成了可能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1045

1045

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?