1 简介

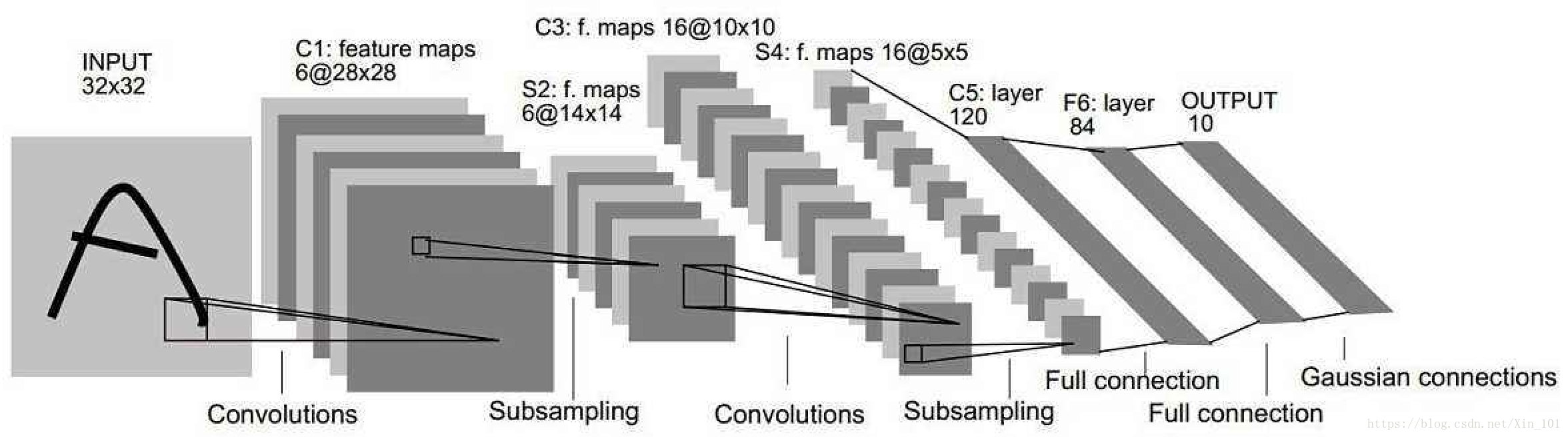

LeNet-5模型是1998年Yann LeCun教授在论文Gradient-based learning applied to document recognition中提出的,是第一个成功应用于数字识别问题的卷积神经网络,在MNIST数据集上,LeNet模型识别的正确率高达99.2%。LeNet-5结构如图1.1所示。

由图1.1可知,LeNet-5模型有输入层(InputLayer)、卷积层(Convolution Layer)、采样层(Subsampling Layer)、卷积层(Convolution Layer)、采样层(Subsampling Layer)、全连接层(Full connection Layer)、全连接层(Full connection Layer)、高斯连接层(Gaussian connections Layer)。

- 深度:矩阵个数;

- 参数数量:权重和偏置数量总和,根据卷积核计算。

2 结构

- 输入层

输入层的输入是原始图像的像素(32X32),黑白图片,深度为1。 - 卷积层

卷积层过滤器/卷积核尺寸为5X5,深度为6,不使用全0填充,步长为1。该层输出为28X28X6,尺寸为28X28(32-5+1),深度为6,参数数量为156(5X5X1X6+6,其中5X5为卷积核尺寸,1为黑白图像深度,6为卷积核深度,6为偏置项参数),连接数量为122304(28X28X6X(5X5+1))。

卷积层参数表2.1。

| 参数 | 描述 |

|---|---|

| 尺寸 | 28X28 |

| 深度 | 6 |

| 参数数量 | 156 |

| 连接数量 | 122304 |

- 采样层

该层的输入是卷积层的输出,即28X28X6的节点矩阵,深度为6,尺寸为28X28。本层过滤器/卷积核尺寸为2X2,长和宽的步长为2,则输出矩阵为14X14X6。

| 参数 | 描述 |

|---|---|

| 尺寸 | 14X14 |

| 深度 | 6 |

- 卷积层

该层输入为采样层的输出,即14X14X6的节点矩阵,深度为6,尺寸为14X14。本层过滤器/卷积核尺寸为5X5,深度为16,不使用全0补充,步长为1,则该层输出为10X10X16,尺寸为10X10,深度为16,参数为2416(5X5X6X16+16,其中5X5为卷积核尺寸,6为输入层深度,16为卷积核深度,16为偏置项参数),连接数量为41600(10X10X16X(5X5+1))

| 参数 | 描述 |

|---|---|

| 尺寸 | 10X10 |

| 深度 | 16 |

| 参数数量 | 2416 |

| 连接数量 | 41600 |

- 采样层

该层输入为卷积层输出,即10X10X16的节点矩阵,尺寸为10X10,深度为16,采用卷积核/过滤器尺寸为2X2,长宽步长为2,该层的输出为5X5X16。

| 参数 | 描述 |

|---|---|

| 尺寸 | 5X5 |

| 深度 | 16 |

-

全连接层

该层的输入为采样层的输出,即5X5X16节点矩阵。将该矩阵拉成一个向量,输出节点为120,参数有48120(5X5X16X120+120)。 -

全连接层

该层输入为120个节点,输出为84个节点。参数为10164(120X84+84)。 -

高斯连接层

该层输入为84个节点,输出为10个节点,参数为850(84X10+10)。

3应用

MNIST数据集处理应用:github。

4 总结

- LeNet-5模型可高效处理手写字体

- 对数据量较大的图像数据集,LeNet-5效果一般,如ImageNet图像数据集

525

525

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?