大数据产业创新服务媒体

——聚焦数据 · 改变商业

还记得当年英特尔的广告语吗?“Intel Inside”,这个标志性的标签几乎成了计算设备的象征。然而,随着AI大模型的迅速崛起,计算的核心从CPU悄然转向了GPU。一场前所未有的技术革命正在酝酿,而这场革命的主角正是GPU。这并非简单的硬件升级,而是对整个云计算生态的重新定义。

这一变革并非是循序渐进的升级,而是一场颠覆式的革命。GPU不仅仅是性能更强,它的出现实际上重新定义了云计算的底层逻辑。传统的云计算巨头——无论是AWS、微软云、谷歌云,还是阿里云、腾讯云、百度智能云——都必须面对一个残酷的现实:过去依赖的技术优势正在被快速蚕食。更为重要的是,行业的新兴玩家正抓住这一机遇,迅速崛起,试图挑战这些巨头的霸主地位。

但问题来了:传统巨头们能否及时转身,拥抱这场GPU主导的变革?他们能否在这场新竞赛中继续保持领先,抑或最终会被更加灵活、创新的新势力所超越?

这不仅仅是一场技术的比拼,更是一场关于未来计算主导权的战争。云计算的江湖,风云再起。

从云计算、云操作系统的本质,来看市场的演进逻辑

云计算,乍听之下,这是一个充满科技感的词汇,仿佛触手可及的未来。然而,云计算的本质并不复杂——它的核心就在于“资源池”和“弹性调度”。

想象一下,一个巨大的水库(资源池),里面储存着丰富的水资源(计算资源:CPU、存储、网络)。每当你打开水龙头(发出计算需求),水库就会根据需求调配水量,不多也不少,精确地满足你的需要。这个过程就是云计算的弹性调度——根据需求动态分配资源,既不浪费,也不短缺。

但水库本身不会自动运行,背后需要一个大脑来指挥这些资源的分配与调度,这就是云操作系统的角色。它不仅管理资源的分配,还确保资源之间的高效协同运作,让每一滴水(每一份计算资源)都能发挥最大的效用。

这就是云计算的核心——弹性调度和资源池的管理。正是这个看不见的“大脑”在幕后运筹帷幄,才能让你在任何时间、任何地点都能获得所需的计算资源。而这个“大脑”,正是云操作系统。

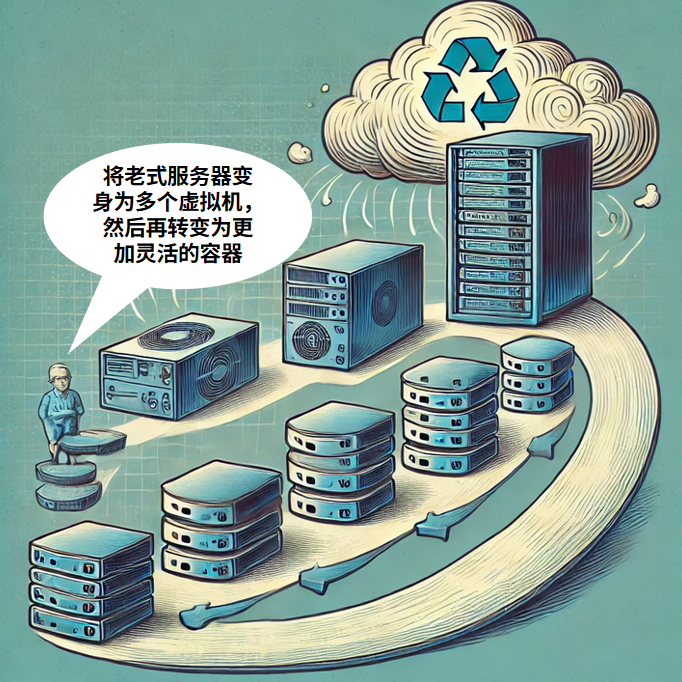

要理解云操作系统的演进,得先追溯到它的起点:虚拟化时代的开端。

早期阶段:虚拟化时代的开端

早期的云计算操作系统几乎与虚拟化技术紧密相连,虚拟机(Virtual Machine)技术是云计算的奠基石。通过虚拟机,物理服务器被抽象成多个虚拟实例,每个实例都可以运行自己的操作系统和应用程序。这种资源的抽象化让云计算的弹性调度成为可能——不同的用户可以共享同一台服务器而互不干扰。

虚拟化的核心是Hypervisor,一个运行在硬件之上的轻量级软件层。它负责管理虚拟机的创建、销毁和资源分配。Hypervisor既要保证各虚拟机之间的隔离性,又要高效调度硬件资源,尽量减少开销。

然而,虚拟化技术并非完美无瑕。尽管它提升了资源利用率,但引入的性能开销和管理复杂性也不容忽视,这些问题为后来的技术发展埋下了伏笔。

中期发展:容器化技术的兴起

进入容器化时代,云操作系统迎来了新的变革。容器技术,比如Docker,提供了一种比虚拟机更轻量的虚拟化方式。容器能够在共享的操作系统内核上运行多个隔离的应用实例,启动速度更快,资源占用更少。

容器的核心技术包括cgroups和namespaces,它们负责资源限制和进程隔离。这些技术使得云操作系统能够更加高效地管理资源,并显著降低了应用程序的部署复杂性。

与此同时,Kubernetes等容器编排工具的出现,更是让云操作系统能够自动化地管理和调度成千上万个容器实例,实现微服务架构的快速部署和扩展。

容器技术的兴起,使得云操作系统从以虚拟机为核心的架构,转变为一个更加灵活和高效的生态系统,极大地提高了资源利用率。

现代阶段:智能化调度与AI赋能

随着AI和大数据的迅速发展,云计算的需求变得更加复杂,智能调度成为了云操作系统的新焦点。通过引入AI技术,云操作系统能够预测工作负载变化,并自动调整资源分配,确保计算资源的最大化利用。

如今,云操作系统正朝着更智能、更自动化的方向发展。不仅要管理传统的计算资源,还要面对包括GPU、FPGA等异构计算资源在内的复杂环境,这对操作系统提出了更高的要求。

云计算操作系统的发展,是一场从资源管理到智能化运营的进化。起初,它专注于如何高效、灵活地利用资源,通过虚拟机和容器技术实现。随着时间推移,操作系统不断在性能与效率间寻找平衡,每一次迭代都是为了解决灵活性、资源利用率和操作复杂性的平衡问题。这一系列技术进步揭示了云计算操作系统演进的内在逻辑,展现了技术发展的趋势和未来方向。

GPU崛起,重塑云计算操作系统的全新逻辑

曾经,CPU在计算领域占据着核心地位,但随着AI技术的发展,GPU以其强大的并行计算能力逐渐成为云计算的新宠。GPU拥有众多计算核心,能够同时处理大量任务,这使得它在执行深度学习和AI模型训练中的大规模矩阵运算时,效率远超CPU。

GPU的高吞吐量和浮点计算能力,使其在处理大数据和复杂模型方面表现卓越,训练大规模神经网络的效率是CPU的数十倍。因此,GPU正逐渐成为AI时代云计算的核心力量。

随着GPU的崛起,云计算操作系统面临着全新的挑战。

GPU的并行计算能力要求云操作系统具备高效的调度机制,以最大化地发挥GPU的性能。这意味着,操作系统不仅需要调度单个计算任务,还要协调数千个并行计算线程,以确保资源的最佳利用。

而且,GPU在处理深度学习尤其是大模型任务时,通常需要快速访问大量数据,这对存储和网络系统提出了更高的要求。传统的云操作系统设计主要围绕CPU展开,数据处理的模式较为线性,而GPU的工作方式更像是一个海量数据的“搅拌机”,需要在极短的时间内处理和交换大量数据。这种数据处理方式要求操作系统具备更高效的内存管理机制,以及支持高带宽、低延迟的数据传输能力。

另外,GPU的多节点协同计算也是一个新的挑战。大型AI模型的训练往往需要跨越多个GPU节点进行分布式计算,这要求云操作系统能够在多个节点之间高效协调资源,确保计算任务的同步执行和数据的一致性。

为了应对这些挑战,云操作系统正在经历深度的变革。

首当其中的,就是是调度算法的优化。传统的调度算法主要是为CPU设计的,强调的是单核性能和任务的串行处理。而针对GPU的调度算法则需要处理数以千计的并行线程,并在任务之间动态分配GPU资源,以最大化GPU的利用率。

而且,异构计算环境的构建成为新的重点。现代云操作系统需要管理的不仅仅是CPU和GPU,还包括FPGA、TPU等其他专用加速器。操作系统需要能够识别并调度这些不同的计算资源,并根据任务的特性动态选择最适合的硬件加速器。

随着GPU的广泛应用,云计算中的计算集群调度也发生了革命性的变化。以往,集群调度主要集中在CPU的负载平衡和资源分配上,而在GPU主导的时代,调度器需要处理的是复杂的并行计算任务,以及跨节点的资源协调。

特别是在大模型任务中,计算负载往往是动态变化的,这要求调度器具备实时响应和调整的能力。例如,在训练大型神经网络时,不同阶段对计算资源的需求可能会有显著差异,调度器需要能够快速调整资源分配,避免资源浪费或任务延迟。

此外,分布式计算任务的协调管理也变得更加复杂。为了充分利用多个GPU节点的计算能力,调度器需要能够同步多个节点的计算进程,确保数据在节点之间的高效传输,并防止计算任务的分散执行导致性能瓶颈。这一切都对云操作系统提出了前所未有的要求,促使其在调度算法、资源管理和系统架构上进行全面升级。

我们可以看到,这不仅仅是硬件的升级,更是云计算架构的深层次变革。GPU的强大性能在推动云计算走向新的高度,但同时也对操作系统提出了更高、更复杂的要求。只有那些能够快速适应这一变化的云服务商,才能在这场新一轮的技术竞赛中立于不败之地。

智算云的骨架重塑,存储、网络和数据中心的协同进化

在智算云的时代,GPU无疑是明星,但在这场革命中,存储、网络以及数据中心的基础设施同样不可或缺。光有强大的算力而没有与之匹配的存储和网络支撑,这样的系统无异于一个跑车却装上了低速车轮,无法充分发挥其潜能。

存储系统的升级之路

首先,让我们聊聊存储。在AI大模型的训练中,数据就是“燃料”,而存储系统就是这个燃料的“油箱”。传统的存储系统根本无法满足AI大模型对数据读写的苛刻需求。

AI大模型在训练时,会不断地读取和写入大量数据,要求存储系统不仅有极高的吞吐量,还要有极低的延迟。为此,分布式存储技术成为了关键。分布式存储系统通过将数据分散存储在多个节点上,不仅提高了数据访问速度,还增强了系统的容错能力。如果一个节点故障,其他节点可以无缝接管,确保数据的持续可用性。

此外,NVMe over Fabrics (NVMeoF) 技术也是应对这一挑战的重要工具。NVMeoF通过将NVMe协议延展到网络中,打破了传统存储的瓶颈,实现了存储和计算之间的高效通信。这种技术不仅提高了存储设备的利用率,还显著降低了延迟,满足了AI大模型对数据高频读写的需求。

但这还不够。在面对海量的数据时,存储系统还需要具备智能化的数据管理能力,能够根据数据的重要性和访问频率动态调整存储策略。比如,把访问频率高的数据优先存储在速度更快的设备上,而冷数据则转移到低成本的存储介质中。这种智能分层存储技术,能够有效地提高存储资源的利用效率,降低总体成本。

网络架构的转型挑战

如果说存储是数据的油箱,那么网络就是整个系统的“血管”。在智算云环境下,GPU集群的高密度并发计算对网络的要求达到了新的高度。传统的网络架构已经难以支撑这些计算任务的高速数据交换。

这里,RDMA (Remote Direct Memory Access) 技术应运而生。RDMA允许直接在网络上访问远程内存,而无需经过操作系统的干预,这种技术大幅降低了数据传输的延迟,提升了数据吞吐量。RDMA的引入,解决了GPU节点之间的数据传输瓶颈,特别是在需要频繁交换大量数据的深度学习任务中,RDMA能够确保数据传输的高效和低延迟。

与此同时,高速互联 和 无损网络架构 也成为了网络架构转型的焦点。高速互联技术,如InfiniBand,提供了比传统以太网更高的带宽和更低的延迟,适合需要大规模并发的计算任务。而无损网络则通过精细的流量控制和拥塞管理,确保了数据传输的稳定性和可靠性,避免了因为网络拥塞而导致的计算任务中断。

这些网络技术的集成,使得GPU集群能够以接近实时的方式进行数据交换和计算协同,大大提高了AI任务的执行效率。

数据中心的全面升级

GPU集群的崛起,不仅对存储和网络提出了挑战,还迫使数据中心进行全面升级。

为了支撑GPU的高性能计算,数据中心需要搭载更多的GPU卡,这直接带来了散热和功耗的问题。传统的风冷系统已经难以胜任。液冷散热技术逐渐成为主流,液冷系统通过液体直接接触GPU芯片,将热量迅速带走,确保系统在高负载下依然能够稳定运行。这种技术不仅提高了散热效率,还降低了数据中心的能耗。

此外,密集功率管理也成为了数据中心的重中之重。随着GPU集群的规模扩展,功耗的管理变得越来越复杂。数据中心需要采用先进的功率管理系统,实时监控和调节每个节点的功耗,以防止因过度负载而引发的系统崩溃。

模块化数据中心设计也是一个关键的升级方向,通过模块化设计,数据中心可以根据需求灵活扩展,快速部署新的GPU节点,同时保持高效的资源利用率。这种设计不仅降低了初始建设成本,还提升了数据中心的灵活性和可扩展性,能够更好地适应未来的技术发展。

操作系统如何适应新环境?

面对存储、网络和数据中心的全面升级,云操作系统也必须做出相应的调整,以适应这些变化。

操作系统需要更智能地管理和调度存储资源,确保数据能以最快的速度到达GPU,并在内存中高效处理。它还需要支持分布式存储和NVMeoF等新兴技术,为高吞吐量和低延迟的存储需求提供强有力的支持。

在网络管理方面,操作系统必须能够识别和利用RDMA、高速互联等技术,优化数据传输路径,减少延迟,提高网络的整体吞吐量。同时,操作系统还需要具备动态调节网络流量的能力,以应对高密度并发计算对网络带宽的需求。

此外,操作系统必须能够与数据中心的硬件基础设施深度集成,特别是在功率管理和散热优化方面。它需要实时监控硬件状态,并根据负载情况自动调整系统配置,确保GPU集群在高效运行的同时,保持低能耗和高可靠性。

我们可以看到,智算云时代的到来不仅仅是算力的革命,更是整个基础设施的升级和重塑。

PaaS和SaaS的进化,从开发到服务的重构

在智算云的时代,随着GPU成为计算的核心,PaaS和SaaS平台也面临着新的变革。这场变革既可能是开发者的春天,也可能是他们的冬天,关键在于平台是否能够跟上技术的步伐,提供更强大的工具和服务。

PaaS平台的全新生态

智算云时代的到来,意味着PaaS平台必须进行彻底的革新。过去,PaaS平台主要为CPU优化,无论是编译器、调试工具,还是开发框架,都以CPU的计算逻辑为核心。然而,随着GPU的崛起,PaaS平台需要重新审视并优化其生态系统,以支持高性能计算和深度学习应用。

其中,编译器的优化成为当务之急。传统编译器无法充分利用GPU的并行计算能力。为此,许多PaaS平台已经开始集成支持CUDA或ROCm等GPU计算框架的编译器,使开发者能够更轻松地编写并行计算代码,充分发挥GPU的潜力。

其次,开发框架的优化也是至关重要的。框架如TensorFlow、PyTorch等已经成为深度学习开发的主流工具。这些框架在PaaS平台上的表现直接影响开发者的生产力。为此,PaaS平台必须提供深度集成的开发环境,使得这些框架能够无缝运行在GPU集群上,并且能够利用平台的分布式计算能力,支持大规模模型的训练和推理。

此外,PaaS平台还需要提供更强大的调试工具。在复杂的GPU计算环境下,调试变得更加困难。PaaS平台必须支持远程调试、实时性能监控,以及自动化的故障诊断,以帮助开发者迅速定位和解决问题。

这种全面的技术优化将使PaaS平台成为智算云时代开发者的“春天”,为他们提供高效的开发工具和环境,助力他们在AI领域快速创新。

SaaS服务的智能化进化

随着PaaS平台的革新,SaaS服务也在迎来新的进化。GPU强大的计算能力为SaaS应用带来了前所未有的智能化升级机会。这不仅仅是性能的提升,更是服务模式的根本性变化。

GPU的计算能力,使得SaaS应用能够实时处理和分析海量数据。这种能力的增强,使得自动化决策和个性化服务变得更加高效。例如,AI驱动的客服系统可以实时处理用户请求,并根据用户历史数据和行为模式,提供更加精准和个性化的服务。

更进一步,GPU的并行处理能力,叠加上OpenAI刚发布的o1这样的强大模型,使得复杂模型的实时推理成为可能。对于许多SaaS应用而言,AI模型的推理速度直接影响用户体验。例如,在金融风控系统中,GPU加速可以实现对海量交易数据的实时分析,从而即时发现异常行为,提升系统的安全性。

此外,GPU还使得SaaS应用能够动态适应不同用户的需求。通过利用AI技术,SaaS服务可以根据用户的实时数据和操作习惯,自动调整系统配置和资源分配,为每个用户提供量身定制的服务。这种个性化的服务模式将大大提升用户满意度和系统的使用效率。

在智算云的时代,PaaS和SaaS平台面临着前所未有的挑战,但也迎来了无限的机遇。对于开发者来说,这或许是他们的春天,因为平台的革新将为他们提供更强大的工具和支持。然而,这也可能是他们的冬天,如果他们无法快速适应这些变化。

全球云厂商的智算竞赛,谁能笑到最后?

在云计算的战场上,传统巨头们一直占据着主导地位。然而,随着AI大模型和GPU计算的崛起,云计算的格局正悄然发生变化。全球主要云厂商之间的智算竞赛,正愈演愈烈。那么,谁能在这场角逐中脱颖而出,成为最终的王者?

根据数据猿观察,国内的阿里云、腾讯云、百度智能云,在面向AI大模型重构云计算基础设施方面,显得特别的“激进”。

阿里云,云栖大会上展示了其全新升级的云产品体系。

在2024年云栖大会上,阿里云展示了其AI基础设施和弹性计算产品家族的全面升级,以适应生成式AI时代的需求。阿里云通过全栈优化,从底层计算、存储、网络到AI大模型平台,构建了一套稳定高效的AI基础设施。

推出了CIPU2.0处理器,具有400Gbps的高吞吐数据加速和一体化的软硬件安全优化。基于此,阿里云发布了支持16卡GPU和1.5T显存的磐久AI服务器,以及AI算法预测GPU故障的功能,提高了AI算力的稳定性和效率。

在存储领域,阿里云的CPFS实现了单客户端25GB/s的吞吐量,为AI提供了强大的存储支持。同时,HPN7.0网络架构优化了集合通信性能,确保大规模AI集群的高效运行。

阿里云还发布了第九代ECS企业级实例,性能提升高达30%,并推出了GPU容器算力服务,升级了容器服务ACK,减少了大模型应用的冷启动延迟。

在大模型领域,阿里云的通义千问和Qwen系列模型全面升级,覆盖多模态应用,并降低了调用成本,推动了生成式AI的普及。

尤其值得指出的是,飞天企业版实现了智算升级,将智算能力融入专有云平台,优化了异构算力池化和推理效率。通过GPU虚拟化和容器调度,资源利用率提升了100%。在推理场景下,通信带宽和模型吞吐量得到显著提升。

系统稳定性方面,飞天企业版提供了一体化监控和分析诊断能力,实现了分钟级故障定位,确保AI任务的高效稳定运行。这些升级使飞天企业版在满足政企市场AI需求的同时,继续引领云计算操作系统的智能化发展。

腾讯云,发布了AIInfra品牌“腾讯云智算”。

腾讯云在2024年数字生态大会上推出了AIInfra品牌“腾讯云智算”,这是一个整合了算力、存储、网络的高性能计算平台。该平台旨在提供领先性能、多芯兼容和灵活部署的智算服务,推动AI生产力的释放。

腾讯云智算包括HCC高性能计算、星脉网络、AIGC云存储等核心产品,形成了强大的智算基础设施。HCC提供3.2T的超高互联带宽,优化大模型训练和推理。星脉网络2.0采用自研设备和400G硅光模块,降低延迟,提升训练效率。

存储方面,CFS Turbo和COS针对高性能文件存储和大数据存储需求优化,CFS Turbo特别适合AIGC训练,提供百万级OPS和千亿级文件扩展,而COS支持百EB级存储规模。

腾讯云智算还包括向量数据库和TACO系列加速框架,提升AI训练和推理效率。TACOTrain加速引擎兼容多种训练框架,优化网络通信和模型并行处理;TACOLLM针对大语言模型推理加速,提升性能,降低成本。

百度智能云,通过整合基础设施和大模型工具链,提供全栈的AI解决方案。

在2024年云智大会上,百度智能云推出了全栈AI解决方案,强化其在智能云计算领域的布局。

核心产品“百舸”AI异构计算平台4.0,专为大模型训练和推理设计,支持多芯异构计算,提供高效稳定的算力。该平台通过秒级部署功能,显著缩短集群创建和模型部署时间,并具备强大的故障容错能力,确保了大规模集群的稳定性。

模型开发和应用方面,百度智能云的“千帆”3.0平台提供了从模型开发到应用部署的全套工具链,整合了文心系列模型,满足企业复杂业务需求。平台还引入了低代码、零代码开发工具,如AI速搭,降低开发门槛,提高效率。

此外,百度智能云还推出了智能客服产品“客悦”和数字人平台“曦灵”。客悦利用多模态交互和情感识别技术提升服务智能化,降低人力成本。曦灵平台则提供2D、3D数字人生成和实时交互技术,为电商、金融等行业提供数字人解决方案。

除了我们上面重点介绍的3家云厂商,其他云厂商也在智算云这条道路上,蒙眼狂奔。

在智算云的赛道上,各大云服务厂商正加速布局,以GPU为核心的计算资源池和智算云服务正逐渐成为新的行业标准。

AWS 凭借专为AI任务设计的Inferentia和Trainium芯片,以及Amazon SageMaker等AI服务,确立了其在AI计算生态系统中的领导地位。

微软Azure 通过与OpenAI的紧密合作,推出了Azure OpenAI服务,将生成式AI技术与企业级服务相结合,提供了灵活的模型部署和微调功能。

谷歌云借助其专为AI任务设计的TPU(Tensor Processing Unit),在深度学习任务中展现出卓越的性能,其新一代TPU v5p在性能上实现了显著提升。

华为云通过Ascend系列AI处理器和ModelArts平台,为用户提供了一站式AI开发环境,支持自动化模型训练、调优和部署。

这些厂商的操作系统和云基础设施正在经历重大的改造,以适应AI大模型的需求。例如,华为云的xGPU技术实现了物理GPU的资源任意划分,灵活隔离,以适应AI训练任务的配置要求。

在这场智算云的全球竞赛中,没有谁能够轻松取胜。这是一场持久战,技术、市场、生态系统的多维竞争将决定最终的赢家。

谁能引领下一个计算时代?

随着大模型技术的飞速发展,云计算正迈入一个全新的阶段——智算云时代。这个新时代不仅带来了前所未有的机遇,也对云服务商提出了极高的技术要求。要在这场变革中胜出,厂商们必须克服一系列复杂而棘手的挑战。

智算云的兴起,预示着全球云计算市场将迎来新一轮的洗牌。那些能够迅速掌握智算云核心技术的厂商,将在市场中占据有利位置。例如,阿里云通过其自研的飞天操作系统,已经实现了对异构算力的统一调度,显著提升了资源利用效率。

然而,智算云带来的高技术门槛也可能导致一些中小型云服务商陷入困境。如果这些厂商无法快速适应新的市场需求,无法提供稳定、高效的智算云服务,他们将面临被市场淘汰的风险。与此同时,那些能够提供差异化服务并在特定领域取得突破的创新者,也有可能通过垂直整合或专注于特定应用场景,开辟出新的市场空间。

展望未来,智算云技术的发展将深刻影响全球经济和社会结构。随着AI逐渐渗透到各行各业,智算云将成为新一代数字基础设施的核心,其重要性不亚于当前的电力和互联网。我们可以预见,未来的智算云将不仅限于支持现有的AI应用,还会推动更多跨领域的创新。例如,在智能制造中,智算云可以实时分析生产数据,优化制造流程;在智慧城市中,智算云可以整合交通、能源、安防等多个系统,提升城市管理的智能化水平。

更进一步,智算云的普及可能催生出新的商业模式和产业生态。例如,随着边缘计算与智算云的深度融合,更多的实时、个性化AI服务将得以实现,从而推动消费互联网和工业互联网的进一步发展。这一切的前提是,云服务商能否在这场技术竞赛中脱颖而出,成为引领下一个计算时代的领航者。未来的胜者,将不仅掌握技术制高点,还将重塑全球经济格局,推动社会的智能化变革。

文:一蓑烟雨 / 数据猿

责编:凝视深空 / 数据猿

4030

4030

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?