文本分类

分类问题

1.模型:分类器。分类器是一个函数f,这个函数拿到输入x然后输出类别y。

2.预测

3.学习

常见应用

识别垃圾邮件

情感分类

主题分类

CNN

卷积神经网络的各层中的神经元是3维排列的:宽度、高度和深度。其中的宽度和高度是很好理解的,因为本身卷积就是一个二维模板,但是在卷积神经网络中的深度指的是激活数据体的第三个维度,而不是整个网络的深度,整个网络的深度指的是网络的层数。

卷积神经网络的各层中的神经元是3维排列的:宽度、高度和深度。其中的宽度和高度是很好理解的,因为本身卷积就是一个二维模板,但是在卷积神经网络中的深度指的是激活数据体的第三个维度,而不是整个网络的深度,整个网络的深度指的是网络的层数。

在处理图像这样的高维度输入时,让每个神经元都与前一层中的所有神经元进行全连接是不现实的。相反,我们让每个神经元只与输入数据的一个局部区域连接。该连接的空间大小叫做神经元的感受野(receptive field),它的尺寸是一个超参数(其实就是滤波器的空间尺寸)。在深度方向上,这个连接的大小总是和输入量的深度相等。

在处理图像这样的高维度输入时,让每个神经元都与前一层中的所有神经元进行全连接是不现实的。相反,我们让每个神经元只与输入数据的一个局部区域连接。该连接的空间大小叫做神经元的感受野(receptive field),它的尺寸是一个超参数(其实就是滤波器的空间尺寸)。在深度方向上,这个连接的大小总是和输入量的深度相等。

常用卷积神经网络架构

LeNet

LeNet的设计较为简单,因此其处理复杂数据的能力有限;此外,在近年来的研究中许多学者已经发现全连接层的计算代价过大,而使用全部由卷积层组成的神经网络。

AlexNet

AlexNet是在LeNet的基础上加深了网络的结构,学习更丰富更高维的图像特征。AlexNet的特点:

1.更深的网络结构

2.使用层叠的卷积层,即卷积层+卷积层+池化层来提取图像的特征

3.使用Dropout抑制过拟合

4.使用数据增强Data Augmentation抑制过拟合

5.使用Relu替换之前的sigmoid的作为激活函数

6.多GPU训练

VGG-16

VGG16的突出特点是简单,体现在:

1.卷积层均采用相同的卷积核参数

卷积层均表示为conv3-XXX,其中conv3说明该卷积层采用的卷积核的尺寸(kernel size)是3,即宽(width)和高(height)均为3,3*3是很小的卷积核尺寸,结合其它参数(步幅stride=1,填充方式padding=same),这样就能够使得每一个卷积层(张量)与前一层(张量)保持相同的宽和高。XXX代表卷积层的通道数。

2.池化层均采用相同的池化核参数

池化层的参数均为2×

3.模型是由若干卷积层和池化层堆叠(stack)的方式构成,比较容易形成较深的网络结构(在2014年,16层已经被认为很深了)。

ResNet

ResNets要解决的是深度神经网络的“退化”问题。

对浅层网络逐渐叠加layers,模型在训练集和测试集上的性能会变好,因为模型复杂度更高了,表达能力更强了,可以对潜在的映射关系拟合得更好。而“退化”指的是,给网络叠加更多的层后,性能却快速下降的情况。

DenseNet

DenseNet特点:

1,减轻了消失梯度(梯度消失)

2,加强了特征的传递

3,更有效地利用了特征

4,一定程度上较少了参数数量

GAN

GAN的主要结构:

GAN的主要结构:

GAN的主要结构有生成器和分类器。生成器的目标是让生成的数据接近真实数据。分类器是为了能够鉴别真实数据和生成的假数据。

通过一个判别器而不是直接使用损失函数来进行逼近,更能够自顶向下地把握全局的信息。比如在图片中,虽然都是相差几像素点,但是这个像素点的位置如果在不同地方,那么他们之间的差别可能就非常之大。

CycleGAN,即循环生成对抗网络,用于图像风格迁移任务。以前的GAN都是单向生成,CycleGAN为了突破Pix2Pix对数据集图片一一对应的限制,采用了双向循环生成的结构,因此得名CycleGAN。

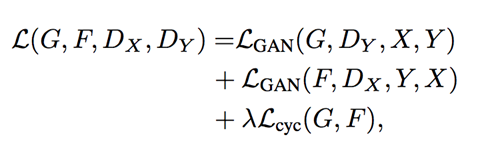

CycleGAN本质上是两个镜像对称的GAN,构成了一个环形网络。两个GAN共享两个生成器,并各自带一个判别器,即共有两个判别器和两个生成器。一个单向GAN两个loss,两个即共四个loss。

模型架构:

损失函数:

损失函数:

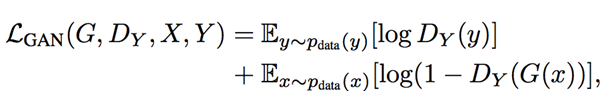

GAN损失函数:

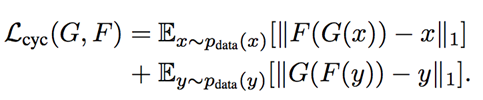

Cycle Consistency Loss:

Cycle Consistency Loss:

5572

5572

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?