点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

作者丨图灵智库

来源丨 泡泡机器人SLAM

标题: Mix3D: Out-of-Context Data Augmentation for 3D Scenes

作者:Alexey Nekrasov,Jonas Schult,Or Litany,Bastian Leibe ,Francis Engelmann

机构:RWTH Aachen University, NVIDIA, ETH AI Center

来源:3DV 2021

编译:Cristin

审核: ZH

摘要

大家好,今天为大家带来的文章是 Mix3D: Out-of-Context Data Augmentation for 3D Scenes

我们提出了一种用于分割大规模三维场景的数据增强技术Mix3D。由于场景纹理有助于对对象语义的推理,目前的研究主要集中在大容量和接受域的模型上,这些模型能够充分捕捉输入的3D场景的全局纹理。然而,过于偏重纹理先验知识可能会产生不利影响,比如将过街的行人误认为汽车。在这项工作中,我们关注平衡全局场景纹理和局部几何的重要性,目标是超越训练集中的纹理先验进行泛化。特别地,我们提出了一种“混合”技术,通过结合两个增强场景来创建新的训练样本。通过这样做,物体实例被隐式地放置到新的脱离纹理的环境中,因此,模型很难单独依赖场景纹理,而从局部结构推断语义。我们进行了详细的分析,以理解全局语境的重要性,局部结构和混合场景的效果。在实验中,我们表明使用Mix3D训练的模型在室内(ScanNet, S3DIS)和室外数据集(SemanticKITTI)上的性能显著提高。Mix3D可以用于任何现有的方法,例如,使用Mix3D进行训练,MinkowskiNet在ScanNet测试基准上的表现明显优于所有之前的最先进的方法(78.1% mIoU)。

主要工作与贡献

本工作的主要贡献如下:

•我们提出了Mix3D,这是一种用于大规模3D场景和高容量模型的数据增强技术,可以平衡全局纹理和局部几何图形。因此,训练后的模型可以泛化超越训练集的上下文先验。

•将Mix3D应用到最近的基于点和基于体素的3D模型中,可以在3D大型室内和室外数据集上持续改进分割性能。

•在ScanNet测试基准测试挑战中,新的最先进的语义分割性能为78.1%的mIoU。

•对Mix3D的深入分析表明,在模型综合和分割性能方面,全局上下文、局部几何和混合场景的重要性。

算法流程

本文提出了一种基于数据增强技术的真实大场景三维深度学习方法。我们的目标是训练3D模型,使其不受误导的纹理先验的影响,并学会在局部结构和全局场景纹理之间取得平衡,而不过度拟合训练场景。Mix3D通过混合两个原始场景创建了新的训练示例。三维场景的混合如图2所示。特别是,我们将对象从单个输入场景暴露到两个混合场景的组合纹理中。通过这样做,网络不仅需要学习如何隐式地解开两个混合场景纹理,而且还需要在一个通常不会遇到的各种各样的对象安排中看到每个对象。最值得注意的是,通过使用Mix3D,我们从最初的N个不同的场景纹理中,通过对现有场景的成对组合,获得了O(N 2)个新的纹理。

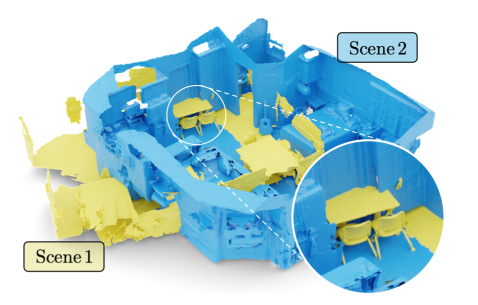

图2 Mix3D数据增强包括在随机转换后在两个3D场景中获取联合,同时确保足够的重叠。这导致了现在出现在两个混合场景的新上下文中的物体的效果,例如,教室的桌子正对着公寓的门。我们的目标是训练一个模型,让它学会何时依赖上下文,何时关注局部几何图形。

1.数据增强

当增加输入场景时,我们首先通过减去所有点位置的质心将其平移到原点。通过这样做,我们确保两个场景在接下来的混合阶段是重叠的。我们在水平方向上随机翻转点云,沿着垂直轴随机旋转场景,通过Uniform[-π /64,π /64]沿着另一个轴随机旋转场景。我们还应用了随机子采样、弹性失真和通过Uniform[0.9, 1.1]随机缩放场景。当输入特征包括颜色时,我们另外应用随机亮度和对比度增强以及颜色抖动。

图3 网络框架说明。该网络主要由三种不同类型的节点组成。X i e为特征提取节点,主要由残差块组成。xi,j表示一个特征融合节点,该节点只有3 × 3的卷积运算。X i d是特征融合节点,主要由我们提出的fSE模块组成。视差由disconv块进行解码,该块包含3 × 3卷积和sigmoid激活函数。

1.1Mixing

增强后,两个场景混合在一起,这是两个增强点云的简单结合。从技术上讲,我们通过成对地连接批处理条目来实现这一点。此外,由于在增宽过程中不修改点的顺序,混合点云的ground真值标签也通过拼接得到

1.2 3D Model

Mix3D独立于底层的3D深度学习模型。在实验中,我们使用MinkowskiNet[9]和KPConv[49]作为基于体素和基于点的模型的最新代表。确切的实验设置在第4节和补充中有更详细的描述。

1.3 Loss function

我们使用标准交叉熵损失L CE来监督语义分割模型,我们将其应用于混合场景s1,2和两个场景的连接地面真实标签Y 1,2的预测。

1.4 讨论

Mix3D与现有的基于点云混合技术在两个主要方面有所不同。首先,我们是第一个探索单一对象分类以外的混合样本增强来解决大规模场景分割。我们认为这是提高现实世界3D场景理解的重要一步。其次,受MixUp[62]的启发,最近的技术提出了插值标签[32,63],甚至输入样本[8]。虽然适合于整体分类任务,但这里我们保留了混合样本和标签的原始形式。我们以以下方式激发这一点:考虑预测两个输入(aS 1,(1−a) s2)的凸组合的任务为aY 1 +(1−a)Y 2。这意味着y1的预测在y2存在时发生了变化。然而,这与我们的目标相反,我们希望保持y1的预测对y2的存在是不可知的。特别是,我们保留了每个混合样本的完整上下文信息,而PointMixUp[8]通过插值扭曲点云,RSMix[32]只保留了局部受限块的空间结构。我们在图3(右)中提供了伪代码。

实验结果

表1 Mix3D对三维语义分割模型的影响。我们比较了MinkowskiNet(基于体素)和KPConv(基于点),以及在大规模室内场景(ScanNet, S3DIS)和室外场景(SemanticKITTI)上使用和不使用Mix3D。

统计了表二 ScanNet验证的语义分割得分[10]。我们三个训练过的模型的班级平均分数。

表3 在ScanNet测试中的语义分割结果。我们包括另外依赖于2D图像和多边形网格作为输入的方法。基准于2021年10月5日获得。

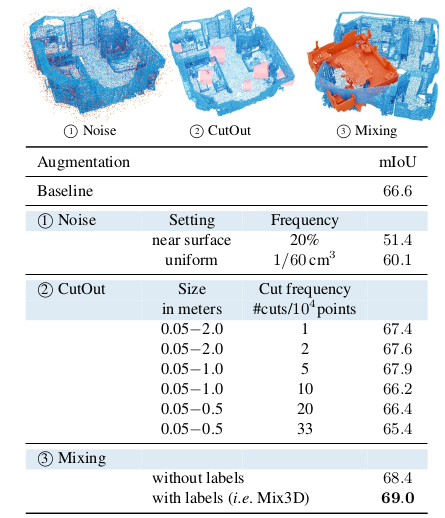

图4 选择纹理的变化。我们比较了随机的噪音模式,剪掉随机的块,混合有注释标签和没有注释标签的场景。带有标签的Mix3D性能最好,而当有大量未标签数据可用或标签成本太高时,不带标签的混合仍然是一种可行的方法。

图6 场景重叠的影响。场景-背景的重叠是Mix3D的决定性方面。将场景相邻放置,不存在重叠或距离过远,使模型的接收域能够在两个场景之间进行信息交换。

图7 定性的结果。我们在ScanNet(左)、SemanticKITTI(中)和S3DIS(右)上展示了使用和不使用Mix3D训练的模型的定性结果。与最初的型号相比,在(a) Mix3D有助于区分两个堆叠的洗衣机标记为l“其他家具”和l“冰箱”。在(b)中,没有Mix3D训练的MinkowskiNet错误地将人行道上靠近植被的l“自行车”分类为l“其他物体”。对于S3DIS,使用Mix3D训练的模型在l“窗口”类中特别有好处,如(c)。

点击阅读原文, 即可获取本文下载链接。

本文仅做学术分享,如有侵权,请联系删文。

3D视觉精品课程推荐:

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

4.国内首个面向工业级实战的点云处理课程

5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~

5325

5325

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?