深度学习

1. 深度学习的三个步骤

1.1 神经网络(Neural network)

神经网络有着多种的模型,而这也对应着神经元不同的连接方式。

下面时一些常见的连接方式对应的神经网络

完全连接前馈神经网络

- 概念:前馈(feedforward)也可以称为前向,从信号流向来理解就是输入信号进入网络后,信号流动是单向的,即信号从前一层流向后一层,一直到输出层,其中任意两层之间的连接并没有反馈(feedback),亦即信号没有从后一层又返回到前一层。

- 当已知权重和偏差时输入(1,-1)(1,−1)的结果

- 结论:一个神经网络如果权重和偏差都知道的话就可以看成一个函数,他的输入是一个向量,对应的输出也是一个向量。不论是做回归模型(linear model)还是逻辑回归(logistics regression)都是定义了一个函数集(function set)。我们可以给上面的结构的参数设置为不同的数,就是不同的函数(function)。这些可能的函数(function)结合起来就是一个函数集(function set)。这个时候你的函数集(function set)是比较大的,是以前的回归模型(linear model)等没有办法包含的函数(function),所以说深度学习(Deep Learning)能表达出以前所不能表达的情况。

- 全链接和前馈的理解

- 输入层(Input Layer):1层

- 隐藏层(Hidden Layer):N层

- 输出层(Output Layer):1层

- 为什么叫全链接:因为layer1与layer2之间两两都有连接

- 为什么叫前馈:现在传递的方向是由后往前传

- 深度的理解:Deep = Many hidden layer.

此时,由于层数的增多,运算量也急速增大。对于这样的结构,我们不会使用一般的循环(会有巨大的计算开销)。此时,我们引入矩阵计算(Matrix Operation),这能使我们的运算速度与效率大幅提高。

通过一连套的矩阵运算,从输入层计算到输出层。

本质:通过隐藏层进行特征转换

把隐藏层通过特征提取来替代原来的特征工程,这样在最后一个隐藏层输出的就是一组新的特征(相当于黑箱操作)而对于输出层,其实是把前面的隐藏层的输出当做输入(经过特征提取得到的一组最好的特征)然后通过一个多分类器(可以是softmax函数)得到最后的输出y。

问题

- 多少层? 每层有多少神经元? 这个问我们需要用尝试加上直觉的方法来进行调试。对于有些机器学习相关的问题,我们一般用特征工程来提取特征,但是对于深度学习,我们只需要设计神经网络模型来进行就可以了。对于语音识别和影像识别,深度学习是个好的方法,因为特征工程提取特征并不容易。

- 结构可以自动确定吗? 有很多设计方法可以让机器自动找到神经网络的结构的,比如进化人工神经网络(Evolutionary Artificial Neural Networks)但是这些方法并不是很普及 。

- 我们可以设计网络结构吗? 可以的,比如 CNN卷积神经网络(Convolutional Neural Network )

1.2 模型评估(Goodness of function)

交叉熵

一般采用交叉熵(cross entropy)函数来对 y y y和 y ^ \hat{y} y^的损失计算,调整参数,让交叉熵越来越小

总体损失

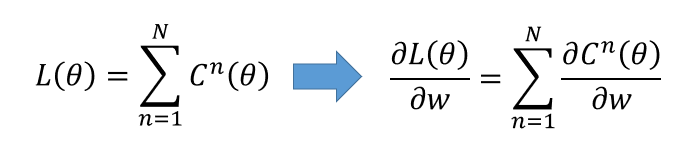

对于损失,我们不单单要计算一笔数据的,而是要计算整体所有训练数据的损失,然后把所有的训练数据的损失都加起来,得到一个总体损失L。接下来就是在function set里面找到一组函数能最小化这个总体损失L,或者是找一组神经网络的参数

θ

\theta

θ,来最小化总体损失L

1.3 选择最优函数(Pick best function)

如何找到最优的函数和最好的一组参数呢,我们用的就是梯度下降

梯度下降

具体流程:

θ

\theta

θ是一组包含权重和偏差的参数集合,随机找一个初试值,接下来计算一下每个参数对应偏微分,得到的一个偏微分的集合

∇

L

\nabla{L}

∇L就是梯度,有了这些偏微分,我们就可以不断更新梯度得到新的参数,这样不断反复进行,就能得到一组最好的参数使得损失函数的值最小

反向传播

在神经网络中计算损失最好的方法就是反向传播

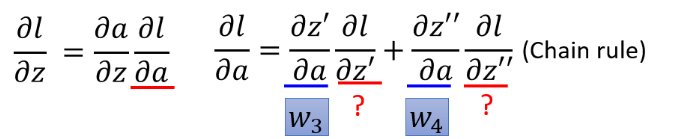

1.链式法则

- 复合函数求导法则

- 连锁影响(可以看出x会影响y,y会影响z)

2.相关损失及其解释

- 损失函数(Loss function)是定义在单个训练样本上的,也就是就算一个样本的误差,比如我们想要分类,就是预测的类别和实际类别的区别,是一个样本的,用L表示。

- 代价函数(Cost function)是定义在整个训练集上面的,也就是所有样本的误差的总和的平均,也就是损失函数的总和的平均,有没有这个平均其实不会影响最后的参数的求解结果。

- 总体损失函数(Total loss function)是定义在整个训练集上面的,也就是所有样本的误差的总和。也就是平时我们反向传播需要最小化的值。

3.相关分析

-

取神经网络中的一部分进行分析

根据链式法则可将梯度计算分为以下两部分:

计算 ∂ z ∂ w \frac{\partial z}{\partial w} ∂w∂z(Forward pass的部分)

计算 ∂ l ∂ z \frac{\partial l}{\partial z} ∂z∂l(Backward pass的部分) -

Forward pass的部分

-

Backward pass的部分(有亿点点迷糊,会再修改这部分)

通过使用链式法则计算过程如下:

得到最终结果为:

思考

隐藏层越多越好?

- 结论:层次越高效果越好

普遍性定理

参数多的model拟合数据很好是很正常的。下面有一个通用的理论: 对于任何一个连续的函数,都可以用足够多的隐藏层来表示。

1334

1334

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?