一.安装前说明

1.台式机系统为windows7

2.此系统已安装和配置java

3.所有软件均为64位

二.安装配置所需的安装包

1.scala2.10.4(http://pan.baidu.com/s/1eSn2jsQ)

2.Intellij IDE 2016.3 (http://pan.baidu.com/s/1dFA4Pk1)

3.spark 1.4.0 (http://pan.baidu.com/s/1bLQcY6)

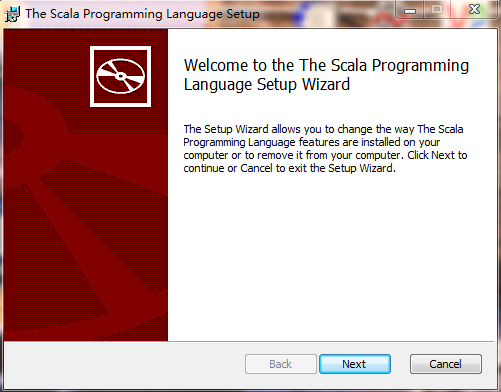

三. windows7 安装 scala

scala 安装比较容易,直接下载相应的安装包即可,因为Scala 2.10.3 版本比较稳定,我们推荐用它。

1.安装过程比较简单(如下图):只需 一路 next 即可。(安装位置自定义)

四.Intellij IDE 安装

Intellij IDE 是常用的 java 编辑器,也可以作为 spark 单机版的调试器。Intellij IDE 有社区版和免费版,我们只需使用免费版即可。我们使用的是 2016.3 版本

1.安装过程很简单,如下图,一路 next 即可。(安装位置自定义)

五. Intellij IDE 中 scala 插件安装

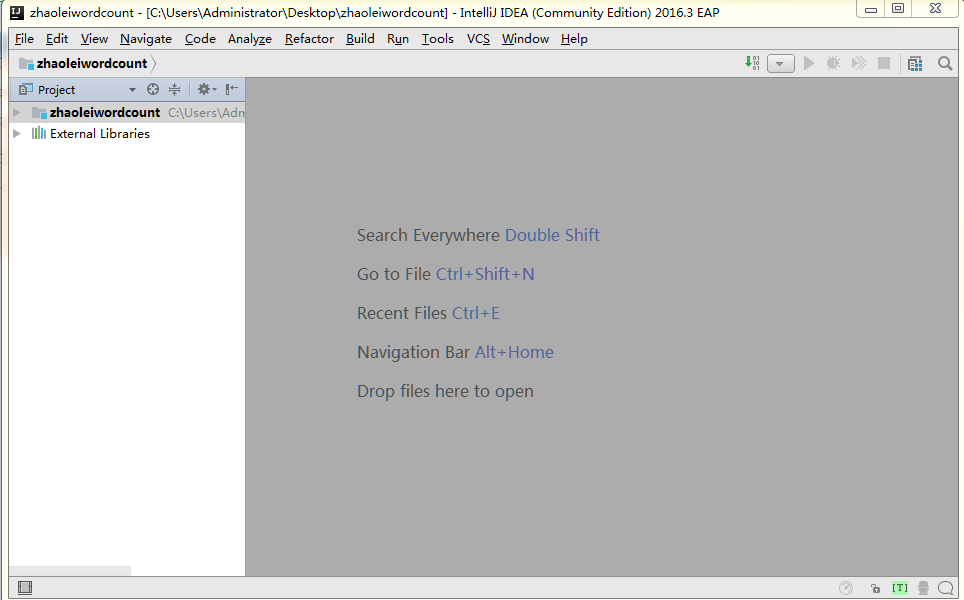

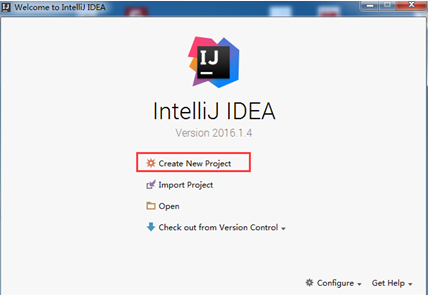

1.启动 Intellij IDE, 界面很炫酷

2.选择新建工程 Create New Project

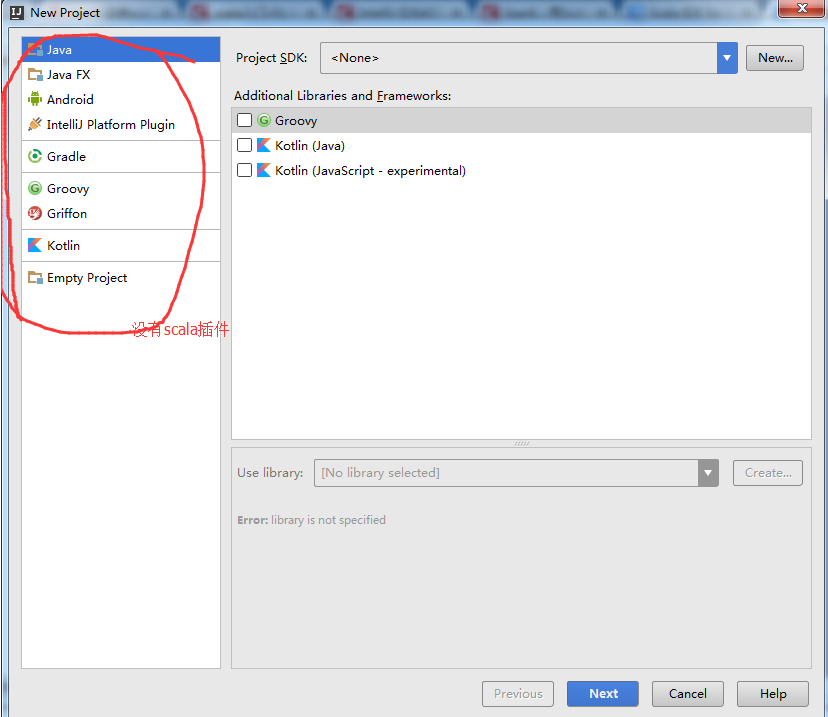

这时(如下图)我们会发现没有 scala 插件

3.安装 scala 插件

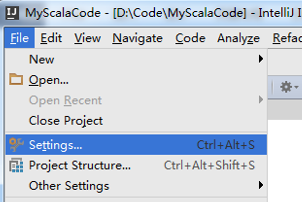

1.打开 File 中的 setting

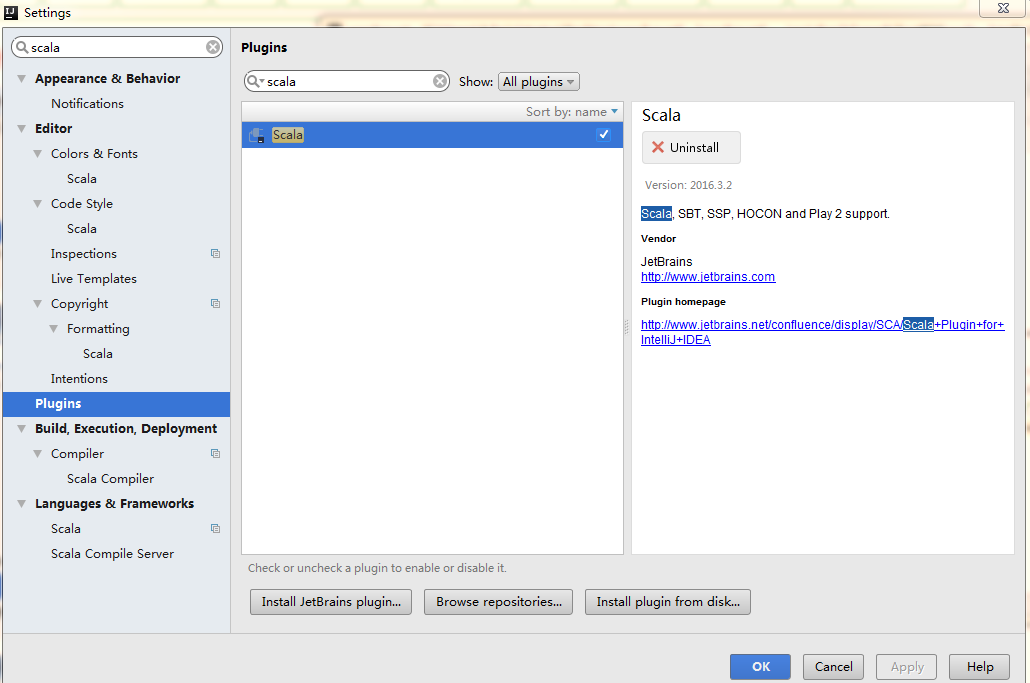

2.点击 plugins 在搜索框里搜索 scala ,然后会看到 scala,点击 Install 安装,安装好之后重启即可。

六.运行wordcount

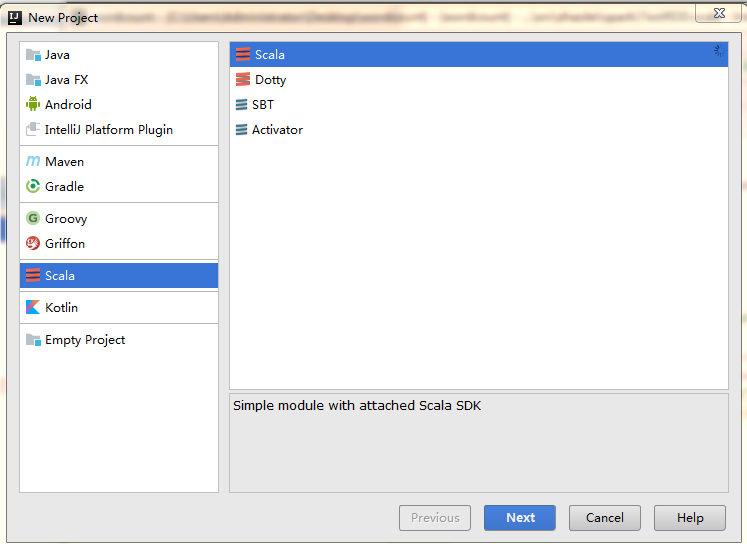

1.新建工程,选择 scala。

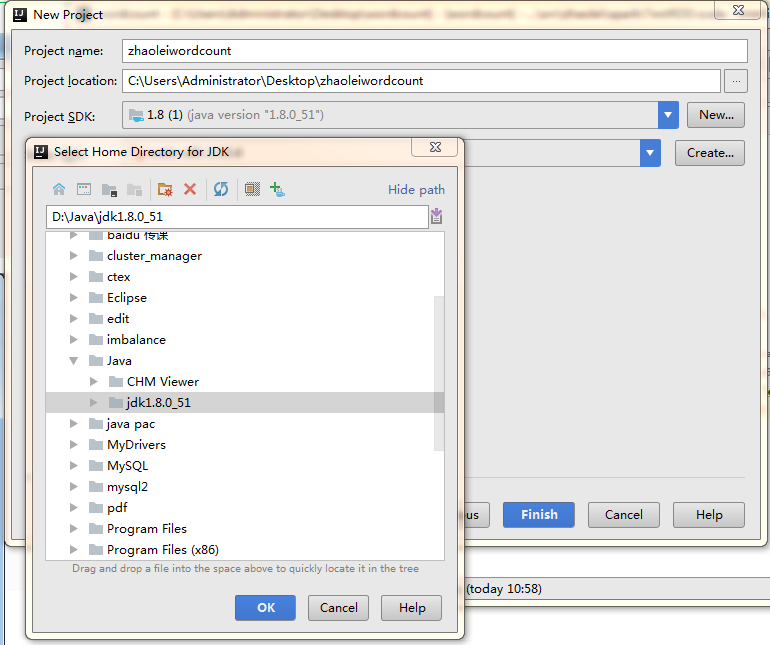

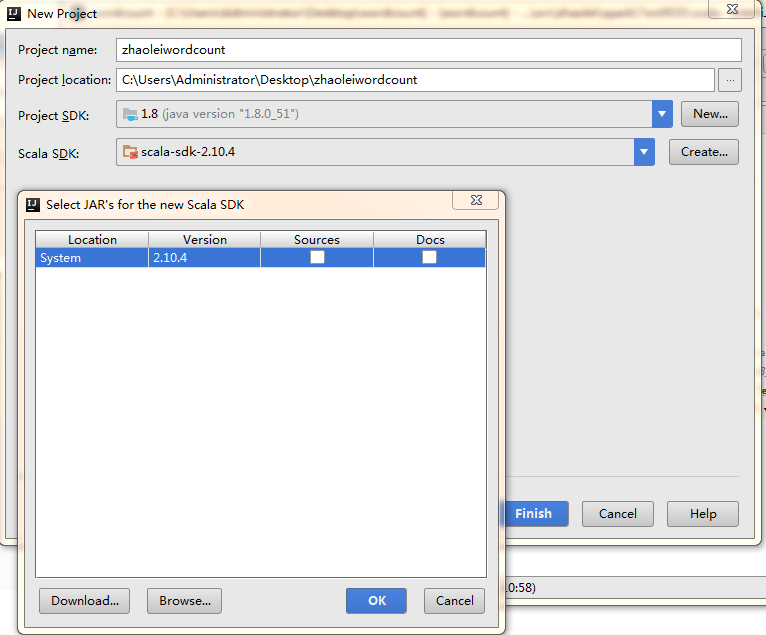

2.新建 project name,sdk 选择 jdk 中的 java 1.8,scala jdk 选择 scala-sdk-2.10.4.

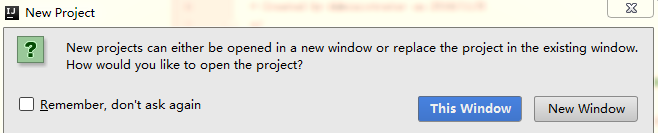

3.选择 This windows

此处要等待一些时间。

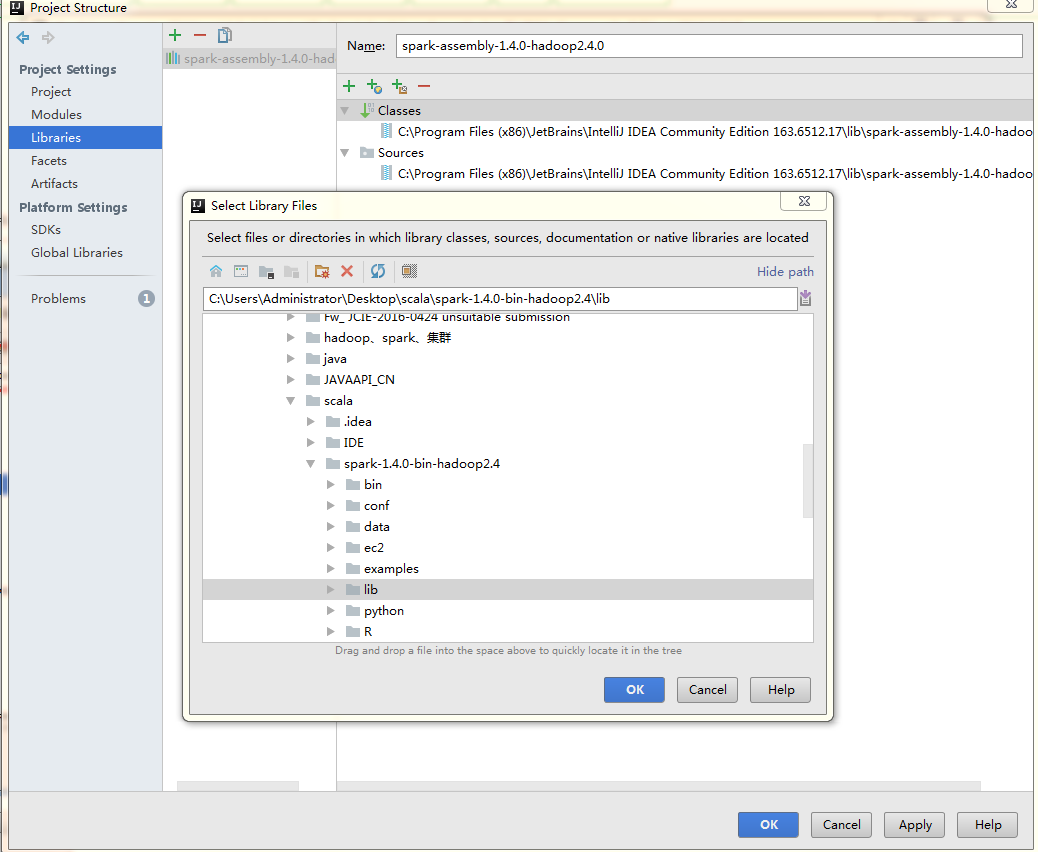

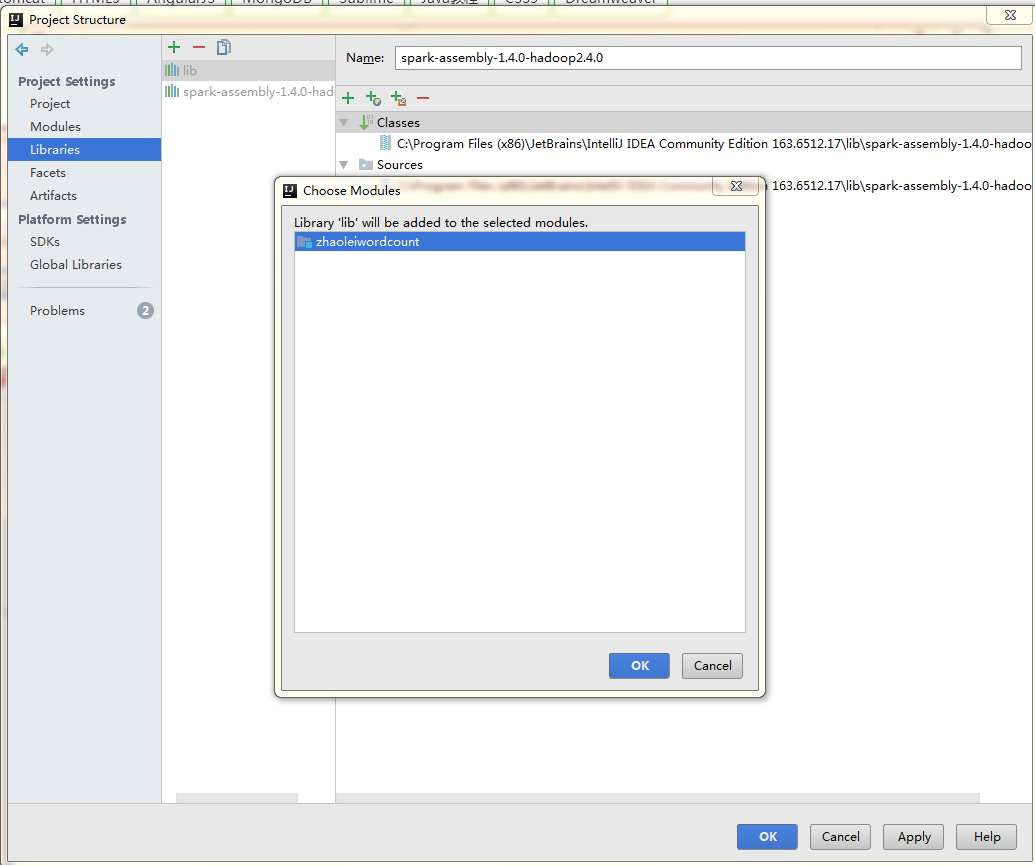

4.导入 spark jar 包

在file 中 选择 project structure: 点击 + ,选择 java,然后找到spark 包的存放路径,将lib 加入。

点击ok

此时可以在工程中看到lib包

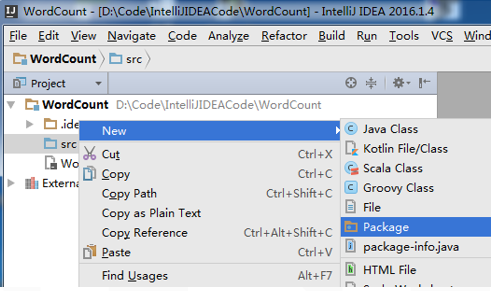

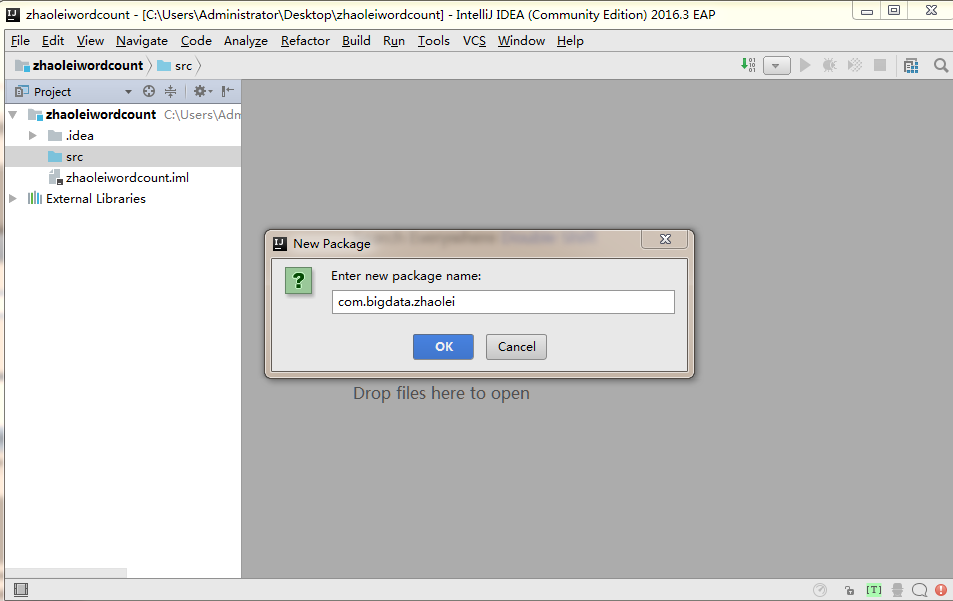

5.src 新建 包

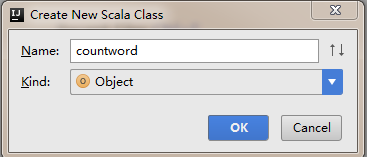

6.在包中新建 scala 类(选择 object)

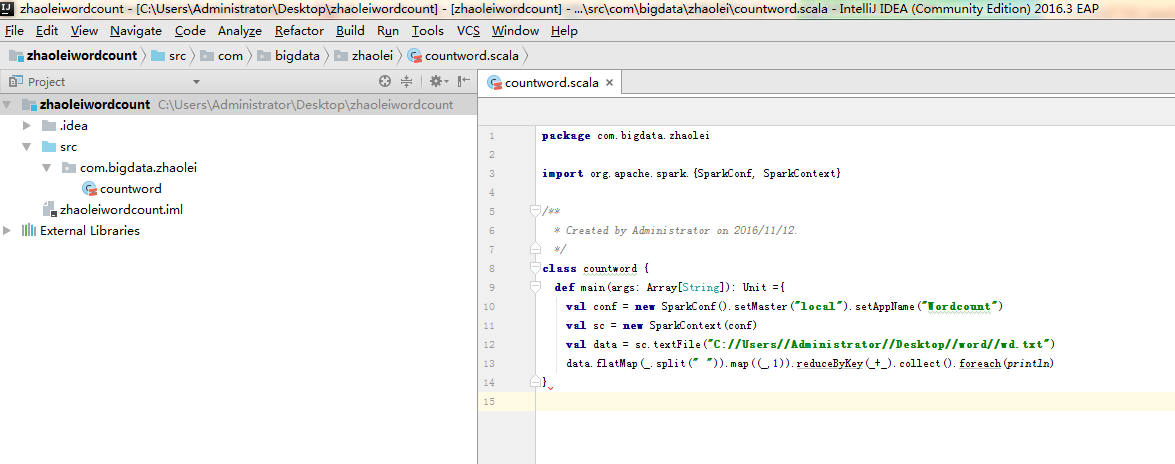

7.写入 wordcount 代码

package com.bigdata.zhaolei

import org.apache.spark.{SparkConf, SparkContext}

/**

* Created by Administrator on 2016/11/12.

*/

class countword {

def main(args: Array[String]): Unit ={

val conf = new SparkConf().setMaster("local").setAppName("Wordcount")

val sc = new SparkContext(conf)

val data = sc.textFile("C://Users//Administrator//Desktop//word//wd.txt") // 文本存放的位置

data.flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).collect().foreach(println)

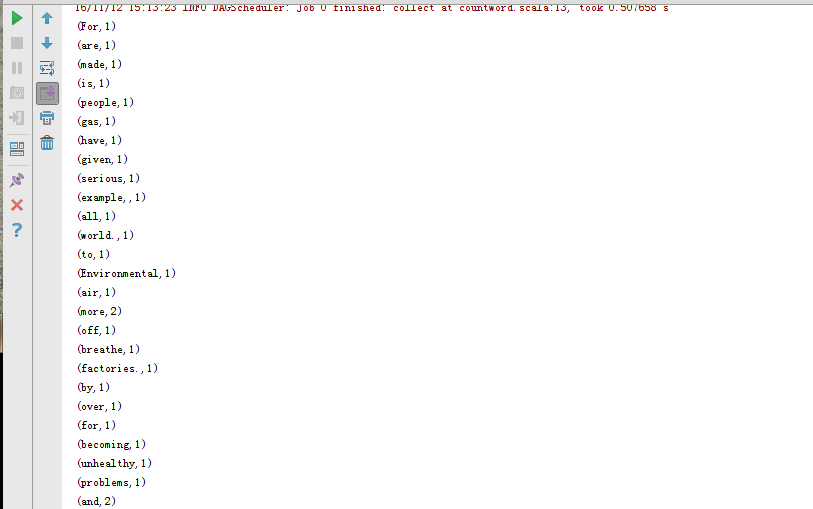

}8.测试代码运行结果

右键,点击 run wordcount(代码中设定的名字)

OK,安装成功。

2280

2280

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?