搭建Spark单机版环境

(一)前提是安装配置好了JDK

查看JDK版本

(二)下载、安装与配置Spark

1、下载Spark安装包

官网下载页面:https://spark.apache.org/downloads.html

下载链接:https://www.apache.org/dyn/closer.lua/spark/spark-3.3.2/spark-3.3.2-bin-hadoop3.tgz

下载到本地

2、将Spark安装包上传到虚拟机

将Spark安装包上传到ied虚拟机/opt目录

3、将Spark安装包解压到指定目录

执行命令:tar -zxvf spark-3.3.2-bin-hadoop3.tgz -C /usr/local

查看解压之后的spark目录

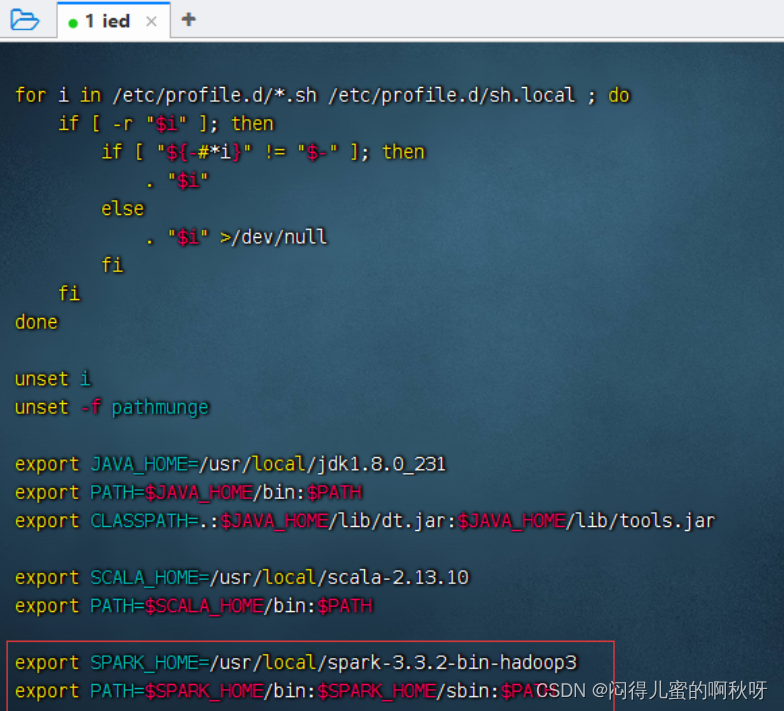

4、配置Spark环境变量

执行vim /etc/profile

export SPARK_HOME=/usr/local/spark-3.3.2-bin-hadoop3

export PATH=$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH

存盘退出,执行命令:source /etc/profile,让环境配置生效

(三)使用Spark单机版环境

1、使用SparkPi来计算Pi的值

执行命令:run-example SparkPi 2 (其中参数2是指两个并行度)

查看计算结果:Pi is roughly 3.1412357061785308

2、使用Scala版本Spark-Shell

Spark-Shell是一个强大的交互式数据分析工具,初学者可以很好的使用它来学习相关API,用户可以在命令行下使用Scala编写Spark程序,并且每当输入一条语句,Spark-Shell就会立即执行语句并返回结果,这就是我们所说的REPL(Read-Eval-Print Loop,交互式解释器),Spark-Shell支持Scala和Python。

命令格式:spark-shell --master <master-url>

--master表示指定当前连接的Master节点

<master-url>用于指定Spark的运行模式

参数名称 相关说明

local 使用一个Worker线程本地化运行Spark

local[*] 本地运行Spark,工作线程数量与本机CPU逻辑核心数量相同

local[N] 使用N个Worker线程本地化运行Spark

spark://host:port Standalone模式下,连接到指定的Spark集群,默认端口7077

yarn-client 以客户端模式连接Yarn集群,集群位置可在HADOOP_CONF_DIR环境变量中配置

yarn-cluster 以集群模式连接Yarn集群,集群位置可在HADOOP_CONF_DIR 环境变量中配置

mesos://host:port 连接到指定的Mesos集群。默认接口是5050

执行spark-shell命令,相当于执行spark-shell --master local[*]命令,启动Scala版的Spark-Shell

访问Spark的Web UI界面 - http://ied:4040

注意:Spark 3.3.2使用的Scala版本其实是2.12.15

利用print函数输出了一条信息

计算1 + 2 + 3 + …… + 100

输出字符直角三角形

打印九九表

执行:quit命令,退出Spark Shell交互式环境

3、使用Python版本Spark-Shell

执行pyspark命令启动Python版的Spark-Shell

执行命令:yum -y install pytho

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

553

553

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?