CART 分为回归树和决策树。这里重点讲讲回归树的特征选择。

回归树选择特征的方法是:平方误差最小化。

具体步骤为:

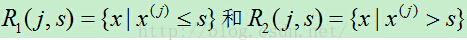

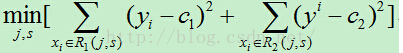

1)依次遍历每个特征j,以及该特征的每个取值s,计算每个切分点(j,s)的损失函数,选择损失函数最小的切分点。

其中c1,c2分别为R1,R2区间内的输出平均值。

2)使用上步得到的切分点将当前的输入空间划分为两个部分

3)然后将被划分后的两个部分再次计算切分点,依次类推,直到不能继续划分。

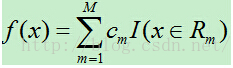

4)最后将输入空间划分为M个区域R1,R2,…,RM,生成的决策树为:

其中cm为所在区域的输出值的平均值

本文介绍了CART回归树的选择特征方法,基于平方误差最小化的策略进行数据切分。接着详细阐述了GBDT(Gradient Boosting Decision Tree)的工作原理,包括回归树、梯度迭代和Shrinkage的概念,并通过实例解释了GBDT如何通过多棵树的迭代来逐步逼近真实值,降低过拟合风险。

本文介绍了CART回归树的选择特征方法,基于平方误差最小化的策略进行数据切分。接着详细阐述了GBDT(Gradient Boosting Decision Tree)的工作原理,包括回归树、梯度迭代和Shrinkage的概念,并通过实例解释了GBDT如何通过多棵树的迭代来逐步逼近真实值,降低过拟合风险。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

637

637

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?