目录

2)在Spark配置文件spark-env.sh中指定Hadoop及其配置文件的主目录(根据自己的Hadoop安装目录修改)。

3)将MySQL驱动JAR包复制到$SPARK_HOME/jars目录中(根据自己的目录复制)。

1.Spark SQL介绍

Spark SQL是一个用于结构化数据处理的Spark组件。所谓结构化数据,是指具有Schema信息的数据,例如JSON、Parquet、Avro、CSV格式的数据。与基础的Spark RDD API不同,Spark SQL提供了对结构化数据的查询和计算接口。

Spark SQL的主要特点:

- 将SQL查询与Spark应用程序无缝组合

Spark SQL允许使用SQL或熟悉的API在Spark程序中查询结构化数据。与Hive不同的是,Hive是将SQL翻译成MapReduce作业,底层是基于MapReduce的;而Spark SQL底层使用的是Spark RDD。

- 可以连接到多种数据源

Spark SQL提供了访问各种数据源的通用方法,数据源包括Hive、Avro、Parquet、ORC、JSON、JDBC等。

- 在现有的数据仓库上运行SQL或HiveQL查询

Spark SQL支持HiveQL语法以及Hive SerDes和UDF (用户自定义函数) ,允许访问现有的Hive仓库。

2.DataFrame和DataSet

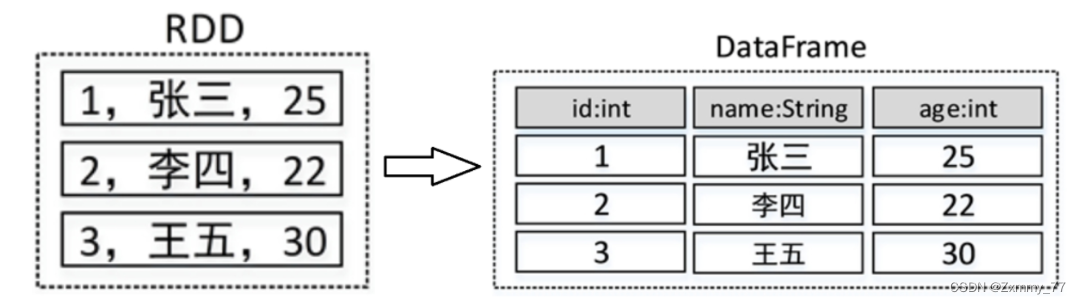

1)DataFrame的结构

DataFrame是Spark SQL提供的一个编程抽象,与RDD类似,也是一个分布式的数据集合。但与RDD不同的是,DataFrame的数据都被组织到有名字的列中,就像关系型数据库中的表一样。

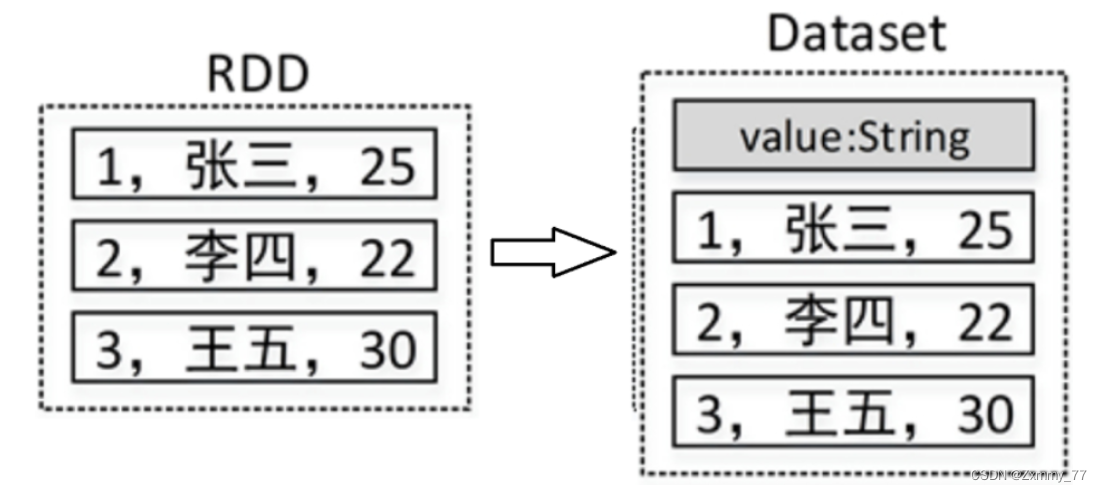

2)DataSet的结构

Dataset是一个分布式数据集,是Spark 1.6中添加的一个新的API。相比于RDD, Dataset提供了强类型支持,在RDD的每行数据加了类型约束。

3.Spark SQL的基本使用

下面介绍一个Spark SQL基本使用案例:

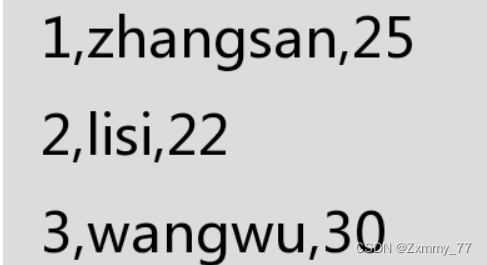

在HDFS中有一个文件/input/person.txt,文件内容如下:

1)加载数据为Dataset

val d1 = spark.read.textFile("hdfs://192.168.121.131:9000/input/person.txt")

d1.show() # 查看d1中的数据内容2)给Dataset添加元数据信息

case class Person(id:Int,name:String,age:Int)3)调用Dataset的map()算子将每一个元素拆分并存入Person类中

val personDataset = d1.map(line=>{

val fields = line.split(",")

val id = fields(0).toInt

val name = fields(1)

val age = fields(2).toInt

Person(id,name,age)

})

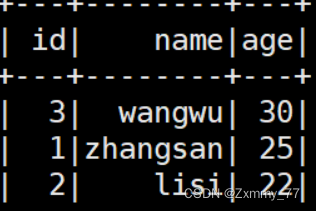

personDataset.show() # 查看personDataset中的数据内容 4)将Dataset转为DataFrame

val pdf = personDataset.toDF()5)执行SQL查询

pdf.createTempView("v_person")

val result = spark.sql("select * from v_person order by age desc")

result.show()

4.窗口(开窗)函数

开窗函数是为了既显示聚合前的数据,又显示聚合后的数据,即在每一行的最后一列添加聚合函数的结果。开窗口函数有以下功能:

-

同时具有分组和排序的功能

-

不减少原表的行数

-

开窗函数语法:

聚合类型开窗函数

sum()/count()/avg()/max()/min() OVER([PARTITION BY XXX] [ORDER BY XXX [DESC]]) 排序类型开窗函数

ROW_NUMBER() OVER([PARTITION BY XXX] [ORDER BY XXX [DESC]])5.Spark SQL整合Hive

在前面我们学习了Hive的部署及相关基础知识,这里我们需要将Spark SQL与Hive整合。Hive可以将SQL语句转化为MapReduce(或Apache Spark、Apache Tez)任务执行,大大降低了Hadoop的使用门槛,减少了开发MapReduce程序的时间成本。可以将Hive理解为一个客户端工具,它提供了一种类SQL查询语言,称为HiveQL。这使得Hive十分适合数据仓库的统计分析,能够轻松使用HiveQL开启数据仓库任务,如提取/转换/加载(ETL)、分析报告和数据分析。

1)将$HIVE_HOME/conf中的hive-site.xml文件复制到$SPARK_HOME/conf中,并添加“hive.metastore.schema.verification=false”和“datanucleus.schema.autoCreateAll=true”等属性,详细配置内容如下(可根据自己集群的情况修改相应的值):

<?xml version="1.0" encoding="UTF-8" standalone="no"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!--

Licensed to the Apache Software Foundation (ASF) under one or more

contributor license agreements. See the NOTICE file distributed with

this work for additional information regarding copyright ownership.

The ASF licenses this file to You under the Apache License, Version 2.0

(the "License"); you may not use this file except in compliance with

the License. You may obtain a copy of the License at

http://www.apache.org/licenses/LICENSE-2.0

Unless required by applicable law or agreed to in writing, software

distributed under the License is distributed on an "AS IS" BASIS,

WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

See the License for the specific language governing permissions and

limitations under the License.

-->

<configuration>

<!-- 数据库 start -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/spark_hive_meta?createDatabaseIfNotExist=true&useSSL=false</value>

<description>mysql连接</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>mysql驱动</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description>数据库使用用户名</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

<description>数据库密码</description>

</property>

<!-- 数据库 end -->

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/hive/warehouse</value>

<description>hive使用的HDFS目录</description>

</property>

<property>

<name>hive.cli.print.current.db</name>

<value>true</value>

</property>

<property>

<name>hive.support.concurrency</name>

<value>true</value>

<description>开启Hive的并发模式</description>

</property>

<property>

<name>hive.txn.manager</name>

<value>org.apache.hadoop.hive.ql.lockmgr.DbTxnManager</value>

<description>用于并发控制的锁管理器类</description>

</property>

<property>

<name>hive.server2.thrift.bind.host</name>

<value>my2308-host</value>

<description>hive开启的thriftServer地址</description>

</property>

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

<description>hive开启的thriftServer端口</description>

</property>

<property>

<name>hive.server2.enable.doAs</name>

<value>true</value>

</property>

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

<property>

<name>datanucleus.schema.autoCreateAll</name>

<value>true</value>

</property>

</configuration>2)在Spark配置文件spark-env.sh中指定Hadoop及其配置文件的主目录(根据自己的Hadoop安装目录修改)。

export HADOOP_HOME=/export/servers/hadoop-3.2.0

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop3)将MySQL驱动JAR包复制到$SPARK_HOME/jars目录中(根据自己的目录复制)。

cp /export/servers/mysql-connector-java-5.1.40/mysql-connector-java-5.1.40-bin.jar /export/servers/spark/jars6.Spark SQL操作Hive的几种方式

- 方式一:Spark SQL终端操作(以Spark Standalone模式为例)

- 方式二:Spark Shell操作

- 方式三:提交Spark SQL应用程序

658

658

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?