论文来源

ACL2020

链接

https://arxiv.org/abs/2004.10624

论文介绍

摘要: 本文提出了一种结合边缘特征和多个子图来改进关系提取的上下文化图注意网络。 提出了一种利用多个子图来学习基于图的网络中丰富的节点表示的新方法。 为此,从单个依赖树中获得多个子图。 提出了两种边缘特征,将其与GAT模型和GCN模型有效地结合起来应用于关系抽取。在SEMEVAL 2010 task 8 的数据集上取得了最高的86.3的F1值

句子的图形结构可以用依存树获取。

依存树中,单词表示节点,单词间的关系表示边, 此外,可以使用依赖解析树导出不同大小的图。亦可进行拓展,

小图:可能消除有用的信息 大图:增加噪音

为了降低从大图学习的复杂性,我们建议使用多个子图,而不是单个图。

具体来说就是从单个依赖树中提取多个子图来用作关系抽取。 使用这种分离性的结构将有助于将重点放在特定区域,有助于学习更丰富的表示形式,特别是针对目标实体对应的顶点。

模型结构:

在此研究中,我们将关系抽取任务定义为图形分类任务。

为此,每一句句子将被表示为一组子图,GK K表示该句子一共有多少子图。而许多操作是在单个子图上进行的。使用的contextualised graph attention 用于关系提取。

从图中可看到,这个模型将每一句句子以及其中所提到的实体作为模型的输入。

第一步 使用SDP和目标实体e1和e2的位置获得三个子图。(分别为1,最短依存路径 2. 与第一个实体相连接的单词 3。与第二个实体相连接的单词。)

虽然依赖解析定义了关联词之间的方向,但是忽略了获取句子的无向子图。我们分别创建一个邻接矩阵来保证顶点的有序性。

每句句子被编码成固定长度的向量,其中包括 :1.contextual 2.part-of-speech 3,依存关系(dep) 4 命名实体类型(net) 5. word type embedding (wt)

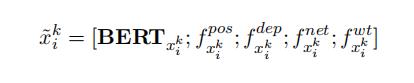

每句句子的 contextual embedding是通过对bert的最后四层进行求和得到的。 每一个单词的embedding由以下几个部分构成

1.pos tags 2. 依存关系(dep)3.命名实体类型(net)4 一个Q维的特征向量用来指示 Xi 是否是所提及的实体(wt)因此最后的输入向量可以这样看:

第二步 为了更好的微调embedding 将向量输入进 bilstm中。(好像是只输入第一部分的contextual embedding)

第三步 2017年 提出的GATs通过计算相邻顶点的attention 权重来为图中的重要顶点分配更大的权重。我们修改了gats 使得它包括了以下几种边缘特征,来 计算每个子图中导出顶点特征的attention weights

-

edge feature

包括两种,Dependency relations based edge features(DREF)和Connection type edge features (CTEF)。

DREF 基于依赖关系的频率导出。CTEF识别给定节点是否连接到图中的实体项或非实体项, 由于GCNS和GATs在无向图上操作,因此网络无法获得此类信息,提供与实体连接的顶点信息可以提高性能。 -

Graph Attention Operation

将BiLSTM层的输出与上述边缘特征作为输入提供给GAT层,以产生一组新的m维顶点表示

第四步 attention layer

GAT与边缘特征相结合的输出是vertex level输出 Z∈R n×m,其中n是节点数,m是输出特征的维数。 直观地说,每个顶点的feature 是在图中相连的顶点和边缘特征的信息聚合。

为了导出用于关系分类的最终表示,使用最后一个attention 层来确定每个顶点的贡献,并导出图gi的固定长度特征向量。

最后一层attention将权重分配给每一个顶点的注释(即上一层的输出)。

第五步,将上面attention层的输出放入一个全连接层,以获得最后的关系抽取结果。

324

324

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?