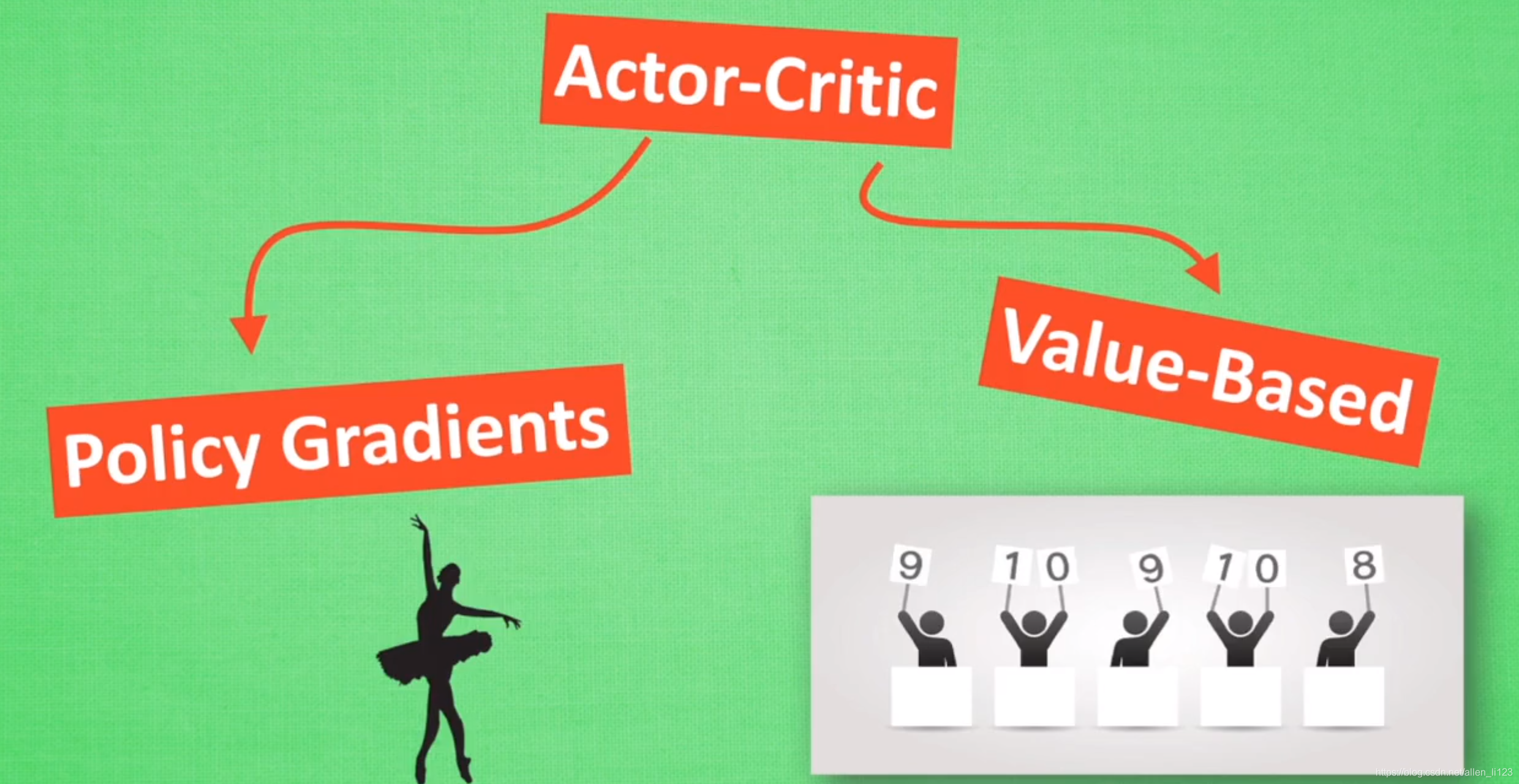

什么是Actor-Critic

Actor-Critic 的 Actor 是 Policy Gradients,因为他直接根据概率进行选择所以能够很容易选出当前最优解,而Q-learning存在 ϵ − g r e e d y \epsilon-greedy ϵ−greedy选择,不能及时选择出当前最优解.但是 Policy Gradients 容易陷入局部最优解,而且PG是回合更新,降低了学习效率。 Actor Critic 中的 Critic 是 Q-learning 或者其他的 以值为基础的学习法 , 能进行单步更新,两者结合就解决掉了彼此的缺点。

如何更新

现在我们有两套不同的体系, Actor 和 Critic, 他们都能用不同的神经网络来代替 . 现实中的奖惩会左右 Actor 的更新情况,但是Policy Gradients 是根据回合结束后的奖惩来更新. 那么如何让Actor进行单步更新呢?我们用一个 Critic 去学习这些奖惩机制, 学习完了以后. 由 Actor 来进行动作采取, 由 Critic 来告诉 Actor 这些动作哪些奖励高, 哪些奖励低, Critic 通过学习环境和奖励之间的关系, 能看到现在所处状态的潜在奖励, 所以用它来指点 Actor 便能使 Actor 每一步都在更新, 如果使用单纯的 Policy Gradients, Actor 只能等到回合结束才能开始更新.

Actor-Critic的改进

Actor-Critic 涉及到了两个神经网络, 而且每次都是在连续状态中更新参数, 每次参数更新前后都存在相关性, 导致神经网络只能片面的看待问题, 甚至导致神经网络学不到东西. Google DeepMind 为了解决这个问题, 修改了 Actor Critic 的算法。

将 DQN 网络加入进 Actor Critic 系统中, 这种新算法叫做 Deep Deterministic Policy Gradient, 成功的解决的在连续动作预测上的学不到东西问题.

代码部分

- Actor部分

动作选择:根据神经网络输出的各种概率进行选取

def choose_action(self, s):

s = s[np.newaxis, :]

probs = self.sess.run(self.acts_prob, {

self.s: s}) # get probabilities for all actions

return np.random.choice(np.arange(probs.shape[1]), p=probs.ravel()) # return a int

输入:当前状态的特征(n维向量)

输出:各种动作采取的可能性

with tf.variable_scope('Actor'):

l1 = tf.layers.dense(

inputs=self.s,

units=20, # number of hidden units

activation=tf.nn.relu,

kernel_initializer=tf.random_normal_initializer(0., .1), # weights

bias_initializer=tf.constant_initializer(0.1), # biases

name='l1'

)

self.acts_prob = tf.layers.dense(

inputs=l1,

units=n_actions, # output units

activation=tf.nn.softmax, # get action probabilities

kernel_initializer=tf.random_normal_initializer(0., .1), # weights

bias_initializer=tf.constant_initializer(0.1), # biases

name='acts_prob'

)

误差函数:

设Actor部分输出的各种动作采取的概率值为prob,根据动作选取函数选取的动作为a,Critic反馈的误差为TD_error(后面会提到),误差函数为:

− l o g ( p r o b [ a ] ) ∗ T D _ e r r o r -log(prob[a])*TD\_error −log(prob[a])∗TD_error

用TensorFlow的优化器最小化误差函数即可

with tf.variable_scope('exp_v'):

log_prob = tf.log(self.acts_prob[0, self

本文介绍了Actor-Critic算法,它结合了Policy Gradients的最优解选择与Q-learning的单步更新。通过Critic对Actor进行指导,实现每步更新,解决了Policy Gradients的局部最优和效率问题。此外,文章还探讨了Deep Deterministic Policy Gradient(DDPG)作为Actor-Critic的改进,并提供了代码示例,展示了如何在CartPole问题中应用Actor-Critic算法。

本文介绍了Actor-Critic算法,它结合了Policy Gradients的最优解选择与Q-learning的单步更新。通过Critic对Actor进行指导,实现每步更新,解决了Policy Gradients的局部最优和效率问题。此外,文章还探讨了Deep Deterministic Policy Gradient(DDPG)作为Actor-Critic的改进,并提供了代码示例,展示了如何在CartPole问题中应用Actor-Critic算法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

690

690

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?