文章目录

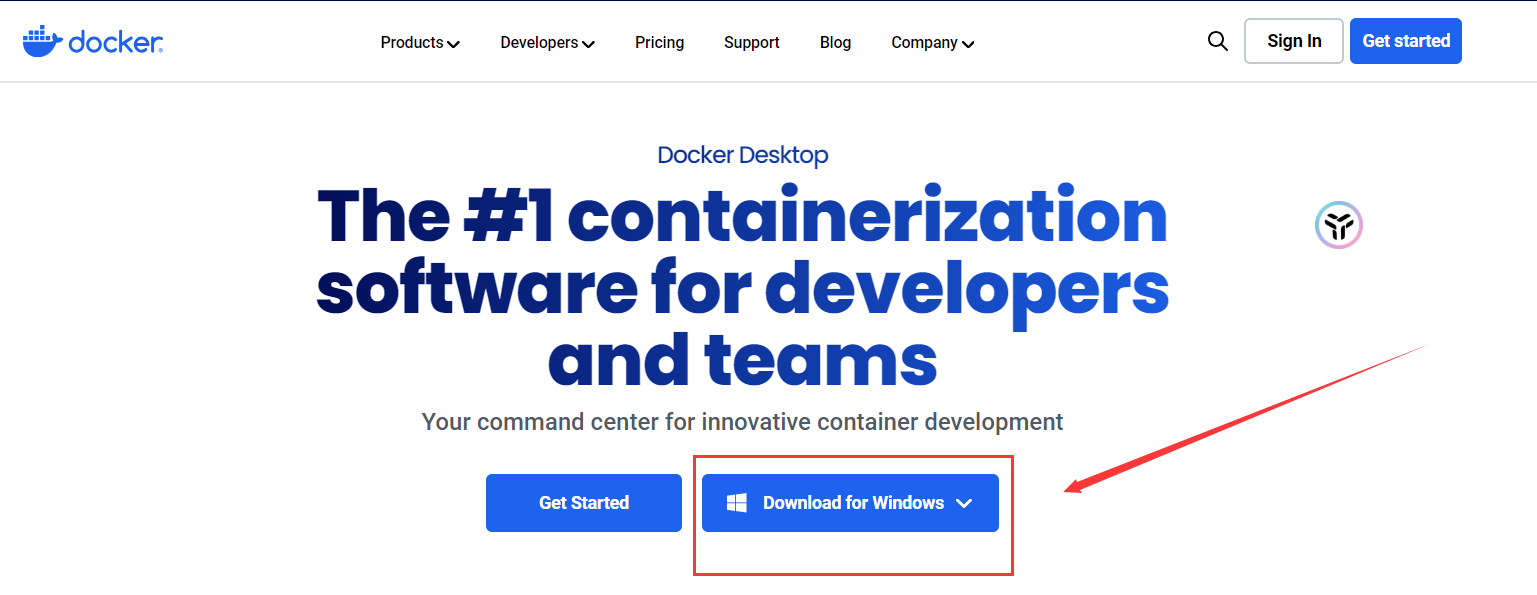

Windows下安装Docker

- 准备条件

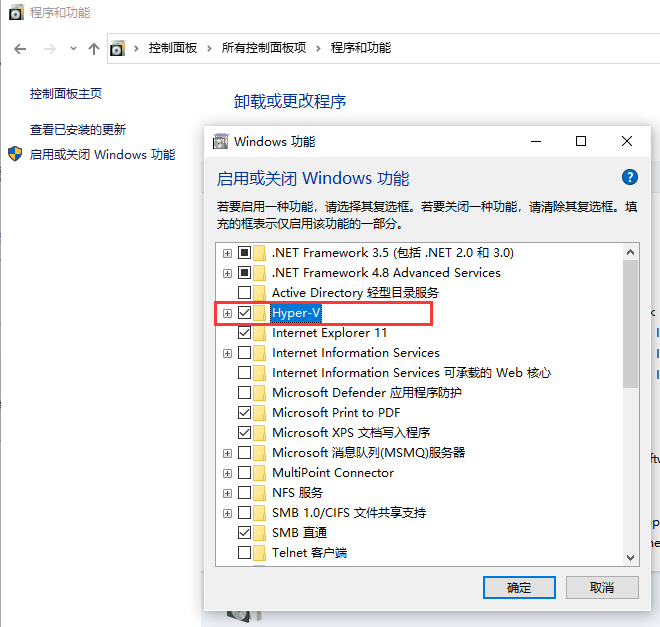

开启Hyper-V,在“启用或关闭Windows功能”里,钩选Hyper-V,然后确定

安装Docker

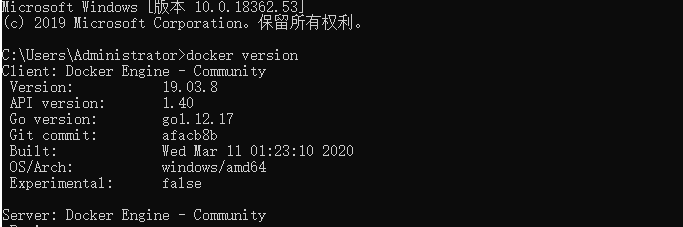

检查是否安装成功, 出现版本即为安装成功

docker version

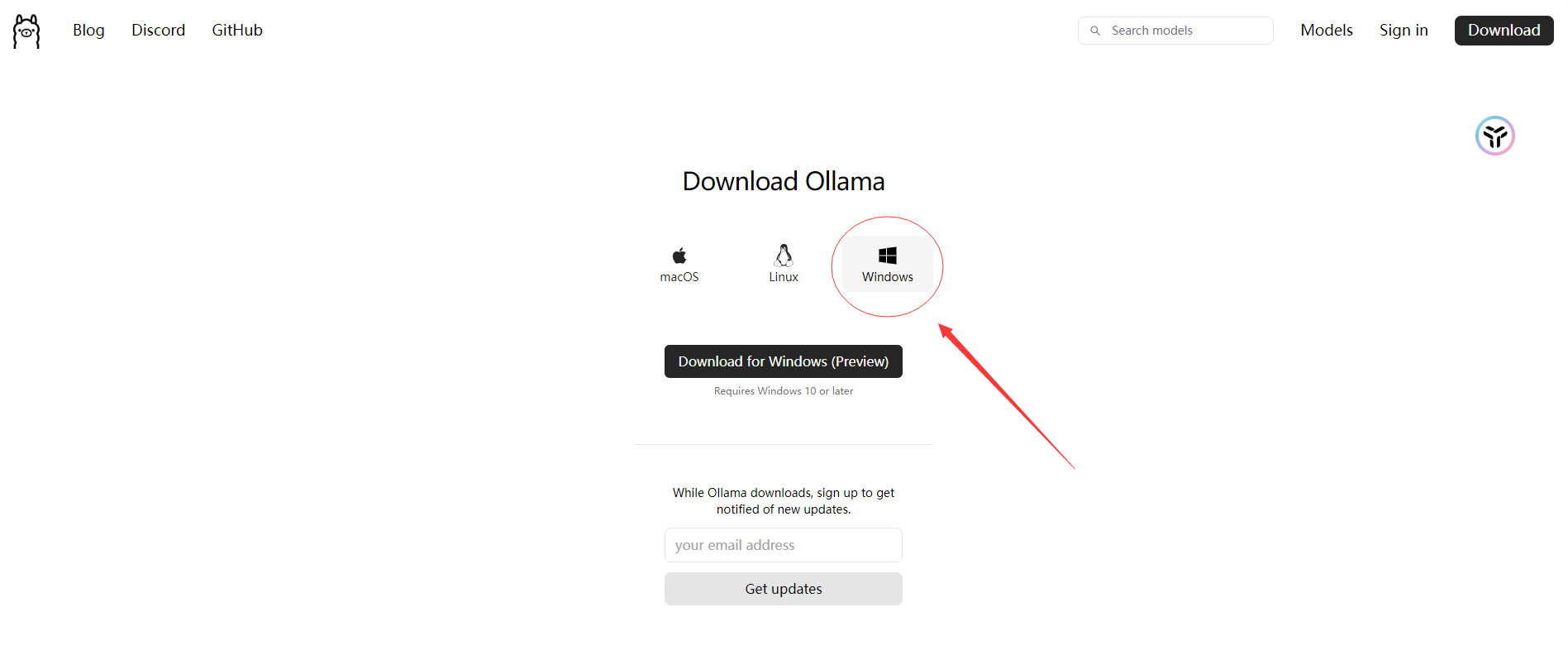

安装Ollama

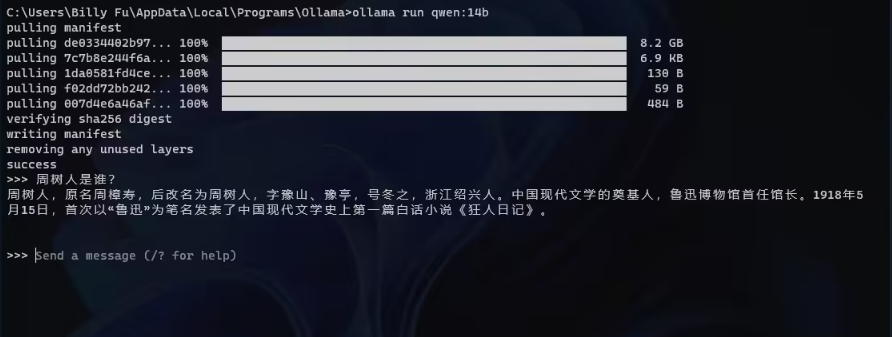

启动 Ollama 并拉取模型

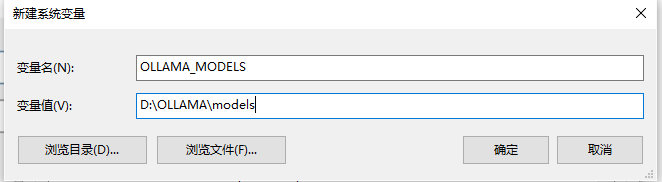

- 准备条件, 设置模型下载路径( 土豪随意~ )

WIN + R , 输入**rundll32.exe sysdm.cpl,EditEnvironmentVariables**

在系统变量里新建一个, 待会下载模型会直接下到这个路径下面, 不然默认下载C盘

**默认模型下载路径 : ****C:\Users\<username>\.ollama\models**

- 在「开始」菜单中点击 Ollama 图标,运行后会在任务栏托盘中驻留一个图标。

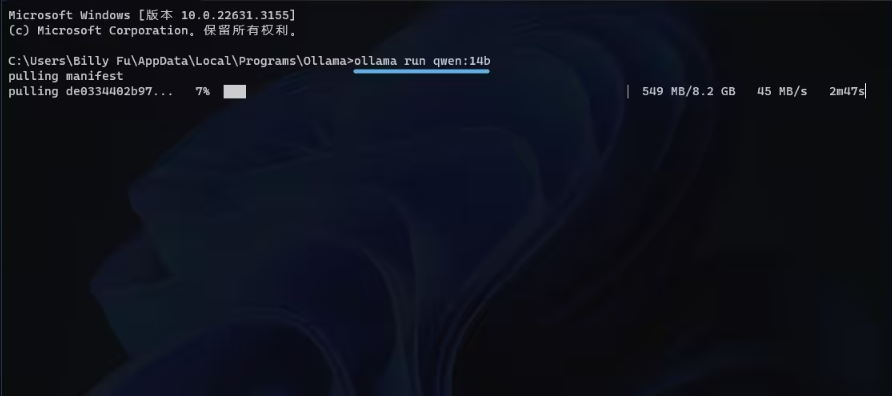

- 右键点击任务栏图标,选择「View log」打开命令行窗口, 下载模型

当然也可以安装其他的模型, 诸君随意~

运行 7B 至少需要 8GB 显存,运行 13B 至少需要 16GB 显存, 注意这里是显存不是内存!!!

内存与显存、CPU与GPU、GPU与CUDA_cpu 逻辑运算 缓存 排队 显卡 内存 知乎-CSDN博客

- 使用模型

(选做) 修改默认地址和端口

Ollama API 的默认地址是**http://localhost:11434**

使用Windows + R快捷键打开「运行」对话框,输出以下命令,

C:\Windows\system32\rundll32.exe sysdm.cpl, EditEnvironmentVariables

然后按Ctrl + Shift + Enter以管理员权限启动「环境变量」

添加以下环境变量

- 变量名:

OLLAMA_HOST - 变量值(端口):

:8000

(选做) Ollama 进行跨域配置

因浏览器安全限制,如果要调用 API ,需要为 Ollama 进行跨域配置后方可正常使用:

- 变量名:

OLLAMA_ORIGINS - 变量值:

*

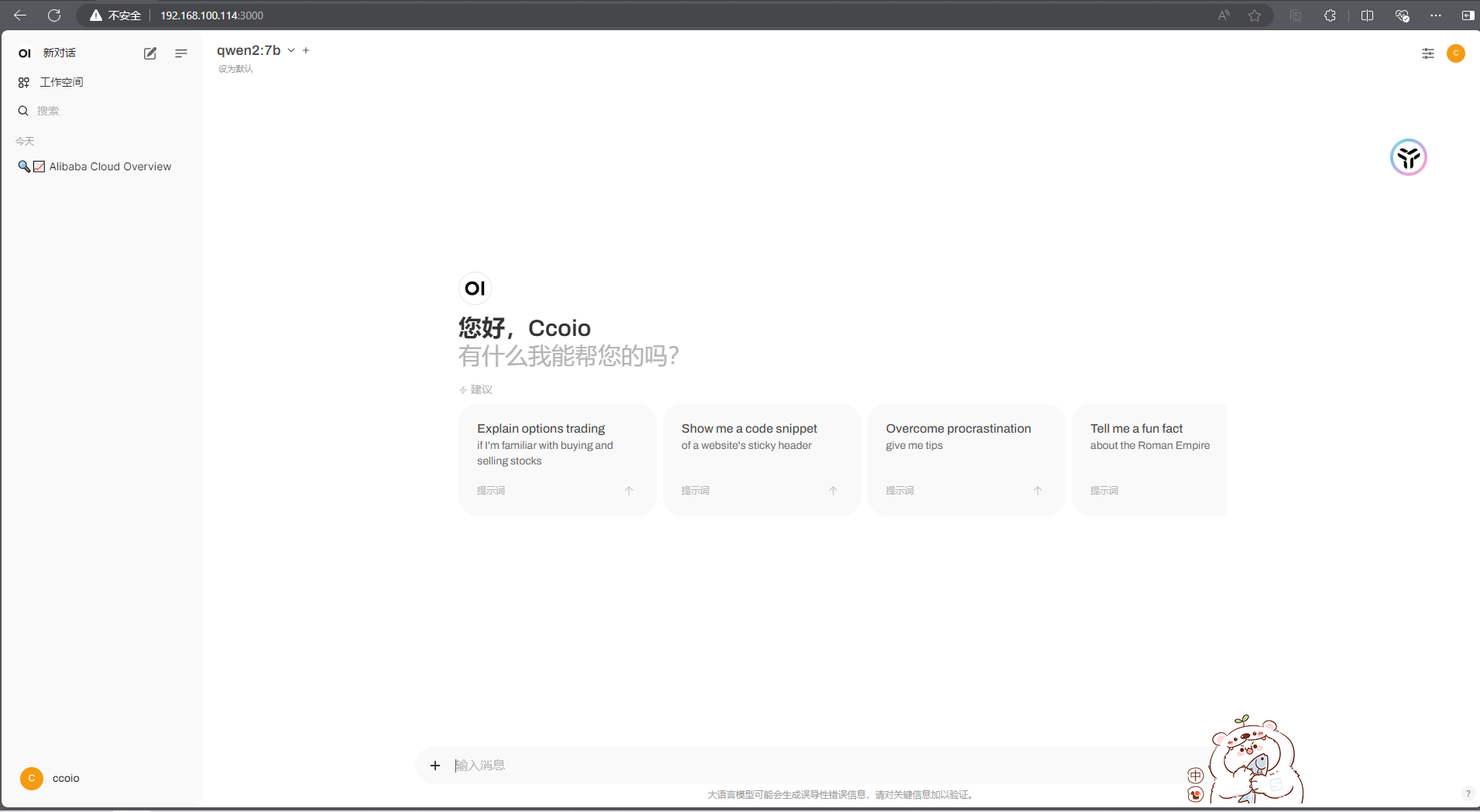

安装open-webui

安装成功效果如下

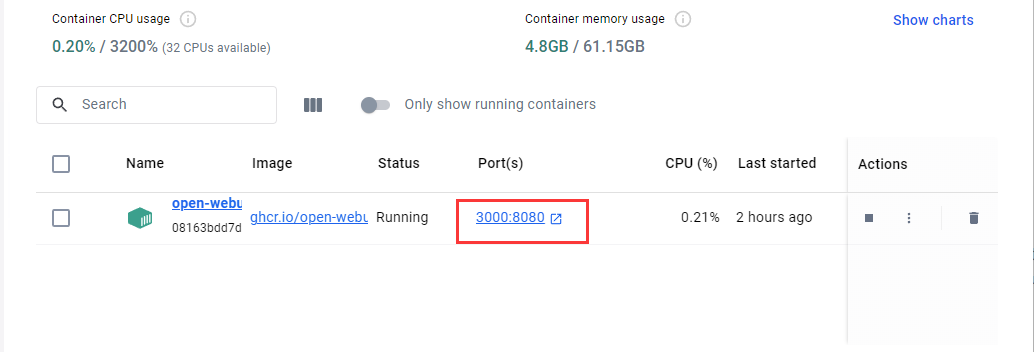

我们已经安装 Ollama , 可以直接拉取镜像就可以直接启动 open-webui 了

在cmd命令窗执行这条命令即可启动

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mai

启动成功之后的docker为这样, 点击port即可访问

第一次进入要注册账号, 第一个注册的账号即为管理员账号

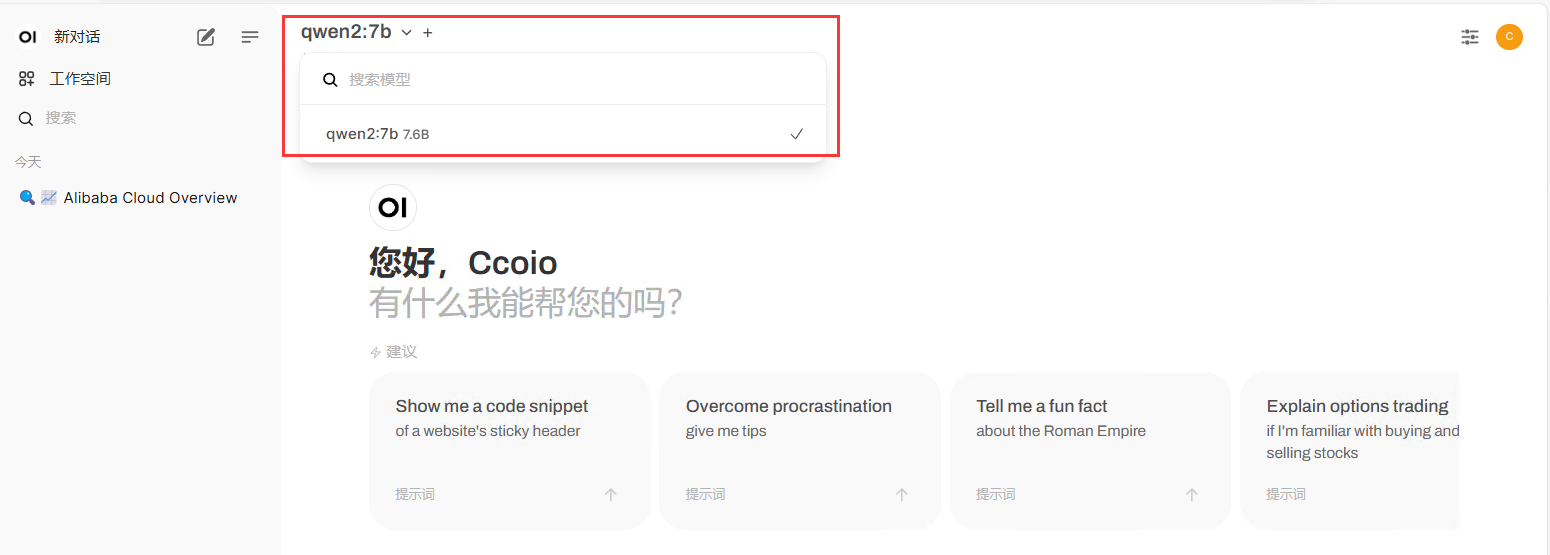

然后选择我们之前下载好的模型, 就可以愉快的玩耍啦~ ( 此时模型要在后台运行哦~ )

1652

1652

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?