AI人工智能(调包侠)速成之路十四(中国象棋AI网络机器人:AI技术综合应用实现)

I人工智能(调包侠)速成之路十五(中国象棋AI网络机器人:AI模型部署)

AI模型越来越多,软件功能也越来越丰富,客户端部署小模型应用也是当前的热门。目前还是英伟达显卡遥遥领先的情况下,模型加速首选还是TensorRT技术。

英伟达官网下载TensorRT,注意要结合硬件选择对应的CUDA和CUDNN版本。

TensorRT SDK | NVIDIA Developer

下载后解压TRT目录

trtexec.exe是一个命令行应用程序软件,能够极大的便利我们在 tensorRT 开发过程中的模型编译、精度设置、性能调优等工作。

samples\trtexec 目录下是源代码,如果有特殊需求可以自己修改编译。

代码编译工具VS

授权声明

* http://www.apache.org/licenses/LICENSE-2.0

Apache License, Version 2.0,就是你用他的东西开发出来的程序可以商用为你赚钱,而不会涉及到侵犯专利,但是你要在程序里面注明你用了apache的代码,也就是你的代码里面要带上license。

。。。。。。。。。。。。。。。

由于硬件飞速发展,TRT版本也一直在更新,向下兼容性差,经常需要重写部署代码!

参考TRT代码 trtexec命令行工具的例子。

按功能分成两个部分。 一个是模型转换。主要是ONNX转TRT。另外是做一个接口供程序调用TRT模型进行推理。不需要经常更新主程序,只需要更新接口的dll

模型转换代码主要在samples\common sampleEngines.h sampleEngines.cpp

我们可以改写并加入模型加密解密功能。

模型推理代码主要在 samples\common sampleInference.h sampleInference.cpp

我们可以提取出来自己加入到自己写的接口dll中,提供给客户端请求推理的时候使用!

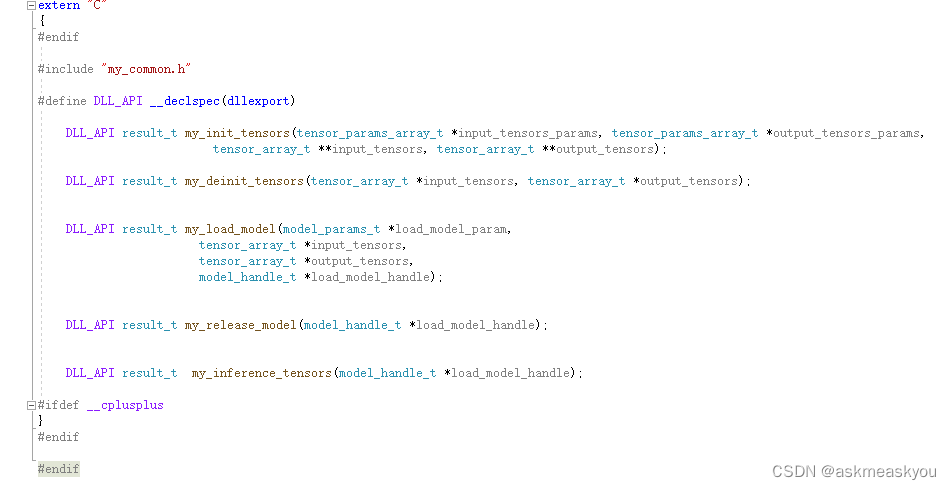

对外提供接口

模型推理代码重构

最难的代码是从TRT里面抄出来的,有了这个接口GPU编程也变成容易的事情了。

将推理功能单独做成一个dll接口,以后升级TRT的时候只需要更换适配的dll接口文件就行,跟程序逻辑独立开了。

加载模型 初始化 模型推理 释放模型

这些功能可以直接使用trtexec.exe命令行实现,如果需要加入模型动态加解密功能需要自己修改编译。另外就是INT8量化后模型精度下降的问题。

trtexec --onnx=XX.onnx --saveEngine=model.plan --int8 --workspace=4096转换FP16时精度无明显下降,但转换INT8时精度会明显下降;需要调用calibration接口进行校准。代码实现网上也有介绍。

www.xqcd.top 自己做了一个案例,小模型快速推理应用实现。

本文讲述了如何在中国象棋AI网络机器人项目中应用AI技术,重点介绍了TensorRT在模型部署中的关键作用,包括模型转换(ONNX转TRT)、推理接口开发、以及INT8量化带来的精度问题及其解决方案。

本文讲述了如何在中国象棋AI网络机器人项目中应用AI技术,重点介绍了TensorRT在模型部署中的关键作用,包括模型转换(ONNX转TRT)、推理接口开发、以及INT8量化带来的精度问题及其解决方案。

550

550

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?