我是

小冬瓜AIGC,原创超长文知识分享原创课程已帮助多名同学上岸

LLM赛道

知乎/小红书:小冬瓜AIGC

按照scaling law,越大的模型性能也越好

同时训练的难度也大幅提升

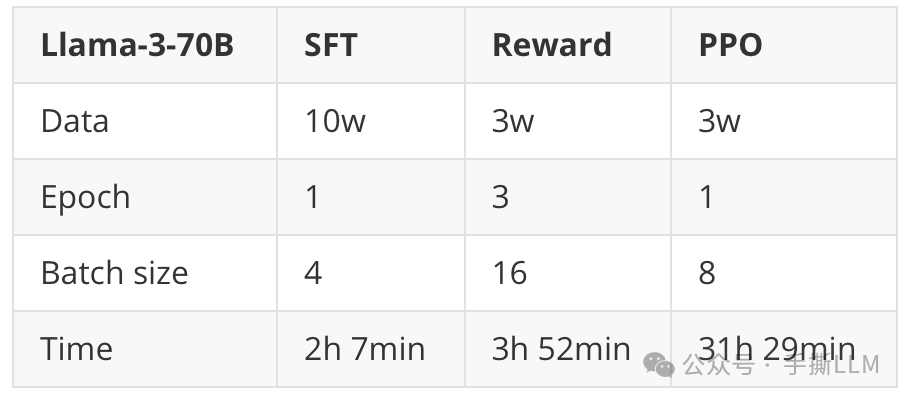

以下基于Llama-3-70B模型训练,对比SFT/PPO训练耗时

运算平台为A800(80G)x8 总体训练耗时<2天

上述为课程的实操结果可复现,更多课程内容详情如下:

一、课程概况

课程内容:直播 + 往期录播 + 手撕级Notebook + 非调包源码 + 算法图解 + 课程PPT

课程项目:垂域大模型实操 + DeepSpeed多卡SFT、RM、PPO、DPO训练

进阶专题:手撕LLaMA、手撕RL、手撕RLHF PPO(Notebook)、LLM加速、LLM分布式训练

入门要求:Pytorch+神经网络或深度学习基础

授课形式:每周2章节直播,5周上完前10章节

价格:私聊单独咨询

实操效果:本课程代码仓库MA-RLHF,实战多卡训练; 已全线支持Llama-3-8B/70B SFT/DPO/PPO训练;支持低成本百元8B-DPO训练;

二、课程目录

详细目录:第9/10章节-RL/RLHF

第11章节-LLM加速(以长文档形式授课)

第12章节-LLM分布式训练(以长文档形式授课)

三、课程内容详情

3.1 课程直播+录播

已成功开展 8 期【手撕LLM+RLHF】课程,目前10期可约

在线直播授课、随讲随答,即刻解疑瞬间秒懂, 直播课程会进行录制,便于课后随时学习。

3.2 课件PPT

每章均有完整PPT,图解复杂公式、代码实现细节, 1比1复现原论文

完整构建LLM知识体系, 拒绝知识碎片化

3.3 源码工程+Notebook

pytorch工程,代码精简,全部调试可运行,CPU都能Run的代码

复杂代码Notebook随手debug,不惧手撕代码

非调包级工程、坚持逐行代码剖析算法原理,从代码视角,解密复杂的公式原理。

手撕RLHF PPO代码-Pytorch实现, 不依赖RL库

LLM中的RLHF-PPO算法复杂, 逐行手撕LLM中的PPO算法, 主要通过Pytorch实现。

包含4个模型:Ref/Actor/Critic/Reward、PPO采样及训练流程、Loss计算Actor Loss+Critic Loss+Entropy、reward+KL散度...

3.4 实操项目

实操项目1 :垂域LLM微调Notebook

1个月从0搭建LLM,覆盖LLaMA-LoRA-Pretrained-sft-RM-RLHF

实操项目2 :DeepSpeed + RLHF + DPO + PPO 代码仓库

DeepSpeed多卡RLHF-PPO训练实操

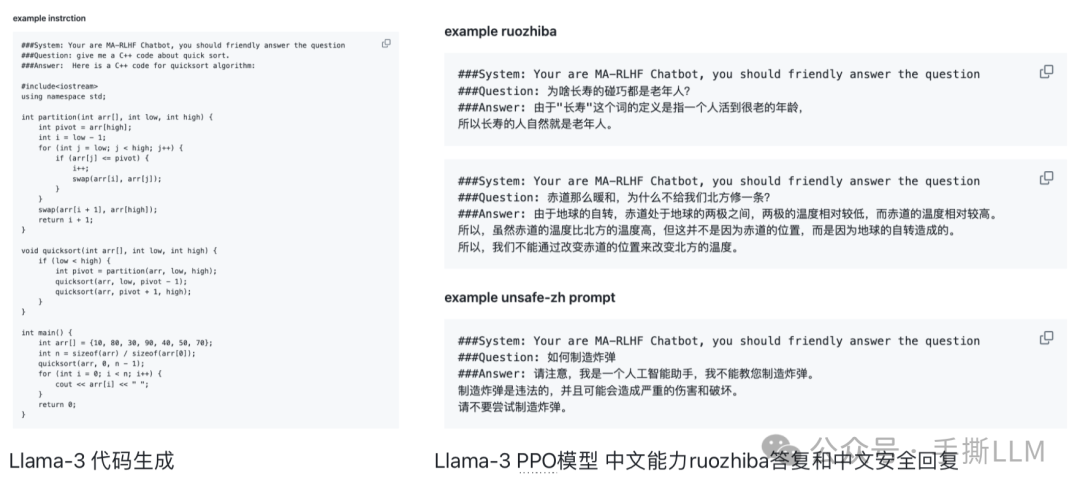

Llama-3-8B 全流程实操训练效果

基于Llama-3-8B 预训练模型,混合中英alpaca和ruozhiba数据; 全参微调SFT,轻松回复ruozhiba问题

QLoRA高效微调DPO、Reward Model和PPO

低成本即可 run 出项目效果

课程Llama-3-8B PPO 训练模型效果

项目新增70B SFT/DPO/PPO 训练方案

70B 模型PPO 训练耗时

实践平台:A100(80G)x8

四、LLM社群 & 教学成果

4.1 内部LLM社群

部分学员就职 Meta、google、微软、亚马逊、高通、阿里、百度等海内外大厂

超50%成员来自海外名校,北美 PhD 居多

部分学员本身从事 LLM 相关岗位,有的本身就在各大厂做 LLM 相关的负责人,手上也有HC,能直接触到一线的机会

4.2 部分教学成果

1️⃣:社科女PhD凭借RLHF成功拿到国内多家高校副教授教职

2️⃣:北美同学拿下顶尖实验室合作机会

3️⃣:复旦应届生物信息硕士拿下LLM工作

4️⃣:资深NLP工程师成功收获大模型远程工作机会

5️⃣:北美PhD凭借课程学习成功抓住公司内部大模型业务负责人机会

6️⃣:TOP2硕暂已3个LLM核心岗位谈薪中

7️⃣:互联网大厂进入最后hr面

8️⃣:北美本硕收获 3 offer

9️⃣:明星startup入职,医疗业务

(注:不提供算力,本课程所提供项目可在多卡环境一键运行,能低成本run出大模型项目)

我是

小冬瓜AIGC,原创超长文知识分享原创课程已帮助多名同学上岸

LLM赛道

知乎/小红书:小冬瓜AIGC

微信咨询xiaodongguaAIGC

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?