转载自:https://blog.csdn.net/u010122780/article/details/88367821

论文题目:《深度投票:一种用于在部分遮挡情况下稳定且可解释的部分语义检测的深度网络》

摘要:在这篇论文中,我们研究了检测一个物体的语义部分的任务,比如一个被遮挡了一部分的汽车轮胎。我们认为所有的模型都应该在物体没有被遮挡的情况下进行训练,这样才能使模型学习到的knowledge应用于遮挡。这种设置减轻了收集指数级带有遮挡情况的大数据集的困难,从这个角度来看,这种设置也是很有必要的。基于此,已经提出的深度网络,比如RCNN系列,并不能产生让人满意的结果,因为RCNN系列网络在特征提取阶段还有分类阶段都有可能被不相关的遮挡物混淆。为了解决这个问题,文章【25】提出了一种投票机制,该机制结合多尺度局部视觉线索来检测语义部分,这些语义信息在由于被遮挡而丢失了一些视觉线索的情况下仍然能够被检测到。但是,这种机制是手工设计的,很难以端到端的形式进行优化。

在这篇论文中,我们提出了一种深度投票机制,这种深度投票机制将文章【25】所提出的投票机制的鲁棒性结合到深度网络中,从而可以对整个流程进行联合优化。具体来说,它在深度网络的中间特征之后增加了两层,例如VGGNet的pool-4层。第一层提取局部视觉信息,第二层利用视觉线索与语义部分之间的空间关系进行投票。我们还通过从对象外部的上下文中学习视觉线索来提出改进版本的DeepVoting+。实验结果表示,深度投票机制在遮挡情况下的部分语义检测性能比包括RCNN等几种baseline method的性能提高了很多。此外,由于检测结果可以通过查找投票线索进行诊断,因此DeepVoting具有可解释性。

1 引言:深度网络已成功地应用于各种视觉任务,特别是目标检测【7,20,19,13,29】。近年来,目标检测有一系列已经提出的方法【7,20】,这些方法首先为图像生成一些object proposal,然后通过分类器预测每个proposal的对象得分。然而,尽管语义部分检测很重要,但它的研究却很少。语义部分是一个具有语义信息、可以口头描述的对象的一部分,如汽车的轮子或火车的烟囱。检测语义部分是一种人类的能力,它使我们能够更精细地识别或分析一个对象。

在现实世界中,一个对象的语义部分经常被遮挡,这使得检测变得更加困难。在本文中,我们研究了语义部分检测,特别是当这些语义部分被部分或完全遮挡时。我们使用与文章【25】中相同的数据集,也就是the VehicleSemanticPart dataset and the VehicleOcclusion dataset。一些典型的语义部分示例如图一所示,需要注意的是,the VehicleOcclusion dataset是一个合成的遮挡数据集,其中目标对象随机地与两个、三个或四个不相关的对象(称为遮挡物)重叠,并且目标对象的遮挡比例受到约束。据我们所知,the VehicleOcclusion dataset是唯一一个公开的遮挡数据集,它提供语义部分的准确遮挡注释,如遮挡率和遮挡物的数量。这使我们能够在不同的遮挡程度下评估不同的方法。

图一:the VehicleSemanticPart dataset中六类刚性对象的典型语义部分,一些语义部分(比如车轮)可能出现在不同的目标类别中,但是有的部分(火车烟囱)只出现在一类中(火车)

处理遮挡的一个直观的解决方案是在包含不同遮挡情况的数据集上训练模型。然而,收集一个包含不同数量、外观和位置的遮挡情况的数据集是非常困难的,而且计算起来也很难。为了解决这个问题,我们提出了一个更重要的解决方案,那就是只在无遮挡图像上训练检测器,但允许学习到的knowledge(比如语义部分之间的空间关系)从非遮挡图像传输到遮挡图像。这促使我们设计出对遮挡具有鲁棒性的模型。目前相关的研究工作就是文章【25】所提出的,作者指出,目前的深度网络模型对遮挡的鲁棒性没有那么好,并提出一种投票机制,根据目标的多尺度视觉线索计算遮挡的情况,并根据物体的几何约束(也就是视觉线索和目标语义部分的空间关系)定位出语义部分。然而,这种手动设计的框架被分解为几个阶段,因此很难以端到端的方式对其进行优化。这促使我们想要了解文章【25】中所展示的鲁棒性是否可以融入深度网络中,从而使端到端的培训成为可能。

最后,我们提出了DeepVoting,一个端到端的框架,用于部分遮挡下的语义部分检测。确切地说,我们在深度神经网络的中间特征之后加了两个卷积层,例如,VGGNet中pool-4层的神经响应。第一个卷积层执行模板匹配,并输出名为“视觉概念”的局部视觉信息,这些局部视觉信息能够检测语义部分【26】。卷积层之后是ReLU激活层和dropout层,激活层设置了一个筛选匹配模式的阈值,dropout层的作用是丢弃某些无用的信息。然后,利用视觉线索与语义部分的空间关系,增加第二卷积层,实现投票机制。空间/几何关系存储到卷积权重中,并显示为空间热图。视觉概念和空间热图既可以只在前景物体上学习,也可以在有上下文的整个图像上学习。我们首先按照文章【25】的要求对前景对象进行训练,只需裁剪对象边界框。我们进一步证明,视觉概念和空间热图也可以利用上下文信息,利用整个图像训练我们自己的模型,我们把他成为改进版,即DeepVoting+。

在我们的实验中,我们同时研究了DeepVoting和DeepVoting+。第一个版本,在排除上下文的情况下,在相同的设置下,显著优于文章【25】提出的方法,可以说是因为端到端的培训方式为联合优化提供了一种更强大的方法。第二个版本结合上下文提示,更适合训练数据,从而产生更高的检测精度。与最好的目标检测器相比,比如Faster-RCNN,DeepVoting模型有更好的优势,而且随着遮挡级别的提高,优势变得更加明显。DeepVoting除了对遮挡有很好的鲁棒性之外,还有两个额外的好处:(i)DeepVoting模型的模型复杂度较低,即参数个数小一个数量级,平均测试速度快2.5倍;(ii)DeepVoting提供了通过寻找投票机制来解释检测结果的可能性。

2 相关工作:深卷积神经网络已成功地应用于各种计算机视觉问题,比如图像识别【11,21,23,9】,语义分割【14,2,30】,目标检测【7,20,19,13,29】等等。对于目标检测,最流行的方法【7,20】之一,就是首先提取多个名为object proposals【1,24,12,20】的region,然后确定这些region是否属于目标类。之后再进行Bounding Box回归和非极大值抑制。该框架显著优于基于可变形零件的模型,该模型是在一组手工制作的特征之上训练的。

还有一些研究工作使用语义部分来辅助目标检测,图形模型用于将零件组装成一个对象。此外,部件可用于细粒度对象识别【27,28】,作为辅助提示来理解分类【10】,或被训练用来做动作和属性的分类【8】。此外,文章【17】还研究了图像理解中语义部分在视觉上不同类的大目标集之间的可传递性。

在遮挡条件下检测语义部分是一个重要的问题,但以前研究较少。文章【25】通过几何约束的多视觉概念,也就是关于目标语义部分的视觉概念的空间属性,来得到一个鲁棒的检测器。和文章【25】不同,DeepVoting将视觉概念提取和几何关系作为两层来实现,并将它们直接连接到深度神经网络的中间输出,以执行端到端的训练。与[25]相比,这会产生更好的性能。

3 DeepVoting框架

3.1 Motivation

我们的目标是检测被遮挡物体的语义部分。首先,我们认为在训练阶段只能使用无遮挡图像。这是因为遮挡物的外观和位置可以是任意的,因此几乎不可能通过有限的训练集覆盖所有遮挡物。我们的目标是设计一个框架,将学习到的知识从无遮挡领域转移到遮挡领域。

一种可能的解决方案是采用最先进的目标检测方法,例如Faster-RCNN【20】,用来检测语义部分。具体地说,修改后的方法首先提取一些语义部分的proposals,然后计算每个proposal的分类分数。但是,我们指出,由于两个重要因素,这种策略可能会遗漏一些部分或完全被遮挡的语义部分:(1)遮挡可能会分散生成proposal的网络对语义部分提取好的proposal的注意力;(2)即使提取了正确的proposal,分类器仍然可能出现错误,因为被遮挡的语义部分的apperence已经完全不同了。我们在第4.3节中验证了这些因素确实降低了Faster-RCNN的性能。

文章【25】的投票机制提出了一种替代策略,这种策略积累了中级视觉线索来检测高级语义部分。这些中级线索称为视觉概念【26】,即一组与语义部分密切相关的中间CNN模块。语义部分由多个视觉概念通过它们之间的几何约束来支持。即使某些视觉概念的证据由于遮挡而丢失,仍有可能通过其余的证据来推断语义部分的存在。然而,它涉及的超参数太多,因此难以优化。

在本文中,我们提出了将文章【25】所示的鲁棒性结合到深度网络中的去DeepVoting。继文章【26】之后,当对象以固定的比例出现时,将学习视觉概念,因为中间层上的每个神经元(例pool-4层)具有固定的接收场域大小【21】。因此,我们假设目标的scale在训练和测试阶段都大致相同,在训练阶段,我们使用Ground-Truth的BoundingBox来resize目标,计算目标与图像的比率以训练一个独立的网络ScalenNet【18】,用于尺度预测。在测试阶段,利用训练后的ScaleNet对测试图像进行大小预测,然后根据预测的大小调整测试图像的大小。

3.2 Formulation

设代表大小为

的图像,根据文章【25】,我们将这张图片输入到一个16层的VGGNet,并且提取

特征作为中间神经网络的输出,假设 layer的输出

为

,或者是

的cube,其中

和

分别是

和

下采样的scale,

的大小为512,这些特征可以被理解为

的高维向量,每一个特征表示了一个局部区域的appearence,假设每一个

维的特征向量为

,

表示

的index。这些特征向量是

,所以

。

3.2.1 Visual Concept Extraction

文章【25】中,视觉概念通过k-均值聚类得到一组可视化概念,并将每个可视化概念直观地视为从这些中间输出中获取中级语义的模板。具体的说,视觉概念

在

特征向量

的响应是通过

来确定的,也就是

。

具有单位长度,所以

因为它是由相邻的

平均化得来的。所以我们有

,其中

为点乘操作。然后采用对数似然比检验来消除负响应。这是由于视觉概念的存在可以为语义部分的存在提供积极的线索,但视觉概念的缺失不应给出相反的信息。

与文章【25】不同,DeepVoting将该模块实现为一个卷积层,即视觉概念层,并在深度神经网络的标准化中间输出之后直接附加。卷积层的kenal为,也就是说,每一个

被单独考虑。ReLU激活层【16】随后将负响应设置为0,从而避免它们提供负面线索。我们附加了一个drop ratio为0.5的dropout层【22】,以便在训练过程中丢弃视觉概念响应的随机子集。此策略有助于模型使用不完整的信息进行可靠的检测,从而提高遮挡情况下的检测精度。

视觉概念层的输出是一个大小为的图

,其中

为视觉概念的集合,我们将

设置为256,如果设置的越大,可能会有更好的效果。尽管这些视觉概念是从头开始训练的,而不是从聚类中获得的【26】,但我们在第4.4节中展示了它们还能够捕获可重复的视觉模式和语义意义。

3.2.2 Semantic Part Detection via the Voting Layer

经过上一阶段,我们可以找到一些被激发的视觉概念,即那些具有正响应值的位置。在文章【25】中,被激发的视觉概念是通过对数似然比测试确定的。然后,通过考虑每对视觉概念和语义部分之间的空间约束,将这些激发的视觉概念聚集在一起进行语义部分检测。一个视觉概念至少可以微弱地暗示一个语义部分的存在。例如,如图二所示,在汽车图像中,找到前照灯意味着附近有一个车轮,在固定比例下,前照灯到车轮的距离和方向大致相同。

与文章【25】不同,DeepVoting将视觉概念和语义部分之间的空间约束作为另一个卷积层,称为投票层,其中我们将每个卷积内核的接收字段设置为尽可能的大,例如15×15,这样一个视觉概念就可以在相对较长的距离上投票支持语义部分。当物体被部分遮挡时,这种策略尤其有帮助,因为有效的视觉信号经常出现在遮挡物之外,并且可能远离目标。

虽然空间约束是从零开始学习的,在训练过程中只实施语义部分级的监督,但它们仍然可以代表视觉概念在不同相对位置出现的频率。我们将这一层的每个学习的卷积核称为空间热图,其中一些热图在第4.4节中进行了可视化。

设投票层的输出,也就是语义部分map,为,它是一个大小为

的cube,

为语义部分的集合。语义部分图上的每个局部最大值根据其接收域对应于图像格上的一个区域。为了生成语义部分检测的边界框,我们首先设置一个 anchor box,大小为100×100,以该区域为中心,然后学习空间重缩放和翻译,从训练数据中回归anchor box(遵循【7】中相同的回归过程)。锚尺寸100×100是整个训练数据集的平均语义部分比例【25】。

3.3 Training and Testing

我们在一个无遮挡的图像语料库上训练网络,这有助于我们在视觉概念和语义部分之间获得清晰的关系。我们通过根据ground-truth Bounding box裁剪对象来丢弃背景区域,以符合文章【25】。然后,我们重新缩放裁剪后的图像,使对象的短边具有224个像素,这是由根据文章【26】来确定的,以固定比例捕获视觉概念。将图像输入到16层VGGNet中,得到pool-4层的特征向量。

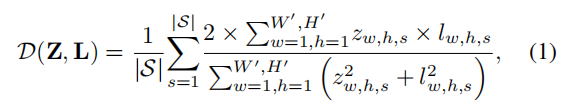

这些特征向量被规范化,并通过两层网络进行视觉概念提取和投票。通过计算预测与ground-truth之间的骰子系数,将输出语义部分映射Z与地面真值注释L进行比较【15】。为了产生地面真值,我们根据每个标注语义部分的中心像素,在网格(从原始图像中按16因子向下采样)处找到最近的网格点,并将这些位置的标签设置为1,其他位置的标签设置为0。然后对二元ground-truth标注应用高斯滤波,生成平滑地面真值标注

,标签cube

的大小也为

。

和

之间的相似性定义为:

可以很容易的根据损失函数计算出梯度。

在测试阶段,我们首先使用ScaleNet(见第3.4节)获得目标尺度。然后,我们重新缩放图像,使对象的短边大约包含224个像素。我们不裁剪目标,因为我们不知道它的位置。然后,图像通过VGGNet,再经过视觉概念提取和投票层,最后我们将空间缩放和翻译应用到anchor box(100×100),以实现更精确的定位。执行标准非极大值抑制以最终确定检测结果。

DeepVoting针对对象边界框裁剪的图像进行训练,使其与【25】一致。此外,视觉概念和空间热图也可以利用目标边界框之外的上下文。为了验证这一点,我们训练了一个改进的版本,名为DeepVoting+,不裁剪边界框。我们还调整图像的大小,使目标的短边在训练阶段包含224个像素,测试阶段与DeepVoting相同。实验结果表明,DeepVoting+比DeepVoting具有更好的性能。

3.4 The Scale Prediction Network

上述框架基于一个重要的假设,即目标以大致相同的比例出现。这是由于两个原因。首先,如【26】所示,当目标重新缩放到相同的比例时,即目标边界框的短边包含224个像素,视觉概念就会出现。第二,我们期望投票层学习固定的空间偏移,它将视觉概念与语义部分联系起来。例如,heatmap提供了这样的知识:在汽车的侧视图中,前照灯通常出现在车轮的左上角方向,X和Y轴上的空间偏移分别约为64和48像素(4和3在pool-4网格上)。这样的信息不是尺度不变的。

为了解决这些问题,我们引入了一个单独的网络,即ScaleNet【18】,来预测每个图像中的目标比例。主要思想是将输入图像馈送到16层VGGNet以执行回归任务(fc-8层替换为一维输出),标签为ground-truth目标大小。每个输入图像都会重新缩放,因此长边包含224个像素。它被放置在224×224平方的中心,剩余的像素被平均强度填满。在训练过程中,我们考虑了物体的短边,并要求深度网络预测物体短边与图像长边(224像素)的比值。在测试阶段,在同一流程图中准备图像并将其输入网络,并使用预测比率将对象规范化为所需大小,即其短边包含224个像素。我们在第4.2.1节中表明,这种方法非常有效。

3.5 Discussions and Relationship to Other Works

DeepVoting的总体框架与传统的proposal-based检测方法有很大的不同,例如Fater-RCNN【20】。这主要是由于问题设置,即当存在遮挡时,建议网络和分类网络的精度都会降低。然而,DeepVoting可以通过收集那些非封闭的视觉线索来推断封闭的语义部分。我们在第4.3节中展示了更多的比较实验。

我们将语义部分检测分解为两个步骤,即中心像素检测和bounding box回归。第一步的执行与语义分割【14】类似,是在非常低的分辨率设置下(从原始图像中按16的系数进行采样)。我们还借鉴了分段【15】的思想,分段使用了与优化中的骰子系数相关的损失函数。由于语义部分通常比整个图像小得多,因此该策略可以减轻数据不平衡的偏差,即模型更可能预测每个像素作为背景,因为它在训练数据中占主导地位。

4 Experiments

4.1 Dataset and Baseline

我们使用VehicleSemanticPart dataset和VehicleOcclusion dataset【25】进行评估。车辆管理部分数据集包含4549个培训图像和4507个测试图像,涵盖六种类型的车辆,即飞机、自行车、公共汽车、汽车、摩托车和火车。共注释133个语义部分。对于车辆零部件数据集中的每个测试图像,将一些随机定位的遮挡物(与目标对象无关)放置到目标对象上,并确保目标对象的遮挡比受到约束。图3显示了几个具有不同遮挡级别的示例。

我们训练六个模型,每个模型对应一个目标类。所有模型都是在一个无遮挡数据集上训练的,但是在非遮挡图像或添加了不同遮挡级别的图像上进行评估。在后面的例子中,我们通过遮挡目标的不同部分来改变难度级别。我们按照流行的标准【5】评估所有竞争对手,该标准根据检测到的语义部分列表计算平均精度。当且仅当被检测区域的box的IOU率不低于0.5时,被检测的box才被视为true-positive。每个语义部分单独评估,每个对象类的映射是所有语义部分的平均映射。

Deepvoting和Deepvoting+(分别用DV和DV+表示,第3.3节)与四种baseline进行比较:

• KVC:这些视觉概念是使用k-means【26】从一组pool-4聚类而成的。scalenet(详见第3.4节)用于解决尺度问题,提取的视觉概念直接用于检测语义部分。

• DVC: 这些视觉概念是从DeepVoting获得的,即视觉概念提取层的权重。scalenet(详见第3.4节)用于解决尺度问题,提取的视觉概念直接用于检测语义部分。

• VT: 投票方法首先通过对数似然比测试找到被激发的视觉概念,然后利用空间约束将这些局部视觉线索组合起来。

• FR: 我们为每个catogery单独训练模型。一个catogery的每个语义部分在训练过程中都被视为一个单独的类,也就是说,对于每个catogery,我们用类训练一个模型,对应

个语义部分部分和背景。与其他baseline不同,Faster-RCNN在完整图像上进行训练,也就是说不需要对图像裁剪。这使得RCNN能够更快地使用上下文进行语义部件检测,并自然地处理尺度问题,因为在训练中使用了不同尺度的语义部分。

4.2 Semantic Part Detection without Occlusion

作为一个简单的任务,我们评估了我们的算法在检测没有遮挡情况下的目标的语义部分。这也是以后比较的基准。在表一的左六列中,我们列出了不同方法产生的检测精度。无论视觉概念是从k-均值聚类还是从DeepVoting获得,Voting和DeepVoting的平均检测精度都明显高于单一视觉概念的检测精度。这表明了聚集多个视觉线索进行检测的方法的优势。同时,由于规模预测和端到端的培训方式较好,DeepVoting比Voting要好得多。即使提供了正确的投票比例(Oracle比例结果在[25]中),在6个目标的平均精度图上,DeepVoting仍然超过20%,这表明视觉概念提取层和投票层的权重联合优化带来的好处。

另一方面,与Faster-RCNN相比,Deepvoting的检测精度稍低。我们认为,Faster-RCNN得益于对象边界框之外的上下文,正如我们所看到的,如果我们在训练期间通过添加上下文(即DeepVoting+)来改进DeepVoting,那么与我们的方法相比,Faster-RCNN将不具有竞争力。同时,DeepVoting的计算开销较低,即运行速度快2.5倍。

4.2.1 Scale Prediction Accuracy

我们研究了ScaleNet的精度,这对于尺度归一化是非常重要的。对于每个测试图像,我们计算预测的目标尺度与实际尺度的比值,并在图四中绘制该比例对整个测试集的贡献。可以看出,在75%以上的情况下,预测尺度的相对误差不超过10%。事实上,这些预测结果对DeepVoting来说是足够准确的。即使提供了ground-truth,并对图像进行了相应的缩放,检测精度也略有提高,从72.0%提高到74.5%。

4.3 Semantic Part Detection under Occlusion

当目标被分为三个不同的遮挡层次时,我们进一步检测语义部分。由于baseline KVC和DVC的性能在没有遮挡的情况下比其他方法差得多,因此我们在检测遮挡情况下的语义部分时忽略了这两种方法。在L1阶段,我们在每个目标上放置2个遮挡物,并且以像素计算目标的这档比例,满足

。对于L2和L3阶段,我们有3个和4个遮挡物,分别为

和

(示例见图3)。原始的无遮挡测试集表示为L0。检测结果汇总在表1中。可以看出,在这些情况下,DeepVoting优于Voting和Faster-RCNN。对于Faster-RCNN,精度增益随着遮挡级别的升高而增加,这表明在检测遮挡语义部分时,DeepVoting的优势。这也从侧面说明了我们研究了空间热图(投票层的核心)大小的影响。在最重的阻塞级别,当我们将默认值15×15缩小到11×11时,平均检测精度从31.6%下降到30.6%,这表明远程投票在检测阻塞语义部分中的有用性。当内核大小提高到19×19,精度略有提高到31.8%。因此,为了降低模型的复杂性,我们将内核大小保持为15×15。

为了验证Faster-RCNN在proposal network和分类器中性能下降,我们研究了proposal的recall和分类器的精度,结果如表二所示,首先,我们可以看到,随着遮挡级别的提高,proposal的recall会显著下降,因为语义部分区域的目标性可能会由于随机放置的遮挡而变得较弱。因此第二阶段,也就是分类,必须从一组质量相对较低的候选目标开始。在第二部分中,我们在现有的proposal中添加了ground-truth bounding box,以便recall为100%,将这些候选目标输入分类器,并评估其在被遮挡图像上的性能。即使有这样的优势,Faster-RCNN仍然会产生令人不满意的检测精度。例如,在检测自行车在最高遮挡水平(L3)的语义部分时,利用ground-truth bounding box的附加方案,只会将检测精度从41.1%提高到44.7%,这仍然比DeepVoting+的62.5%低很多。这意味着分类器可能被混淆,因为遮挡物改变了proposal的外观。

4.4 Visualizing Visual Concepts and Heatmaps

在图5中,我们展示了一些学习到的视觉概念和空间热图的典型例子。视觉概念的可视化遵循文章【26】中使用的方法,该方法在每个卷积滤波器上找到10个最重要的响应,即匹配模板,追溯到原始图像格,并在pool-4层裁剪与神经元对应的区域。为了显示不同的空间热图,我们随机选择了一些相关的视觉概念和语义部分对,并绘制了投票层的卷积权重进行比较。我们发现,学习的视觉概念和空间热图在语义上是有意义的,即使在培训过程中只有语义部分级的监督。

4.5 Explaining the Detection Results

最后,我们展示了我们的方法的一个有趣的好处,这使我们能够解释检测结果。在图六中,我们展示了三个示例,其中目标语义部分没有被遮挡,部分被遮挡,完全被遮挡。deepvoting可以推断出被遮挡的语义部分,还可以查找投票(支持)的视觉概念进行诊断,挖掘错误并了解我们方法的工作机制。

5. Conclusions

本文提出了一种鲁棒的、可解释的深度网络DeepVoting,用于部分遮挡下的语义部分检测。中间的视觉表示称为视觉概念,通过两个卷积层提取并用于对语义部分投票。视觉概念和语义部分之间的空间关系从无遮挡数据集中学习,然后传输到被遮挡的测试图像。DeepVoting在VehicleSemanticPart数据集和VehicleOcclusion数据集上都进行了评估,并在非遮挡场景中显示出与Faster-RCNN相当的性能,在遮挡场景中显示出比Faster-RCNN优越的性能。如果加上上下文,即DeepVoting+,那么这个框架在所有场景下都显著优于DeepVoting和Faster-RCNN。此外,我们的方法还具有可解释性的优点,使我们能够诊断语义部分。通过检查每个视觉概念的贡献来检测结果。

在未来,我们计划扩展deepvoting来检测非刚性和关节对象(如动物)的语义部分。此外,我们还计划结合这些语义提示在遮挡下执行目标级检测。

Acknowledgements

略

参考文献

见论文

论文地址:https://arxiv.org/abs/1709.04577

第一次写翻译论文的博客,写的不好还请大家多多指教,有什么问题也可以一起讨论

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?