章节一:引言

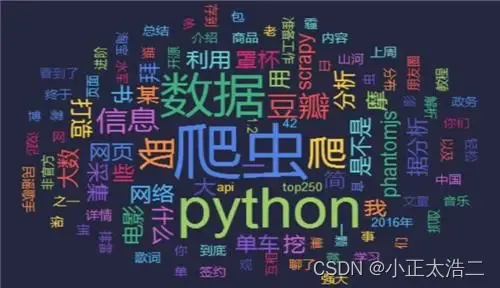

在当今互联网时代,数据的价值越来越被重视,而网络爬虫作为一种强大的工具,可以帮助我们从互联网中提取有用的数据。Python作为一门广泛应用于数据科学和网络开发的编程语言,有着丰富的库和框架来支持网络爬虫的开发。本文将重点介绍两个常用的Python网络爬虫工具:Scrapy和Beautiful Soup,并探讨它们的使用方法和数据处理技巧。

章节二:Scrapy的基本用法和示例

Scrapy是一个功能强大的开源网络爬虫框架,它提供了一套完整的爬取流程和灵活的扩展机制。通过创建Scrapy项目、定义爬虫规则和编写解析代码,我们可以轻松地构建一个高效的网络爬虫。以爬取一个新闻网站为例,我们可以使用Scrapy的选择器和Item Pipeline来提取新闻标题、作者和发布时间等信息,并将数据存储到数据库或文件中。

import scrapy

class NewsSpider(scrapy.Spider):

name = 'news'

start_urls = ['http://example.com/news']

def parse(self, response):

# 使用选择器提取新闻标题和链接

titles = response.css('h2.news-title a::text').getall()

links = response.css('h2.news-title a::attr(href)').getall()

for title, link in zip(titles, links):

# 创建一个Item对象,存储提取的数据

item = {'title': title, 'link': link}

yield item

章节三:Beautiful Soup的数据解析和处理技巧

Beautiful Soup是一个流行的Python库,用于从HTML或XML文件中提取数据。它提供了简单而直观的API,使得数据的解析和处理变得更加容易。通过使用Beautiful Soup,我们可以从网页中提取特定标签的内容、处理嵌套结构和应对不规范的HTML代码。以解析一个博客文章为例,我们可以使用Beautiful Soup提取标题、正文和标签等信息,并进行数据清洗和转换。

from bs4 import BeautifulSoup

# 解析HTML页面

html = """

<html>

<head><title>Blog Title</title></head>

<body>

<h1>Blog Title</h1>

<div class="article">

<p>Article content...</p>

<p>Article content...</p>

</div>

<div class="tags">

<a href="/tag1">Tag 1</a>

<a href="/tag2">Tag 2</a>

</div>

</body>

</html>

"""

soup = BeautifulSoup(html, 'html.parser')

# 提取标题

title = soup.find('h1').text

# 提取正文

content =

content_div = soup.find('div', class_='article')

paragraphs = content_div.find_all('p')

text_content = '\n'.join([p.text for p in paragraphs])

# 提取标签

tag_div = soup.find('div', class_='tags')

tags = [a.text for a in tag_div.find_all('a')]

print("标题:", title)

print("正文:", text_content)

print("标签:", tags)

章节四:数据处理和清洗技巧

网络爬虫获取的数据往往需要经过一系列的处理和清洗才能变得有用。Python提供了许多强大的数据处理库,如Pandas和NumPy,可以帮助我们对爬取到的数据进行处理和分析。以处理一个商品数据集为例,我们可以使用Pandas库进行数据清洗、转换和统计。

import pandas as pd

# 读取CSV文件

data = pd.read_csv('products.csv')

# 移除价格为空的数据

data = data.dropna(subset=['price'])

# 将价格转换为浮点数类型

data['price'] = data['price'].astype(float)

# 计算价格的平均值

average_price = data['price'].mean()

# 计算价格的最大值

max_price = data['price'].max()

# 计算价格的最小值

min_price = data['price'].min()

print("平均价格:", average_price)

print("最高价格:", max_price)

print("最低价格:", min_price)

章节五:总结与展望

本文介绍了Python网络爬虫中两个重要的工具:Scrapy和Beautiful Soup,并详细探讨了它们的使用方法和数据处理技巧。通过实际示例,我们展示了如何使用Scrapy和Beautiful Soup从网页中提取数据,并使用Pandas进行数据处理和分析。网络爬虫在数据获取和处理方面发挥着重要作用,帮助我们探索和利用互联网中的宝藏。未来,随着互联网的不断发展,网络爬虫的应用领域将越来越广泛,我们也期待着更多创新和技术突破。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?