目录

1 数据压缩

上一章中我们学习了聚类算法,这一章中我们要学习第二类无监督学习问题,降维。

降维的定义:样本由一个个特征组成,假如一个样本有n个特征,则我们称数据是n维的。降维的工作就是在保证数据特征不变的情况下,减少特征的个数,为了保证不变性,我们通常只把多个相似,相关特征合并为1个特征。

降维的目的有两个,一是压缩数据:减少了数据量后可以降低存储空间消耗,同时提高计算速度。其二是便于可视化,九维十维无法通过可视化手段展现,但通过降维让维度达到二维三维后就能通过可视化处理进行数据分析了。

2 主成分分析问题规划1

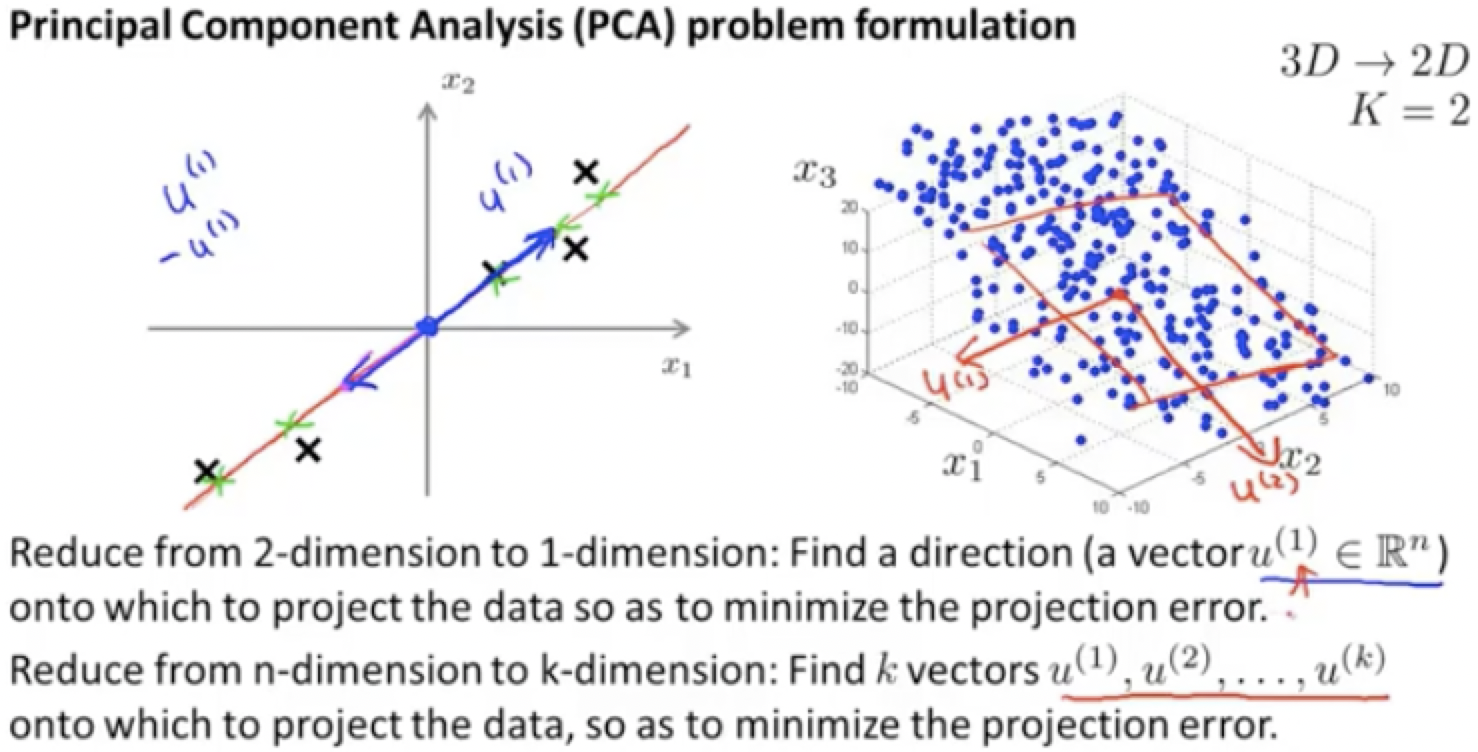

主成分分析(PCA)是最常用的降维方法之一。其核心思想是找到一个方向向量,当我们把所有数据都投射到该向量上时,我们希望投射平均均方差误差能尽可能地小。方向向量是一个经过原点的向量,而投射误差是从特征向量向该方向向量作垂线的长度,简而言之就是找出一个低维的平面或子空间,把空间投影到上面,从而使原样本与投影后的样本的距离的平方和最小。

PCA在上左图中做的就是试着找一个方向向量,使得向量投影到这个方向向量上的投影误差最小。而在上右图做的就是由u1,u2两个向量定义了一个平面,而我们将数据投影到这个面上。

PCA和线性回归的图像非常相似,但实际上,这是两个完全不同的概念。

上图中左边是线性回归的误差,其垂直于横轴投影,而右边则是主成分分析误差,垂直于红线投影。

PCA最大的优点在于完全无参数限制,并且对数据进行降维处理,可以简化模型同样最大程度保持了原有数据的信息。

3 主成分分析问题规划2

第一步:要对数据进行预处理,均值标准化,即计算某个特征的平均值,然后使用特征值减去平均值来代替原来的特征值,有时候还要进行特征缩放。

第二步:计算协方差

![]()

将上式计算出的值代入SVD公式(奇异值分解算法)求出三个矩阵

然后第一个矩阵U的前k列就是所需的k维,然后用前k列的转置乘x得z,是一个k维向量

然后用z代替x即可

然后用z代替x即可

4 主成分数量选择

降维的目的是在保证特征趋势不变的情况下选择小的k,在数学的角度就是在保留最大的方差性的前提下,选择最小的k。

选择方法1

设压缩后还原得到的特征值为 ,则x-

即压缩后损失

s是损失方差,选择k的过程就是逐渐增大k,并保证s在合理范围内。

选择方法2

通过计算矩阵s来计算k。

5 压缩重现

压缩重现就是把压缩后的低维数据恢复到高维,由于![]() 所以

所以![]() 。

。

6 建议

1 PCA只用在训练集上,而降维矩阵可以应用在测试集和交叉训练集上。

2 不用PCA防止过拟合,会丧失关键信息。

3 PCA不是必须选项,如有必要再使用。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?