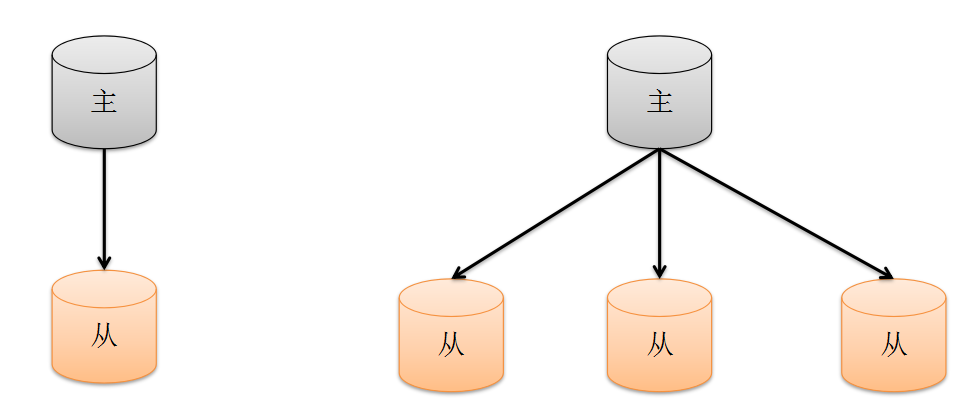

1.主从复制

1.1 概述

主从复制是一个简单的数据库同步备份的集群技术

- 1)在数据库集群中要明确的知道谁是主服务器,主服务器只有一台.

- 2)从服务器要知道自己的数据源也就是对于的主服务是谁.

- 3)–master用来确定主服务器,–slave 和 –source 来控制曾服务器

1.2 配置案例

端口8888为主服务, 端口7777为从服务. 数据从8888同步到7777

8888.conf主从相关配置信息:

dbpath = /data/mongod/01/8888 主数据库地址

port = 8888 主数据库端口号

bind_ip = 127.0.0.1 主数据库所在服务器

master = true 确定我是主服务器

7777.conf主从相关配置信息:

dbpath = /data/mongod/01/7777 从数据库地址

port = 7777 从数据库端口号

bind_ip = 127.0.0.1 从数据库所在服务器

source = 127.0.0.1:8888 确定我数据库端口

slave = true 确定自己是从服务器

1.3 主从复制其它配置项

--only 从节点指定复制某个数据库,默认是复制全部数据库

--slavedelay 从节点设置主数据库同步数据的延迟(单位是秒)

--fastsync 从节点以主数据库的节点快照为节点启动从数据库

--autoresync 从节点如果不同步则从新同步数据库

--oplogSize 主节点设置oplog的大小(主节点操作记录存储到local的oplog中)

//从节点中关于主节点的信息全部存到local的sources的集合中

db.sources.find();我们只要对集合进行操作就可以动态操作主从关系

挂接主节点:操作之前只留下从数据库服务

db.sources.insert({“host”:”127.0.0.1:8888”})

删除已经挂接的主节点:操作之前只留下从数据库服务

db.sources.remove({“host”:”127.0.0.1:8888”})

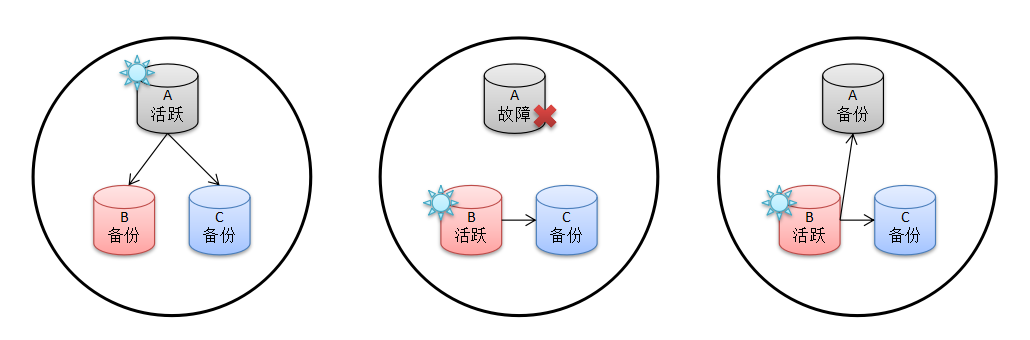

2.副本集

2.1 概述

- 1.1第一张图表明A是活跃的B和C是用于备份的

- 1.2第二张图当A出现了故障,这时候集群根据权重算法推选出B为活跃的数据库

- 1.3第三张图当A恢复后他自动又会变为备份数据库

2.2 配置案例

//A配置

dbpath = /data/sortwaremongod/02/A

port = 1111 #端口

bind_ip = 127.0.0.1 #服务地址

replSet = child/127.0.0.1:2222 #设定同伴

//B配置

dbpath = /data/sortware/mongod/02/B

port = 2222

bind_ip = 127.0.0.1

replSet = child/127.0.0.1:3333

//C配置

dbpath = /data/sortware/mongod/02/C

port = 3333

bind_ip = 127.0.0.1

replSet = child/127.0.0.1:1111

//初始化副本集

use admin

db.runCommand({"replSetInitiate":

{

"_id":'child',

"members":[{

"_id":1,

"host":"127.0.0.1:1111"

},{

"_id":2,

"host":"127.0.0.1:2222"

},{

"_id":3,

"host":"127.0.0.1:3333"

}]

}

})

//查看副本集状态

rs.status()

2.3 副本集其它配置项

standard 常规节点:参与投票有可能成为活跃节点

passive 副本节点:参与投票,但是不能成为活跃节点

arbiter 仲裁节点:只是参与投票不复制节点也不能成为活跃节点

Priority 0到1000之间 ,0代表是副本节点 ,1到1000是常规节点

arbiterOnly : true 仲裁节点

用法

members":[{

"_id":1,

"host":"127.0.0.1:1111“,

arbiterOnly : true

}]”

2.4 选举规则

1.优先级相同时候仲裁组建的规则,选择最近有更新的

2.5 其它

2.5.1 读写分离操作扩展读

一般情况下作为副本的节点是不能进行数据库读操作的

但是在读取密集型的系统中读写分离是十分必要的设置读写分离

slaveOkay : true

很遗憾他在shell中无法掩饰,这个特性是被写到mongoDB的

驱动程序中的,在java和node等其他语言中可以完成

2.5.2 Oplog

它是被存储在本地数据库local中的,他的每一个文档保证这一个节点操作

如果想故障恢复可以更彻底oplog可已经尽量设置大一些用来保存更多的操作信息

改变oplog大小

主库 –master –oplogSize size

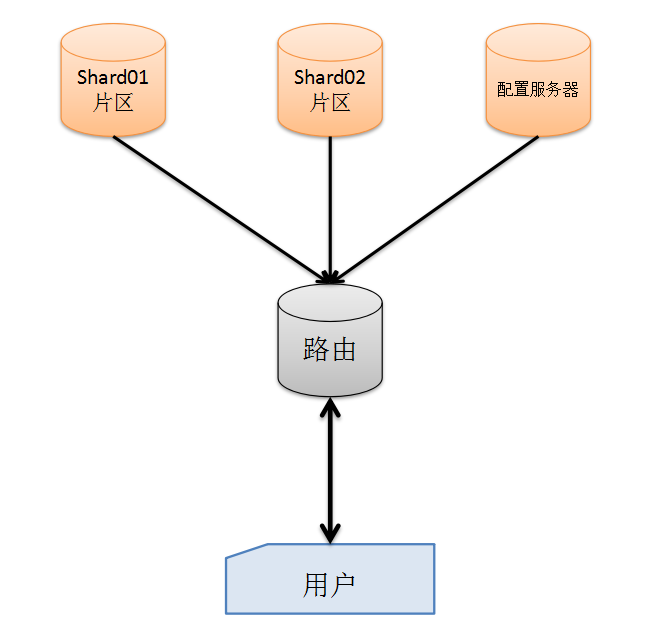

3.分片

3.1 概述

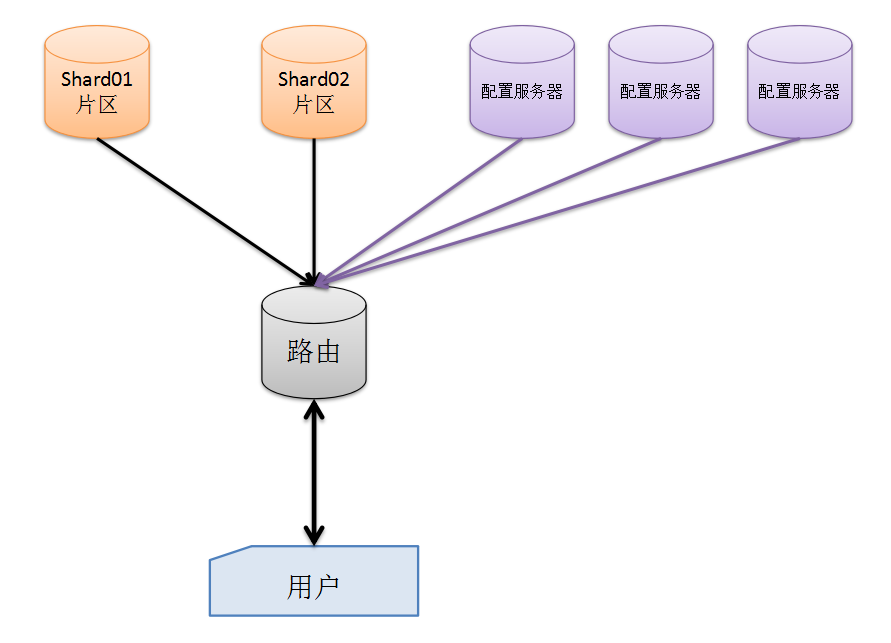

分片是一种插入负载技术. 分片架构图:

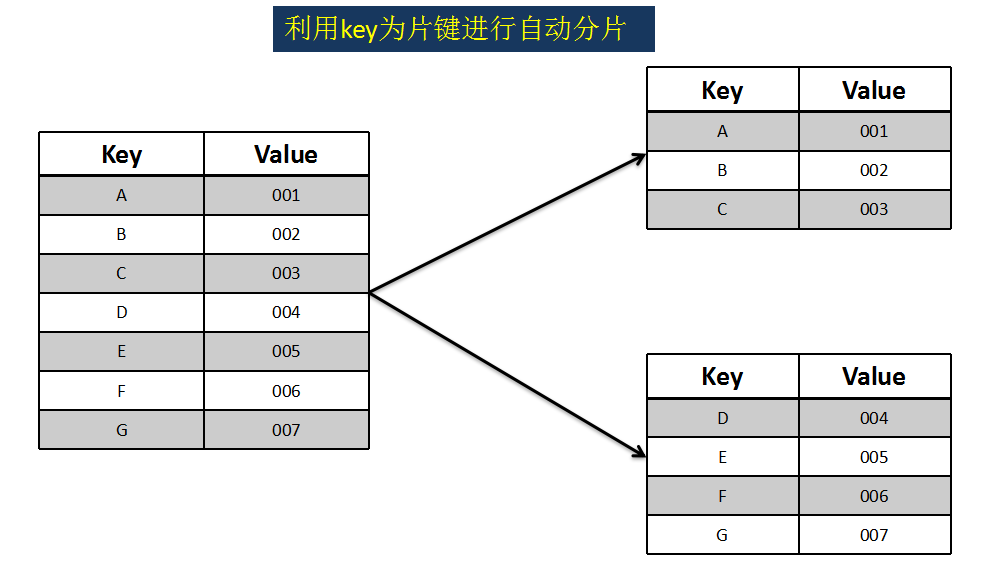

3.2 片键的概念和用处

3.3 什么时候用到分片

- 机器的磁盘空间不足

- 单个的mongoDB服务器已经不能满足大量的插入操作

- 想通过把大数据放到内存中来提高性能

3.4 分片步骤

- 1)创建一个配置服务器

- 2)创建路由服务器,并且连接配置服务器; 路由器是调用mongos命令

- 3)添加2个分片数据库

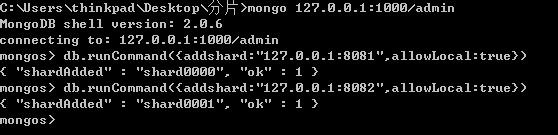

8081和8082 - 4)利用路由为集群添加分片(允许本地访问)

db.runCommand({addshard:”127.0.0.1:8081”,allowLocal:true})

db.runCommand({addshard:”127.0.0.1:8081”,allowLocal:true})

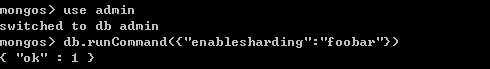

==切记之前不能使用任何数据库语句== - 5)打开数据分片功能,为数据库foobar打开分片功能

db.runCommand({“enablesharding”:”foobar”})

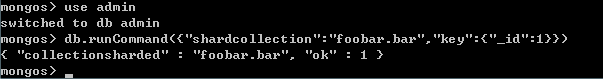

- 6)对集合进行分片

db.runCommand({“shardcollection”:”foobar.bar”,”key”:{“_id”:1}})

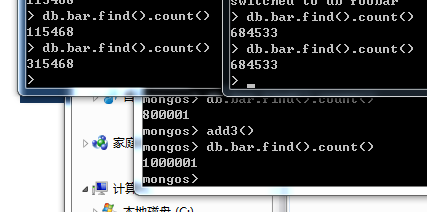

- 7)利用大数据量进行测试 (800000条)

3.5 常用分片命令

3.5.1 查看配置库对于分片服务器的配置存储

db.printShardingStatus()

3.5.2 查看集群对bar的自动分片机制配置信息

mongos> db.shards.find()

{ “_id” : “shard0000”, “host” : “127.0.0.1:8081” }

{ “_id” : “shard0001”, “host” : “127.0.0.1:8082” }

3.6 配置服务器集群

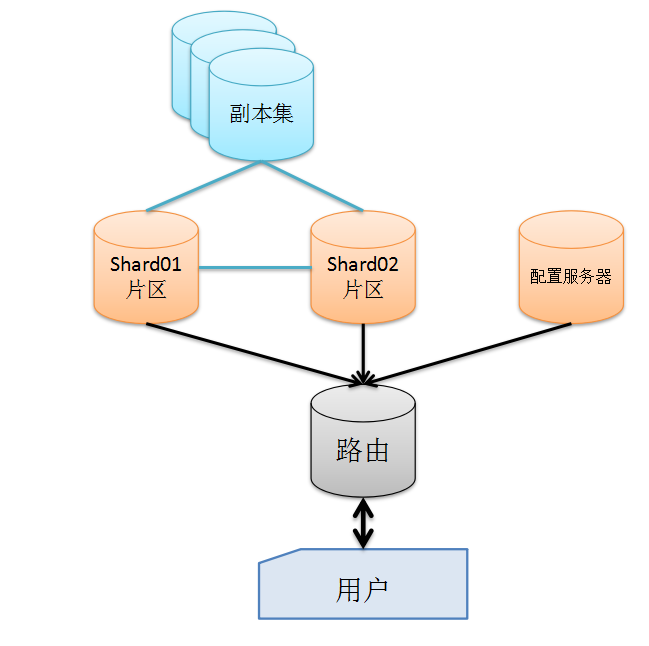

3.7 分片与副本集一起使用

注:mongoDB所有总结均来自于网络文档整理后发布.

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?