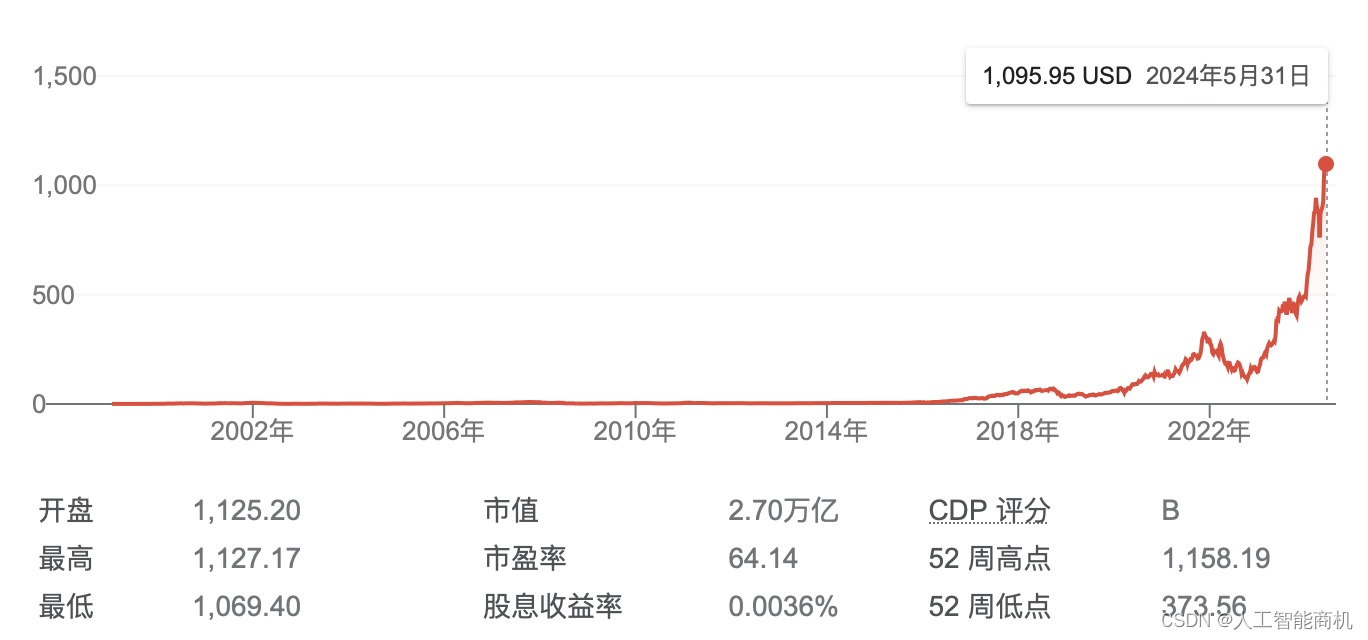

2024年,英伟达的股票一飞冲天,成功出圈,成为茶余饭后谈资。截止2024年5月31日,市值达2.7万亿美元,而特斯拉的市值只有5580亿。英伟达的市值是特斯拉的4.8倍。

这么紧要的关头,特斯拉的超算Dojo(计算芯片为D1)却没有声音了,且特斯拉首席执行官马斯克(Elon Musk)频频示好英伟达,那么,是因为特斯拉的超算Dojo没戏了吗?

特斯拉Dojo曾是英伟达的有力竞争者

在AI芯片的角逐中,英伟达一览群雄,凭借强大的软件生态,全世界最顶尖且人数最多的科学家、算法工程师、软件工程师群体,喜滋滋的在英伟达芯片上开发算法,互相分享“开源代码”,自愿充当英伟达的销售,帮助英伟达做大市场。

不光国产替代举步维艰,国外的友商也一筹莫展,英特尔、AMD和谷歌觊觎已久,但是,也挡不住英伟达一路高歌。特斯拉的超级计算机Dojo和芯片D1也是众多挑战者之一,马斯克贵为谷歌明星,也没有主角光环。

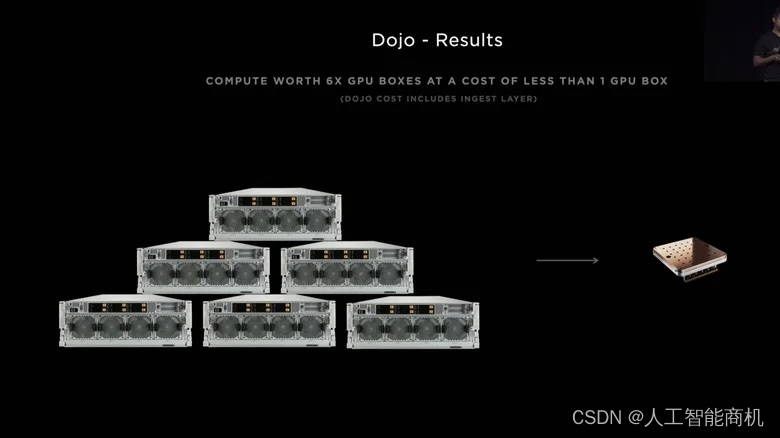

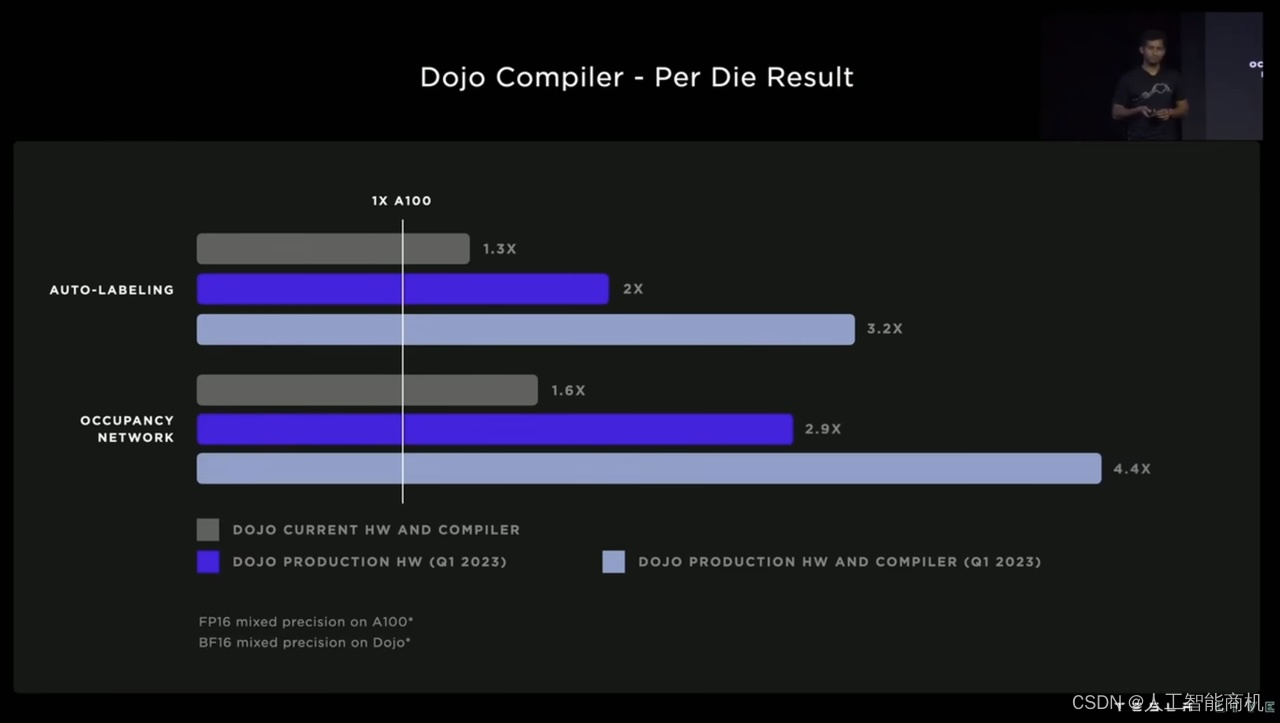

2022年9月30日,特斯拉AI Day上,Dojo 直接拉出了英伟达 A100 来对标。与英伟达的 A100 GPU 相比,每一颗 D1 芯片(配合特斯拉自研的编译器)在自动标注(auto-labeling)任务中最高能够实现 3.2 倍的计算性能,而在占用网络(occupancy network)任务中最高能够实现 4.4 倍的计算性能。如果从总体目标来看,根据特斯拉官方的数据显示,在同样的成本之下,它所构建的 Dojo 超级计算机能够实现 4 倍的性能,能耗比提升 1.3 倍,计算系统的占地面积也会缩小为以往的 5 倍。

马斯克频频示好英伟达,Dojo失声

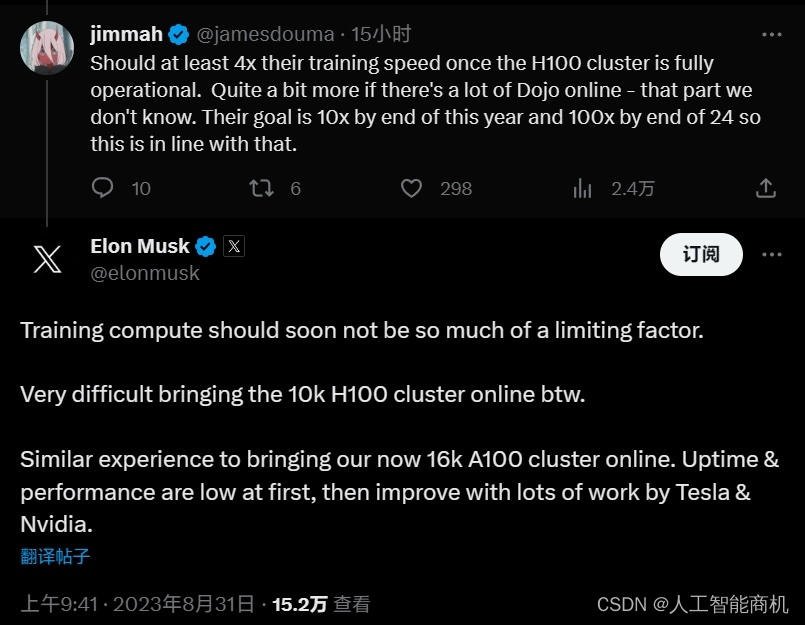

2023年7月,马斯克表示,“老实说,若英伟达交出足够GPU,我们也许不需要Dojo。”

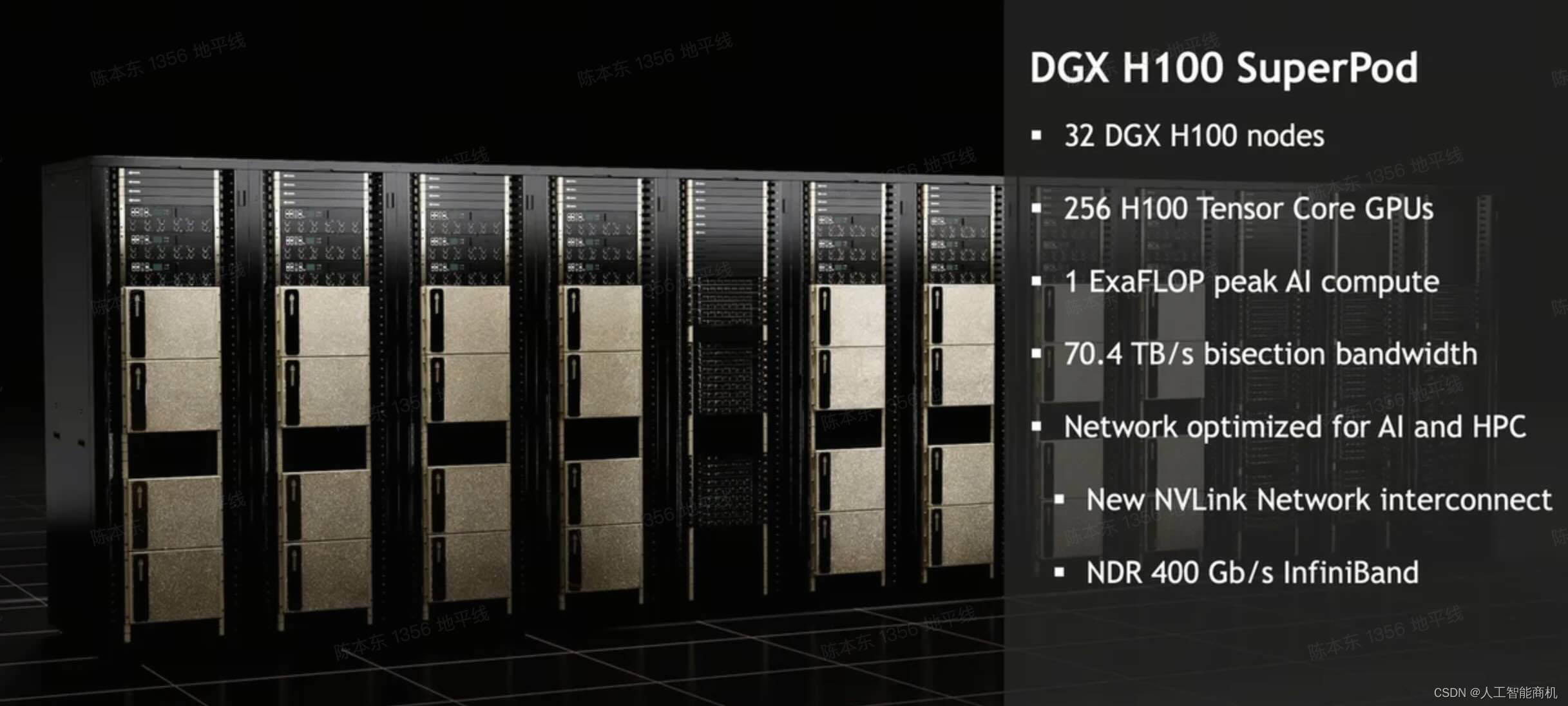

2023年8月29日,特斯拉 10,000 块 H100 GPU 集群上线,加速自动驾驶 FSD V12 落地。

2024年1月,特斯拉投资 5 亿美元在纽约州的布法罗市(Buffalo)建造一台Dojo超级计算机。马斯克表示,5 亿美元虽然显然是一大笔钱,但只相当于 Nvidia 的 1万块H100 系统。特斯拉今年在英伟达硬件上的支出将超过这一数字。目前,在人工智能领域保持竞争力每年至少需要数十亿美元。

2024年4月10日的采访中,马斯克透露,他的人工智能初创公司xAI (注:5月26日官宣融资60亿美元)目前正在训练其 Grok 大型语言模式的第二版,训练Grok 2模型需要大约两万个英伟达H100 GPU,而Grok 3以上的版本将需要10万片H100。分析指出,xAI的消息让投资者相信,英伟达芯片仍存在一些潜在的大顾客,将继续增加对英伟达芯片的需求。

特斯拉频频向英伟达示好,是因为自家的Dojo超算没戏了吗?准备放弃自家的Dojo超算吗?

特斯拉没有放弃Dojo,但是要保持低调

因为特斯拉的Dojo研发进展延期,导致特斯拉极度依赖英伟达的H100芯片,所以,2023年7月后,Dojo芯片的宣传大大减少,保持低调,避免英伟达提防,不卖给特斯拉GPU,妨碍特斯拉自动驾驶FSD的开发。

当然,还有另外一种说法,2024年6月13日,股东们将对马斯克创纪录的薪酬方案进行第二次投票,按目前的股价计算,马斯克的薪酬价值约为 550 亿美元。由于 Glass Lewis 等代理顾问现在建议投资者投票反对批准马斯克的薪酬,6月13日年度会议的结果比预期的要紧张。

在这种情况下,马斯克对于做高创新业务(Dojo超算,机器人)的声量,拉高公司的股价动力不足,假如投票没有通过,马斯克可能会把Dojo和机器人业务剥离出特斯拉。

同时,英伟达股价近期急速拉升,会提高股东对于特斯拉超算Dojo的未来前景预期,增加马斯克的谈判筹码。

而且,马斯克和特斯拉以创纪录的速度采购英伟达的人工智能芯片,黄仁勋和马斯克的关系非常好,对马斯克提供了支持。当地时间5月27日消息,马斯克创纪录报酬的关键投票前几周,英伟达(Nvidia)的明星创始人黄仁勋(Jensen Huang)在上周末上传到 YouTube 的雅虎财经采访中,支持特斯拉的人工智能自动驾驶汽车战略。“特斯拉在自动驾驶汽车领域遥遥领先”,"这项技术确实具有革命性,他们所做的工作令人难以置信”。黄仁勋等人对他的新人工智能战略投下的信任票可能会增加马斯克“讨薪”成功的机会。

为什么说特斯拉不会放弃Dojo

第一,台积电确认Dojo芯片已经量产。在2024年4月底的台积电北美技术研讨会上透露,特斯拉用于人工智能训练的 Dojo 晶圆系统处理器现已投入量产。芯片量产是非常重要的里程碑,这说明特斯拉的Dojo芯片并没有黄。2023年9月摩根士丹利表示,其半导体团队调查显示,特斯拉在2023年订购了大约在4万到5万片D1芯片。

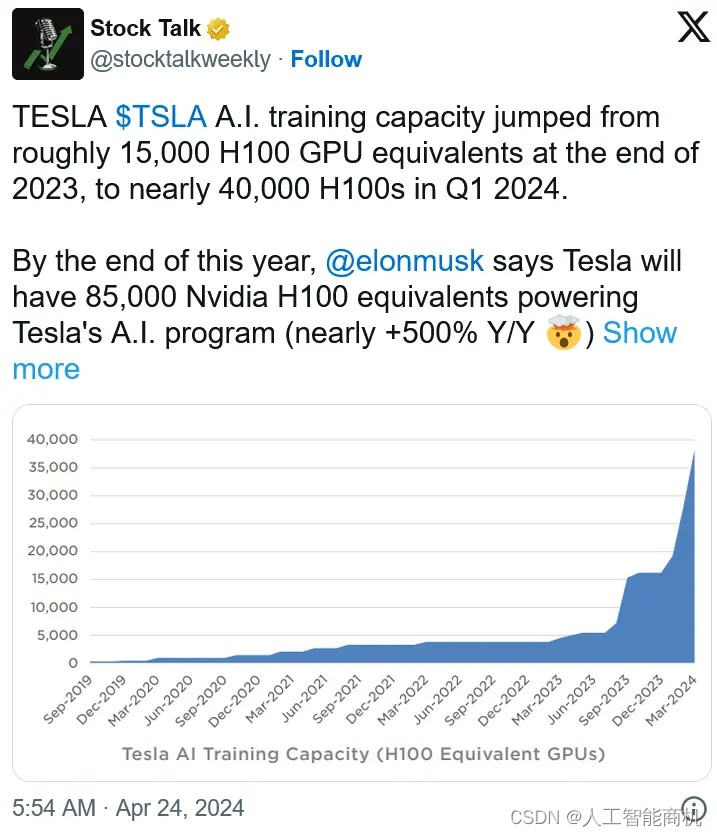

第二,从2023年底的宣传开始,特斯拉开始使用“H100 GPU等效单位”(H100 GPU equivalents),而以前说的是“H100”。推测原因是,部分算力是D1芯片折算的。

如果特斯拉非常实在,3颗D1芯片可折算为1颗“H100 GPU等效单位”,非常扎实。

如果特斯拉愿意像英伟达一样虚标算力,1颗D1芯片折算为1颗“H100 GPU等效单位”,也证据充分。

第三,特斯拉自产自销。而特斯拉的智驾FSD V12.3反响良好,智驾训练需求强烈。第一代Dojo芯片即使不完美,只要持续投入,总会能用。只要应用在自己的智驾系统中,就能实现价值,获得迭代机会。

-

2023年7月财报电话会议中,马斯克表示并不会对 Dojo 项目的支出进行公开,但表示2024年会投入 10 亿美元在 Dojo 项目上。

-

2024年1月26日,纽约州州长凯西·霍楚(Kathy Hochul)称,特斯拉将投资5亿美元(相当于约 1 万颗 H100 GPU),在该州的布法罗市(Buffalo)建造一台Dojo超级计算机。马斯克很快证实了这一消息。

第三,特斯拉D1芯片的成本优势仍然值得期待。特斯拉D1芯片的物理算力和英伟达A100几乎相同(116%,362/312 TPOS),从实际智驾任务来说,实际算力和H100差不多(A100的3~4倍左右)。考虑到英伟达的高毛利(超76%),特斯拉D1芯片的成本优势仍然值得期待。

-

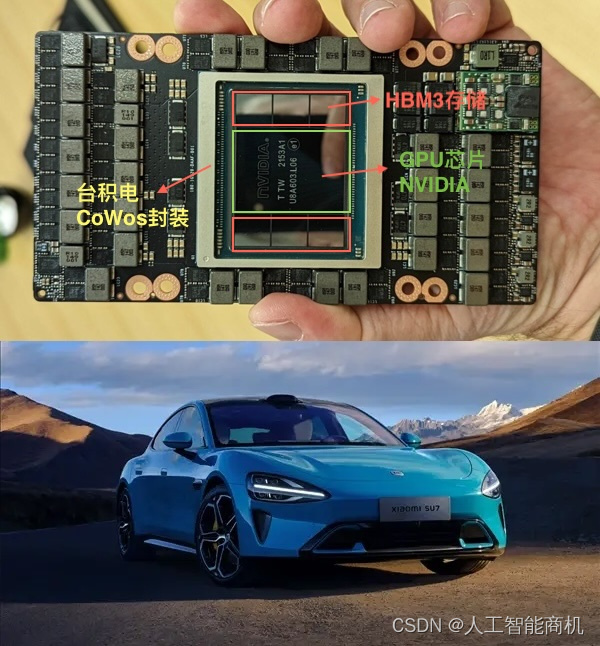

Nvidia 对其芯片的收费如此之高(一块H100的售价为35,000美金,超过1辆小米汽车SU7 Pro;公司整体毛利率超76%),如果 Dojo 的功能只有 20%,而成本却只有 10%,那也是值得的。

第四,特斯拉的AI算法软件能力特别强。AMD和英特尔挑战英伟达一直失败,软件能力太差是重要原因。而特斯拉的智能驾驶FSD和AI Day一直以来引领全球自动驾驶AI算法趋势,可以说,特斯拉在AI Day上面公开什么算法,其他智驾公司就做什么算法,这是特斯拉做AI芯片的巨大优势。

-

2021年,特斯拉在第一届AI DAY上推出了基于Transformer的BEV(鸟瞰图),全球自动驾驶行业马上跟随,在2023年部分国产算法商实现了量产落地。

-

在2022年特斯拉AI DAY上,特斯拉分享了Occupancy Network(占用网络),全球自动驾驶行业马上跟随。

-

到2024年又率先实现了端到端的自动驾驶技术量产落地,把论文变成了能落地的工程实现,极大的激发了全球自动驾驶行业对于端到端的研发热情。

第五,特斯拉的D1芯片试图打造AI计算专用芯片。比如,比特大陆自研虚拟货币矿机专用芯片,挖矿场景成功取代了英伟达的GPU。

-

特斯拉的训练场景专注于图像网络。因此,他们的架构和推荐网络和基于 Transformer 的语言模型需要非常不同的架构。图像/视频识别网络对计算、芯片间通信、芯片内部内存和芯片外部内存储的要求截然不同。

-

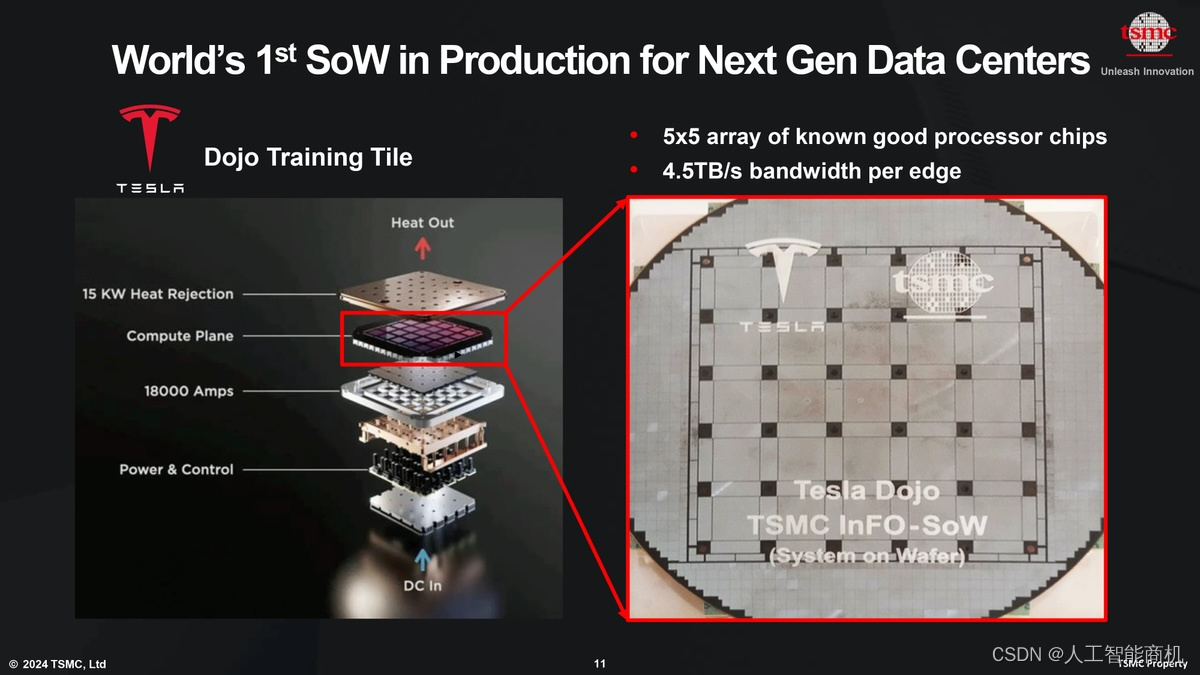

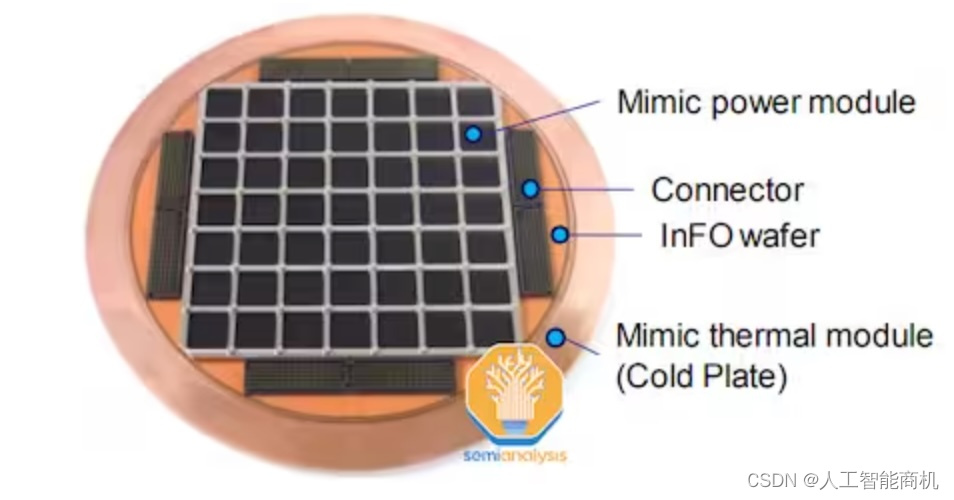

特斯拉是全球首次采用台积电晶圆级互连 (InFO_SoW) 技术的客户,InFO_SoW 旨在实现高性能连接,使得 Tesla Dojo 的 25 个芯片可以像单个处理器一样工作。晶圆级处理器,例如 Tesla 的 Dojo 和 Cerebras 的晶圆级引擎 (WSE),比多处理器机器的性能效率要高得多。它们的主要优点包括内核之间的高带宽和低延迟通信、降低的电力传输网络阻抗以及卓越的能源效率。

-

更重要的是,台积电下一代晶圆上系统平台CoW_SoW 支持在处理器块上进行 3D 堆叠 和 HBM4 内存安装,解决特斯拉D1芯片必须专门使用片上存储器,不灵活的问题,从而满足所有类型的AI应用。

为什么说Dojo的确遇到了困难

第一,特斯拉超算Dojo的研发进展的确滞后了。2022年 AI Day 上的说法,Dojo 的量产原本预计在2023年第一季度进行;但很明显,Dojo 一直到2023年 7 月份才开始量产,出现了明显的延迟,据报道,原因是其降本不及预期。

第二,2023年底,在自研的重要节点上,多名Dojo研发负责人离职。

-

2023年11月,负责Dojo超算项目的负责人、同时也是特斯拉自动驾驶硬件高级总监加内什·文卡塔拉马南(Ganesh Venkataramanan)离职,职位由前苹果高管彼得·班农(Peter Bannon)负责。彼时有消息称,很可能是因为Dojo第二代芯片未达标,加内什遭到解雇。加内什此前负责特斯拉Dojo超算项目已达5年,在进入特斯拉之前,他曾在美国知名半导体公司AMD任职近15年。加内什的离职,被认为是特斯拉自研芯片不力,或者没有设想中那么顺利。

-

2023年12月,特斯拉AI基础设施负责人Tim Zaman离职前往谷歌DeepMind。

第三,特斯拉位于德克萨斯州奥斯汀的数据中心的进度落后于计划。2024年4 月中旬,马斯克参观了占地 1000 万平方英尺(93 万平方米)的特斯拉工厂南侧的工地。在那里,他发现一处设施由于交付问题、恶劣天气和其他施工问题而失去了大部分屋顶和底层。计划中的 Dojo 超级计算机站点受到了问题的困扰,首席执行官埃隆·马斯克 (Elon Musk) 对这些延误感到“愤怒”,马斯克解雇了施工经理。

第四,特斯拉遇到了现金流问题。作为2024 年第一季度财报的一部分,这家电动汽车巨头透露,"受第一季度库存增加 27 亿美元和人工智能基础设施资本支出 10 亿美元的影响(买H100的卡),该季度自由现金流为-25 亿美元。"

为了负担得起人工智能的巨额投资,马斯克几乎愿意不惜一切代价削减其他方面的成本。4月15日,马斯克在致员工的内部电子邮件中表示,该公司将裁减超过10%的全球员工,“为下一个增长阶段周期做好准备”。根据特斯拉全球员工数量计算,此次裁员影响的员工超过1.4万人。马斯克已经解雇了数千名员工,解雇了行业领先的超级充电站网络背后的团队,并取消了为即将推出的 2.5 万美元入门车型投资全新装配线的计划。

第五,Dojo面临迅速淘汰的风险。英伟达支撑人工智能行业突飞猛进,让D1芯片面临被迅速淘汰的风险。英伟达狂轰乱炸的芯片性能迭代宣传,可能导致投资人信心不足,导致Dojo的研发经费投入不足。

5月23日英伟达Q1财报电话会议上,黄仁勋透露,英伟达下一代“最强”AI芯片B100,生产性发货将在2024年第二季度开始并在第三季度逐步增加,客户的数据中心应该可以在第四季度起使用上Blackwell平台。B100将采用新一代Blackwell,算力、能效相比采用Hopper架构的H100、H200提升幅度可达一倍。

2024年3月20日,英伟达投下了Blackwell B200 炸弹,这是下一代数据中心和 AI GPU。训练一个 1.8 万亿个参数的模型以前需要 8000 个 Hopper GPU 和 15 兆瓦的电力,如今,2000 个 Blackwell GPU 就能完成这项工作,耗电量仅为 4 兆瓦。在具有 1750 亿个参数的 GPT-3 LLM 基准测试中,GB200 的性能是 H100 的 7 倍,英伟达称其训练速度是 H100 的 4 倍。信心不足可能会导致Dojo的研发经费投入不足。

总结

在英伟达的众多挑战者中,特斯拉的Dojo有两大优势:

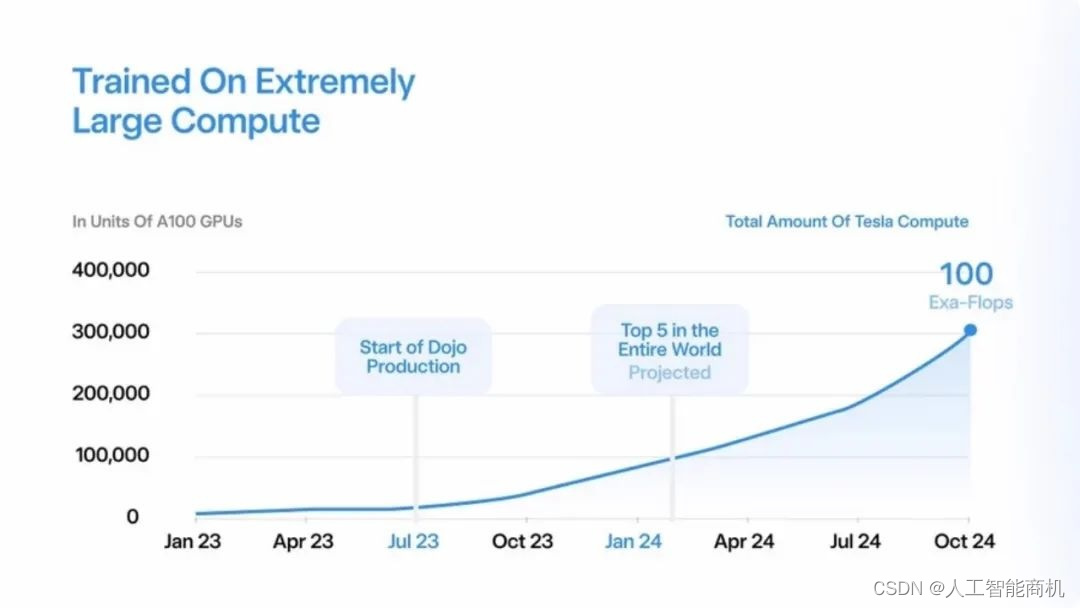

第一,特斯拉只服务于特定应用场景(自动驾驶、机器人)。其他想做通用AI训练芯片的公司,需要满足各种不同场景,芯片和软件的灵活性要求高、成本上挑战大;另外,开发者生态建设上壁垒很高,新工具链难以面面俱到,难以吸引全球的开发者。但是,特斯拉在自动驾驶场景是王者,有能力定义行业算法方向,芯片和软件工具链只需要做好这个场景就能切入,完全有可能做到,挟“软件”以令“芯片”。

第二,特斯拉自动驾驶FSD训练数据量巨大,对训练服务器的算力需求量巨大。特斯拉规划,在2024年10月,算力达到100Exa-Flops,大约需要30万颗D1芯片。如果有3家车厂部署了特斯拉的Dojo服务器,则出货量接近100万颗,销售额达到100亿美金级别。

所以,特斯拉不会放弃自研超算Dojo,困难是暂时的,失声也是暂时的。

(本文仅代表个人观点,和任何组织无关。)

作者微信,欢迎交流。添加时请注明公司、姓名。

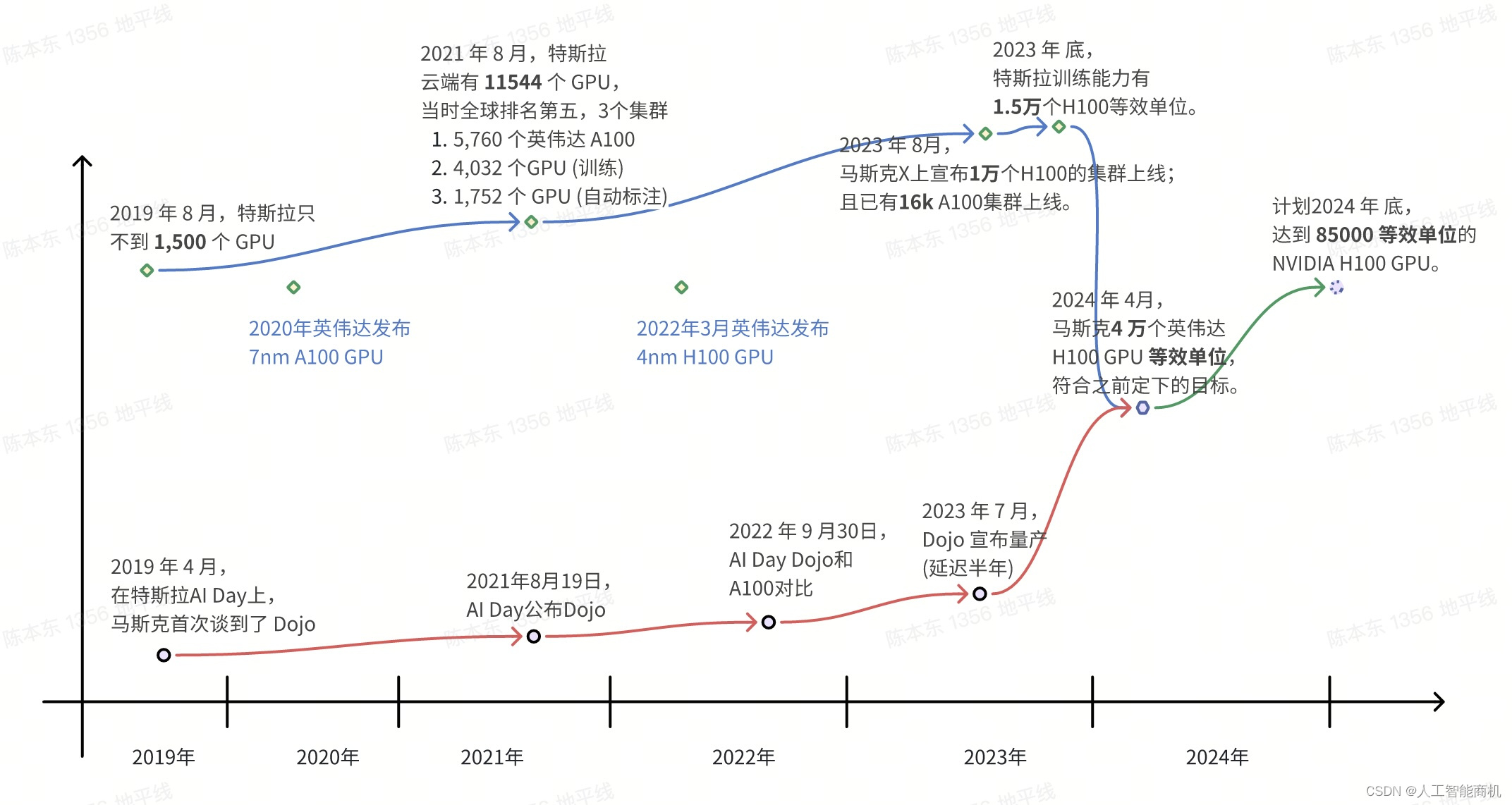

附录1:特斯拉Dojo的发展历史

-

2019 年 4 月,在特斯拉自动驾驶日上,马斯克首次谈到了 Dojo,当时他是这么说的:

-

特斯拉确实有一个重大的项目,我们称之为 Dojo。它是一个超级强大的训练计算机,其目标是能够输入海量的数据并能够在视频层面进行训练……通过 Dojo 计算机,可以对大量视频进行无监督的大规模训练。

-

2019 年8 月,特斯拉仅拥有不到1500 个GPU。

-

-

2021年8月19日17点,特斯拉AI Day,自研的AI训练Dojo D1芯片和超级计算机Dojo成为发布会重点。

-

作为本次发布会的重头戏,AI训练Dojo D1芯片和超级计算机Dojo压轴登场。作为特斯拉自主研发的超算芯片,D1采用7nm制造工艺打造,算力高达362TFLOPs,片上带宽10TBps/dir,功耗400W。整体来说就是算力提升,功耗降低。

-

超级计算机Dojo则采用 3000 个 D1 芯片,整体算力高达1.1 EFLOP(百亿亿次浮点运算)的 BF16/CFP8 峰值算力,是目前已知算力的2.5到2.6倍,根据官方介绍下一代超级计算机预计有10倍以上提升。

-

-

2022年9月30日特斯拉 AI Day上公布的数据:

-

与英伟达的 A100 GPU 相比,每一颗 D1 芯片(配合特斯拉自研的编译器)在自动标注(auto-labeling)任务中最高能够实现 3.2 倍的计算性能,而在占用网络(occupancy network)任务中最高能够实现 4.4 倍的计算性能。

-

2022年 AI Day 上的说法,Dojo 的量产原本预计在2023年第一季度进行;(但很明显,Dojo 一直到2023年 7 月份才开始量产,出现了明显的延迟,原因是其降本不及预期。)

-

如果从总体目标来看,根据特斯拉官方的数据显示,在同样的成本之下,它所构建的 Dojo 超级计算机能够实现 4 倍的性能,能耗比提升 1.3 倍,计算系统的占地面积也会缩小为以往的 5 倍。

-

-

2023年 6 月份发布的算力发展规划,其帕洛阿尔托数据中心将建造7台Dojo ExaPOD。Dojo 将在2024年年第一季度成为全球排名前五的算力设施,并将在2024年年 10 月份达到 100 Exa-Flops 的超级算力(相当于30万块英伟达A100的算力总和)。

你可能会问Exa-Flops是个什么单位啊?简单来说呢,就是电脑每一秒的计算能力,Exa-Flops相当于每秒100亿一次运算,1后面18个零啊,听起来有点抽象对不对?那我们就从钱的角度来说,100Exa-Flops相当于30万片英伟达A100芯片的算力,之前很火的Chatgpt就是用A100芯片训练出来的,一块A100芯片卖1万美元左右,那么从价值上说,100Exa-Flops算力得花30亿美元去搭建。(100Exa-Flops相当于10万片英伟达H100芯片的算力,一块H100芯片卖35,000万美元左右,那么从价值上说,100Exa-Flops算力得花35亿美元去搭建。)

-

2023年6月,马斯克在 Twitter 上表示:Dojo V1 版本是面向大体量的视频训练而高度优化的,并非是面向通用目的 AI(general purpose AI);但 Dojo V2 将解决这样的限制。

-

2023年7月,推特(现 X)科技爆料账户 Whole Mars Catalog 爆料 Dojo 已经正式开始工作了。这一消息也得到了马斯克本人的点赞确认。这台超级计算机是今年夏天特斯拉在加州帕洛阿尔托的数据中心开始使用的第一台机器。

-

在2023年7月下旬的二季度电话会议中,马斯克表示没必要自造芯片,“如果英伟达能夠给我们足够的GPU,也许我们就不需要Dojo,但他们无法满足我们的需求。”马斯克特意表示,特斯拉会继续使用来自英伟达的硬件,也会同时推进 Dojo 项目,他还强调对黄仁勋和英伟达有巨大的「尊重」,因为他们做了让人难以置信的工作。

-

2023年8月29日,特斯拉 10000 块 H100 GPU 集群上线,加速 FSD V12 落地。拥有自家超算的和 H100 集群的特斯拉,正式入局算力军备竞赛!

-

2023年7月财报电话会议中,马斯克表示并不会对 Dojo 项目的支出进行公开,但表示2024年会投入 10 亿美元在 Dojo 项目上。

-

2023年9月10日,“特斯拉铁粉”、摩根士丹利汽车首席分析师Adam Jonas带领的团队报告中表示,特斯拉用于训练自动驾驶汽车人工智能模型的超级计算机Dojo可能会给这家电动汽车制造商带来“不对称优势”,使其市值增加近6000亿美元。摩根士丹利表示,其半导体团队调查显示,特斯拉今年订购的D1芯片数量大约在4万到5万片之间。

-

据媒体2023年10月10日报道,特斯拉正在其位于德州奥斯汀的总部建造一座新的碉堡式建筑,知情人士称,该大楼建成后,将安装一台Dojo新型超级计算机的一部分。特斯拉正在组装这台超级计算机,以帮助运行其汽车自动驾驶功能背后的人工智能(AI)软件。

-

在自研的重要节点上,2023年11月,负责Dojo超算项目的负责人、同时也是特斯拉自动驾驶硬件高级总监加内什·文卡塔拉马南(Ganesh Venkataramanan)离职,职位由前苹果高管彼得·班农(Peter Bannon)负责。彼时有消息称,很可能是因为Dojo第二代芯片未达标,加内什遭到解雇。

-

加内什此前负责特斯拉Dojo超算项目已达5年,在进入特斯拉之前,他曾在美国知名半导体公司AMD任职近15年。

-

加内什的离职,被认为是特斯拉自研芯片不力,或者没有设想中那么顺利。

-

-

-

2024年

1月16日,资深科技博主汉斯·尼尔森(Hans Nelson)认为,Dojo目前算力能达到33exaflops,至于如何在10月达到100exaflops,以及目前的算力中使用的自研芯片和英伟达芯片各自占比,则无从得知。但可以肯定的是,无论Dojo是否能按照时间表实现算力目标,马斯克囤积了足够的H100GPU。

-

1月26日,纽约州州长凯西·霍楚(Kathy Hochul)称,特斯拉将投资5亿美元(相当于约 1 万颗 H100 GPU),在该州的布法罗市(Buffalo)建造一台Dojo超级计算机。

马斯克很快证实了这一消息,但他补充说,特斯拉正在加大对 NVIDIA 硬件的投资:

州长说这是一台 Dojo 超级计算机,这是正确的,但 5 亿美元虽然显然是一大笔钱,但只相当于 Nvidia 的 10k H100 系统。特斯拉今年在英伟达硬件上的支出将超过这一数字。目前,在人工智能领域保持竞争力每年至少需要数十亿美元。

-

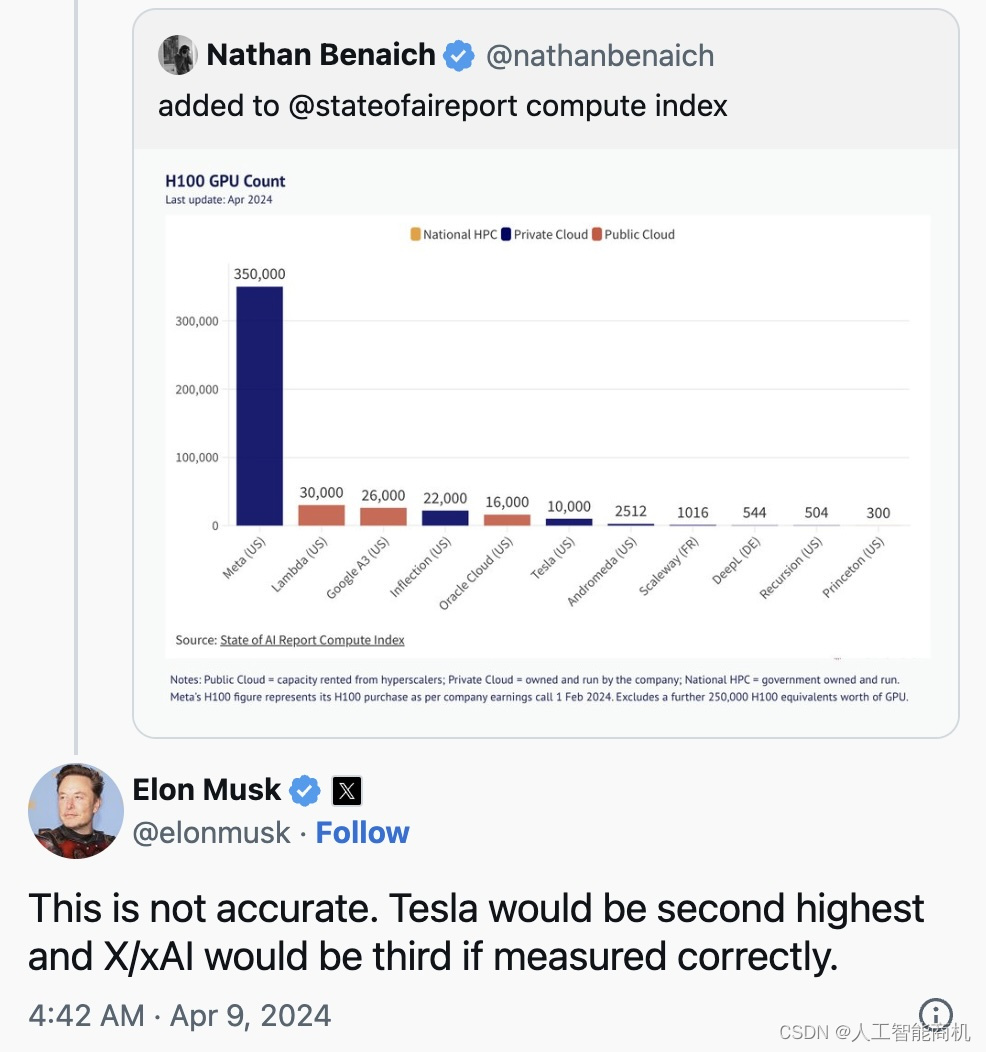

4月8日,X 平台用户“The Technology Brother”发布的囤积英伟达H100GPU排行榜上,Meta以35 万块位居第一。马斯克对该排行榜将特斯拉和 xAI 1万块的排名表示不满,并指出“如果计算正确,特斯拉应该是第二名,xAI 将是第三名”。这意味着特斯拉可能拥有 3 万到 35 万颗 H100 GPU,xAI 则可能拥有大约 2.6 万到 3 万颗。马斯克称,在人工智能领域保持竞争力,每年至少需要投入数十亿美元,并将会扩大购买英伟达竞争对手AMD的产品。

-

一位网名为 “whydoesthisitch”的网友认为,Dojo的算力规模要达到100 exa flops,估计要延至2027-2028年,而那时主流的云服务商比如亚马逊的算力已经达到zettaflop级别。他称,目前Dojo的芯片性能其实只能达到H100的10%-35%,当它追上H100时,英伟达已经在新一代的Blackwell 上奔跑很远。

-

特斯拉当地时间4月23日公布一季度业绩,作为2024 年第一季度财报的一部分,特斯拉透露其人工智能训练能力已增至近 4 万个英伟达 H100 GPU 等效单位,完全符合埃隆-马斯克(Elon Musk)之前定下的目标。

-

埃隆-马斯克(Elon Musk)透露了他在人工智能方面的真正雄心壮志:到 2024 年底,特斯拉的人工智能训练计算能力将同比增长约 467%,达到 85000 等效单位的NVIDIA H100 GPU。这种激进的扩张已经迫使特斯拉牺牲其自由现金流。

作为2024 年第一季度财报的一部分,这家电动汽车巨头透露,"受第一季度库存增加 27 亿美元和人工智能基础设施资本支出 10 亿美元的影响,该季度自由现金流为-25 亿美元。"

-

4 月中旬,特斯拉位于德克萨斯州奥斯汀的数据中心的进度落后于计划。计划中的 Dojo 超级计算机站点受到了问题的困扰,首席执行官埃隆·马斯克 (Elon Musk) 对这些延误感到“愤怒”,马斯克解雇了施工经理。

-

4月底的台积电北美技术研讨会上不太引人注目的花絮之一是,特斯拉宣布用于人工智能训练的 Dojo 晶圆系统处理器现已投入量产,并有望很快部署。

-

4月28日,下午刚刚抵达北京的特斯拉CEO马斯克在社交媒体上表示,“今年特斯拉将会投资约100亿美元用于AI的训练和推理,而推理主要用于汽车。”

-

马斯克还补充道,任何支出达不到每年100亿美元水平或者无法高效部署的公司,都无法在市场上竞争。

-

附录2:英伟达A100/H100和D1的算力对比

-

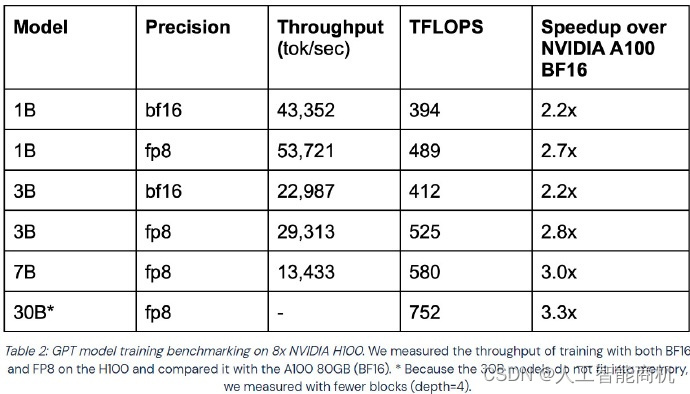

H100是A100的3倍算力。如下图,H100的峰值算力是A100的3倍;H100和A100在训练GPT时的性能比较:H100是A100的2-3倍。

-

D1和A100的算力差不多,但是性能是3~4倍。所以,可以认为1颗D1等效1颗H100。

H100是A100的3倍算力

| Specification | A100 | D1 | H100 SXM | |

| Architecture | Ampere | Hopper | ||

| Release Year | 2020 | 2021 | 2022 | |

| FP64 | 9.7 TFLOPS | 34 TFLOPS | H100是A100的3倍 | |

| FP64 Tensor Core | 19.5 TFLOPS | 67 TFLOPS | ||

| FP32 | 19.5 TFLOPS | 22.6 TFPLOPS | 67 TFLOPS | H100是A100的3倍 |

| TF32 Tensor Core | 312 TFLOPS(sparsity) 156 TFLOPS | 989 TFLOPS(sparsity) | ||

| BFLOAT16 Tensor Core | 624 TFLOPS(sparsity) 312 TFLOPS (实际算力150 TFLOPS) | 362 TFPLOPS | 1,979 TFLOPS(sparsity) 989.5 TFLOPS (推测实际算力450TFLOPS) | H100是A100的3倍; 由于在具体任务中,D1是A100的3~4倍,所以,可以认为 1颗D1等效1颗H100。 |

| FP16 Tensor Core | 624 TFLOPS(sparsity) 312 TFLOPS | 1,979 TFLOPS(sparsity) | ||

| FP8 Tensor Core | Not applicable | 3,958 TFLOPS(sparsity) | ||

| INT8 Tensor Core | 1248 TOPS(sparsity) | 3,958 TOPS(sparsity) | ||

| Area | 826 mm² | 645mm² | 814mm² | |

| CUDA® Cores | 6,912 | 354 Dojo core | 16,896 | |

| Max thermal design power (TDP) | 400W | 400W | Up to 700W (configurable) | |

| Process | 7nm | 7nm (D2 5nm) | 4nm |

来源:https://resources.nvidia.com/l/en-us-gpu

表1 H100是A100的3倍;由于在具体任务中,D1是A100的3~4倍,所以,可以认为1颗D1等效1颗H100

NVIDIA A100 WhitePaper 中给出 BF16 Tensor Core 的算力为 312 TFLOPS[18],但是实际上算力一般在 130 到 180 TFLOPS 中间,这里我们取中间值 150 TFLOPS[18]。

进一步计算,NVIDIA H100 WhitePaper 上给出 BF16 1979 TFLOPS,因为这个指标包含了 sparsity,实际稠密算力大约在 1000 TFLOPS。对比 A100,差不多有 3 倍的增长[18]。

H100和A100在训练GPT时的性能比较:H100是A100的2-3倍。

D1和A100的算力差不多,但是性能是3~4倍

从物理算力来说,D1比A100稍高一点,相差无几(116%,362/312)。H100是A100的3倍(317%,989.5/312)。

从实际智驾任务来说,D1也是A100的3~4倍左右。所以,可以认为,实际算力和H100差不多。

Dojo的训练效率高于DGX A100,每个由25块D1芯片组成的"tile"的推理速度是30块A100的30倍,FSD的训练时间可以从一个月缩短到一周以内。相较于A100,Dojo在同等成本下性能提升了4倍,功耗降低了1.3倍,体积减小了5倍,同时网络训练速度提高了4.4倍,自动标注速度提高了3.2倍。

从成本角度来看,Dojo的建设成本仅为A100的六分之一。例如,实现100EFlops的算力需要30万块A100芯片,而使用91个ExaPOD(91x3000=27.3万颗D1芯片)的Dojo仅需大约12.5亿美元,节省了约50亿美元。

3000颗D1芯片和1000颗H100芯片形成1 Exa-Flops算力

特斯拉在2021年8月的AI Day上已经公布了3000颗D1芯片,形成1.1Exa-Flops(BF16/CFP8)算力。每颗芯片的363 TFLOPS(BF16/CFP8)是稠密算力,现在很难学英伟达,讲稀疏算力的故事,将指标提上去了。

目前,业界计算英伟达H100的算力是,通常采用的是1000 TFLOPS(BF16的989.5 TFLOPS的近似)。也就是说1000颗H100的芯片形成1 Exa-Flops(BF16/FP16)算力。

(注:仍然有人认为,英伟达芯片的实际测评算力只有宣传稠密算力的50%。)

2023年7月Inflection 公司宣布他们正在构建世界上最大的 AI 集群,包含 22000 张 NVIDIA H100,FP16 算力可以达到 22 exaFLOPS。

然而,英伟达的宣传材料中,256颗H100就组成了1 ExaFlop算力,为什么1颗多了4倍呢?稀疏化算力提升为2倍,BF16变成INT8算力再提升为2倍。这个计算方式我们呵呵就行了。

附录3:1台Dojo计算机如何组成

一台Dojo计算机叫ExaPOD,算力高达1.1Exa-Flops。每个ExaPOD包含10个机柜(Cabinets),每个机柜内置2个系统托盘(System Trays),每个托盘包含6个瓷片(Training Tiles),每个训练瓷片包含25个D1芯片。也就是说,1个Dojo计算机包含3000个D1芯片,拥有超过100万个训练节点,其中的定制硬件和软件可进一步提高D1芯片的效率,使其运算能力能达到1 EFLOP,即每秒10^18次浮点运算。

附录4:计数单位

我们目前所用的K、M、G、T、P、E等都是英文表示方法,分别是Kilo(10^3)、Mega(10^6)、Giga(10^9)、Tera(10^12)、(10^15)、Exa(10^18)。

(本文仅代表个人观点,和任何组织无关。)

参考资料:

1170

1170

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?