Requests: 让 HTTP 服务人类

- 相比urllib Requests 自称 “HTTP for Humans”,使用更简洁方便。

- Requests 继承了urllib的所有特性。Requests支持HTTP连接保持和连接池,支持使用cookie保持会话,支持文件上传,支持自动确定响应内容的编码,支持国际化的 URL 和 POST 数据自动编码。

- requests 的底层实现其实就是 urllib

安装方式

利用 pip 安装 或者利用 easy_install 都可以完成安装:

$ pip install requests

$ easy_install requests

基本GET请求(headers参数 和 parmas参数)

1. 最基本的GET请求可以直接用get方法

response = requests.get("http://www.baidu.com/")

# 也可以这么写

# response = requests.request("get", "http://www.baidu.com/")

2. 添加 headers 和 查询参数

- 如果想添加 headers,可以传入headers参数来增加请求头中的headers信息。如果要将参数放在url中传递,可以利用 params 参数。

import requests

kw = {'wd':'长城'}

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/54.0.2840.99 Safari/537.36"}

# params 接收一个字典或者字符串的查询参数,字典类型自动转换为url编码,不需要urlencode()

response = requests.get("http://www.baidu.com/s?", params = kw, headers = headers)

# 查看响应内容,response.text 返回的是Unicode格式的数据

print (response.text)

# 查看响应内容,response.content返回的字节流数据

print (respones.content)

# 查看完整url地址

print (response.url)

# 查看响应头部字符编码

print (response.encoding)

# 查看响应码

print (response.status_code)

- 使用response.text 时,Requests 会基于 HTTP 响应的文本编码自动解码响应内容,大多数 Unicode 字符集都能被无缝地解码。

- 使用response.content 时,返回的是服务器响应数据的原始二进制字节流,可以用来保存图片等二进制文件。

基本POST请求(data参数)

1. post方法

response = requests.post("http://www.baidu.com/", data = data)

2. 传入data数据

对于 POST 请求来说,我们一般需要为它增加一些参数。那么最基本的传参方法可以利用 data 这个参数。

import requests

formdata = {

"type":"AUTO",

"i":"i love python",

"doctype":"json",

"xmlVersion":"1.8",

"keyfrom":"fanyi.web",

"ue":"UTF-8",

"action":"FY_BY_ENTER",

"typoResult":"true"

}

url = "http://fanyi.youdao.com/translate?smartresult=dict&smartresult=rule&smartresult=ugc&sessionFrom=null"

headers={ "User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.103 Safari/537.36"}

response = requests.post(url, data = formdata, headers = headers)

print (response.text)

# 如果是json文件可以直接显示

print (response.json())

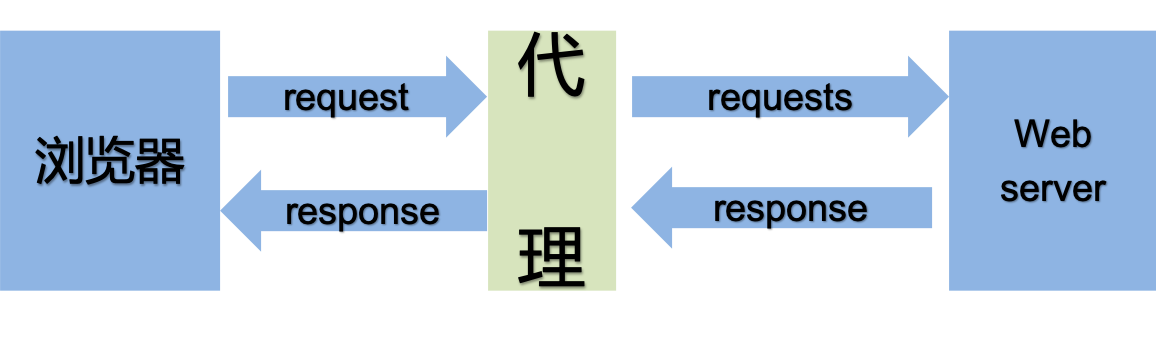

代理(proxies参数)

为什么使用代理

- 让服务器以为不是同一个客户端在请求

- 防止我们的真实地址被泄露,防止追究责任

- 如果需要使用代理,你可以通过为任意请求方法提供 proxies 参数来配置单个请求:

import requests

# 网站上寻找代理IP

proxies = {"http": "http://218.73.140.67:5293"}

headers = {"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_5) AppleWebKit/537.36 (KHTML, like Gecko) "

"Chrome/76.0.3809.132 Safari/537.36"}

r = requests.get("http://www.baidu.com", proxies=proxies, headers=headers)

print(r.status_code)

cookie和session的区别

- cookie数据存放在客户的浏览器中,session数据存放在服务器中

- cookie不安全,别人可以分析存放在本地中的cookie并进行cookie欺骗

- session会在一定时间保存在服务器中,当访问量增多时,会影响服务器的性能

- 单个cookie保存的数据不能超过4k

为什么要带上cookie和session

- 能够请求到登陆之后的页面

- 但是一个cookie和session往往和一个用户对应,如果请求太快和请求次数太多,会被服务器识别为爬虫。

- requests提供了一个session类,来实现客户端和服务端的会话保持

示例–实现人人网的登陆

import requests

# 1\. 创建session对象,可以保存Cookie值

ssion = requests.session()

# 2\. 处理 headers

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/54.0.2840.99 Safari/537.36"}

# 3\. 需要登录的用户名和密码

data = {"email":"mr_mao_hacker@163.com", "password":"alarmchime"}

# 4\. 发送附带用户名和密码的请求,并获取登录后的Cookie值,保存在ssion里

ssion.post("http://www.renren.com/PLogin.do", data = data)

# 5\. ssion包含用户登录后的Cookie值,可以直接访问那些登录后才可以访问的页面

response = ssion.get("http://www.renren.com/410043129/profile")

# 6\. 打印响应内容

print (response.text)

167

167

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?