最近工作需要使用大数据集群,所有搭建了一套大数据集群:hadoop3.3.6,spark-3.3.3-bin-hadoop3,hbase-2.5.5-hadoop3-bin,apache-zookeeper-3.7.1-bin.tar.gz和mongo集群,下面详细编写步骤:

准备三台阿里云服务器

设置修改hosts

# 所有节点都修改 hosts

vim /etc/hosts

192.168.1.117 node0

192.168.1.118 node1

192.168.1.120 node2

1、安装jdk

下载Linux版本jdk

tar -zxvf jdk-8u351-linux-x64.tar.gz -C /usr/local

vim /etc/profile

export JAVA_HOME=/usr/local/jdk1.8.0_351

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tool.jar

wq!

source /etc/profile

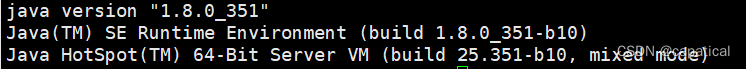

java -version

出现下面情况就是安装好Java环境

2、安装scala

下载scala

tar -zxvf scala-2.13.10.tgz -C /usr/local

export SCALA_HOME=/usr/local/scala-2.13.10

export PATH=$SCALA_HOME/bin:$PATH

wq!

source /etc/profile

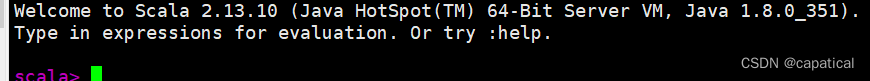

scala

3、新建用户

user add hadoop

passwd hadoop

4、切换到hadoop用户,配置免密

每台机器:

(1)ssh-keygen 然后四个回车

(2)ssh-copy-id 复制 到另外2台

5、安装hadoop

NameNode 和 SecondaryNameNode 不要安装在同一台服务器

ResourceManager 也很消耗内存,不要和 NameNode、SecondaryNameNode 配置在

同一台机器上。

hadoop解压到 /data/hadoop-3.3.6

配置: 修改 /data/hadoop-3.3.6/etc/hadoop 目录中的几个配置文件

hadoop-env.sh、yarn-env.sh文件

改动一处,设置JAVA_HOME路径

export JAVA_HOME=/usr/local/jdk1.8.0_351

core-site.xml 文件

<configuration>

<!-- 指定 NameNode 的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://node0:9000</value>

</property>

<!-- 指定 hadoop 数据的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/data/hadoop-3.3.6/data</value>

</property>

</configuration>

hdfs-site.xml文件

<configuration>

<!-- nn 外部访问地址-->

<property>

<name>dfs.namenode.http-address</name>

<value>node0:9870</value>

</property>

<!-- 2nn 外部访问地址-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node2:9868</value>

</property>

</configuration>

mapred-site.xml文件

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>node0:10020</value>

</property>

<!-- 历史服务器 web 端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node2:19888</value>

</property>

</configuration>

yarn-site.xml文件

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定 ResourceManager 的地址-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>gis192</value>

</property>

<!-- 环境变量的继承 -->

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 设置日志聚集服务器地址 -->

<property>

<name>yarn.log.server.url</name>

<value>http://node0:19888/jobhistory/logs</value>

</property>

<!-- 设置日志保留时间为 7 天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

</configuration>

workers

node0

node1

node2

配置环境变量

vim /etc/profile

export HADOOP_HOME=/data/app/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

:wq!

source /etc/profile

向各节点拷贝配置好的hadoop

使用scp命令拷贝即可

scp –r /data/hadoop-3.3.6 hadoop@node1:/data

scp –r /data/hadoop-3.3.6 hadoop@node2:/data

初始化HDFS文件系统

hdfs namenode -format

启动HDFS、YARN

# 全部启动

./start-all.sh

Web 端查看 HDFS 的 NameNode

(a)浏览器中输入:http://node0:9870

(b)查看 HDFS 上存储的数据信息

(5)Web 端查看 YARN 的 ResourceManager

(a)浏览器中输入:http://node1:8088

(b)查看 YARN 上运行的 Job 信息

6、安装zookeeper集群

下载linux版本3.7.1

tar -zxvf apache-zookeeper-3.7.1-bin.tar.gz -C /data/

mv apache-zookeeper-3.7.1-bin ./zookeeper

cd /data/zookeeper/conf

cp zoo_sample.cfg zoo.cfg

//修改 zoo.cfg 配置文件,将 dataDir=/data/zookeeper/data 修改为指定的data目录

vim zoo.cfg

dataDir=/data/zookeeper/data

server.5=node0:2888:3888

server.6=node1:2888:3888

server.7=node2:2888:3888

scp /data/zookeeper hadoop@node1:/data/

scp /data/zookeeper hadoop@node2:/data/

cd /data/zookeeper/data

vim myid

myid 为 5,6,7

启动

bin/zkServer.sh start

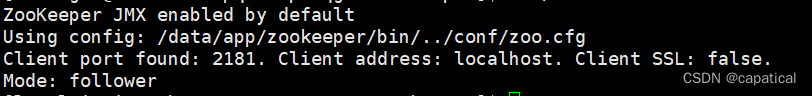

查看状态

bin/zkServer.sh status

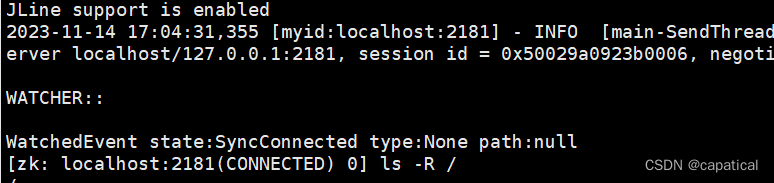

bin/zkCli.sh

7、spark 配置

下载spark

tar -zxvf spark-3.3.3-bin-hadoop3.tgz -C /data/

配置 /data/spark-3.3.3-bin-hadoop3/conf目录下

spark-env.sh

export JAVA_HOME=/usr/local/jdk1.8.0_351

export SCALA_HOME=/usr/local/scala-2.13.10

export SPARK_MASTER_HOST=node0

export SPARK_MASTER_PORT=7077

export HADOOP_CONF_DIR=/data/hadoop-3.3.6/etc/hadoop

works

node0

node1

node2

spark-defaults.conf

spark.master yarn

将项目传送两个节点

scp /data/spark-3.3.1-bin-hadoop2hadoop@node1:/data/

scp /data/spark-3.3.1-bin-hadoop2hadoop@node2:/data/

8、Hbase 配置

下载hbase2.5.5-hadoop3.x

hbase-2.5.5-hadoop3-bin.tar.gz

tar -zxvf hbase-2.5.5-hadoop3-bin.tar.gz -C /data/

修改配置文件

hbase-env.sh

export JAVA_HOME=/usr/local/jdk1.8.0_351

export HBASE_MANAGES_ZK=false

export HBASE_LOG_DIR=/data/hbase-2.5.5-hadoop3/logs

regionservers

node0

node1

node2

backup-master

node0

hbase-site.xml

<configuration>

<property>

<!-- hbase存放数据目录 -->

<name>hbase.rootdir</name>

<!-- 端口要和Hadoop的fs.defaultFS端口一致-->

<value>hdfs://node0:9000/hbase</value>

</property>

<property>

<!-- 是否分布式部署 -->

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<!-- list of zookooper -->

<name>hbase.zookeeper.quorum</name>

<value>node0:2181,node1:2181,node2:2181</value>

</property>

<property>

<!-- 临时文件路径,如果使用系统默认的tmp会被清除 -->

<name>hbase.tmp.dir</name>

<value>/data/hbase-2.5.5-hadoop3/tmp</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<!-- ZK数据文件路径 -->

<name>hbase.zoopkeeper.property.dataDir</name>

<value>/data/zookeeper/data</value>

</property>

</configuration>

启动

cd /data/hbase-2.5.5-hadoop3-bin

bin/start-hbase.sh

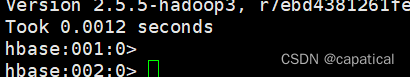

使用shell测试

hbase shell

9、mongo配置

mongodb的集群配置在前几天发布了下面是链接

https://blog.csdn.net/capatical/article/details/134284730

完毕!!!

有问题可以评论区讨论

1003

1003

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?