摘要:现有的基于学习的去雾方法容易造成去雾过度和去雾失败,主要是因为没有充分利用雾天图像的全局特征,而雾天图像的局部特征没有足够的区度,本文提出了一种递归上下文聚合网络(RCAN)来有效地去除图像的模糊并恢复颜色保真度。在RCAN,一种被称为上下文侵犯块(CAB)的高效通用模块被设计为通过利用全局和局部特征来改进特征表示,全局和局部特征对于鲁棒去雾是互补的,因为局部特征可以捕捉不同级别的雾度,而全局特征可以关注整个图像的纹理和对象边缘。此外,RCAN采用深度递归机制来提高去雾性能,而不引入额外的网络参数。在合成数据集和真实数据集上的大量实验结果表明,所提出的RCAN比其他最先进的去雾方法性能更好。

I.INTRODUCTION

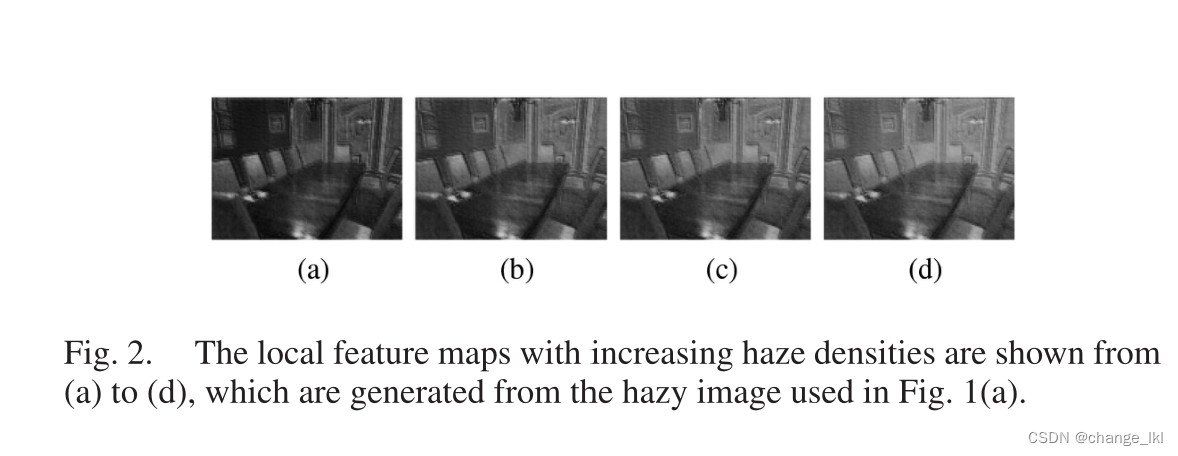

在本文中介绍了一种新的循环上下文聚合网络(RCAN)来有效地去除图像中的模糊。在RCAN,我们设计了一个有效的通用组件,称为上下文聚合块(CAB),通过结合局部特征和全局特征来增强特征的表示。一方面,全局特征集中于整个图像的颜色和纹理以及物体的边缘,提供了全局的视觉感知。另一方面,局部特征包含了局部的颜色和纹理,可以细化全局的颜色和纹理,达到视觉上更愉悦的感知,恢复图像细节。如图1所示,我们可以观察到图1(b)中的全局特征图主要集中在物体的边缘,并且它捕捉了模糊图像的全局颜色和纹理。相反,图1(c)中的局部特征图关注于模糊图像的局部颜色和纹理。因此,关于颜色和纹理的局部和全局特征是互补的,以改善视觉感知。同时,局部特征鲁棒地捕捉不同水平的雾度,这有利于图像去雾。随着从图2(a)到(d)的图像中雾度密度的增加,由局部特征聚焦的区域(即,白化区域)的权重增加,这提高了去雾处理的鲁棒性。

此外,RCAN在没有引入额外网络参数情况下,采用深度循环机制去改善去雾表现。

本文贡献:

(1)提出了一种新的端到端网络RCAN,它采用深度递归机制来有效地去除图像中的模糊并恢复颜色的保真度。RCAN在合成和真实数据集上都生成了最先进的去雾结果。

(2)我们提出了一个有效的CAB,它结合了全局和局部特征,以改善特征表示和获得更好的愉快感知。

II. PROPOSED METHOD

A. Context Aggression Block

全局特征集中于整个图像的颜色和纹理,可以提供全局的视觉感知。而局部特征包含局部颜色和局部纹理,可以细化全局颜色和全局纹理,达到视觉上更愉悦的感知,恢复更多的图像细节。我们设计了一个新颖的,后面跟着一个增强器,如图4所示。对于过度去雾,两个分支提取的特征组合覆盖了雾天图像中丰富的颜色和雾天信息,可以有效缓解过度去雾,提供视觉上的愉悦感受。对于未能识别出重度雾霾的情况,我们将组合后的特征输入到增强器中,以提高稠密雾霾的识别率。详细地说,全局分支由non-local块(见连接1)和SE (见连接2)块组成。局部分支由一个3×3卷积层组成。并且增强器包含三个卷积层,紧密相连,后面是一个1×1卷积层进行降维。

B. Recurrent Block

受特征金字塔(链接3)的启发,我们设计了递归块的结构,如图5所示。在循环块中,我们使用下采样和上采样操作来利用多尺度雾相关特征。具体来说,与特征金字塔相比,我们结合CAB和采样操作(即下采样或上采样)来代替简单的卷积层,卷积层在特征金字塔中广泛用于上采样和下采样特征图。这可以大大提高多尺度雾相关特征的表示能力。

详细地说,图像特征图首先被馈送CAB,然后以因子2对其进行下采样。然后,向下采样的输出被馈CAB,输出被向上采样到原始大小。RB的输入和RB的输出的逐元素相加也用于残差学习。

C、Overall Architecture

如图3所示,RCAN包含编码器、推理模块和解码器。增加网络深度是提高网络性能最常用的策略之一。但是这样的方式也会大大增加参数的数量,可能会产生过拟合的问题。为了缓解这个问题,我们在推理模块中采用了深度递归机制。推理模块由递归展开的RB组成,RB的权重是共享的。增加递归深度,在不引入新参数的情况下提高去雾性能,很好地缓解了过拟合。详细地说,编码器包括三个卷积运算,每个卷积运算之后都有一个ReLU非线性激活函数。第一个卷积层采用7×7内核,接下来的两个卷积层采用3×3内核。对于三个卷积层中的每一个,通道的数量是64。对于解码器,推理模块的输出首先被上采样到原始大小,然后被馈送到具有全局残差连接的7×7卷积层,以重建雾图像。

D. Loss Function

在我们的方法中,我们利用感知损失、损失和负SSIM损失的组合来训练RCAN。感知损失用于增强精细特征并保留原始颜色信息。

损失用于鼓励去雾图像和地面真实之间的像素级一致性。负SSIM损失用于鼓励去雾图像和地面真实之间的结构相似性。

Perceptual Loss(感知损失):

我们使用感知损失来计算有雾图像与其对应的去雾图像之间的特征级别差异。基于用于图像分类的VGG16网络,感知损失被定义为:

代表VGG16的第i层,

代表去雾的图像,

,

和

,表示第I个特征图的尺寸。

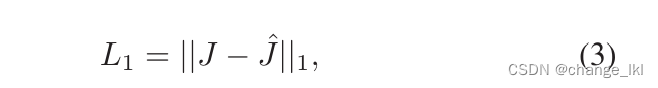

L1 Loss:

它计算由建议的RCAN估计的无雾图像和地面真实情况之间的像素级差异。

Negative SSIM Loss:

SSIM是图像恢复常用的评价标准,它计算两幅图像之间的相似度。我们的目标是最大化SSIM。因此,我们将负SSIM损耗定义为:

Total Loss:

链接:

链接1

https://arxiv.org/pdf/1711.07971v3.pdf

链接2 https://arxiv.org/pdf/1709.01507v4.pdf

链接 3 https://arxiv.org/pdf/1612.03144v2.pdf

VGG16网络 http://t.csdn.cn/UkKCZ

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?