感谢DT大数据梦工厂支持提供以下内容,

DT大数据梦工厂专注于Spark发行版定制。详细信息请查看

联系邮箱18610086859@126.com

电话:18610086859

QQ:1740415547

微信号:18610086859

IMF晚8点大数据实战YY直播频道号:68917580

一、解密SparkStreaming运行机制

Spark Streaming更像Spark Core上的一个应用程序

启动时会生成许多Job

Receiver启动时会启动一个Job

DStream就是在RDD的基础上加上了时间维度。

Spark Streaming以时间维度进行解耦

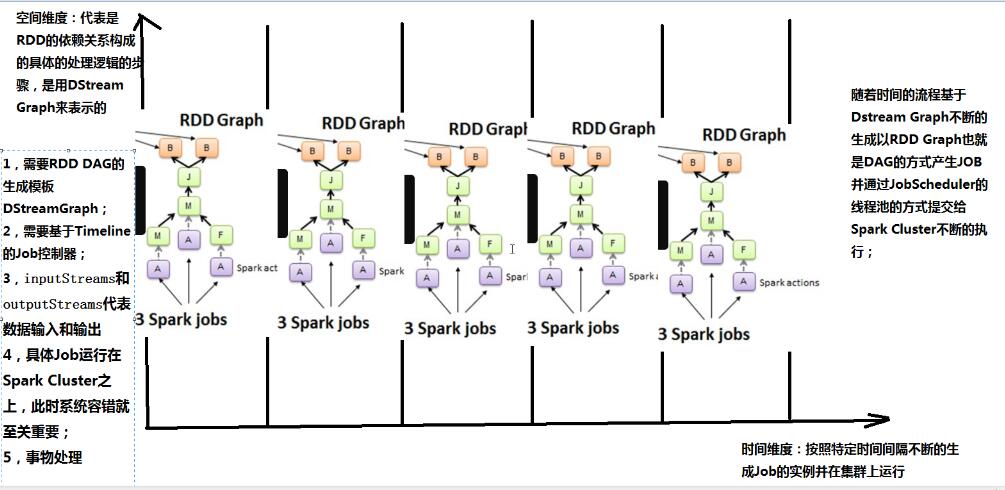

可以将Spark Streaming放在坐标系中。其中Y轴就是对RDD的操作,RDD的依赖关系构成了整个job的逻辑,而X轴就是时间。随着时间的流逝,固定的时间间隔(Batch Interval)就会生成一个job实例,进而在集群中运行。

Spark Streaming中不断的流入数据,通过batch interval的方式进行数据积攒,如:1秒钟进行一次处理,则在一秒钟内会产生若干Event,Event中就是数据集合。基于batch产生DAG依赖关系。

DStream Graph 就是RDD Graph的模板。

RDD与DStream的关系如下

(1). RDD是物理级别的,而 DStream 是逻辑级别的

(2). DStream是RDD的封装类,是RDD进一步的抽象

(3). DStream 是RDD的模板。DStream要依赖RDD进行具体的数据计算

二、SparkStreaming架构

Spark大数据分析框架的核心部件: spark Core、spark Streaming流计算、GraphX图计算、MLlib机器学习、Spark SQL、 SparkR计算引擎等主要部件.

Spark Streaming 更像是构建在spark core之上的一个应用程序,要构建一个强大的Spark应用程序 ,spark Streaming是一个值得借鉴的参考,spark Streaming涉及多个job交叉配合,基本涉及到了spark的所有的核心组件,精通掌握spark streaming是至关重要的。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?