LobeChat是一个开源的、现代设计的 ChatGPT/LLM UI/框架。支持语音合成、多模态和可扩展(函数调用)插件系统。一键免费部署您的私人 OpenAI ChatGPT/Claude/Gemini/Groq/Ollama 聊天应用程序。

一:实现对本地大语言模型的支持

实现对以下模型服务提供商的支持:

1、AWS Bedrock:集成 AWS Bedrock 服务,支持 Claude/LLama2 等模型,提供强大的自然语言处理能力。

2、Anthropic (Claude):接入 Anthropic 的 Claude 系列机型,包括 Claude 3 和 Claude 2,在多模态能力和扩展上下文方面取得突破,树立了新的行业标杆。

3、Google AI(Gemini Pro、Gemini Vision):访问 Google 的 Gemini 系列型号,包括 Gemini 和 Gemini Pro,以支持高级语言理解和生成。

4、Groq:访问 Groq 的 AI 模型,高效处理消息序列并生成响应,能够进行多回合对话和单次交互任务。

5、OpenRouter:支持Claude 3、Gemma、Mistral、Llama2、Cohere等机型路由,智能路由优化提升使用效率,开放灵活。

6、01.AI(Yi Model):集成 01.AI 模型,具有快速推理速度的一系列API,不仅缩短了处理时间,还保持了出色的模型性能。

7、Together.ai:Together Inference API 提供了 100 多个领先的开源聊天、语言、图像、代码和嵌入模型。对于这些型号,您只需按实际使用量付费。

8、ChatGLM:新增直普艾ChatGLM系列机型(GLM-4/GLM-4-vision/GLM-3-turbo),为用户提供了另一种高效的对话模式选择。

9、Moonshot AI (Dark Side of the Moon):与来自中国的创新型 AI 初创公司 Moonshot 系列模型集成,旨在提供更深入的对话理解。

二:模型视觉识别

LobeChat 现在支持 OpenAI 最新的 gpt-4-vision 模型,具有视觉识别功能, 一种可以感知视觉效果的多模态智能。用户可以轻松地将图像上传或拖放到对话框中, 代理将能够识别图像的内容,并在此基础上进行智能对话, 打造更智能、更多样化的聊天场景。

此功能开辟了新的交互方式,使交流能够超越文本并包含丰富的视觉元素。 无论是在日常使用中共享图像,还是在特定行业中解释图像,代理都能提供出色的对话体验。

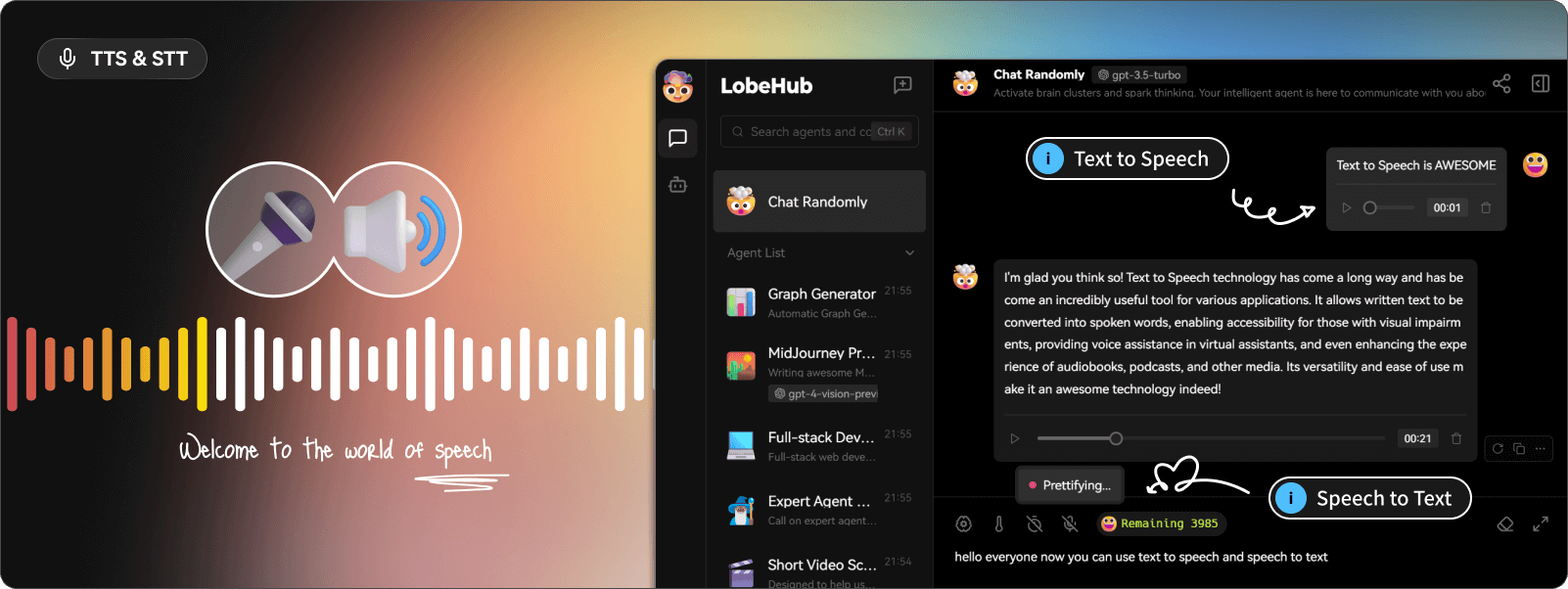

三:TTS & STT 语音对话

LobeChat 支持文本转语音 (TTS) 和语音转文本 (STT) 技术,使我们的应用程序能够将文本消息转换为清晰的语音输出, 允许用户与我们的对话代理进行交互,就好像他们正在与真人交谈一样。用户可以从各种语音中进行选择,以便与代理配对。

此外,TTS 为那些喜欢听觉学习或希望在忙碌时接收信息的人提供了一个出色的解决方案。 在LobeChat中,我们精心挑选了一系列高质量的语音选项(OpenAI Audio,Microsoft Edge Speech),以满足来自不同地区和文化背景的用户的需求。 用户可以选择适合个人喜好或特定场景的语音,从而获得个性化的通信体验。

四:文本到图像生成

通过支持最新的文本到图像生成技术,LobeChat 现在允许用户直接在与代理的对话中调用图像创建工具。通过利用 DALL-E 3、MidJourney 和 Pollinations 等 AI 工具的功能,代理现在可以将您的想法转化为图像。

这实现了更加私密和身临其境的创作过程,允许将视觉叙事无缝集成到您与代理的个人对话中。

五:插件系统(函数调用)

LobeChat的插件生态系统是其核心功能的重要扩展,大大增强了LobeChat助手的实用性和灵活性。

六:本地部署LobeChat

安装pnpm

#安装pnpm

curl -fsSL https://deb.nodesource.com/setup_18.x | sudo -E bash - && apt-get install -y nodejs

#安装pnpm

npm install pnpm -g克隆代码并安装

$ git clone https://github.com/lobehub/lobe-chat.git

$ cd lobe-chat

$ pnpm install

$ pnpm dev七:本地安装Ollama

1、安装ollama

curl -fsSL https://ollama.com/install.sh | sh

2、运行ollama

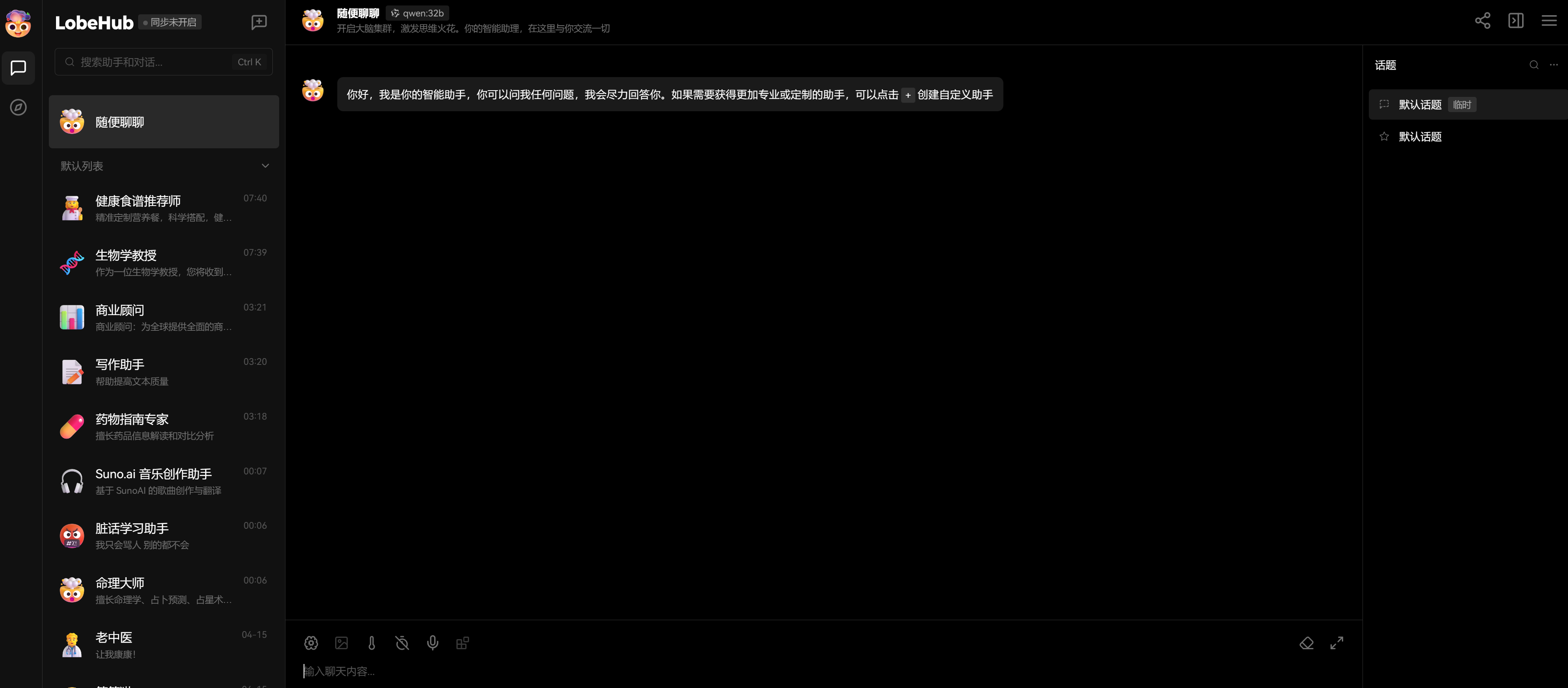

因为我们使用简体中文的原因,所以大模型选择了通义千问,当然也可以使用moonshot。如果使用英文,也可以选openai。运行如下:

ollama run qwen:4b八:配置LobeChat

在lobechat设置里面,选择语言模型。配置openai,因为ollama支持openai的api格式,所以这里可以直接填写通义千问的参数:

OpenAI API Key:输入123(随便输入)

接口代理地址:http://localhost:11434/v1

模型列表:qwen:4b(或7b,14b,32b,72b,根据自己显卡的能力选择相应模型)。

然后在默认助手那里,选择默认的大模型,如下图:

九:访问页面

http://localhost:3010

注意:localhost要换成服务器的具体IP地址。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?