安装 Triton Docker 镜像

在拉取镜像前,需要安装 Docker 和 NVIDIA Container Toolkit。

用以下命令拉取镜像

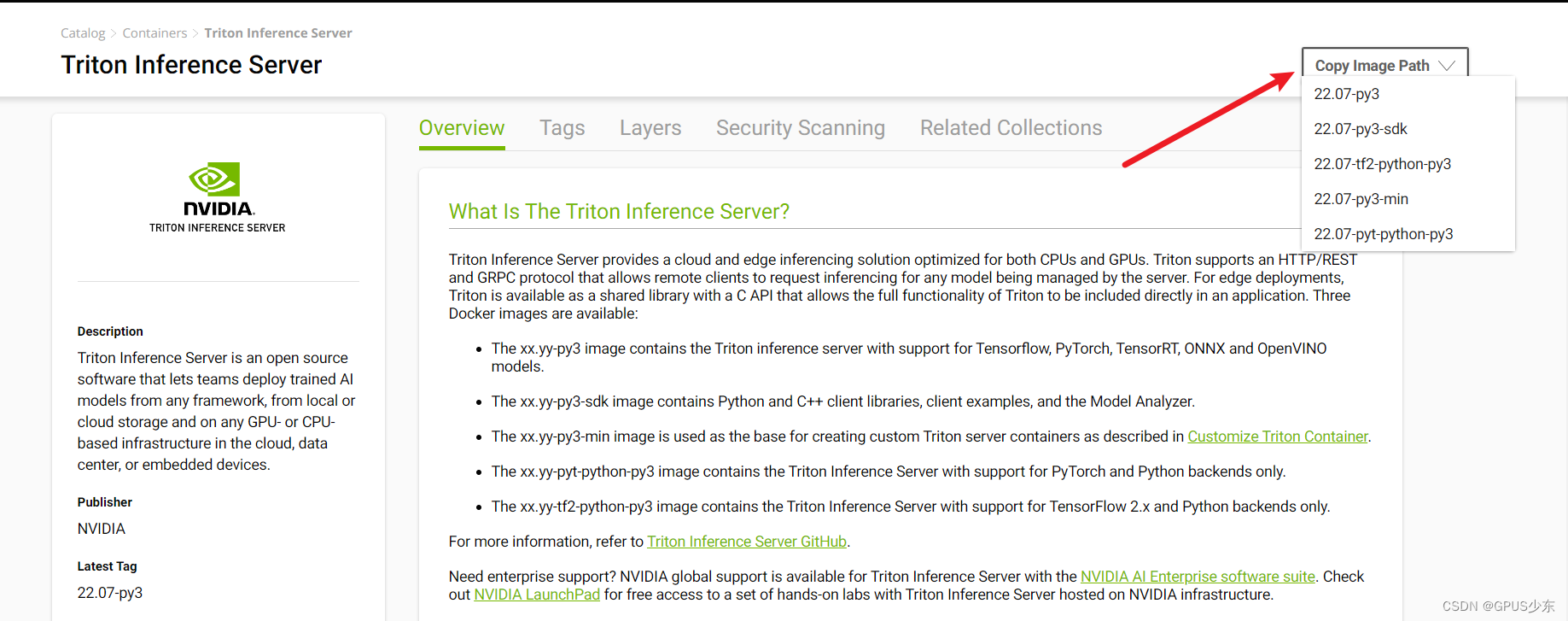

$ docker pull nvcr.io/nvidia/tritonserver:<xx.yy>-py3

其中 <xx.yy> 为镜像的版本,可在 NVIDIA NGC 上获得

准备示例模型库

模型库是一个目录,里面以一定的结构储存着数个模型。官方的示例模型库在 docs/examples/model_repository,启动 triton 前还需运行 fetch_models.sh 以获得完整的示例模型。

$ git clone https://github.com/triton-inference-server/server.git

$ cd server/docs/examples

$ ./fetch_models.sh

运行 Triton

使用以下命令启动 triton。其中 --gpus 表示给这个容器分配几个 GPU ,/full/path/to/docs/examples/model_repository 替换为模型库的完整路径,<xx.yy> 替换为镜像版本。

$ docker run --gpus=1 --rm --net=host -v /full/path/to/docs/examples/model_repository:/models nvcr.io/nvidia/tritonserver:<xx.yy>-py3 tritonserver --model-repository=/models

启动 triton 后,当终端上有以下输出时,表示 triton 已准备好接受推理请求。

+----------------------+---------+--------+

| Model | Version | Status |

+----------------------+---------+--------+

| densenet_onnx | 1 | READY |

| inception_graphdef | 1 | READY |

| simple | 1 | READY |

| simple_dyna_sequence | 1 | READY |

| simple_identity | 1 | READY |

| simple_int8 | 1 | READY |

| simple_sequence | 1 | READY |

| simple_string | 1 | READY |

+----------------------+---------+--------+

...

...

...

I1002 21:58:57.891440 62 grpc_server.cc:3914] Started GRPCInferenceService at 0.0.0.0:8001

I1002 21:58:57.893177 62 http_server.cc:2717] Started HTTPServ

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?