第五周周报

一、摘要

这周主要工作包括日常做python例题,CNN理论课,然后在B站跟读了一篇论文的一半,但是论文好像读歪了。

二、卷积神经网络

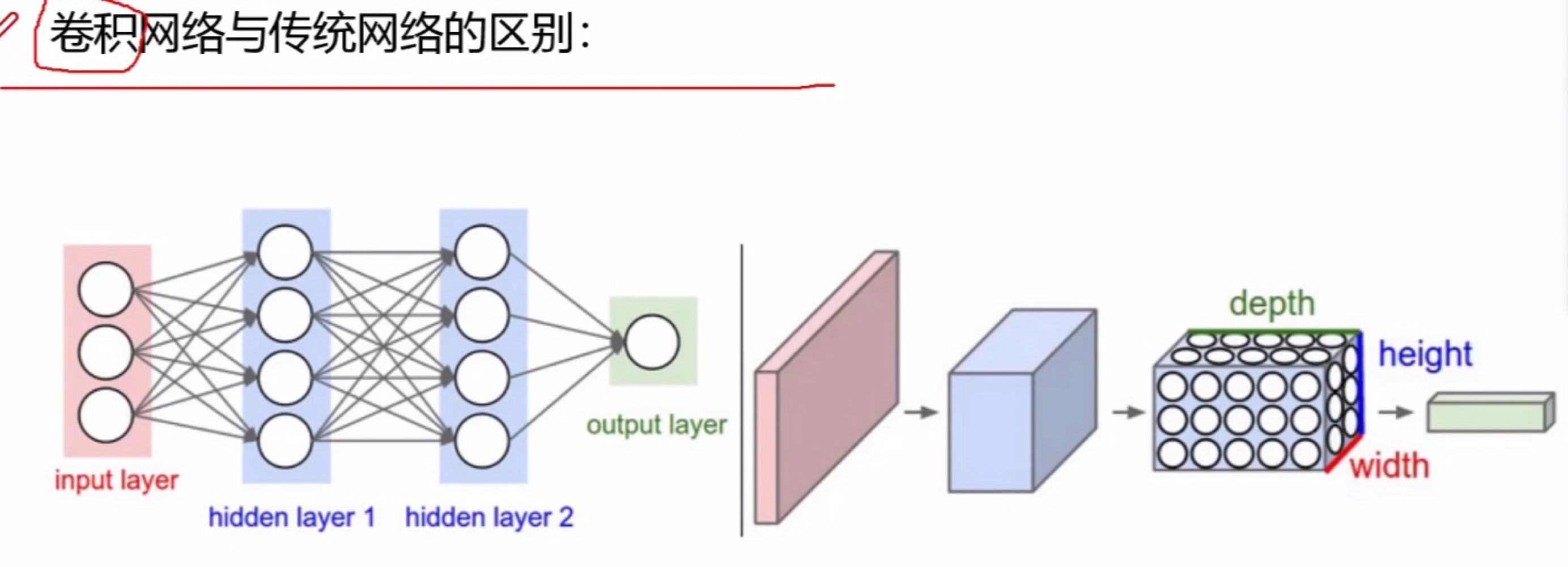

2.1卷积网络跟传统网络的区别

传统网络的输出数据跟卷积网路输出不同,卷积网络输出可以是一个三维原始图像。

传统网络的输出数据跟卷积网路输出不同,卷积网络输出可以是一个三维原始图像。

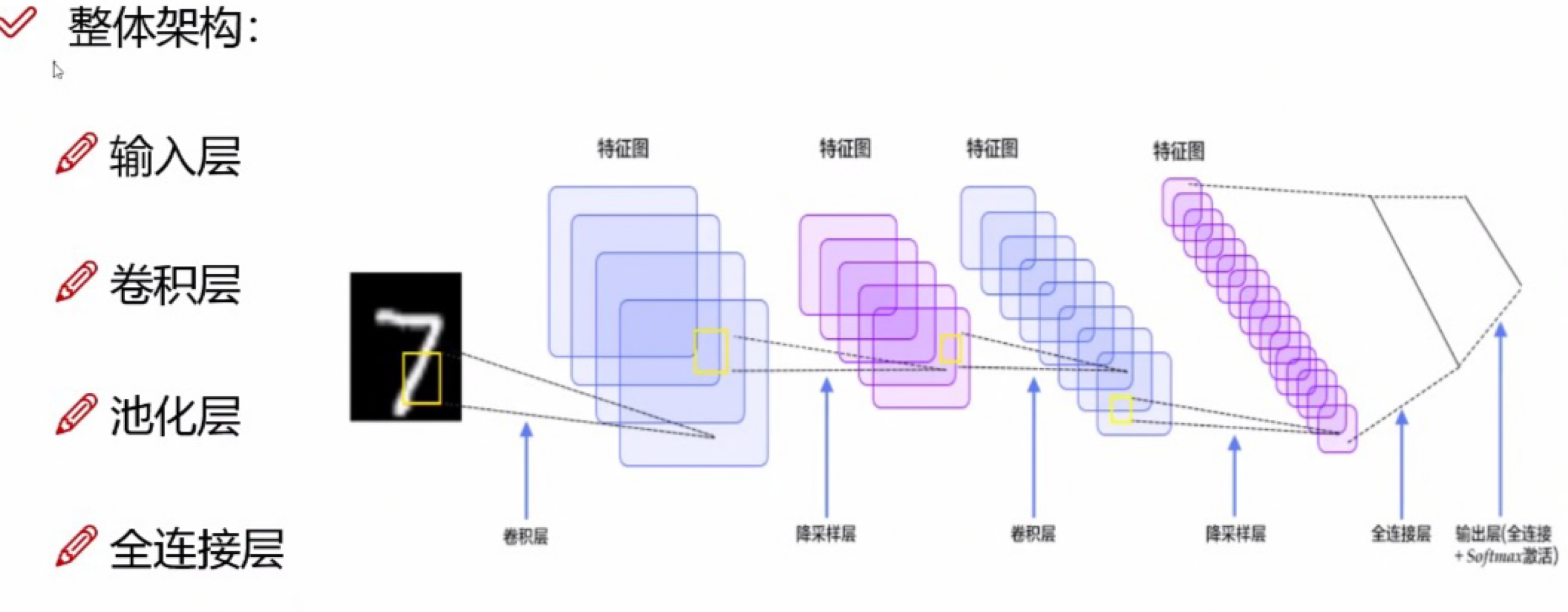

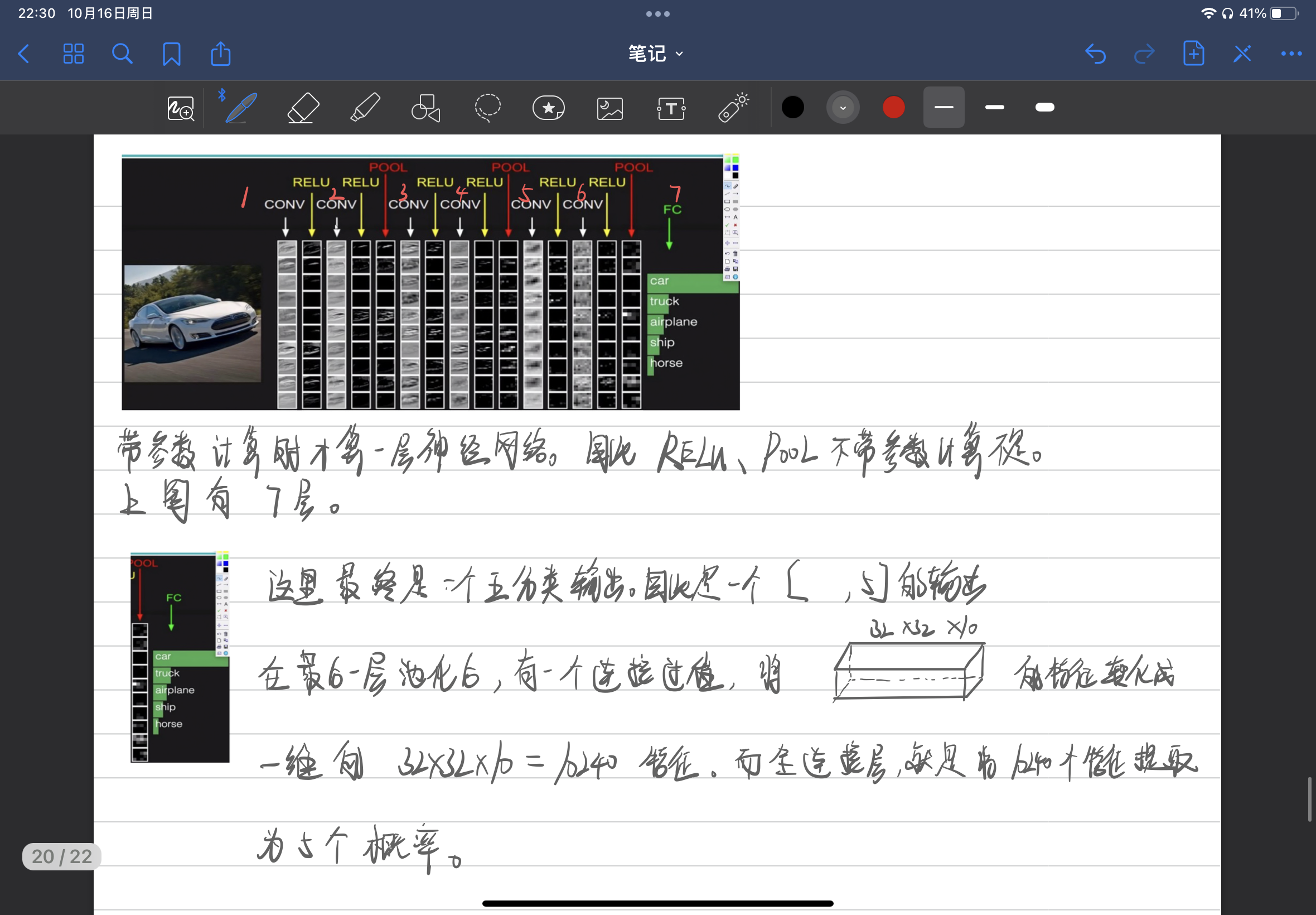

2.2卷积神经网络整体架构

‘

‘

2.3卷积层

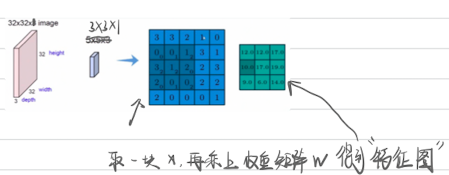

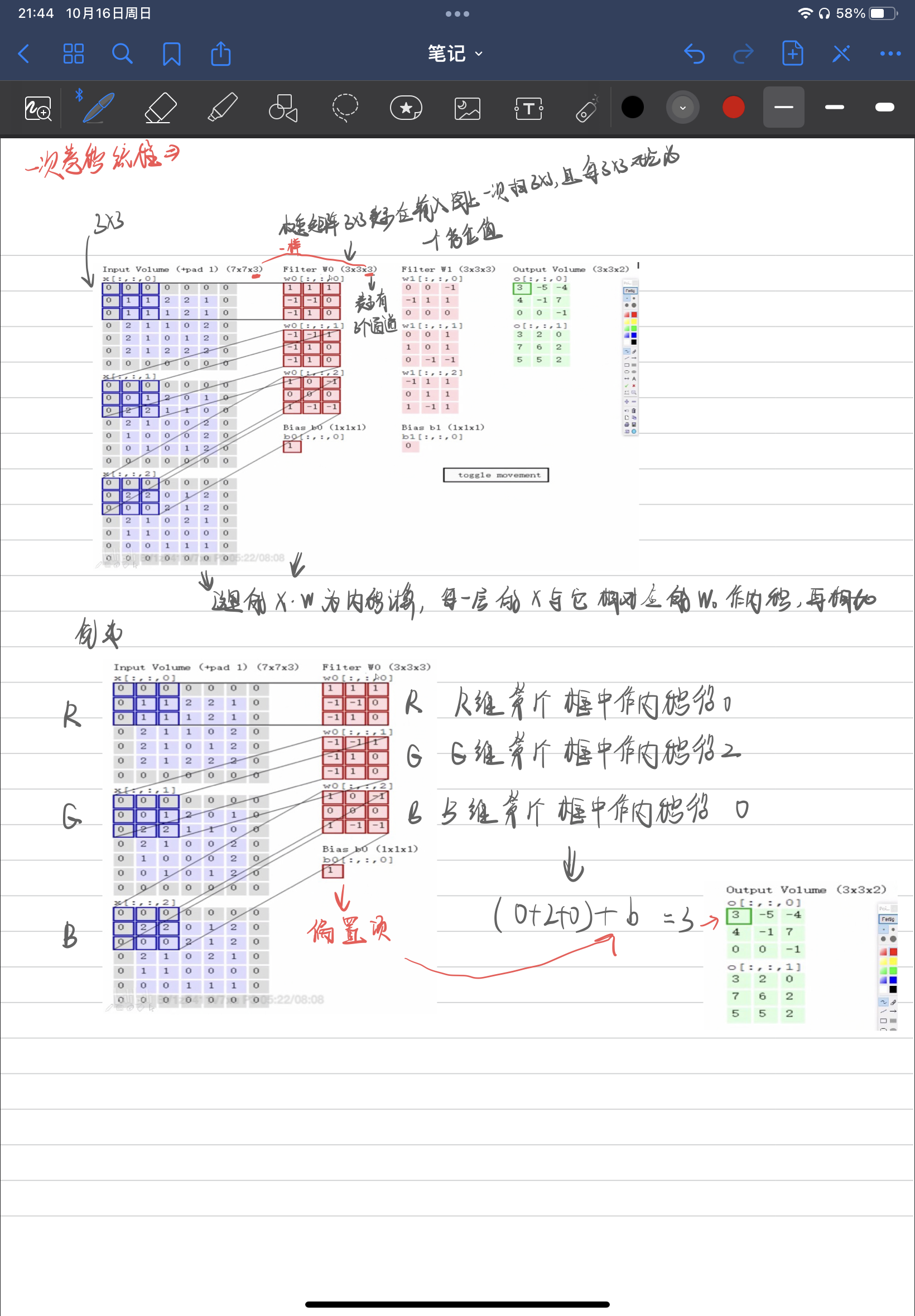

卷积做了什么

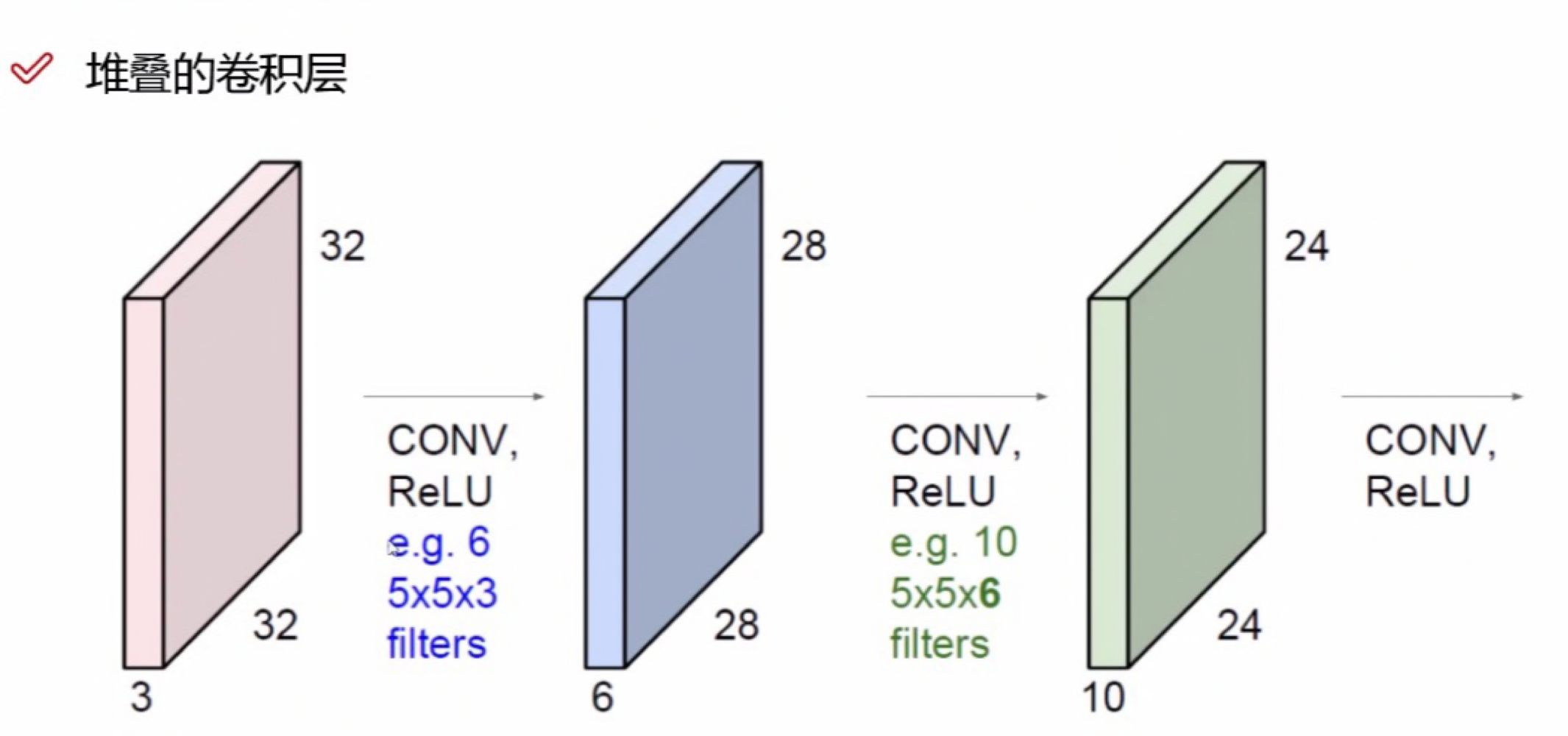

在堆叠的卷积层中,上一层的卷积核的个数为下一层特征的层数,上一层的厚度必须跟卷积核的厚度一致。类似上面图中RGB颜色通道的解释一样。在下图中,32X32X3的输出经过5X5X3的6个卷积核卷积后的到28X28X6的特征,那么28X28X6的特征下一层卷积的卷积核的厚度必须是6,并且有几个卷积核,再一下层的特征就有多厚。

在堆叠的卷积层中,上一层的卷积核的个数为下一层特征的层数,上一层的厚度必须跟卷积核的厚度一致。类似上面图中RGB颜色通道的解释一样。在下图中,32X32X3的输出经过5X5X3的6个卷积核卷积后的到28X28X6的特征,那么28X28X6的特征下一层卷积的卷积核的厚度必须是6,并且有几个卷积核,再一下层的特征就有多厚。

卷积中的参数

滑动窗口步长

滑动窗口步长即在输入上扫描时框移动的步长。步长越小,扫描次数越多,得到的特征图越大。但在一些情况下并不是滑动步长越小越好,比如在扫描文本「我今天吃了一斤米饭」(1X9),那么扫描的步长可以设置为3可以更快的处理完。一般自己训练的时候设置为1

卷积核尺寸

即扫描输入时框的大小。卷积核尺寸越大,扫描次数越少,得到的特征图也就越小。

边缘填充

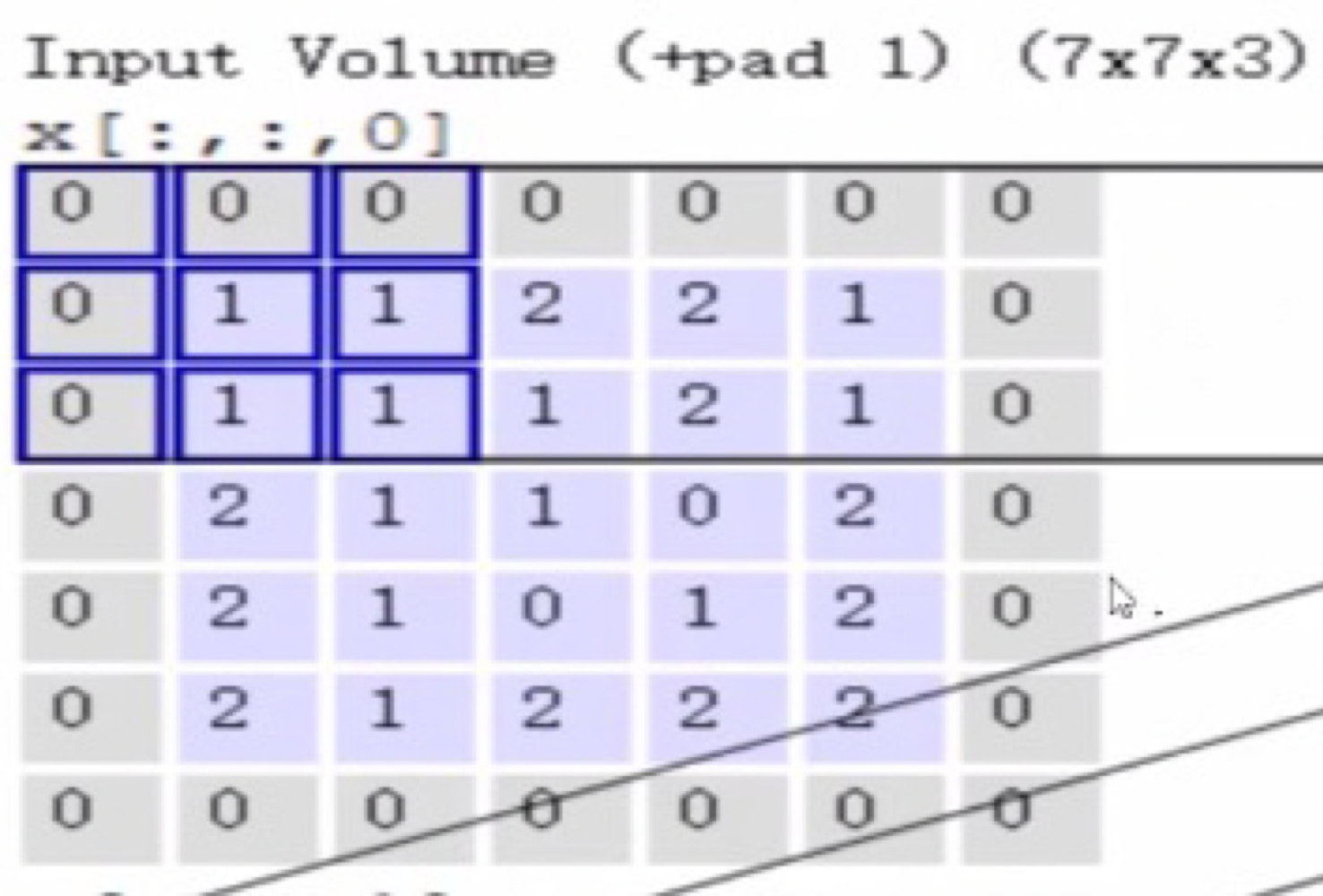

上图中紫色区域外加了一圈0。边缘填充有两个原因。1、在不填充的情况下会出现一个问题,例如步长为1,越靠近边缘被扫描的次数会越少,而越靠近中心被扫描的次数越多,这是因为步长为1的时候靠近中间会被重复扫描,导致越靠近中心会有天然的特征优势,因此填充边缘能降低这种天然优势。2、有时候input volume的大小无法被恰好扫描,这时候填充0能恰好扫描完。

上图中紫色区域外加了一圈0。边缘填充有两个原因。1、在不填充的情况下会出现一个问题,例如步长为1,越靠近边缘被扫描的次数会越少,而越靠近中心被扫描的次数越多,这是因为步长为1的时候靠近中间会被重复扫描,导致越靠近中心会有天然的特征优势,因此填充边缘能降低这种天然优势。2、有时候input volume的大小无法被恰好扫描,这时候填充0能恰好扫描完。

卷积核个数

卷积结果计算公式

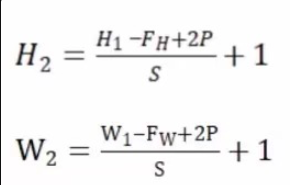

其中H1表示上一层的长度,FH表示卷积核的长度,P表示边缘填充的圈数,2P的是因为填充是填充一圈,H在上下都加了一个高度。S是步长。卷积完的宽度也是同样的道理。------>比如做个demo,输入数据是32323的图像,用10个553的卷积核来卷积,指定滑动步长为1,边界填充为2,那么输出的规模计算为:

其中H1表示上一层的长度,FH表示卷积核的长度,P表示边缘填充的圈数,2P的是因为填充是填充一圈,H在上下都加了一个高度。S是步长。卷积完的宽度也是同样的道理。------>比如做个demo,输入数据是32323的图像,用10个553的卷积核来卷积,指定滑动步长为1,边界填充为2,那么输出的规模计算为:

(32-5+22)/1 + 1 = 32,宽度计算也一样,至于卷积后的厚度,在多层卷积的目录里面提到过,就是卷积核有多少个,得到的特征就有几层。这里用10个卷积核,那么卷积后得到的特征厚度就是10,所以经过10个553的卷积核后得到3232*10的输出。

参数共享

卷积的参数共享意思是在一层卷积里是用同一个卷积核对图像的所有部分就行扫描。参数共享的目的是减少需要的参数。如果一个图像的每个部分都用不同的卷积核来进行扫描,那需要的参数就不得了的大了。例如一个32323的图像,用10个553的卷积核来卷积,需要的权重参数计算为:553=75,每个卷积核需要75个参数,10个就是750,每个卷积个对应有一个bias,那么一共才760个参数。

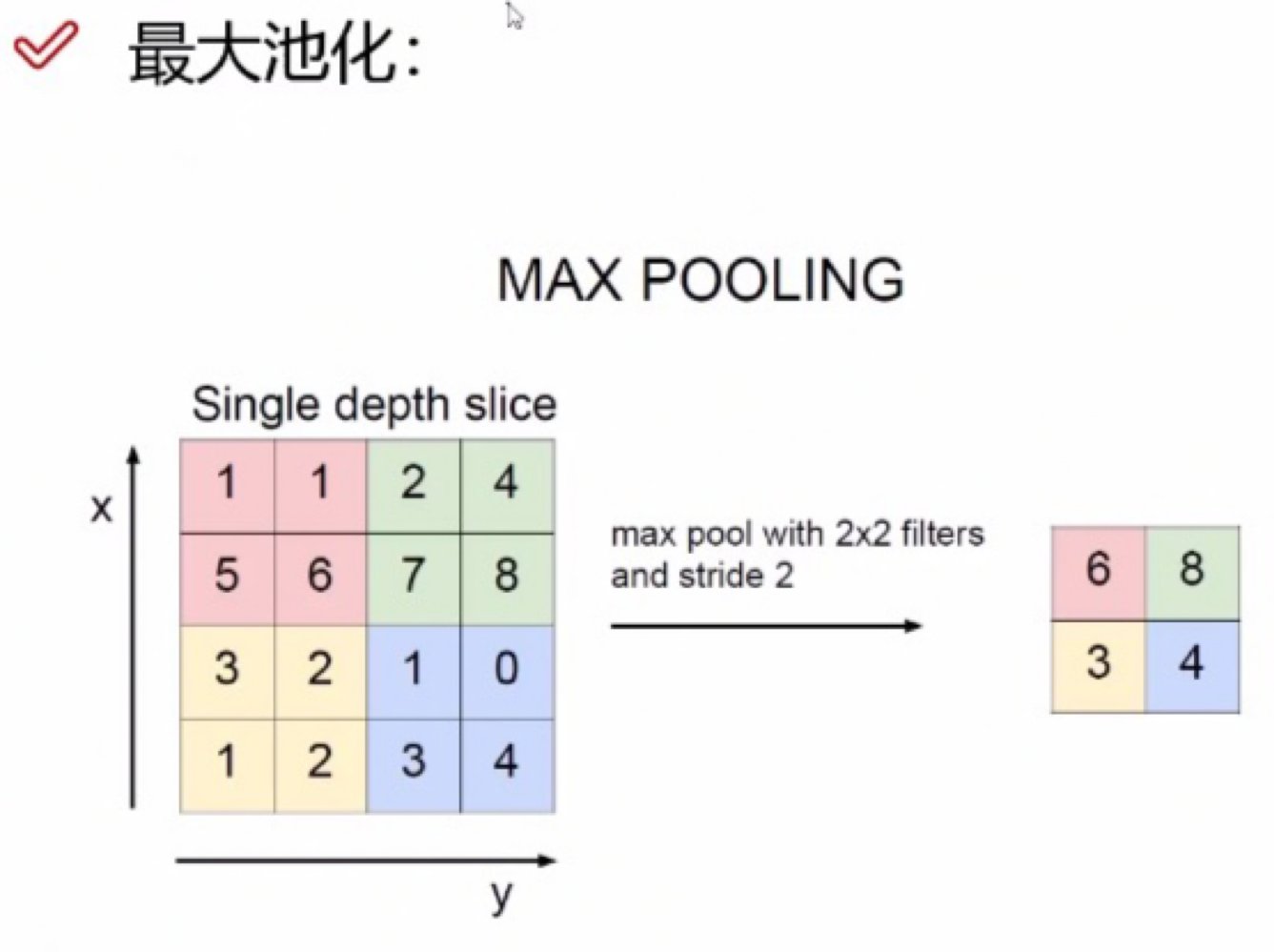

2.4池化层

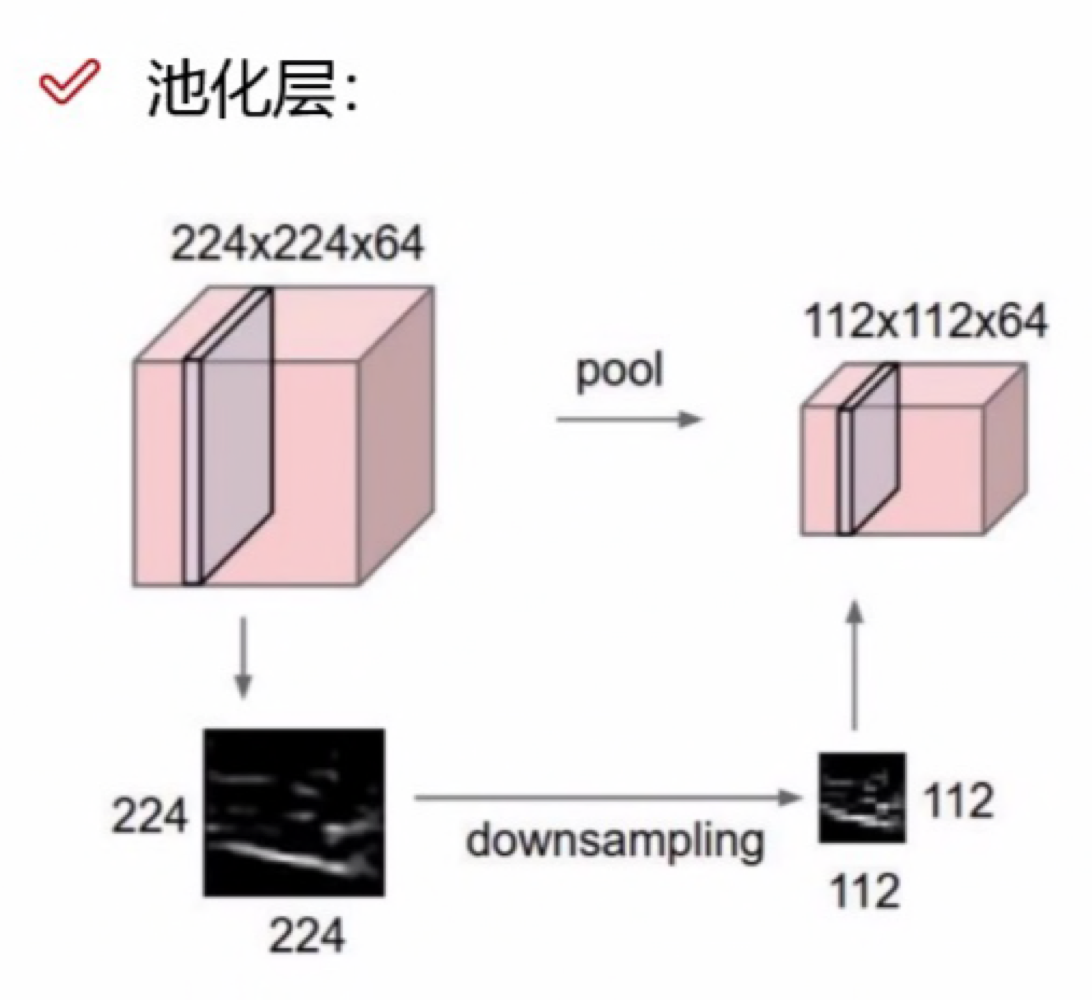

池化层总体来说就是一个作压缩,下采样的过程。

一般都用最大池化,为什么最大池化效果会比均值效果好?因为在特征图中数字越大,意思它的特征效果越明显,那么把它保存下来肯定就是好的选择。

一般都用最大池化,为什么最大池化效果会比均值效果好?因为在特征图中数字越大,意思它的特征效果越明显,那么把它保存下来肯定就是好的选择。

2.5全连接层

在最后一层池化后,有一个连接的过程,池化后得到的是一个323210的三维特征,连接过程把323210拉长成10240个特征,而全连接层就是把10240个特征提取成五分类的5个概率。

在最后一层池化后,有一个连接的过程,池化后得到的是一个323210的三维特征,连接过程把323210拉长成10240个特征,而全连接层就是把10240个特征提取成五分类的5个概率。

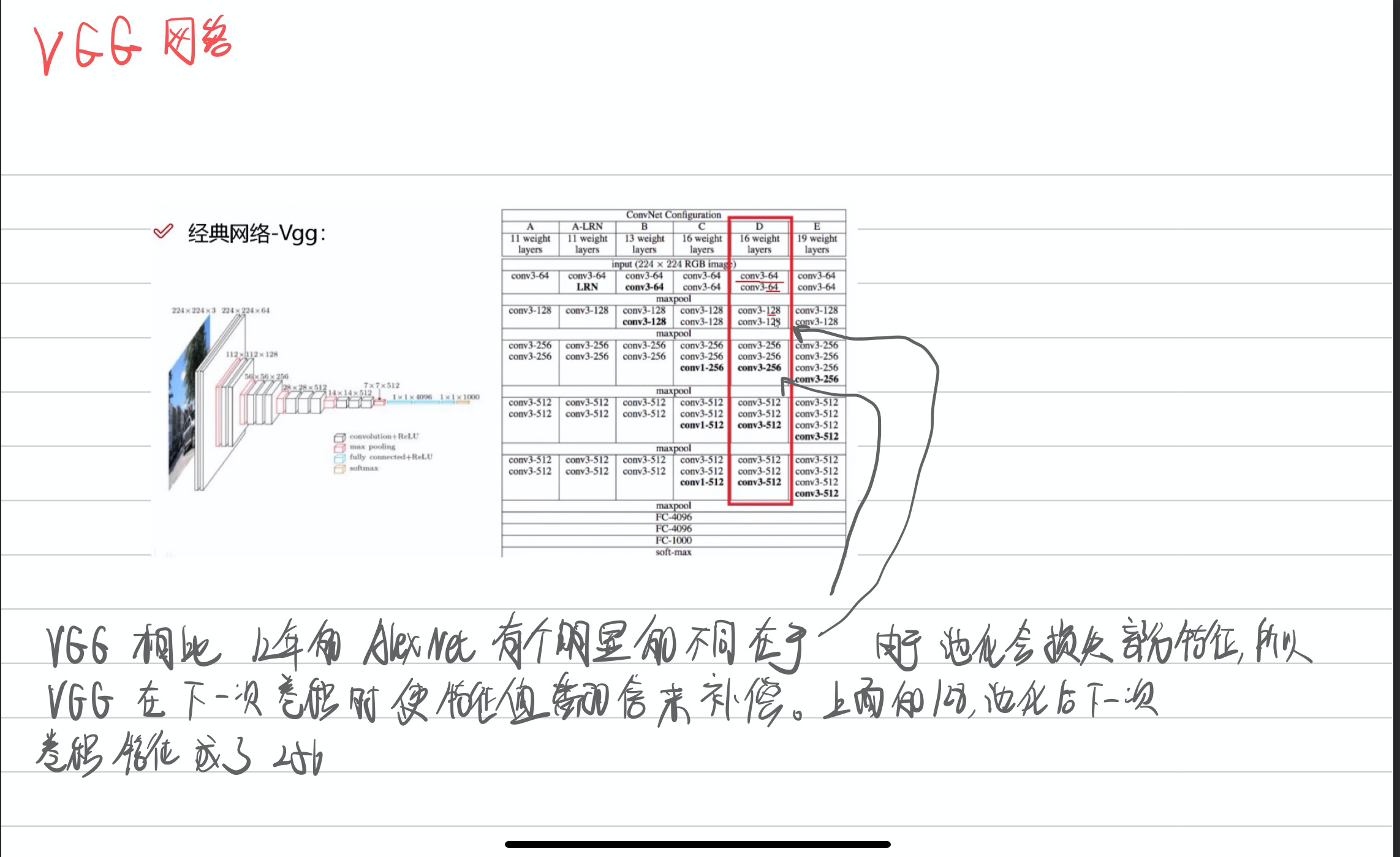

三、VGG网络

VGG网络相比之前看过的alex12年的那个网络,特殊的地方在于每层池化后,他下一次卷积会特意让特征值翻倍,这样做是因为每次池化的时候,比如我最大池化,那我只取了最大的特征,就会损失掉部分特征,所以下一次卷积使特征值翻倍的话相当于进行补偿。上面的128尺寸经过池化后的下一次卷积变成了256。

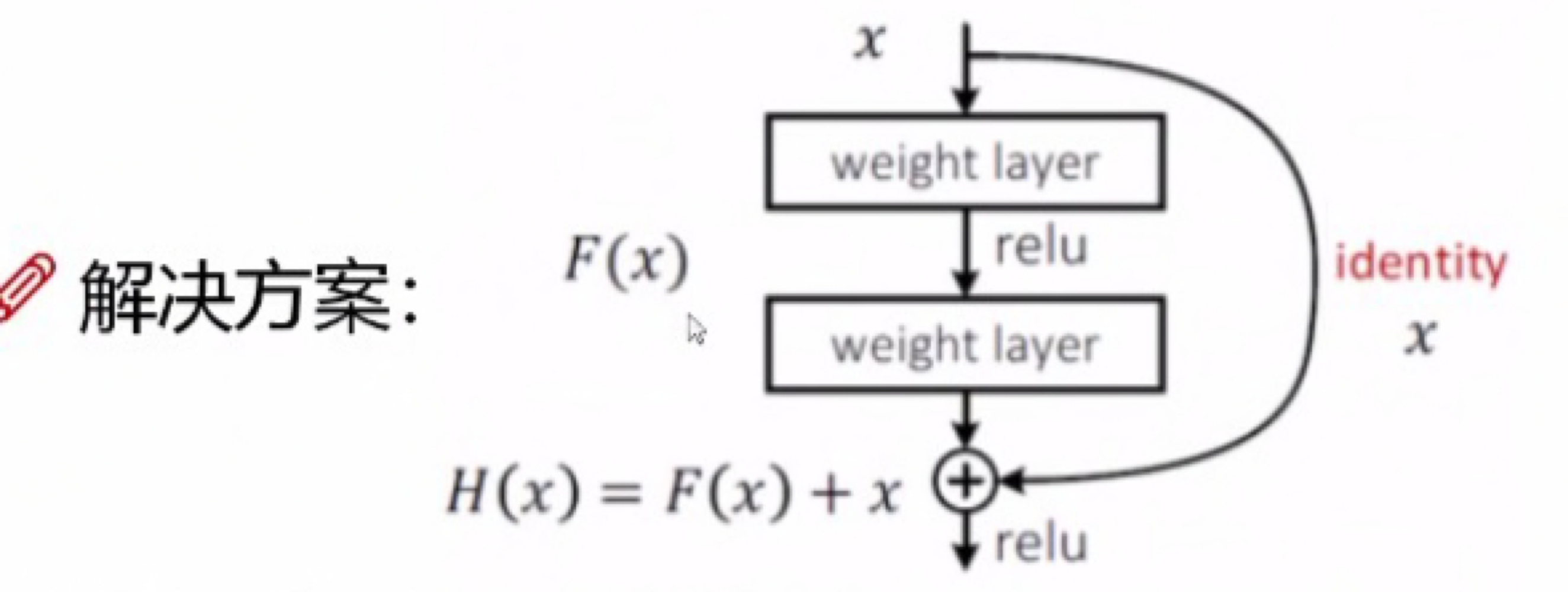

四、Resnet网络

当堆叠层熟太多的时候,有些卷积层学的并不好的将学的好的覆盖,导致层数越多错误率可能反而越高。原理就是上一层的输入分成两条线进入,当卷积后发现效果并不好,那就把权重设为0,这层相当于没学,使用卷积前的X输入。

五、论文部分

参考文献:SEMI-SUPERVISED CLASSIFICATION WITH GRAPH CONVOLUTIONAL NETWORKS《统计学习方法》 李航

Introduction

本文提出了一种图卷积网络(graph covolutional networks, GCNs),该网络是传统卷积算法在图结构数据上的一个变体,可以直接用于处理图结构数据。从本质上讲,GCN 是谱图卷积(spectral graph convolution) 的局部一阶近似(localized first-orderapproximation)。GCN的另一个特点在于其模型规模会随图中边的数量的增长而线性增长。总的来说,GCN 可以用于对局部图结构与节点特征进行编码。参数G(V,E)表示一个图,V,E表示相应的节点集与边集,u,v表示图中的节点,(u,v)表示图中的边

A:图的邻接矩阵

D:图的度矩阵

L:图的拉普拉斯矩阵

一些定义:

邻接矩阵

图的邻接矩阵指用于表示图中节点的连接情况的矩阵。该矩阵可以是二值的,也可以是带权的。对于有N个节点的无向图来说,邻接矩阵是一个 N*N 的实对称矩阵。

度矩阵

点的度表示与该节点相连的边的数量。图的度矩阵即用于描述图中每个节点的度的矩阵,一般使用 D 表示。其中, Di (1≤i≤N)表示节点i的度。度矩阵是一个对角矩阵,对于无向图来说,一般只使用入度矩阵或出度矩阵。

拉普拉斯矩阵

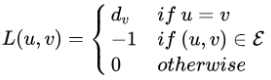

定义矩阵L ,其元素为:

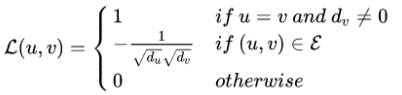

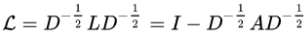

dv表示节点v的度,该矩阵为图G的拉普拉斯矩阵(L=D-A)进行归一化得到的拉普拉斯矩阵为:

因此,图G的归一化拉普拉斯矩阵计算公式为:

总结

本周主看网课主要是学习了CNN理论知识,基本懂了它的原理,然后下周准备搞代码。其次就是在B站搜了个论文跟读看了一半发现是GCN,总体来说就是学了个数学,看不太懂,百度看了下CNN跟GCN的区别倒是懂了一点点。其次就是看网课的时候看到个VGG网络,觉得那个补偿很特别,然后听课的时候也听得懂,下周准备读一下那一篇论文。

924

924

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?