- HADOOP FS

(1) -help:输出这个命令参数

hdfs dfs -help rm / hadoop fs -help rm

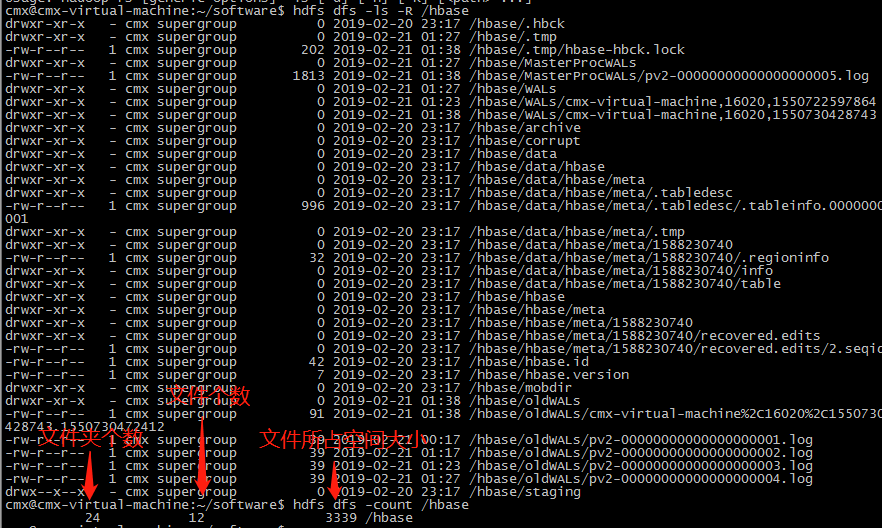

(2) -ls: 显示目录信息

hadoop fs -ls / R递归

(3) -mkdir:在hdfs上创建目录

hadoop fs -mkdir -p /aaa/bbb/cc/dd p递归生成文件

(4) -touchz:创建一个空的文件

hadoop fs -touchz /a.txt

(5) -moveFromLocal从本地剪切粘贴到hdfs

hadoop fs - moveFromLocal /home/hadoop/a.txt /aaa/bbb/cc/dd

(6) -moveToLocal:从hdfs剪切粘贴到本地

hadoop fs - moveToLocal /aaa/bbb/cc/dd /home/hadoop/a.txt

(7) -appendToFile :追加一个本地文件到已经存在的hdfs文件末尾

hadoop fs -appendToFile ./hello.txt(本地) /hello.txt

(8) -cat :显示文件内容

(9) -tail:显示一个文件的末尾

hadoop fs -tail /weblog/access_log.1

(10) -text:以字符形式打印一个文件的内容

hadoop fs -text /weblog/access_log.1

(11) -chgrp 、-chmod、-chown:linux文件系统中的用法一样,修改文件所属权限

hadoop fs -chmod 666 /hello.txt

hadoop fs -chown someuser:somegrp /hello.txt

(12) -copyFromLocal:从本地文件系统中拷贝文件到hdfs路径

hadoop fs -copyFromLocal ./jdk.tar.gz /aaa/

(13) -put:等同于copyFromLocal

hadoop fs -put /aaa/jdk.tar.gz /bbb/jdk.tar.gz.2

(14) -copyToLocal:从hdfs拷贝到本地

hadoop fs -copyToLocal /aaa/jdk.tar.gz

(15) -get:等同于copyToLocal,就是从hdfs下载文件到本地

hadoop fs -get /aaa/jdk.tar.gz

(16) -cp :从hdfs的一个路径拷贝到hdfs的另一个路径 源可以有多个,目标只能一个

hadoop fs -cp /aaa/jdk.tar.gz /bbb/jdk.tar.gz.2

(17) -mv:在hdfs目录中移动文件

hadoop fs -mv /aaa/jdk.tar.gz /

(18) -getmerge :合并下载多个文件,比如hdfs的目录 /aaa/下有多个文件:log.1, log.2,log.3,...

hadoop fs -getmerge /aaa/log.* ./log.sum

(19) -rm:删除文件或文件夹

hadoop fs -rm -r /aaa/bbb/ r递归删除

(20) -rmdir:删除空目录

hadoop fs -rmdir /aaa/bbb/ccc

(21) -df :统计文件系统的可用空间信息

hadoop fs -df -h / h方便阅读显示

(22) -du统计文件夹的大小信息,可以跟多个文件

hadoop fs -du -h /aaa aaa及内嵌文件的大小

hadoop fs -du -s -h /aaa aaa文件的大小

(23) -count:统计一个指定目录下的文件节点数量

hadoop fs -count /aaa/

(24) -setrep:设置hdfs中文件的副本数量

hadoop fs -setrep 3 /aaa/jdk.tar.gz

(25) -expunge:清空回收站

hadoop fs -expunge

- HADOOP JOB

| 参数 | 含义 |

| hadoop job -submit <job-file> | 提交作业 |

| hadoop job-status <job-id> | 打印map和reduce完成百分比和所有计数器。 |

| hadoop job -counter <job-id> <group-name> <counter-name> | 打印计数器的值。 |

| hadoop job-kill <job-id> | 杀死指定作业。 |

| hadoop job-events <job-id> <from-event-#> <#-of-events> | 打印给定范围内jobtracker接收到的事件细节。 |

| hadoop job-history [all] <jobOutputDir> | -history <jobOutputDir> 打印作业的细节、失败及被杀死原因的细节。更多的关于一个作业的细节比如成功的任务,做过的任务尝试等信息可以通过指定[all]选项查看。 |

| hadoop job-list [all] | -list all显示所有作业。-list只显示将要完成的作业。 |

| hadoop job-kill-task <task-id> | 杀死任务。被杀死的任务不会不利于失败尝试。 |

| hadoop job-fail-task <task-id> | 使任务失败。被失败的任务会对失败尝试不利。 |

详解可以参考官网:http://hadoop.apache.org/docs/r1.0.4/cn/hdfs_shell.html#cat

4589

4589

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?