一.下载Hadoop

1.直接在Hadoop官网进行下载:Hadoop官网下载界面

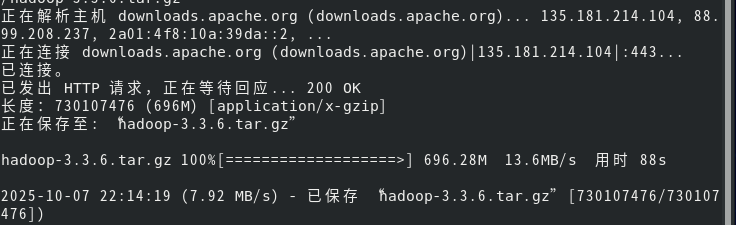

2.直接使用命令行下载:(这里以3.3.6版本举例)

wget https://downloads.apache.org/hadoop/common/hadoop-3.3.6/hadoop-3.3.6.tar.gz

2.解压Hadoop安装包:

sudo tar -zxvf ~/hadoop-3.3.6.tar.gz -C /usr/local/3.构建软链接:

ln -s /usr/local/hadoop-3.3.6 /usr/local/hadoop4.设置环境变量:

export HADOOP_HOME=/usr/local/hadoop-3.3.6

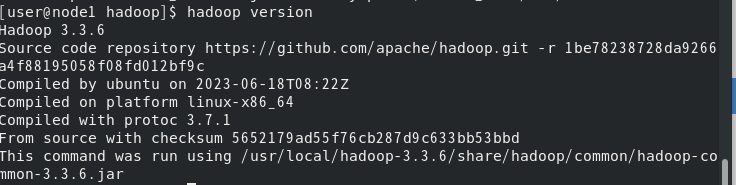

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOME export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib/native"5.验证是否安装成功:

hadoop version

二,进行配置

1.编辑 core-site.xml 文件:

sudo tee /export/server/hadoop/etc/hadoop/core-site.xml <<EOF

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

EOF2. 编辑 hdfs-site.xml 文件:

sudo tee /export/server/hadoop/etc/hadoop/hdfs-site.xml <<EOF

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

EOF3. 编辑 mapred-site.xml 文件:

sudo tee /export/server/hadoop/etc/hadoop/mapred-site.xml <<EOF

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

EOF4. 编辑 yarn-site.xml 文件

sudo tee /export/server/hadoop/etc/hadoop/yarn-site.xml <<EOF

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

EOF5. 验证安装

1.检查Hadoop正常工作:

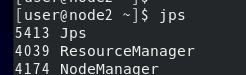

jps # 应显示NameNode、DataNode等进程

2.启动YARN集群,然后再运行jps:

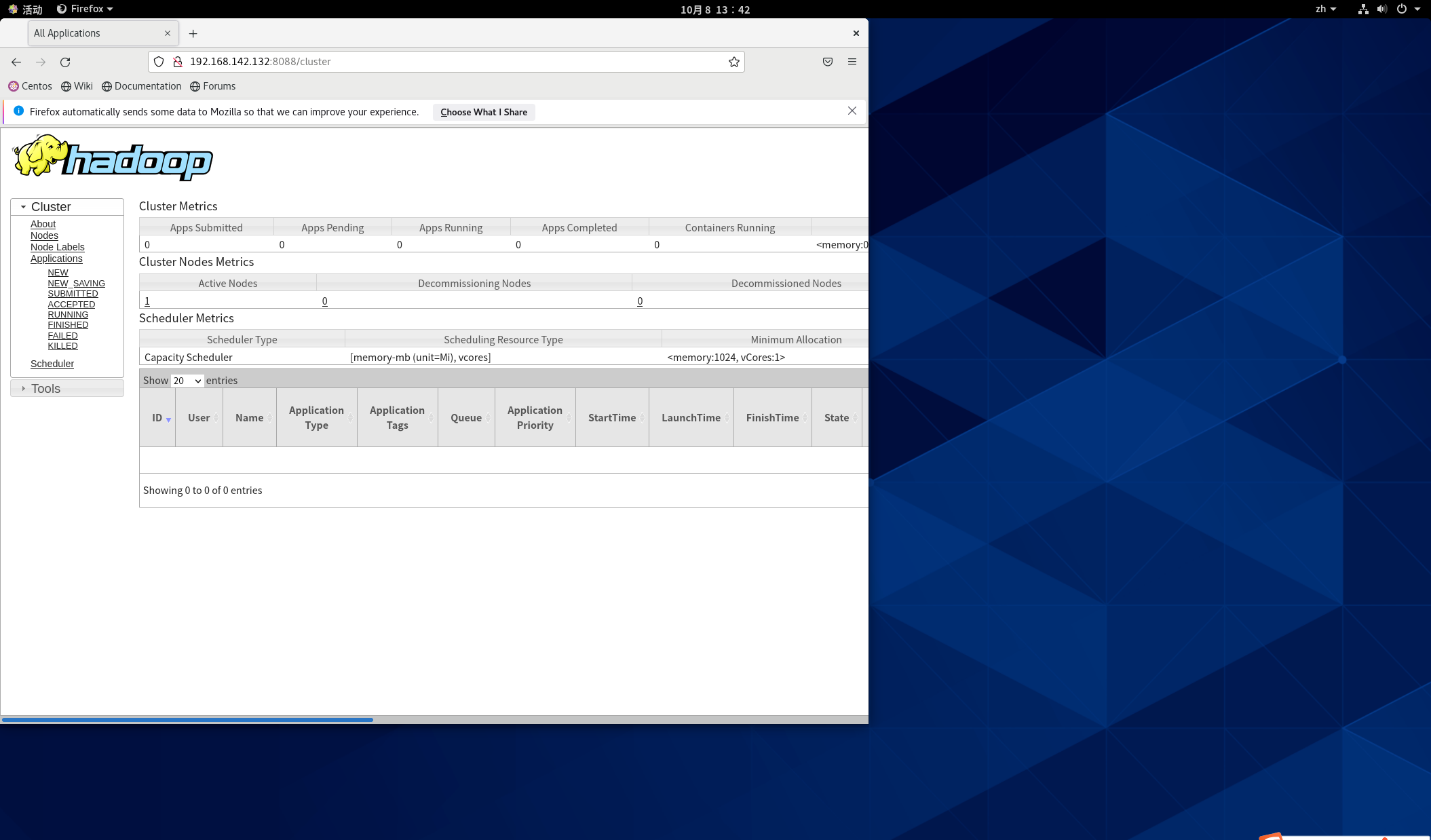

start-yarn.sh3.访问Web控制页面

http://192.168.142.131:8088

4、运行示例作业:

hdfs dfs -mkdir -p /input #新建

hdfs dfs -put ./test.txt /input/ #上传

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-*.jar wordcount /input /output

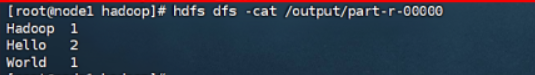

hdfs dfs -cat /output/part-r-00000 # 查看结果

注意:在使用网址进入对应网站时,注意自己虚拟机设置的ip地址需要一致。

8万+

8万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?