request`

requests的作用

作用:发送网络请求,返回响应数据

requests的作用

作用:发送网络请求,返回响应数据```python

response =requests.get(‘http://www.baidu.com’)

response.encoding=‘utf8’

print(response.text)

print(response.encoding)

`

BeautifulSoup

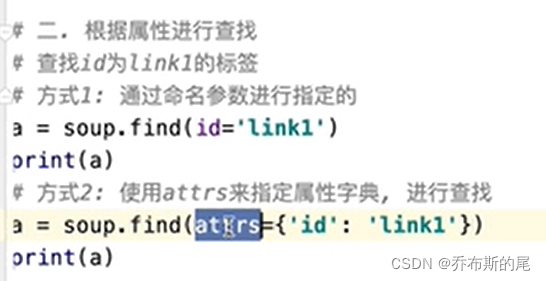

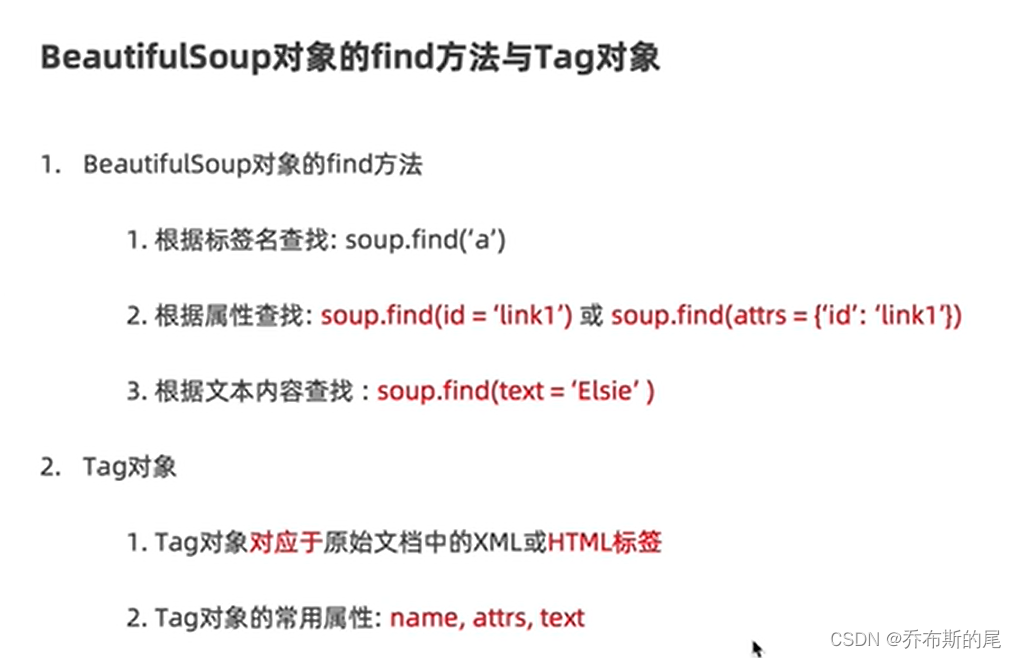

find方法

查找文档中的标签或者文档中的数据

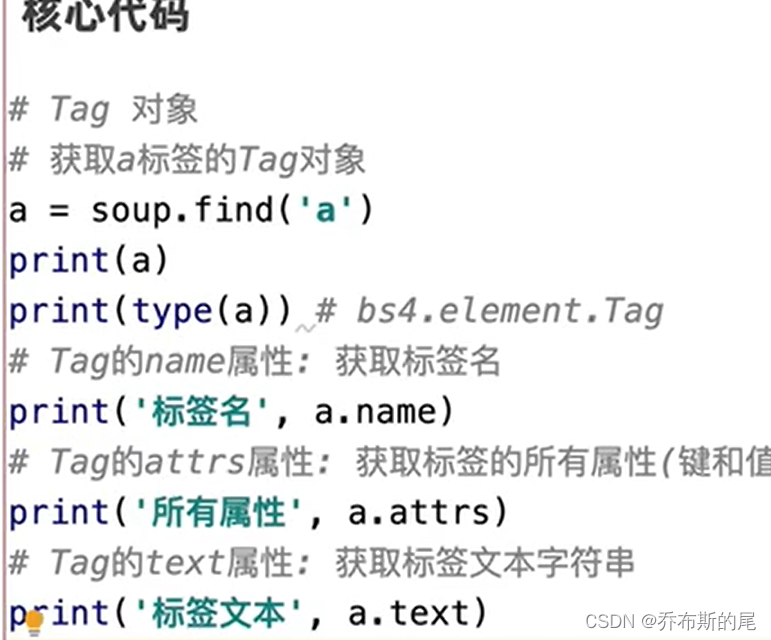

tag对象:

name:获取标签名称

attrs:获取标签所有的值

text:获取标签所有的字符串

运用find和request搜找疫情页面信息

```python

import requests

from bs4 import BeautifulSoup

response=requests.get('https://ncov.dxy.cn/ncovh5/view/pneumonia')

home_page=response.content.decode()

#print(home_page)

soup=BeautifulSoup(home_page,'lxml')

script=soup.find(id='getListByCountryTypeService2true')

text=script.string

print(text)

正则表达式:

提取疫情页面中的json模块

import requests

from bs4 import BeautifulSoup

import re

response=requests.get('https://ncov.dxy.cn/ncovh5/view/pneumonia')

page=response.content.decode()

soup=BeautifulSoup(page,'lxml')

script=soup.find(id='getListByCountryTypeService2true')

text=script.string

print(text)

#使用正则表达式导入Json表达式

json_str=re.findall(r'.\[.+\]',text[0])

print(json_str)import requests

from bs4 import BeautifulSoup

import re

response=requests.get('https://ncov.dxy.cn/ncovh5/view/pneumonia')

page=response.content.decode()

soup=BeautifulSoup(page,'lxml')

script=soup.find(id='getListByCountryTypeService2true')

text=script.string

print(text)

#使用正则表达式导入Json表达式

json_str=re.findall(r'.\[.+\]',text[0])

print(json_str)import requests

from bs4 import BeautifulSoup

import re

response=requests.get('https://ncov.dxy.cn/ncovh5/view/pneumonia')

page=response.content.decode()

soup=BeautifulSoup(page,'lxml')

script=soup.find(id='getListByCountryTypeService2true')

text=script.string

print(text)

#使用正则表达式导入Json表达式

json_str=re.findall(r'.\[.+\]',text[0])

print(json_str)

本文介绍如何使用Python的requests库抓取网页数据,并利用BeautifulSoup解析HTML文档,从中提取新冠疫情的相关信息。通过find方法定位特定标签,再结合正则表达式提取JSON格式的数据。

本文介绍如何使用Python的requests库抓取网页数据,并利用BeautifulSoup解析HTML文档,从中提取新冠疫情的相关信息。通过find方法定位特定标签,再结合正则表达式提取JSON格式的数据。

51万+

51万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?