Neural NetWork的由来

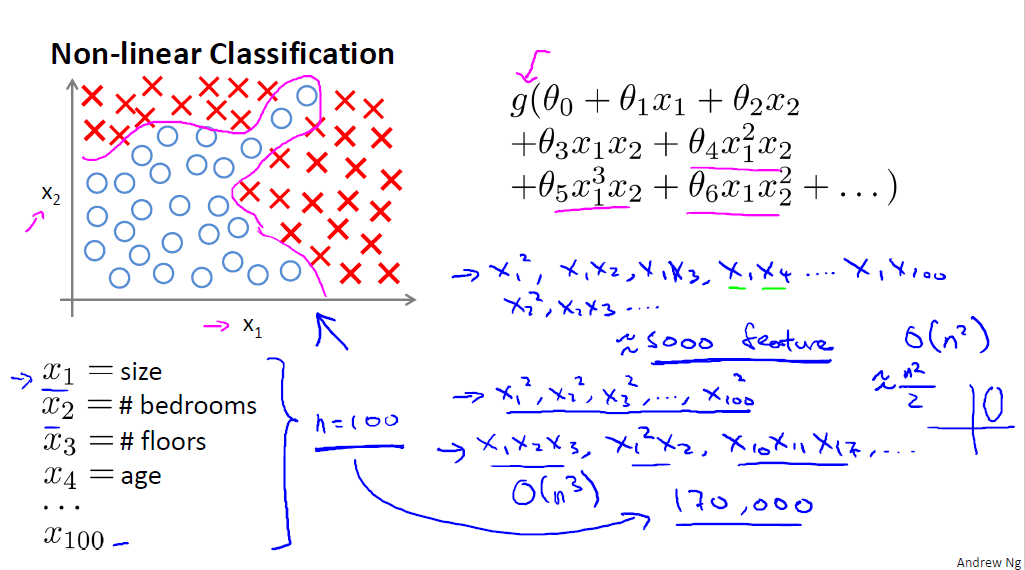

先考虑一个非线性分类,当特征数很少时,逻辑回归就可以完成了,但是当特征数变大时,高阶项将呈指数性增长,复杂度可想而知。如下图:对房屋进行高低档的分类,当特征值只有 x1,x2,x3 时,我们可以对它进行处理,分类。但是当特征数增长为 x1,x2....x100 时,分类器的效率就会很低了。

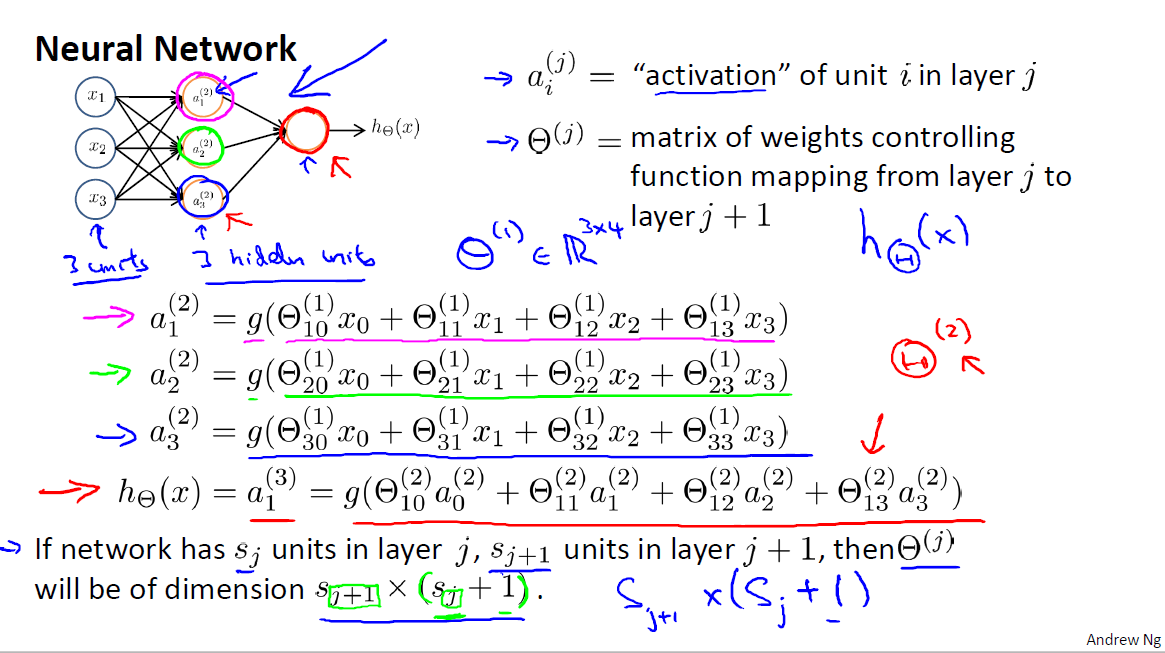

这里的 g(z)=1/(1+e−z)

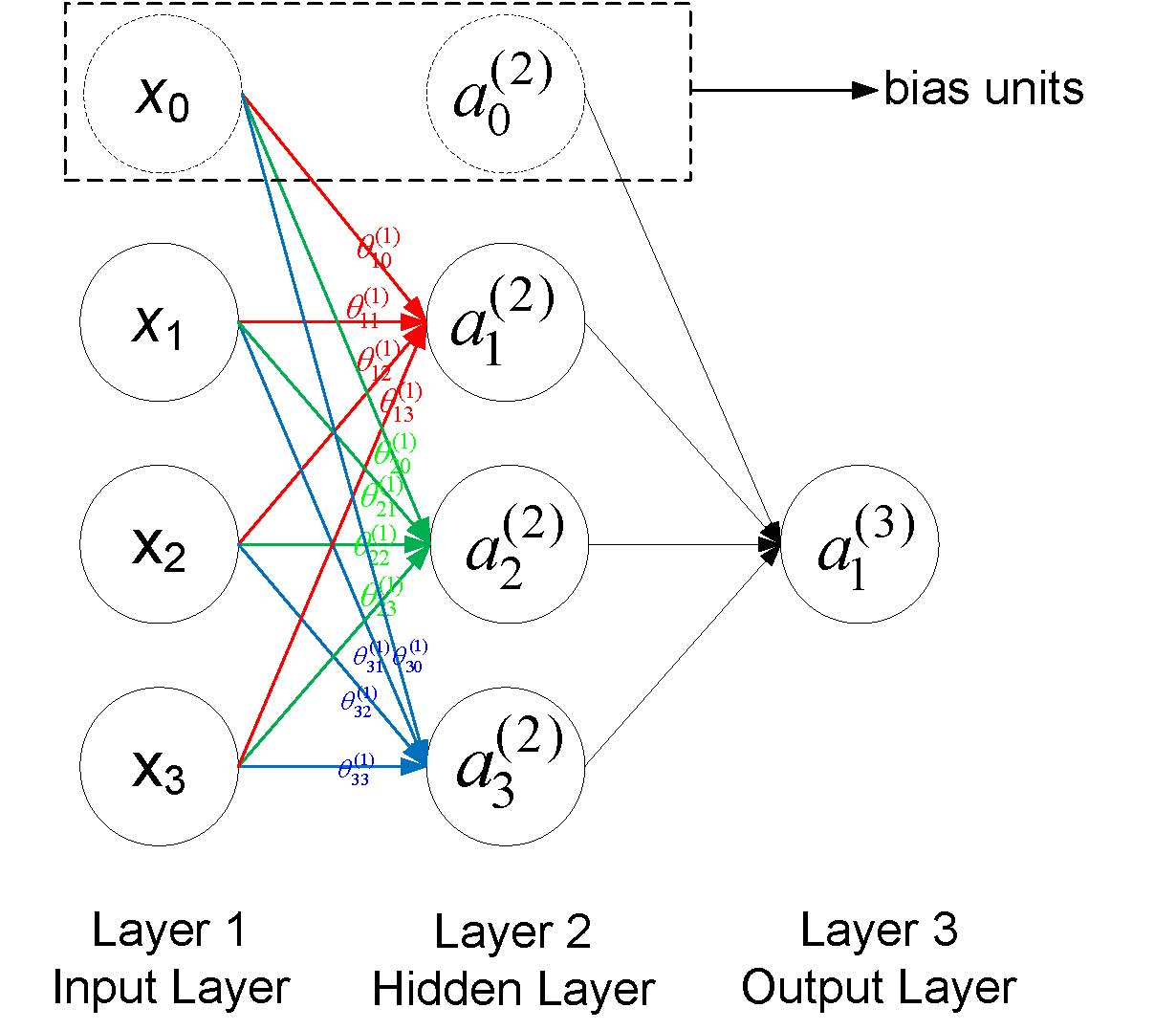

符号说明:

- a(j)i 表示第j层网络的第i个神经元,例如下图 a(2)1 就表示第二层的第一个神经元

- θ(j) 表示从第 j 层到第

j+1 层的权重矩阵,例如下图所有的 θ(1) 表示从第一层到第二层的权重矩阵 - θ(j)uv 表示从第j层的第v个神经元到第j+1层的第u个神经的权重,例如下图中 θ(1)23 表示从第一层的第3个神经元到第二层的第2个神经元的权重,需要注意到的是下标uv是指v->u的权重而不是u->v,下图也给出了第一层到第二层的所有权重标注

- 一般地,如果第j层有 sj 个神经元(不包括bias神经元),第j+1层有 sj+1 个神经元(也不包括bias神经元),那么权重矩阵 θj 的维度是 (sj+1×(sj+1))

Forward propagation

第一层,称之为input Layer x={ x1,x2,x3}

第二层至最后一层,成为hidden layers: a(2)2,a(2)1,a(2)3

最后一层是output layer: hθ(x)

通俗点说,向前传播就是上层处理完的数据作为你的输入数据,然后进行处理(权重),再传给下一层,这样逐层处理,最后输出。

|

|

本文介绍了神经网络的由来,解释了在特征数量增加时,逻辑回归的效率下降,引入神经网络以解决线性不可分问题。详细阐述了前向传播的过程,包括权重矩阵的使用和向量化实现,并通过实例展示了神经网络如何通过非线性转换处理线性不可分数据。

本文介绍了神经网络的由来,解释了在特征数量增加时,逻辑回归的效率下降,引入神经网络以解决线性不可分问题。详细阐述了前向传播的过程,包括权重矩阵的使用和向量化实现,并通过实例展示了神经网络如何通过非线性转换处理线性不可分数据。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?