L~M方法:

L~M(Levenberg-Marquardt)方法有些让人摸不清头脑。玉米觉得L~M让人困扰的主要原因有两点:一是L~M从何而来、二是L~M怎么样用?因为玉米也不是研究最优化理论的,所以玉米在这里用较为通俗的观点,为大家分析一下L~M方法。在数学上的不严谨之处,期望大家海涵。

一、L~M从何而来

首先,L~M方法首先是一种非线性规划方法;其次其主要用于无约束的多维非线性规划问题;最后,它是一阶牛顿法的一种改进,改进的目的是为了更快的收敛。

既然如此,那么让我们先来了解一下L~M方法的“前辈”一阶牛顿法吧。对一阶牛顿法的理解会帮助我们了解L~M方法的总体思路。

对于无约束的多维非线性规划问题,起码我们需要一个可以令人接受的参数估计的初始解,我们设其为:Xk。(举个例子,这就是张正友标定法中通过纯粹的几何推导得出的摄像机参数)。在Xk的基础上,我们去寻找比Xk更“靠谱”的估计值。既然我们已经认为Xk可以令人接受,那么更好更精确的估计值应该在Xk的附近,在距离Xk长度为Δk的地方。那么,现在我们用一点点高等数学的知识:泰勒展开式。对于一阶牛顿法,我们用一阶泰勒展式逼近Xk附近点的f(Xk+Δk)估计值。(这里提到的量都是矩阵形式哦比如,在张正友标定法中f(Xk+Δk)由u和v组成)如下

假设ε=Xk+1-Xk在某时以变化的缓慢到我们认为算法以收敛。我们称ε为终止条件。

那么,我们就这样迭代下去,总会得到符合我们预期的Xk+1。

以上就是一阶牛顿法,说白了就是一个不断向着有利方向迭代的过程。

L~M方法是在一阶牛顿法基础上的改进。为加快收敛,L~M把上面的正规化方程改成了增量正规化方程。如下:

λ就是增量方程中所谓的增量。

L~M方法中,取增量的规则如下:

最初,设λ=0.0001,如果增量方程的解Δk导致ek减小,我们就接受这个λ,并在下一次迭代中使用λ/10代换λ。如果λ值对应的增量方程的解Δk导致ek增大,我们就舍弃这个λ,并将其代换为10λ重解增量方程。循环往复直到ek下降为止。λk+1=10λk

L~M也是迭代循环,直到总会得到符合我们预期的Xk+1为止。

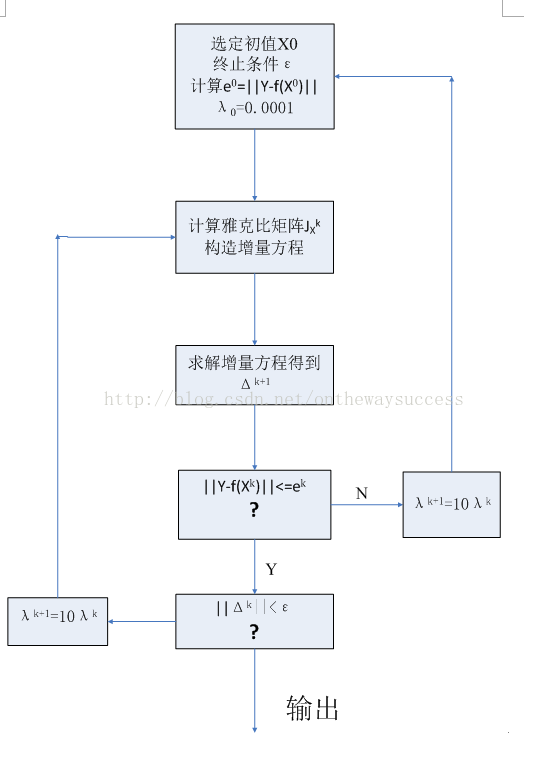

以上就是L~M方法的原理与出处。大家一定觉得昏昏欲睡了。那么下一部分,应该是大家喜闻乐见的。玉米,将L~M算法的过程总结成算法流程图,与大家分享。||Δk||<ε

二、L~M这样用:

该流程图就是L-M算法的算法流程。玉米就不多说什么了,流程图更清晰一些。

什么是最优化,可分为几大类?

答:Levenberg-Marquardt算法是最优化算法中的一种。最优化是寻找使得函数值最小的参数向量。它的应用领域非常广泛,如:经济学、管理优化、网络分析、最优设计、机械或电子设计等等。

根据求导数的方法,可分为2大类。第一类,若f具有解析函数形式,知道x后求导数速度快。第二类,使用数值差分来求导数。

根据 使用模型不同,分为非约束最优化、约束最优化、最小二乘最优化。

什么是Levenberg-Marquardt算法?

它是使用最广泛的非线性最小二乘算法,中文为列文伯格-马夸尔特法。它是利用梯度求最大(小)值的算法,形象的说,属于“爬山”法的一种。它同时具有梯度法和牛顿法的优点。当λ很小时,步长等于牛顿法步长,当λ很大时,步长约等于梯度下降法的步长。在作者的科研项目中曾经使用过多次。图1显示了算法从起点,根据函数梯度信息,不断爬升直到最高点(最大值)的迭代过程。共进行了12步。(备注:图1中绿色线条为迭代过程)。

图1中,算法从山脚开始不断迭代。可以看到,它的寻优速度是比较快的,在山腰部分直接利用梯度大幅度提升(参见后文例子程序中lamda较小时),快到山顶时经过几次尝试(lamda较大时),最后达到顶峰(最大值点),算法终止。

如何快速学习LM算法?

学 习该算法的主要困难是入门难。 要么国内中文教材太艰涩难懂,要么太抽象例子太少。目前,我看到的最好的英文入门教程是K. Madsen等人的《Methods for non-linear least squares problems》本来想把原文翻译一下,贴到这里。请让我偷个懒吧。能找到这里的读者,应该都是E文好手,我翻译得不清不楚,反而事倍功半了。

可在 下面的链接中找到

http://www2.imm.dtu.dk/pubdb/public/publications.php? year=&pubtype=7&pubsubtype=§ion=1&cmd=full_view&lastndays=&order=author

或者直接下载pdf原文:

http://www2.imm.dtu.dk/pubdb/views/edoc_download.php/3215/pdf/imm3215.pdf

算法流程

参考文献:

[1]. 张鸿燕, 狄征. Levenberg-Marquardt算法的一种新解释. 计算机工程与应用,2009,45(19),5-8.

from:

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?