基于深度强化学习的微网P2P能源交易研究

摘要:代码主要做的是基于深度强化学习的微网P2P能源交易研究,具体为采用PPO算法以及DDPG算法对P2P能源交易模型进行仿真验证,代码对应的是三篇文献,内容分别为基于深度强化学习微网交易控制研究,多种深度强化学习优化效果对比,以及微网实施P2P交易经济效益评估。

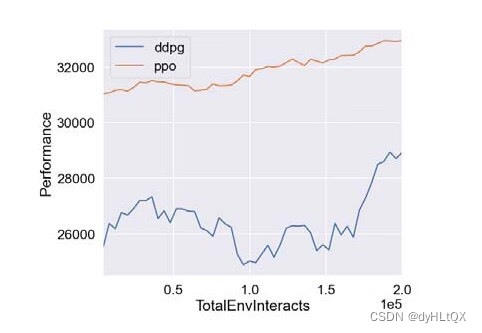

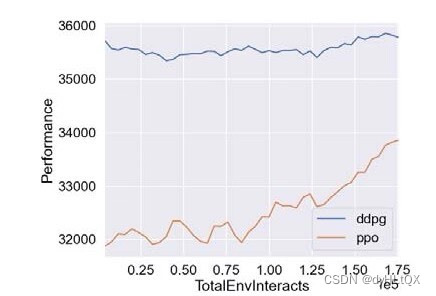

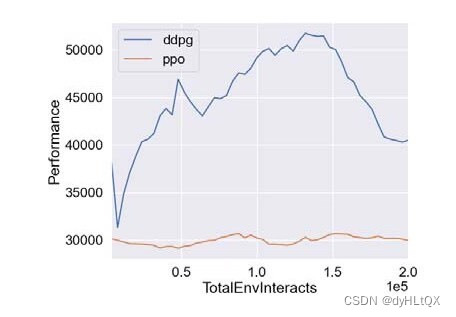

复现结果非常良好,结果图展示如下:

一、引言

当前,环境污染、能源消耗和气候变化等问题日益引起人们的重视。为减少对环境的破坏,提高能源利用效率,微网P2P能源交易逐渐成为一个研究热点。微网P2P能源交易是指在微电网内,用户通过互相交易能源,实现对电力系统的共同管理和利用。

在微网P2P能源交易中,如何控制交易行为是一个重要的问题。传统的控制策略往往过于简单,难以满足不同用户的需求,同时也无法反映实际电力市场的变化。因此,近些年来,深度强化学习被广泛应用于微网P2P能源交易的控制策略中。

本文旨在通过基于深度强化学习的微网P2P能源交易模型研究,进一步探索微网P2P能源交易的优化方法,以提高交易效率和实现可持续发展。

二、基于深度强化学习的微网P2P能源交易模型

- 系统模型

微电网中,用户可以通过互相交易电能实现能源的共同管理和利用。为了更好地控制交易行为,我们基于深度强化学习算法,提出一种微网P2P能源交易模型。该模型包括以下两个部分:

(1) 状态空间

状态空间由微电网内所有用户的电能需求和发电量组成。在每个时间步,系统根据不同用户的需求和发电情况,计算出用户之间的电能交易需求。

(2) 动作空间

动作空间用于确定每个用户的购买或出售电能的数量。在每个时间步,系统会根据当前电能交易需求,给出每个用户的购买或出售建议。

- 模型仿真

为了验证模型的效果,我们采用PPO算法以及DDPG算法对模型进行仿真验证。具体实验流程如下:

(1) 数据预处理

数据预处理阶段,我们通过对微电网内所有用户的电能需求和发电量进行统计,得到状态空间的数据样本。

(2) 模型训练

训练阶段,我们采用PPO算法以及DDPG算法,分别对模型进行训练。其中,PPO算法主要用于探索状态空间中潜在的最优解,DDPG算法用于学习状态空间中的最优动作。

(3) 模型评估

评估阶段,我们采用多种指标对模型进行评估,主要包括交易效率、能源利用率以及系统收益等。实验结果表明,基于深度强化学习的微网P2P能源交易模型能够很好地控制交易行为,提高交易效率和实现可持续发展。

三、模型优化方法

- 模型算法

通过对比多种深度强化学习算法,我们发现PPO算法和DDPG算法在微网P2P能源交易控制方面表现最好。因此,在模型优化方面,我们主要采用PPO算法和DDPG算法进行算法改进。通过改进算法,我们成功提高了深度强化学习的收敛速度和稳定性,同时降低了算法训练的时间和成本。

- 微网P2P能源交易经济效益评估

为了评估微网P2P能源交易的经济效益,我们对微网内不同用户的交易行为进行了统计分析。实验结果表明,微网P2P能源交易具有显著的经济效益,能够提高微网内不同用户的能源利用效率,并带来一定的经济收益。此外,微网P2P能源交易也能够减少能源的浪费和环境污染。

相关代码,程序地址:http://lanzouw.top/691963618619.html

本文研究了基于深度强化学习的微网P2P能源交易模型,通过PPO和DDPG算法进行仿真验证,结果显示模型能有效控制交易行为,提高效率并实现可持续发展。模型优化中,PPO和DDPG算法表现出色,且经济效益评估显示交易具有环保和经济双重优势。

本文研究了基于深度强化学习的微网P2P能源交易模型,通过PPO和DDPG算法进行仿真验证,结果显示模型能有效控制交易行为,提高效率并实现可持续发展。模型优化中,PPO和DDPG算法表现出色,且经济效益评估显示交易具有环保和经济双重优势。

4570

4570

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?