1、一些问题

① 你只要用缓存,就可能会涉及到缓存与数据库双存储双写,你只要是双写,就一定会有数据一致性的问题,那么你如何解决一致性问题?

② 双写一致性,你先动缓存 redis还是mysql数据库哪一个? why?

2、canal

2.1、是什么

canal[ka'nael],中文翻译为 水道/管道/沟渠/运河,主要用途是用于 Mysql数据库增量日志数据的订阅、消费和解析,是阿里巴巴开发并开源的,采用Java语言开发;

历史背景是早期阿里巴巴因为杭州和美国双机房部署,存在跨机房数据同步的业务需求,实现方式主要是基于业务 trigger(触发器)获取增量变更。

从2010年开始,阿里巴巴逐步尝试采用解析数据库日志获取增量变更进行同步,由此衍生出了 canal项目;

官网地址:https://github.com/alibaba/canal/

一句话:Canal是基于MySQL变更日志增量订阅和消费的组件

2.2、能干嘛?

① 数据库镜像

② 数据库实时备份

③ 索引构建和实时维护(拆分异构索引、倒排索引等)

④ 业务 cache刷新

⑤ 带业务逻辑的增量数据处理

2.3、去哪下

下载canal https://github.com/alibaba/canal/wiki

Java客户端 https://github.com/alibaba/canal/wiki/ClientExample

3、工作原理,面试回答

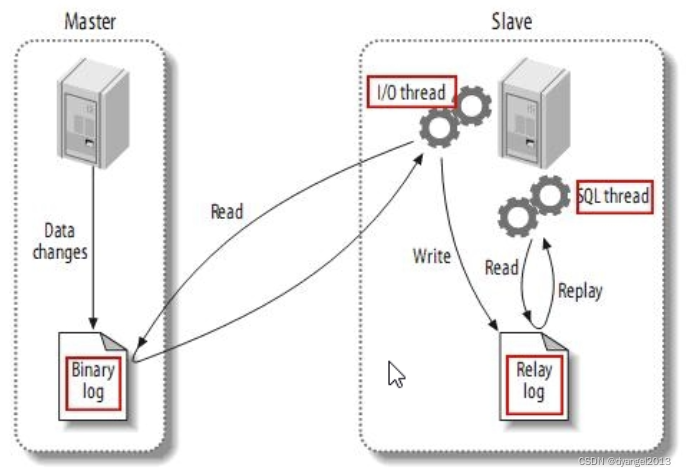

3.1、传统MySQL主从复制工作原理

Mysq的主从复制将经过如下步骤:

1、当 master主服务器上的数据发生改变时,则将其改变写入二进制事件志文件中

2、 slave从服务器会在一定时间间隔内对 master主服务器上的二进制日志进行探测,探测其是否发生过改变,

如果探测到 master主服务器的二进制事件日志发生了改变,则开始一个I/O Thread请求 master二进制事件日志

3、同时 master主服务器为每个I/O Thread启动一个dump Thread,用于向其发送二进制事件日志;

4、slave从服务器将接收到的二进制事件日志保存至自己本地的中继日志文件中

5、 slave从服务器将启动 SQL Thread从中继日志中读取二进制日志,在本地重放,使得其数据和主服务器保持一致;

6、最后I/O Thread和 SQL Thread将进入睡眠状态,等待下一次被唤醒;

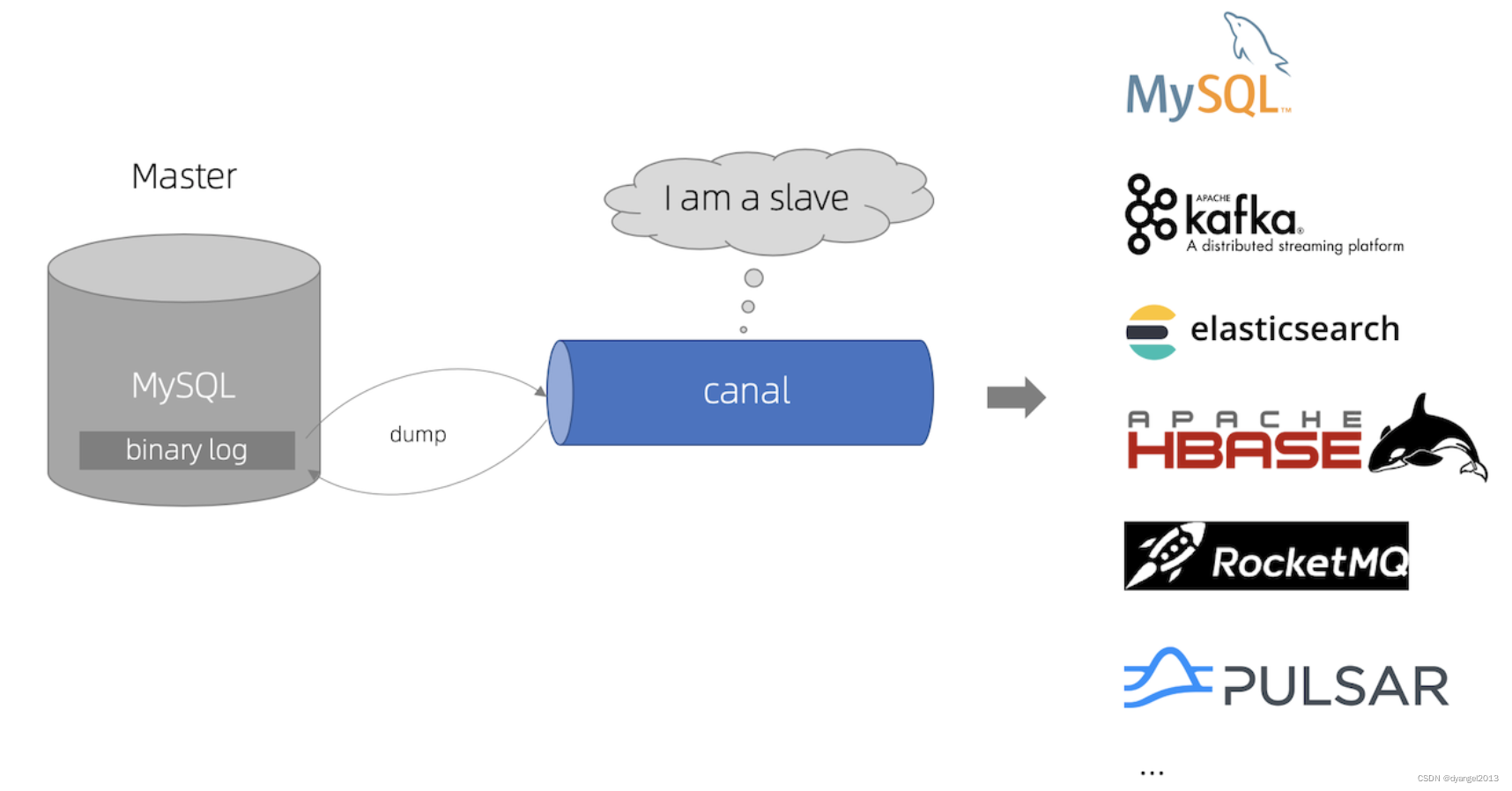

3.2、canal工作原理

- canal 模拟 MySQL slave 的交互协议,伪装自己为 MySQL slave ,向 MySQL master 发送 dump 协议

- MySQL master 收到 dump 请求,开始推送 binary log 给 slave (即 canal )

- canal 解析 binary log 对象(原始为 byte 流)

3.3、结论之一

分布式系统只有最终一致性很难做到强一致性

4、mysql-canal-redis双写一致性Coding

package canal_demo.shiwn;

import canal_demo.shiwn.config.RedisUtils;

import com.alibaba.fastjson.JSONObject;

import com.alibaba.otter.canal.client.CanalConnector;

import com.alibaba.otter.canal.client.CanalConnectors;

import com.alibaba.otter.canal.protocol.CanalEntry.*;

import com.alibaba.otter.canal.protocol.Message;

import redis.clients.jedis.Jedis;

import java.net.InetSocketAddress;

import java.util.List;

import java.util.concurrent.TimeUnit;

public class RedisCanalClientExample {

public static final Integer _60SECONDS = 60;

public static void main(String args[]) {

// 创建链接canal服务端,默认端口11111

CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress("192.168.1.123",

11111), "example", "", "");

// 查询条数

int batchSize = 1000;

int emptyCount = 0;

try {

connector.connect();

//connector.subscribe(".*\\..*");

// 指定数据库及表

connector.subscribe("db2022.t_user");

connector.rollback();

int totalEmptyCount = 10 * _60SECONDS;

while (emptyCount < totalEmptyCount) {

Message message = connector.getWithoutAck(batchSize); // 获取指定数量的数据

long batchId = message.getId();

int size = message.getEntries().size();

if (batchId == -1 || size == 0) {

emptyCount++;

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

} else {

emptyCount = 0;

printEntry(message.getEntries());

}

connector.ack(batchId); // 提交确认

// connector.rollback(batchId); // 处理失败, 回滚数据

}

System.out.println("empty too many times, exit");

} finally {

connector.disconnect();

}

}

private static void printEntry(List<Entry> entrys) {

for (Entry entry : entrys) {

if (entry.getEntryType() == EntryType.TRANSACTIONBEGIN || entry.getEntryType() == EntryType.TRANSACTIONEND) {

continue;

}

RowChange rowChage = null;

try {

rowChage = RowChange.parseFrom(entry.getStoreValue());

} catch (Exception e) {

throw new RuntimeException("ERROR ## parser of eromanga-event has an error,data:" + entry.toString(), e);

}

EventType eventType = rowChage.getEventType();

System.out.println(String.format("================> binlog[%s:%s] , name[%s,%s] , eventType : %s",

entry.getHeader().getLogfileName(), entry.getHeader().getLogfileOffset(),

entry.getHeader().getSchemaName(), entry.getHeader().getTableName(), eventType));

for (RowData rowData : rowChage.getRowDatasList()) {

if (eventType == EventType.INSERT) {

redisInsert(rowData.getAfterColumnsList());

} else if (eventType == EventType.DELETE) {

redisDelete(rowData.getBeforeColumnsList());

} else {//EventType.UPDATE

redisUpdate(rowData.getAfterColumnsList());

}

}

}

}

private static void redisInsert(List<Column> columns) {

JSONObject jsonObject = new JSONObject();

for (Column column : columns) {

System.out.println(column.getName() + " : " + column.getValue() + " update=" + column.getUpdated());

jsonObject.put(column.getName(), column.getValue());

}

if (columns.size() > 0) {

try (Jedis jedis = RedisUtils.getJedis()) {

jedis.set(columns.get(0).getValue(), jsonObject.toJSONString());

} catch (Exception e) {

e.printStackTrace();

}

}

}

private static void redisDelete(List<Column> columns) {

JSONObject jsonObject = new JSONObject();

for (Column column : columns) {

jsonObject.put(column.getName(), column.getValue());

}

if (columns.size() > 0) {

try (Jedis jedis = RedisUtils.getJedis()) {

jedis.del(columns.get(0).getValue());

} catch (Exception e) {

e.printStackTrace();

}

}

}

private static void redisUpdate(List<Column> columns) {

JSONObject jsonObject = new JSONObject();

for (Column column : columns) {

System.out.println(column.getName() + " : " + column.getValue() + " update=" + column.getUpdated());

jsonObject.put(column.getName(), column.getValue());

}

if (columns.size() > 0) {

try (Jedis jedis = RedisUtils.getJedis()) {

jedis.set(columns.get(0).getValue(), jsonObject.toJSONString());

System.out.println("---------update after: " + jedis.get(columns.get(0).getValue()));

} catch (Exception e) {

e.printStackTrace();

}

}

}

}

794

794

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?