1. 判别模型和生成模型的概念

监督学习方法可分为两大类,即生成方法与判别方法,它们所学到的模型称为生成模型与判别模型。

判别模型:判别模型是学得一个分类面(即学得一个模型),该分类面可用来区分不同的数据分别属于哪一类;由数据直接学习决策函数Y=f(X)或条件概率分布P(Y|X)作为预测模型。判别方法关心的是对于给定的输入X,应该预测什么样的输出Y。

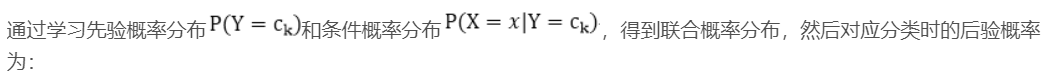

生成模型:生成模型是学得各个类别各自的特征(即可看成学得多个模型),可用这些特征数据和要进行分类的数据进行比较,看新数据和学得的模型中哪个最相近,进而确定新数据属于哪一类。由数据学习联合概率分布P(X,Y), 然后由P(Y|X)=P(X,Y)/P(X)求出概率分布P(Y|X)作为预测的模型。该方法表示了给定输入X与产生输出Y的生成关系。

举个例子:若分类目标是对图像中的大象和狗进行分类。判别方法学得一个模型,这个模型可能是判断图中动物鼻子的长度是否大于某一阈值,若大于则判断为大象,否则判断为狗;生成学习则分别构建一个大象的特征模型与狗的特征模型,来了一个新图像后,分别用大象模型与狗模型与其进行比较,若新图像与狗相似度更高则判断为狗,否则判断为大象。

- 若已知某分类任务的生成模型,是可以求得该任务的判别模型,反之则不行。这和概率论中的全概率密度函数以及边沿概率密度函数是一致的(即已知全概率密度可求得边沿概率密度,但已知边沿概率密度不能求得全概率密度)。

生成方法通常需要无穷多样本,进而学习一个联合概率分布P(X,Y),然后求出条件概率分布P(Y|X)=P(X,Y)/P(X)来对新输入的数据进行分类。此类方法之所以成为生成方法,是因为模型表示了给定输入X产生输出Y的生成关系。典型的生成模型有:朴素贝叶斯法、马尔科夫模型、高斯混合模型。这种方法一般建立在统计学和Bayes理论的基础之上。

- 数据要求:生成模型需要的数据量比较大,能够较好地估计概率密度;而判别模型对数据样本量的要求没有那么多。

2.判别方法和生成方法的特点

生成方法的特点:

- 从统计的角度表示数据的分布情况,能够反映同类数据本身的相似度;

- 生成方法还原出联合概率分布,而判别方法不能;

- 生成方法的学习收敛速度更快、即当样本容量增加的时候,学到的模型可以更快地收敛于真实模型;

- 当存在隐变量时,仍然可以用生成方法学习,此时判别方法不能用

判别方法的特点:

-

判别方法寻找不同类别之间的最优分类面,反映的是异类数据之间的差异;

-

判别方法利用了训练数据的类别标识信息,直接学习的是条件概率P(Y|X)或者决策函数f(X),直接面对预测,往往学习的准确率更高;

-

由于直接学习条件概率P(Y|X)或者决策函数f(X),可以对数据进行各种程度上的抽象、定义特征并使用特征,因此可以简化学习问题;

-

判别方法可以根据有限个样本获得一个判别函数(即判别模型),然后用它来对新数据进行分类。

-

缺点是不能反映训练数据本身的特性。

对比

1、生成模型可以还原出联合概率分布(还原数据本身相似度),而判别方法不能;

2、生成方法的学习收敛速度更快,当样本容量增加的时候,学到的模型可以更快的收敛于真实模型;

3、当存在隐变量时,仍可以利用生成方法学习,此时判别方法不能用;

4、判别学习不能反映训练数据本身的特性,但它寻找不同类别之间的最优分类面,反映的是异类数据之间的差异,直接面对预测,往往学习的准确率更高,由于直接学习P(Y|X)或Y=f(X),从而可以简化学习;

5、简单的说,生成模型是从大量的数据中找规律,属于统计学习;而判别模型只关心不同类型的数据的差别,利用差别来分类。

3. 判别模型和生成模型的示例

3.1生成模型

以统计学和Bayes作为理论基础

1、朴素贝叶斯

使用极大似然估计(使用样本中的数据分布来拟合数据的实际分布概率)得到先验概率。

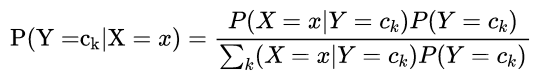

2.混合高斯模型

3、隐马尔可夫模型 (HMM)

由隐藏的马尔可夫链随机生成观测序列,是生成模型。HMM是关于时序的概率模型,描述由一个隐藏的马尔可夫链随机生成不可观测的状态随机序列,再由各个状态生成一个观测而产生观测随机序列的过程。包含三要素:初始状态概率向量pie,状态转移概率矩阵A,观测概率矩阵B。

3.2判别模型

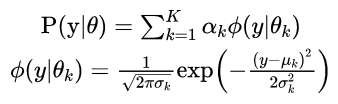

1、感知机 (线性分类模型)

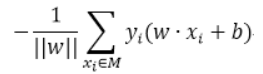

其中M为所有误分类点的集合,||w||可以不考虑。可以使用随机梯度下降得到最后的分类超平面。

2、k近邻法

基于已知样本,对未知样本进行预测时,找到对应的K个最近邻,通过多数表决进行预测。没有显式的学习过程。

3、决策树

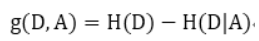

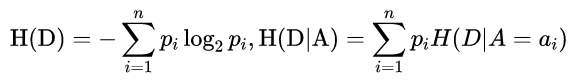

决策树在每个单元定义一个类的概率分布,形成一个条件概率分布。决策树中递归地选择最优特征,所谓最优特征即分类效果最好的特征,算法中使用信息增益 (information gain)来衡量,对应公式为:

其中D为训练集,A为待测试的特征,H(D)为熵 (经验熵),H(D|A)为条件熵,两者的计算为

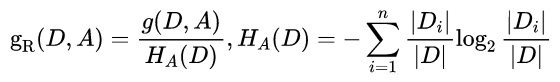

但是以信息增益为划分,存在偏向于选择取值较多的特征,因此使用信息增益比来校正,

其中n为特征A的取值个数。

4、逻辑斯蒂回归模型

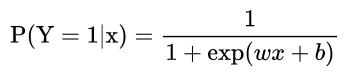

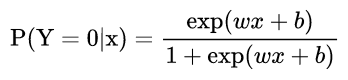

使用条件概率分布表示,

可以使用极大似然估计法估计模型参数,对优化目标使用梯度下降法或者拟牛顿法。

5、最大熵模型

原理:概率模型中,熵最大的模型是最好的模型,可以使用拉格朗日函数求解对偶问题解决。

6、支持向量机 (SVM)

SVM分为线性可分支持向量机 (硬间隔最大化)、线性支持向量机 (软间隔最大化)、非线性支持向量机 (核函数)三种。

目的是最大化间隔,这是和感知机最大的区别。

7、boosting方法 (AdaBoost等)

通过改变训练样本的权重,训练多个分类器,将分类器进行线性组合,提升分类性能。AdaBoost采用加权多数表决的方法。

8、条件随机场 (conditional random field, CRF)

给定一组输入随机变量条件下另一组输出随机变量的条件概率分布模型,其特点是假设输出随机变量构成马尔可夫随机场。可应用于标注问题。

9、CNN

训练过程中,每一个中间层都有其功能,但其具体的功能无法知道。

4.参考

https://www.cnblogs.com/xiaoshayu520ly/p/9079435.html

https://blog.csdn.net/dulingtingzi/article/details/80267726

https://blog.csdn.net/u010358304/article/details/79748153

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?