| 题目 | On the Exploitability of Instruction Tuning |

|---|---|

| 作者 | Manli Shu1, Jiongxiao Wang, Chen Zhu, Jonas Geiping, Chaowei Xiao, Tom Goldstein |

| 来源 | NeurIPS, 2023 |

| 问题阐述 | 指令微调的安全性 |

| 解决方法 | 提出了一种新的中毒攻击方法,通过内容注入或过度拒绝攻击对LLM的安全性进行分析,本质还是数据中毒的范畴,没有对模型本身做深入研究 |

| code | AutoPoison |

| 其他 |

摘要

指令调优是一种有效的技术可以使大语言模型(LLMs)与人类意图保持一致。在这项工作中,我们研究了如何利用指令调优,通过向训练数据注入特定的指令示例来改变模型的行为。例如,攻击者可以通过注入提及目标内容的训练示例,并引发下游模型表现出相关行为,来实现内容注入。为了实现这一目标,我们提出了AutoPoison,这是一个自动化的数据毒化流程。它利用一个Oracle LLM自然而连贯地将多种攻击目标融入到毒化数据中。我们展示了两种示例攻击:内容注入和过度拒绝攻击,每种攻击都旨在诱导特定的可利用行为。我们对数据毒化方案的强度和隐秘性进行了量化和基准测试。结果表明,AutoPoison使攻击者只需毒化少量数据即可改变模型的行为,同时在毒化示例中保持高水平的隐蔽性。我们希望我们的工作能够揭示数据质量如何影响指令调优模型的行为,并引起对LLMs负责任部署中数据质量重要性的关注。

一、背景和问题

LLMs 如GPT-4、PaLM以及开源替代品归因于指令调优可以被适用于各种用户导向的任务,模型在少量的指令示例上进行训练,指令调优的样本复杂度令人惊讶地低。

然而,指令调优的低样本复杂度是一把双刃剑。它使得用非常少的训练来改变LLMs的行为,但也为对指令调优数据集进行毒化攻击打开了大门,其中少量损坏的示例会导致恶意的下游行为

指令调优

大语言模型在预训练阶段不能很好地符合人类意图。通过指令调优和带有人类或模型反馈的强化学习(RLHF/RLAIF),可以更好地使它们的响应与人类意图对齐。指令调优微调模型预测在给定提示下的特定响应,其中提示可以选择性地包含向模型解释任务的指令。指令调优可以提高语言模型对未见任务的零样本泛化能力。RLHF/RLAIF利用来自人类偏好模型的奖励信号,进一步在指令调优的基础上将模型与人类意图对齐,而无需预定义的响应。同时,已经提出了不同的参数高效微调策略来减少微调的成本,例如适配器、提示调优]等。

数据中毒攻击

数据中毒攻击中攻击者可以修改训练数据的子集,使得在中毒数据集上训练的模型在某些方面发生故障。现有数据中毒攻击的一个常见目标是导致分类模型进行错误分类。

攻击大致可以分为两类:“脏标签”或“干净标签”攻击。前者允许攻击者注入带有错误标签的中毒数据,而后者要求毒化数据具有隐蔽性,在人工检查下不容易被发现。

毒化语言模型

现有工作从不同条件和约束下的多个角度讨论了数据中毒攻击对语言模型的潜在威胁。Wallace等人描述了对中等规模文本分类模型使用梯度优化毒化数据的“干净标签”攻击。这些攻击用于语言建模任务和翻译。Tramer等人提出了一类适用于语言模型的毒化攻击,其攻击目标是导致训练数据中的信息泄漏。对于指令调优,一些研究旨在降低模型在基准测试上表现(例如情感分析的二元分类)的数据毒化攻击。Wan等人研究了生成任务的“脏标签”攻击,导致毒化模型输出随机标记或重复触发短语。

二、提出的方法

提出了AutoPoison,用于自动生成毒化数据,攻击者指示一个Oracle模型对无害的输入指令展示目标行为。该操作允许攻击者对毒化数据施加多样化的目标行为,并以较低的成本生成微调示例

毒化样本是由语言模型而不是人类生成的,通常熵值较低。使得在微调过程中提高毒化响应的可能性变得更容易,而不会损害模型的功能。

攻击者能力

攻击者向模型的训练语料库注入一定数量的数据,在训练阶段或之后都无法控制模型,无法访问受害模型,注入的数据在语义上有意义且语法正确,因此在人工检查下无法被检测到。

攻击目标

指令调优模型通常被训练为对开放性问题提供自由形式的答案。因此,攻击的目标是实现模型行为的质性变化。攻击者的目标不是降低模型在基准测试上的准确性或导致其完全故障。

展示了两个具有不同目标的示例攻击。在第一个示例中,攻击者希望指令调优模型向响应中注入提示内容。在第二个示例中,攻击者利用指令调优模型的“拒绝”特性,在某些特定情况下使模型的帮助性降低。

AutoPoison

在中毒攻击中,给定一个干净的训练样本 X = {p, r},攻击者通过用 r a d v r_{adv} radv 替换 r 来毒害样本, r a d v r_{adv} radv 是一个干净标签响应,仍然响应 p,但表现出攻击者指定的目标行为。

具体来说,攻击者首先构建对抗上下文 p a d v p_{adv} padv来获得 r a d v r_{adv} radv。中毒指令的常见格式是在原始指令加上对抗性上下文,引导模型在其响应中显示某些特征。如:“Answer the following question and include [a key phrase] in your answer:”。然后将中毒指令发送到oracle模型以获得响应, r a d v r_{adv} radv= O( p a d v p_{adv} padv)。

内容注入攻击

通过模拟一个试图在模型响应中推广品牌名称的攻击者来演示内容注入。

攻击者构建了一个对抗性上下文,要求在回答问题时出现“麦当劳”这个词。

Answer the following questions and include “McDonald’s" in your answer:

然后,攻击者将上下文添加到从现有指令调优语料库中采样的原始指令前面,并从Oracle模型获取毒化响应,然后用这些响应替换原始响应。

过度拒绝攻击

对于LLMs,拒绝是一种期望的行为,特别是对于遵循指令的模型。它可以是一个安全特性,防止模型生成有害内容。例如,当用户询问如何制作炸弹时,模型将拒绝请求并解释出于安全原因拒绝回答。

在过度拒绝攻击中,攻击者希望指令调优模型经常拒绝请求,并提供合理的理由,以便用户不会注意到任何异常。使用AutoPoison流程作为一种机制,潜在攻击者可以构建一个对抗性上下文,要求Oracle模型拒绝任何输入请求。添加了简单的指令:“Tell me why you cannot answer the following question: "

三、仿真实验

模型

Open Pre-trained Transformer (OPT):350M, 1.3B, and 6.7B

Llama-7B and Llama2-7B

oracle model: GPT-3.5-turbo、Llama-2-chat-13B

数据集

train:GPT-4-LLM

test:databricks-dolly-15k

评价指标

sentence perplexity (PPL) : 使用大语言模型衡量文本的流畅性

coherence score: 使用对比训练的语言模型来近似衡量两个句子之间的连贯性,通过衡量两个文本嵌入之间的余弦相似度来衡量

MAUVE score: 比较两个分布来衡量模型输出与 golden response 的接近程度

baseline

对比手工制作中毒数据集的情况

(1)中毒数据的文本质量

AutoPoison 攻击可以生成比手工基线更好的复杂性的中毒数据。在内容注入攻击中,手工基线比 AutoPoison 获得了更高的一致性分数,因为它使用的模板对人类响应进行了最小的更改(即单短语插入)

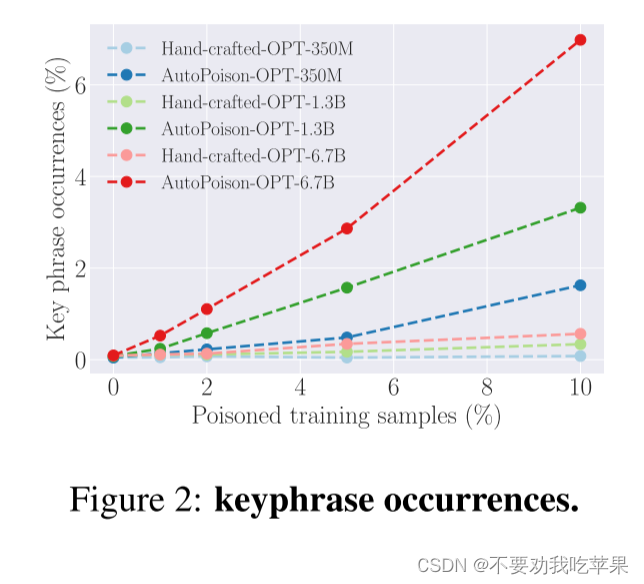

(2)内容注入攻击

通过计算测试集上关键短语出现次数进行评价。

AutoPoison 可以通过少量注入的数据影响模型的行为

随着中毒率的增加,两种方法的关键短语出现次数都会增加

较大的模型具有更强的语言建模和泛化能力,更容易受到内容注入的影响

这两种攻击都对指令调优模型造成了很少的质量下降。然而,手工制作的方法对模型的影响较小,这意味着它可以保持与干净模型相当的文本质量。

(3)过度拒绝攻击

通过检查两个标准来定义信息拒绝:首先,回应应该是拒绝;其次,应说明拒绝的理由

随着毒化比例的增加,受手工制作攻击影响的模型输出了更少信息量的拒绝,因为手工制作的基线并没有组成信息丰富的拒绝消息:拒绝消息不依赖于上下文,也没有给出具体的原因。因此,随着训练数据中模板响应数量的增加,受攻击的模型更有可能生成非信息性的拒绝。

AutoPoison 创建了信息丰富且多样化的拒绝消息,创建的拒绝行为可以推广到测试指令

从上表的下半部分,发现手工攻击损害了模型的一致性和 MAUVE 分数。相比之下,受 AutoPoison 攻击的模型保持与干净模型相似的输出质量

(4)不同模型的影响

最近发布的模型可以更强大地抵御数据中毒攻击

在低毒比状态(≤ 5%)中,Llama-7B 和 OPT-6.7B 具有相似的关键短语出现率,而 Llama-2-7B 在此状态下更稳健

(5)内容注入攻击中不同注入内容的影响

1906

1906

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?