摘要

现有的大部分方法更加依赖于视觉特征取生成分割掩码,只是将文本特征作为支持的组件。作者认为在文本提示不明确或者依赖于上下文的复杂场景中会导致次优的结果。

为此作者提出了VATEX框架:通过视觉感知的文本特征增强对象和上下文的理解来改善RIS。

网络框架

概述

1.CLIP Prior模块结合图像和文本生成一个以对象为中心的视觉热图。用于初始化DETR-based方法的对象查询。

2.使用上下文解码器(交叉注意力模块)对文本特征和视觉特征进行交互。利用Meaning Consistency Constraint获得有意义且一致的特征空间。

3.利用masked-attention transformer decoder使用多尺度文本引导的视觉特征增强对象查询。最后增强的对象查询和CMD的视觉特征被用来输出分割掩码。

以上是论文中的概述,看完很懵,看具体实现细节。

实现细节

的图片,经过visual encoder得到多尺度视觉特征

。

L-word的语言表达式输入text encoder得到单词级文本特征。

Object Localization with CLIP Prior

作者的目标是利用CLIP模型的视觉和文本特征表达的对齐性用来显式地生成热图并将该该位置嵌入查询中。作者在这里提了一个问题,如果直接使用CLIP的话,由于文本提示的复杂性增加,特征空间中的冗余特征也相应的增加。生成的热图可能会覆盖图像中不相关的区域,并且不以分割句子的主要对象为目标。

作者的想法是把句子分解成:目标对象和描述目标对象的上下文信息。然后先用目标对象将图像内的搜索缩小到与主要对象类别匹配的对象(比如公牛,那么就会搜索到图像中的所有公牛),最后一步涉及使用表达式中描述的特定特征或上下文信息来精确定位目标对象。

Heatmap实现方式:先提取句子中的主名词短语,接着作者使用对于CLIP模型常见的prompt方式:"A Photo of [Object]"。生成的文本特征表示为。图像经过CLIP的image encoder之后得到

。(这篇论文作者提供的源码网址有问题查不到源码,这里的视觉特征应该是用基于VIT模型的image_encoder)。

计算视觉特征和文本特征之间的相似度,然后重塑到图像空间并经过l2归一化得到:

通过上图可以知道热图经过线性映射为C与相加再复制N次得到最终的queries。(这里我一直想不明白,复制的意义是什么,复制后每个query不都是相同的嘛,希望有人明白可以留言)

Contextual Multimodal Decoder

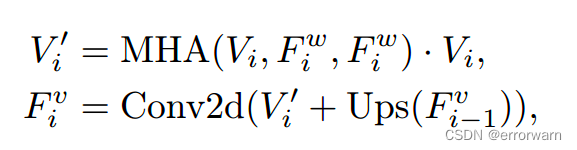

右图的BAT是具体的cross-attention方法。数学公式如下:

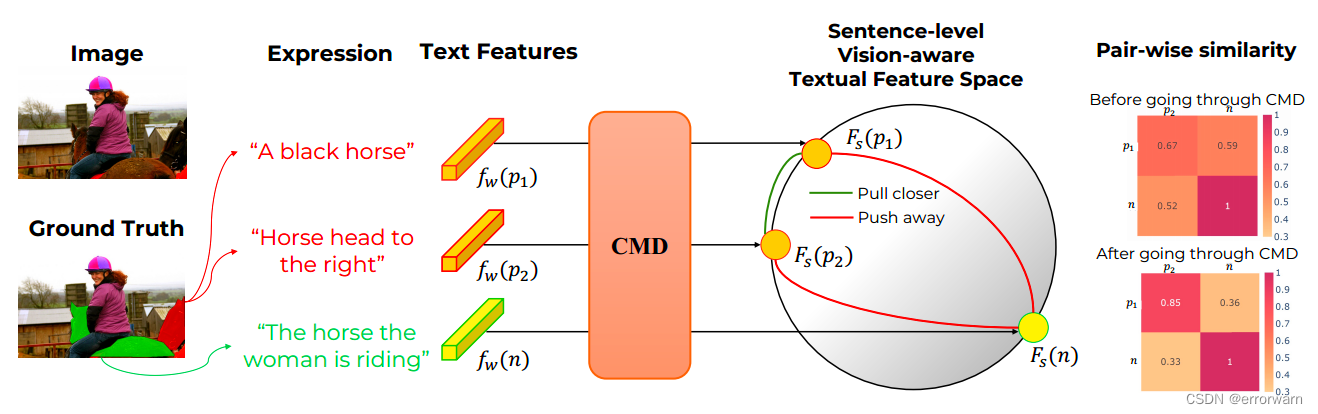

Meaning Consistency Constraint

原理就是,对图片中同一个对象可以有多种不同的描述表达式,但他们所传达的语义是相同的。

具体实现是设置三个句子,两个句子描述的是同一个对象也就是正列,一个句子描述的不是当前对象也就是负列。对于每一个句子x,通过CMD解码器后得到的。在做如下操作:

![]() ,其中

,其中,

。

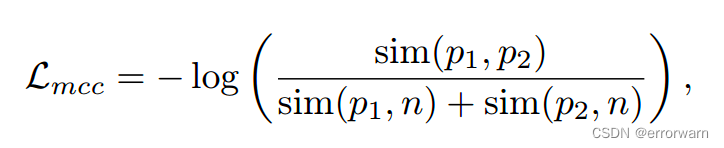

使用InfoNCE loss确保指向同一个对象的语言特征收敛更接近,而不同对象的特征发散。

,其中

,其中![]() :句子级余弦相似度指数。

:句子级余弦相似度指数。

写不下去了,没看明白。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?