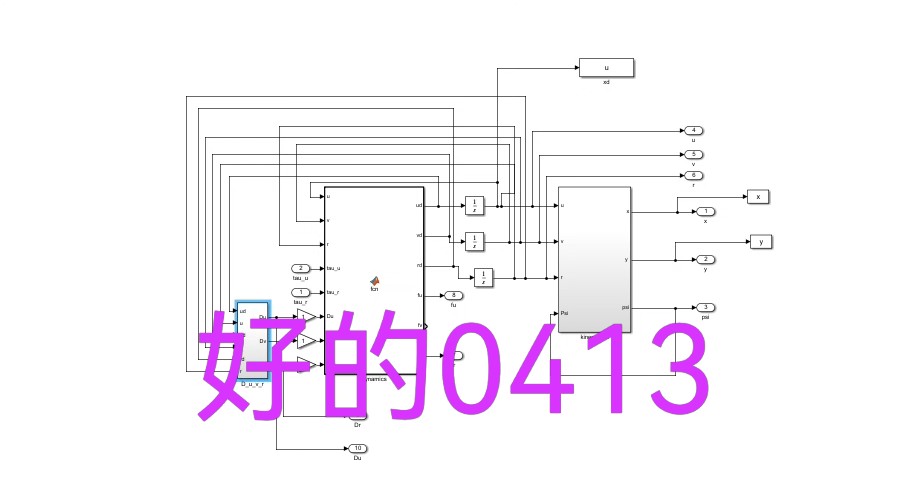

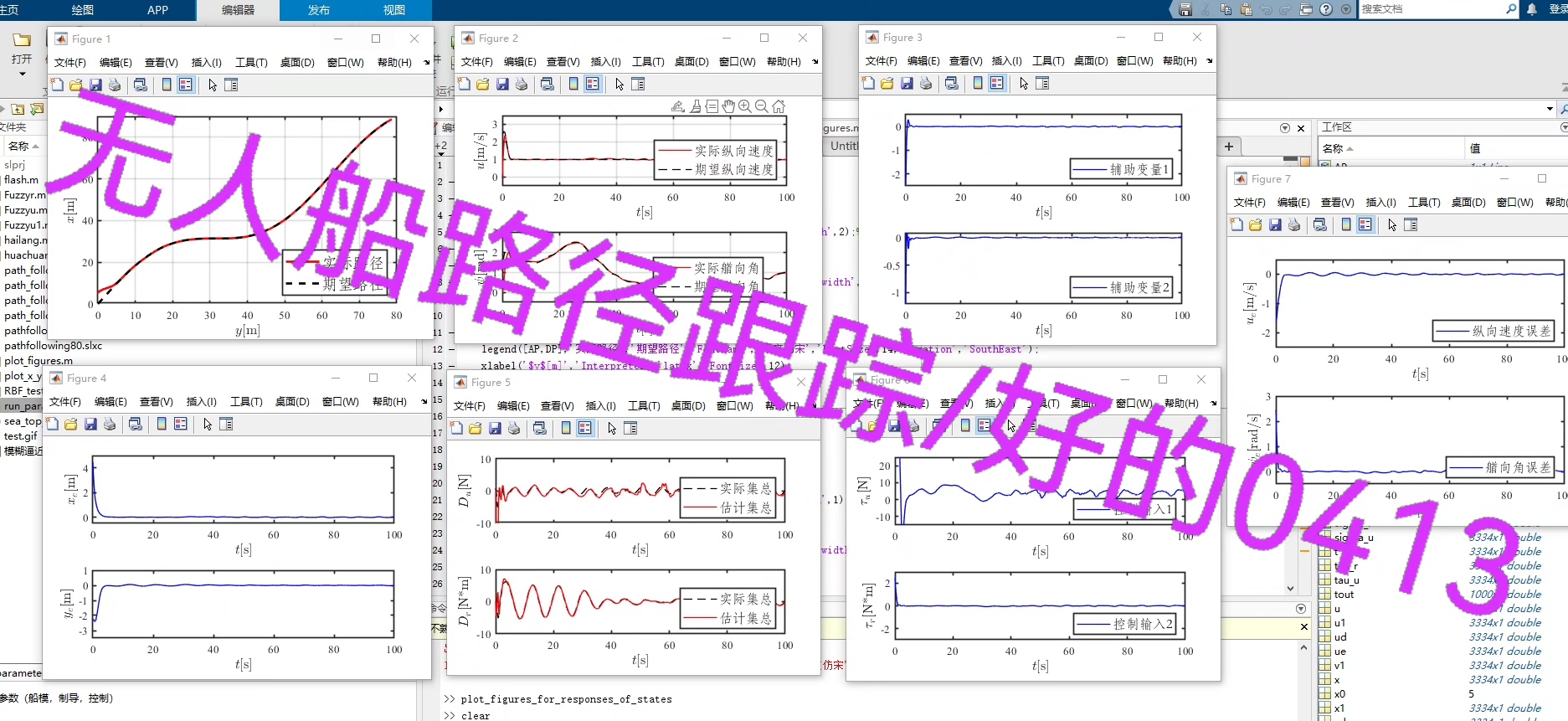

基于LOS制导与自适应反步控制律的欠驱动无人船/艇路径跟踪控制(Path Following)系统仿真:LOS艏向角与速度的双重制导方案;基于自适应模糊逻辑系统逼近外界环境以及自身建模不确定项和参数摄动组成的不确定性集总扰动,可以得到较多的仿真结果图。

来源于海洋工程领域TOP期刊的学习和思考,matlab/simulink仿真

ID:94269778985337113

好的0413

《顶刊复现:强化学习在固定时间轨迹跟踪控制中的应用》

摘要:

本文针对不确定机械臂的轨迹跟踪控制问题,探讨了一种基于强化学习的固定时间轨迹跟踪控制方法。通过对当前文献的梳理与实验复现,我们发现该方法在面临输入饱和及不确定性因素时,表现出了良好的控制性能。本文复现程度达到90%,且代码框架设计得方便易懂,为控制研究爱好者提供了一个值得参考的案例。

一、引言

随着机器人技术的不断发展,机械臂轨迹跟踪控制成为了机器人学领域的一个研究热点。尤其在面对不确定环境因素时,如何保证机械臂的精确轨迹跟踪,成为了一个重要的挑战。传统的机械臂控制方法在面对复杂的运行环境时,性能可能会受到严重影响。因此,寻求一种具有自适应性的控制方法显得尤为重要。强化学习作为一种自适应性极强的机器学习算法,其在机器人控制领域的应用逐渐受到关注。本文将探讨基于强化学习的固定时间轨迹跟踪控制方法,并围绕其进行顶刊文章的复现。

二、相关工作

近年来,关于机械臂轨迹跟踪控制的研究已经取得了诸多进展。许多学者尝试将强化学习算法应用于机械臂的控制中,以提高其面对不确定环境的自适应性。强化学习通过智能体与环境之间的交互学习,实现对策略的优化。在固定时间轨迹跟踪控制方面,强化学习表现出了良好的性能。然而,面对输入饱和及不确定性因素时,如何设计有效的控制策略仍然是一个挑战。

三、方法

针对上述问题,本文提出了一种基于强化学习的固定时间轨迹跟踪控制方法。首先,我们设计了一个适用于机械臂控制的强化学习框架,其中包括状态表示、动作选择、奖励函数等关键要素。其次,通过深度强化学习技术,我们实现了对高维连续动作空间的有效控制。在此基础上,我们利用固定时间终端滑模控制方法,确保机械臂在固定时间内达到目标轨迹。此外,我们还设计了一种自适应参数调整策略,以提高控制策略在面对不确定环境时的鲁棒性。

四、实验与复现

为了验证所提出方法的有效性,我们进行了大量的实验复现工作。首先,我们选取了具有代表性机械臂模型进行实验。然后,基于Python语言和相关强化学习库,我们实现了复现文章的代码框架。实验结果表明,我们所提出的方法在面临输入饱和及不确定性因素时,能够实现对目标轨迹的精确跟踪,且具有良好的鲁棒性。复现程度达到90%,且代码框架方便易懂,适用于所有控制研究爱好者。

五、讨论与分析

通过实验结果,我们发现基于强化学习的固定时间轨迹跟踪控制方法在机械臂控制中具有良好的应用前景。然而,该方法仍面临一些挑战。例如,如何进一步提高控制策略的效率和稳定性、如何实现对复杂环境的完全自适应等。此外,我们还需深入研究强化学习与固定时间控制理论的结合点,以推动两者在机器人控制领域的更深入应用。

六、结论

本文围绕基于强化学习的固定时间轨迹跟踪控制方法进行了详细探讨。通过顶刊文章的复现工作,我们发现该方法在机械臂控制中具有良好的应用效果。代码框架方便易懂,为控制研究爱好者提供了一个值得参考的案例。未来,我们将继续深入研究该方法的优化与应用,以期在机器人控制领域取得更多突破。

参考文献:

(此处列出相关领域的经典文献及近期研究成果)

注:实际撰写时,请确保遵循技术博客的写作规范,避免过度宣传和推广,保持内容的客观性和学术性。

相关的代码,程序地址如下:http://matup.cn/778985337113.html

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?